Meta a récemment annoncé MusicGen, un générateur de musique alimenté par l’IA qui peut transformer une description textuelle en 12 secondes d’audio. La société l’a également mis en open source, bien que Google ait choisi l’inverse. Aujourd’hui, nous allons vous expliquer ce qu’est MusicGen de Meta et comment l’utiliser !

La majorité des activités artistiques ont réussi à être impactées par l’IA, et le business de la musique est désormais fermement sous son influence. De la même manière que ChatGPT ou d’autres énormes IA basées sur des modèles de langage créent du texte, Meta a récemment annoncé la disponibilité de la version open-source de leur modèle d’IA pour générer de la musique.

Qu’est-ce que MusicGen ?

MusicGen est construit sur un modèle Transformer, comme le sont la majorité des modèles de langage utilisés aujourd’hui. MusicGen prédit le segment suivant d’un morceau de musique d’une manière similaire à la façon dont un modèle de langage prédit les lettres suivantes dans une phrase.

Les chercheurs utilisent le tokenizer audio EnCodec de Meta pour décomposer les données audio en plus petits morceaux. MusicGen est une approche rapide et efficace en une seule étape qui effectue le traitement des jetons en parallèle.

Pour la formation, l’équipage a utilisé 20 000 heures de musique autorisée. Ils ont utilisé 10 000 enregistrements audio de haute qualité à partir d’un ensemble de données internes ainsi que des données musicales Shutterstock et Pond5, en particulier.

IA générative : l’origine des outils d’IA populaires

MusicGen est exceptionnel dans sa capacité à gérer à la fois le texte et les repères musicaux, en plus de l’efficacité du design et de la rapidité de création. Le texte établit le style fondamental, que la musique du fichier audio suit ensuite.

Vous ne pouvez pas changer exactement la direction de la mélodie pour pouvoir l’entendre dans différents styles musicaux, par exemple. Il n’est pas parfaitement reflété dans la sortie et sert simplement de guide général pour la génération.

Il n’y a pas eu beaucoup d’exemples de génération de musique de haute qualité qui ont été mis à la disposition du public, malgré le fait que de nombreux autres modèles exécutent la génération de texte, la synthèse vocale, la création de graphiques et même de brèves vidéos.

Le document d’étude qui va avec, accessible sur le site de préimpression arXiv, affirme que l’une des principales difficultés de la musique est qu’elle nécessite de faire fonctionner le spectre de fréquences complet, ce qui nécessite un échantillonnage plus intensif. Sans parler des compositions complexes de la musique et des instruments qui se chevauchent.

Comment utiliser MusicGen ?

À travers le API d’étreinte de visage, les utilisateurs peuvent tester MusicGen, mais selon le nombre d’utilisateurs qui l’utilisent simultanément, la génération de musique peut prendre un certain temps. Pour des résultats beaucoup plus rapides, vous pouvez utiliser le site Web Hugging Face pour configurer votre propre instance du modèle. Si vous avez les compétences et l’équipement nécessaires, vous pouvez télécharger le code et exécutez-le manuellement à la place.

Si vous cherchez à essayer la version du site Web, comme la plupart des autres personnes, voici comment procéder :

- Ouvrez votre navigateur Internet.

- Allez à la Site Web d’étreinte de visage.

- Cliquez sur Les espaces en haut à droite.

- Taper « MusicGen » dans le champ de recherche.

- Trouvez celui qui a été publié par Facebook.

- Entrez votre rapide dans la boîte au gauche.

- Cliquez sur Générer.

Comment ça marche?

Votre description est utilisée pour générer 12 secondes d’audio par le modèle MusicGen. Un fichier audio de référence à partir duquel une mélodie complexe sera créée peut également être fourni. En utilisant l’audio de référence, le modèle s’efforcera de créer une musique qui reflète mieux les goûts de l’utilisateur en respectant à la fois la description et la mélodie fournie.

Nous présentons MusicGen : Un modèle de génération de musique simple et contrôlable. MusicGen peut être invité à la fois par du texte et par une mélodie.

Nous publions du code (MIT) et des modèles (CC-BY NC) pour la recherche ouverte, la reproductibilité et pour la communauté musicale : https://t.co/OkYjL4xDN7 pic.twitter.com/h1l4LGzYgf– Félix Kreuk (@FelixKreuk) 9 juin 2023

Le modèle utilise un tokenizer audio EnCodec basé sur un modèle de langage de transformateur, comme indiqué par Kreuk. Grâce à l’API Hugging Face, les utilisateurs peuvent tester MusicGen, mais en fonction du nombre d’utilisateurs qui l’utilisent simultanément, la génération de musique peut prendre un certain temps. Pour des résultats beaucoup plus rapides, vous pouvez utiliser le site Web Hugging Face pour configurer votre propre instance du modèle. Si vous avez les compétences et l’équipement nécessaires, vous pouvez télécharger le code et l’exécuter manuellement à la place.

MusicGen contre Google MusicLM

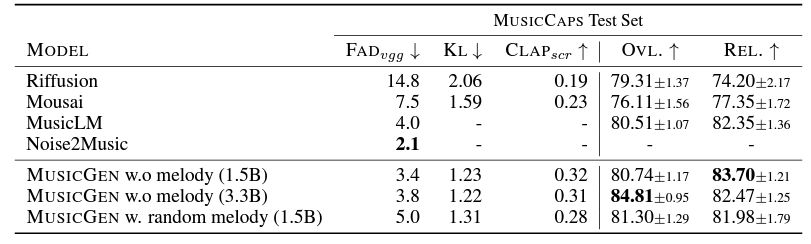

MusicGen semble produire des résultats légèrement meilleurs. Les chercheurs le démontrent en comparant la production de MusicGen à celle de MusicLM, Riffusion et Musai sur un exemple de site Web. Il est disponible en quatre tailles de modèle, allant de minuscule (300 millions de paramètres) à grand (3,3 milliards de paramètres), ce dernier ayant le plus grand potentiel pour créer de la musique complexe. Il peut être utilisé localement (un GPU avec au moins 16 Go de RAM est suggéré).

L’un des nombreux exemples de la façon dont Meta utilise l’IA pour créer des expériences immersives et convaincantes pour ses consommateurs est MusicGen. L’objectif de Meta est de créer un monde virtuel partagé appelé métaverse où les utilisateurs peuvent interagir, collaborer et s’amuser sur de nombreuses plateformes et appareils. Le métaverse deviendra plus divertissant et musical grâce à MusicGen.