Stability AI a récemment dévoilé FreeWilly, ses nouveaux modèles de langage entraînés sur des données « synthétiques ». Les LLM sont désormais disponibles pour une utilisation de masse, et le laboratoire Carper AI de Stability AI les a développés.

Les deux nouveaux LLM, qui ont été dévoilés vendredi par Stability AI, la société à l’origine de l’IA de génération d’images Stable Diffusion et fondée par l’ancien Hedge Funder britannique Emad Mostaque, qui a été accusé d’avoir gonflé son CV, sont tous deux basés sur des versions du LLaMA de Meta. et les modèles open source LLaMA 2, mais ont été formés sur un ensemble de données entièrement nouveau et plus petit qui comprend des données synthétiques.

Les deux modèles sont excellents pour résoudre des problèmes complexes dans des domaines spécialisés comme le droit et les mathématiques et des détails linguistiques délicats.

Les FreeWillys ont été publiés par CarperAI, filiale de Stability, sous une « licence non commerciale », qui interdit leur utilisation à des fins lucratives, d’entreprise ou commerciales. Au lieu de cela, ils visent à approfondir la recherche et à promouvoir le libre accès dans la communauté de l’IA.

Qu’est-ce que FreeWilly ?

En partenariat avec la société de développement d’IA CarperAI, Stability AI a lancé FreeWilly1 et sa suite FreeWilly2 le 21 juillet 2023. FreeWilly1 a été réglé via un réglage fin supervisé (SFT) sur des ensembles de données créés synthétiquement sur la base du modèle de langage à grande échelle de Meta, LLaMA-65B. D’autre part, LLaMA 270B est utilisé dans le développement de FreeWilly2.

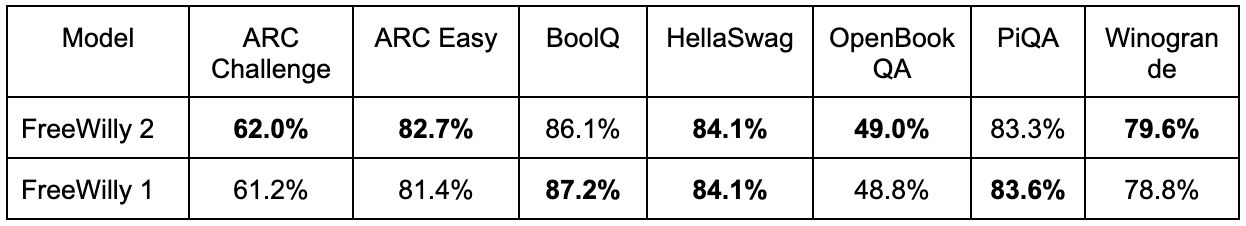

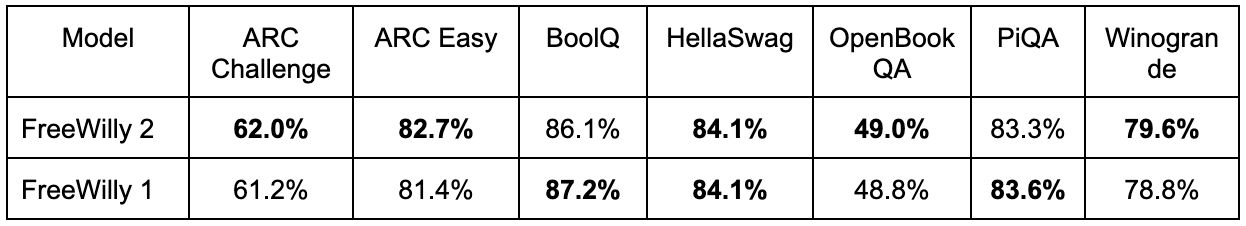

Selon les rapports, FreeWilly2 effectue plusieurs tâches à égalité avec GPT-3.5. Des tests de référence indépendants effectués par des chercheurs de Stability AI ont montré que FreeWilly2 surpassait ChatGPT avec GPT-3.5, qui obtenait une précision de 85,5 %, avec une précision de 86,4 % dans « HellaSwag », une tâche d’inférence en langage naturel qui évalue le bon sens.

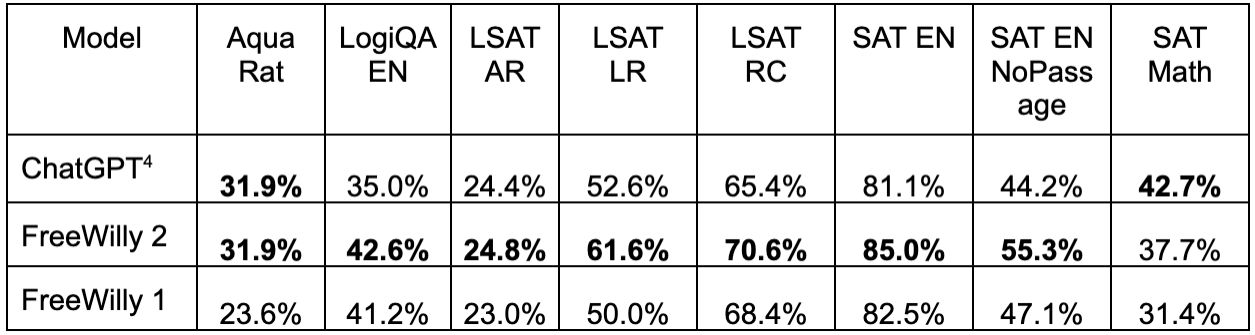

À l’exception de la partie arithmétique du test d’entrée à l’université américaine connue sous le nom de « SAT Math », FreeWilly2 a surpassé GPT-3.5 dans la plupart des tâches lorsque les performances par rapport au logiciel de référence de modèle linguistique à grande échelle « AGIEval » ont été comparées.

De plus, Stability AI met l’accent sur la publication minutieuse des modèles FreeWilly et sur l’évaluation approfondie des risques effectuée par une équipe interne spécialisée. L’entreprise encourage régulièrement les contributions extérieures pour améliorer les protocoles de sécurité.

L’IA de stabilité révèle Griffonnage stable: Esquisse en HD

« FreeWilly1 et FreeWilly2 établissent une nouvelle norme dans le domaine des grands modèles de langage en libre accès. Ils font tous deux progresser de manière significative la recherche, améliorent la compréhension du langage naturel et permettent des tâches complexes. Nous sommes ravis des possibilités infinies que ces modèles apporteront à la communauté de l’IA et des nouvelles applications qu’ils inspireront », a déclaré Stability AI dans son annonce.

Un travail incroyable qui sort de notre laboratoire

! Nous sommes si fiers de montrer au monde ce sur quoi nous avons brûlé l’huile de minuit ! Un grand bravo à @dmayhem93 pour les nuits blanches pour vous apporter cette version incroyable ! https://t.co/JqlWX6MA2L

— Carper, un laboratoire d’IA de stabilité (@carperai) 21 juillet 2023

Les chercheurs ont utilisé le processus de formation « Orca » sur FreeWilly

Les titres des modèles sont des jeux de mots sur le processus de formation à l’IA « Orca » des chercheurs de Microsoft, qui permet aux modèles « plus petits » (ceux exposés à moins de données) de fonctionner ainsi qu’aux grands modèles de base soumis à des ensembles de données plus volumineux. (Ce n’est pas une référence aux orques qu’IRL a coulé un bateau.)

FreeWilly1 et FreeWilly2 ont été spécifiquement formés avec 600 000 points de données – seulement 10% de la taille de l’ensemble de données Orca d’origine – en utilisant les conseils de quatre ensembles de données produits par Enrico Shippole. En conséquence, ils étaient à la fois nettement plus abordables et respectueux de l’environnement (utilisant moins d’énergie et laissant une empreinte carbone plus faible) que le modèle Orca original et la majorité des principaux LLM. Les modèles ont continué à offrir d’excellentes performances, atteignant parfois ou même dépassant ChatGPT sur GPT-3.5.

Pour évaluer ces modèles, les chercheurs ont utilisé le lm-eval-harness d’EleutherAI, auquel ils ont ajouté AGIEval. Les résultats démontrent que les deux modèles FreeWilly réussissent exceptionnellement bien dans le raisonnement complexe, la reconnaissance des subtilités du langage et la résolution de problèmes dans des domaines spécialisés comme le droit et les mathématiques.

Les deux modèles, de l’avis de l’équipe, aident les humains à mieux comprendre le langage parlé et à créer de nouvelles possibilités auparavant irréalisables. Toutes les nouvelles applications de ces modèles en intelligence artificielle sont ce qu’ils espèrent voir.

Crédit image en vedette : IA de stabilité