Découvrez Mistral 7B, un modèle de langage de 7,3 milliards de paramètres qui surpasse le Llama 2 de Meta, qui fait des vagues non seulement pour sa taille impressionnante, mais aussi pour ses capacités exceptionnelles qui surpassent ses homologues plus grands. Dans cet article, nous plongerons dans le monde de Mistral 7B, en explorant ses fonctionnalités, ses réalisations et ses applications potentielles.

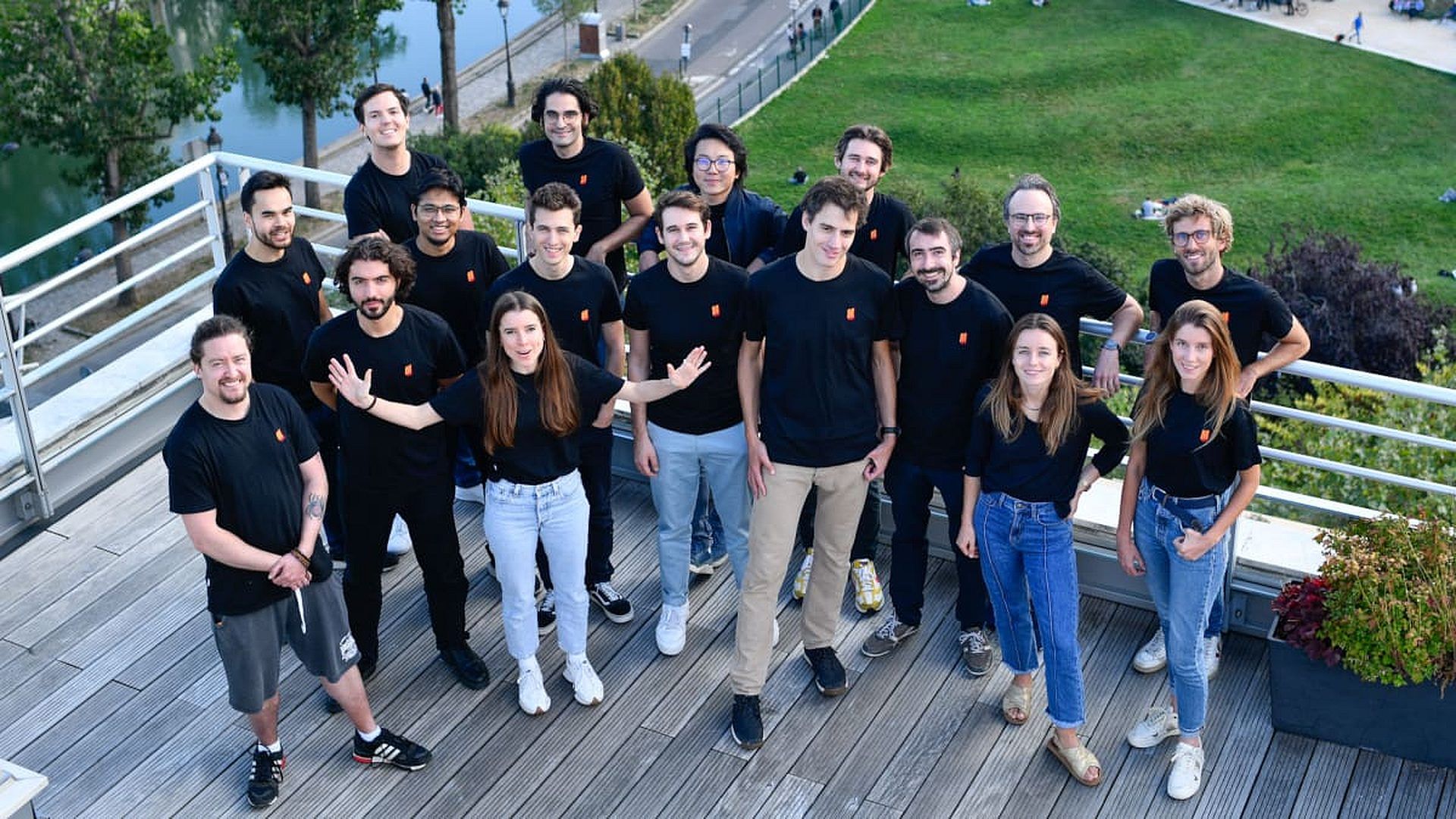

Une startup en plein essor

Mistral AI, une startup basée à Paris fondée par d’anciens élèves des géants de la technologie DeepMind et Meta de Google, a fait irruption sur la scène plus tôt cette année avec un logo Word Art distinctif et un cycle de financement d’amorçage historique de 118 millions de dollars. Ce financement, le plus grand tour de table de l’histoire de l’Europe, a propulsé Mistral AI sous les feux de la rampe.

La mission de l’entreprise est claire : « rendre l’IA utile » pour les entreprises en exploitant les données accessibles au public et les contributions des clients. Avec le lancement de Mistral 7B, l’entreprise franchit une première étape significative vers l’accomplissement de cette mission.

Mistral 7B peut changer la donne

Mistral 7B n’est pas un modèle de langage ordinaire. Avec ses 7,3 milliards de paramètres compacts, il surpasse les modèles plus grands comme le Llama 2 13B de Meta, établissant une nouvelle norme en matière d’efficacité et de puissance. Ce modèle offre une combinaison unique de capacités, excellant dans les tâches en anglais tout en démontrant des prouesses impressionnantes en matière de codage. Cette polyvalence ouvre les portes à un large éventail d’applications centrées sur l’entreprise.

Un aspect notable de Mistral 7B est sa nature open source, publiée sous la licence Apache 2.0. Cela signifie que n’importe qui peut affiner et utiliser le modèle sans restrictions, que ce soit pour des applications locales ou basées sur le cloud, y compris des scénarios d’entreprise.

Licence Apache 2.0

En utilisant un logiciel sous licence Apache 2.0, par exemple, les utilisateurs finaux se voient garantir une licence sur tous les brevets couverts par le logiciel. Un logiciel open source sûr et puissant est garanti d’être facilement disponible sous une licence Apache 2.0.

Comment utiliser Mistral 7B

Sous la licence Apache 2.0, Mistral 7B peut être utilisé sans restrictions de la manière suivante :

- Télécharge le et utilisez-le n’importe où (y compris localement) avec L’implémentation de référence de Mistral

- Déployez-le sur n’importe quel cloud (AWS/GCP/Azure), en utilisant vLLM serveur d’inférence et skypilot

- Utilisez-le sur ÉtreindreVisage

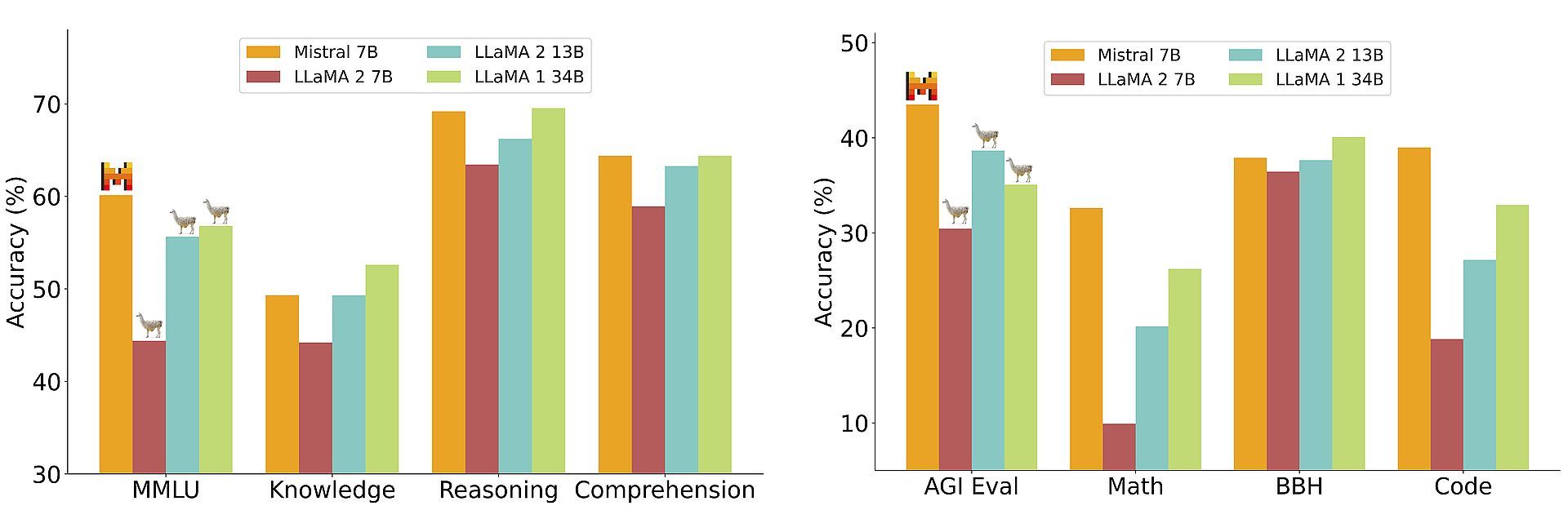

Les benchmarks sont plus éloquents que les mots

Même si le Mistral 7B vient tout juste d’entrer en scène, il a déjà fait ses preuves lors de tests de référence. Dans les comparaisons directes avec la concurrence open source, le modèle surpasse systématiquement. C’est le meilleur Lama 2 7B et 13B avec facilité, démontrant ses prouesses dans diverses tâches.

Les principaux atouts de Mistral 7B incluent son utilisation de l’attention aux requêtes groupées (GQA) pour une inférence ultra-rapide et de l’attention à fenêtre coulissante (SWA) pour gérer des séquences plus longues sans encourir de coûts de calcul importants. Cette approche innovante améliore ses performances à tous les niveaux.

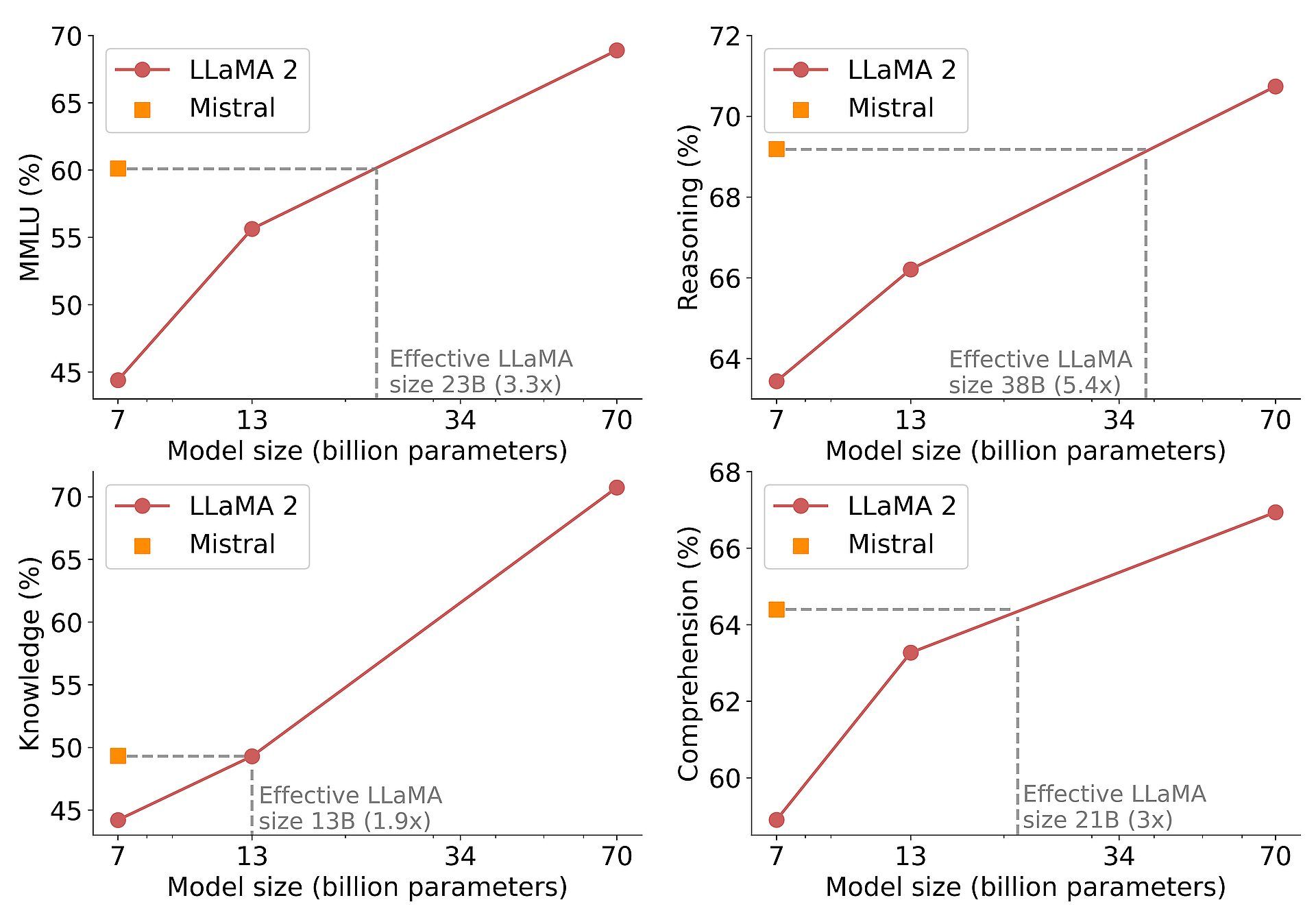

Libérer l’efficacité coût-performance

Un aspect fascinant des performances du Mistral 7B est sa rentabilité. En calculant les « tailles de modèle équivalentes », nous pouvons apprécier les économies de mémoire et les gains de débit qu’il offre. En raisonnement, compréhension et raisonnement STEM, Mistral 7B fonctionne de manière équivalente à un modèle Llama 2 sur trois fois sa taille.

Cela en fait un choix attrayant pour les applications économes en ressources.

Un aperçu du futur

Pour mettre en valeur l’adaptabilité de Mistral 7B, le modèle a été affiné sur des ensembles de données d’instructions accessibles au public provenant de HuggingFace, prouvant ainsi ses impressionnantes capacités de généralisation. Ce modèle affiné, connu sous le nom de Mistral 7B Instruct, surpasse les autres modèles 7B sur MT-Bench et rivalise avec les modèles de chat 13B. Cette réalisation laisse entrevoir le potentiel du modèle dans diverses applications spécialisées.

Mistral AI a hâte de collaborer avec la communauté pour établir des garde-fous, garantissant des sorties responsables et modérées. Cet engagement s’aligne sur la tendance plus large de l’industrie vers le développement éthique de l’IA.

En conclusion, Mistral 7B représente un bond en avant remarquable dans les modèles d’IA linguistique. Avec sa taille compacte, sa nature open source et ses performances exceptionnelles, il promet de transformer la façon dont les entreprises exploitent l’IA pour un large éventail d’applications. Alors que Mistral AI continue d’innover, nous pouvons nous attendre à des progrès encore plus importants dans le monde de l’intelligence artificielle.