DALL-E Mini est entré dans la course à la génération d’images IA en tant que concurrent inattendu, doté de ses propres capacités et limites. Dans une analyse comparative, DALL-E Mini, en particulier la version développée par Craiyon, présente un potentiel remarquable, notamment en termes de qualité d’image et de simplicité des invites.

L’année dernière en particulier, l’intelligence artificielle et les avantages de cette technologie ont changé nos vies. Il existe désormais des robots qui effectuent à notre place des tâches répétitives qui demandaient auparavant du temps et des efforts, et de nombreux secteurs ont commencé à en bénéficier.

Cette technologie, dont l’utilisation s’est généralisée avec la tendance de l’IA initiée par OpenAI, nous a fait découvrir des modèles génératifs qui répondent à de nombreux objectifs tels que la conversion texte-image et texte-son. Bien que la technologie de génération d’images de Midjourney ait été critiquée par les artistes, les outils de génération d’images vous permettent de créer n’importe quelle image que vous pouvez imaginer, même si vous n’avez ni talent ni formation.

Qu’est-ce que DALL-E mini ?

DALL-E mini est un modèle d’IA de conversion texte-image créé par Boris Dayma. Il est formé sur un ensemble massif de données de texte et d’images et peut générer des images photoréalistes à partir de descriptions textuelles. Le modèle est encore en cours de développement, mais il a déjà généré des résultats impressionnants.

DALL·E mini est un outil puissant qui peut être utilisé à diverses fins, notamment :

- Création d’illustrations pour des livres, des articles et des sites Web

- Génération d’art conceptuel pour les jeux vidéo et les films

- Concevoir des prototypes de produits

- Visualiser des idées abstraites

Le modèle est encore en cours de développement, mais il a déjà généré des résultats impressionnants. Par exemple, il peut générer des images à la fois photoréalistes et créatives. Il peut également générer des images basées sur des descriptions textuelles complexes, telles que « Un chat portant un haut-de-forme et faisant du vélo ».

Découvrez comment Boris Dayma explique DALL-E mini à Pondérations et biais Chaîne YouTube ci-dessous.

Comment le DALL-E mini se compare-t-il au DALL-E 2 ?

La comparaison entre le DALL-E Mini auto-hébergé et son homologue, DALL-E2, révèle des avantages et des considérations distincts. Un aspect important est la possibilité d’affiner les modèles pour répondre à des besoins spécifiques. La capacité de données personnalisées et de réglage fin dans DALL-E Mini, en particulier dans différentes langues ou domaines spécialisés, offre un avantage essentiel. Cette capacité à « piloter » des modèles pour générer des résultats spécifiques, tels qu’un « robot avocat » ou des images nuancées, s’avère être un outil puissant.

Cependant, cette innovation s’accompagne de son propre ensemble de considérations, notamment les exigences en matière d’infrastructure. Alors que DALL-E 2 fonctionne via une simple requête réseau, DALL-E Mini nécessite une infrastructure informatique plus élevée, nécessitant un GPU robuste ou un puissant serveur multi-CPU pour des performances efficaces.

Au cœur des fonctionnalités du DALL-E Mini se trouve un réseau de décodeurs séquence à séquence construit sur le modèle de transformateur bidirectionnel et auto-régressif (BART). Ce pipeline complexe comprend quatre composants :

- Encodeur image vers jeton

- Encodeur de texte

- Décodeur BART Seq2seq

- Décodeur de jetons en image

Pendant la formation, DALL-E Mini utilise environ 15 millions de paires légende-image pour former le décodeur crucial BART seq2seq. Cela implique la génération de jetons d’image à partir d’images via un encodeur VQGAN et la conversion de descriptions de texte en jetons d’intégration de texte via un encodeur BART. Le décodeur seq2seq génère ensuite une séquence de jetons d’image basée sur ces intégrations.

À des fins d’inférence, avec juste une invite de texte à portée de main, l’encodeur de texte BART génère des intégrations pour l’invite, déclenchant le processus de prédiction de séquence pour créer des images.

Des performances impressionnantes

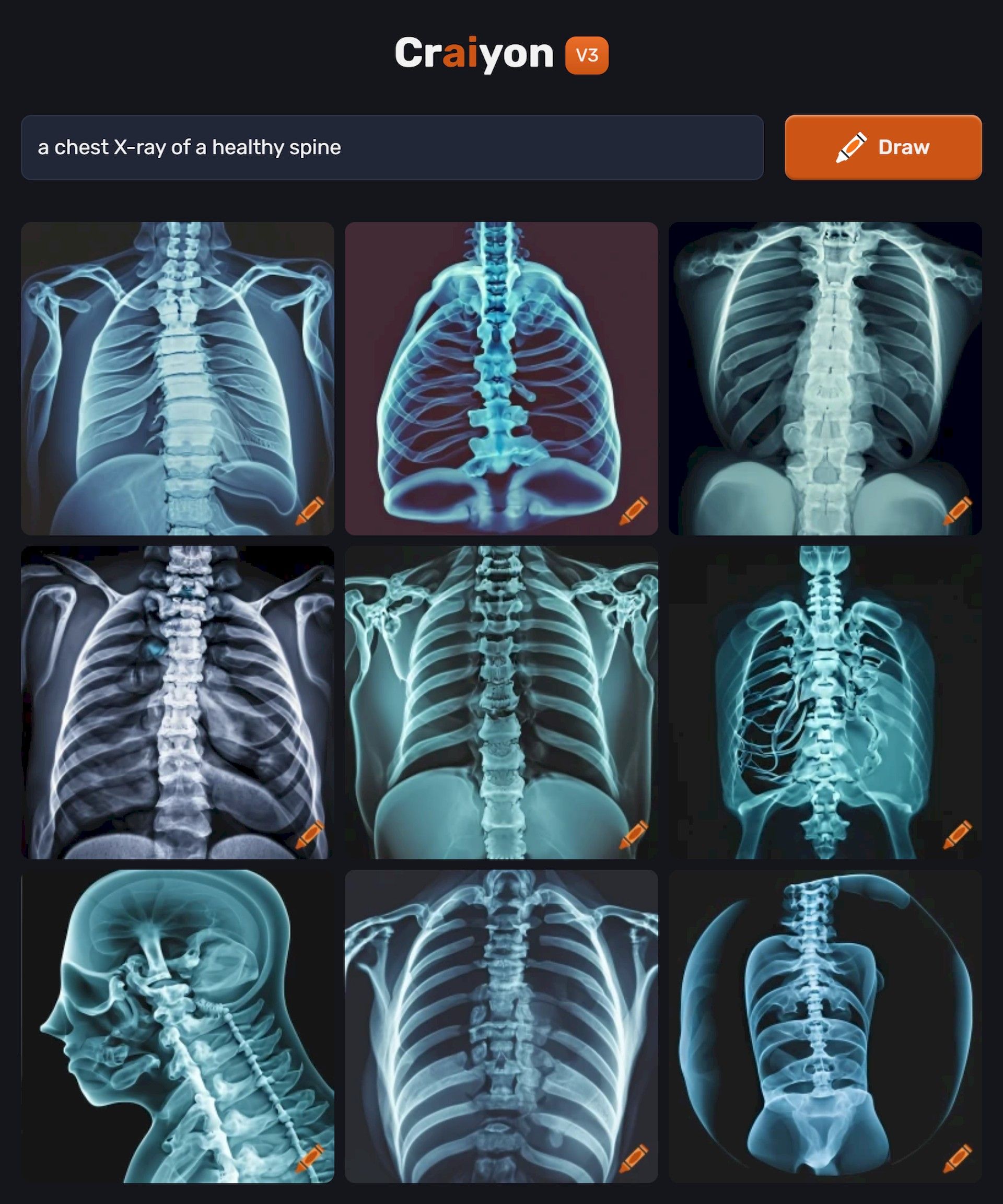

Les performances du DALL-E Mini sont particulièrement fascinantes lorsqu’elles sont testées dans des contextes de complexité variable. Depuis des invites relativement simples, comme visualiser une « fille jouant au golf » où elle rencontre des difficultés dans le placement des mains par rapport au club de golf, jusqu’à des invites plus spécialisées dans le domaine des soins de santé, comme « une radiographie pulmonaire d’une colonne vertébrale saine » qui donne des résultats impressionnants et Des résultats anatomiquement « presque » précis, le modèle montre ses forces et ses limites.

Comment utiliser DALL-E mini gratuitement ?

Il existe deux manières principales d’utiliser DALL-E mini gratuitement :

- Utiliser le site Craiyon: La façon la plus simple d’utiliser DALL-E mini est d’utiliser le site Web de Craiyon. Vous n’avez pas besoin de créer un compte pour utiliser le site, mais vous devrez compléter un CAPTCHA à chaque fois que vous générerez une image

- Utilisez la mini-API DALL-E: Si vous êtes développeur, vous pouvez utiliser la mini API DALL-E pour intégrer le modèle dans vos propres applications. L’API est actuellement en version bêta, mais son utilisation est gratuite

Voici les étapes à suivre pour utiliser le site Web Craiyon pour générer une image avec DALL-E mini :

- Allez au Site Internet de Craiyon ou Hub HugginFace du DALL-E mini

- Entrez une description textuelle de l’image que vous souhaitez générer

- Cliquez sur le bouton « Générer »

- Le modèle générera quatre images basées sur votre description textuelle

- Vous pouvez enregistrer les images sur votre ordinateur ou les partager avec d’autres

Donc, si vous avez besoin d’un outil de génération d’images gratuit, DALL-E mini semble être là pour répondre à vos besoins. Alors que nous entrons dans les derniers mois de 2023, il est passionnant pour nous tous d’observer l’évolution des technologies d’IA. Voyons ce que le temps nous montrera encore en matière d’intelligence artificielle.

Crédit image en vedette: Joanna Kosinska/Unsplash.