OpenAI, la principale société de recherche à but non lucratif sur l’IA, a signé une lettre d’intention avec Pluie IA, une startup développant des processeurs neuromorphiques (NPU) spécifiquement adaptés aux applications d’IA. L’accord décrit l’engagement d’OpenAI à acheter pour 51 millions de dollars de NPU de Rain AI dès leur disponibilité commerciale.

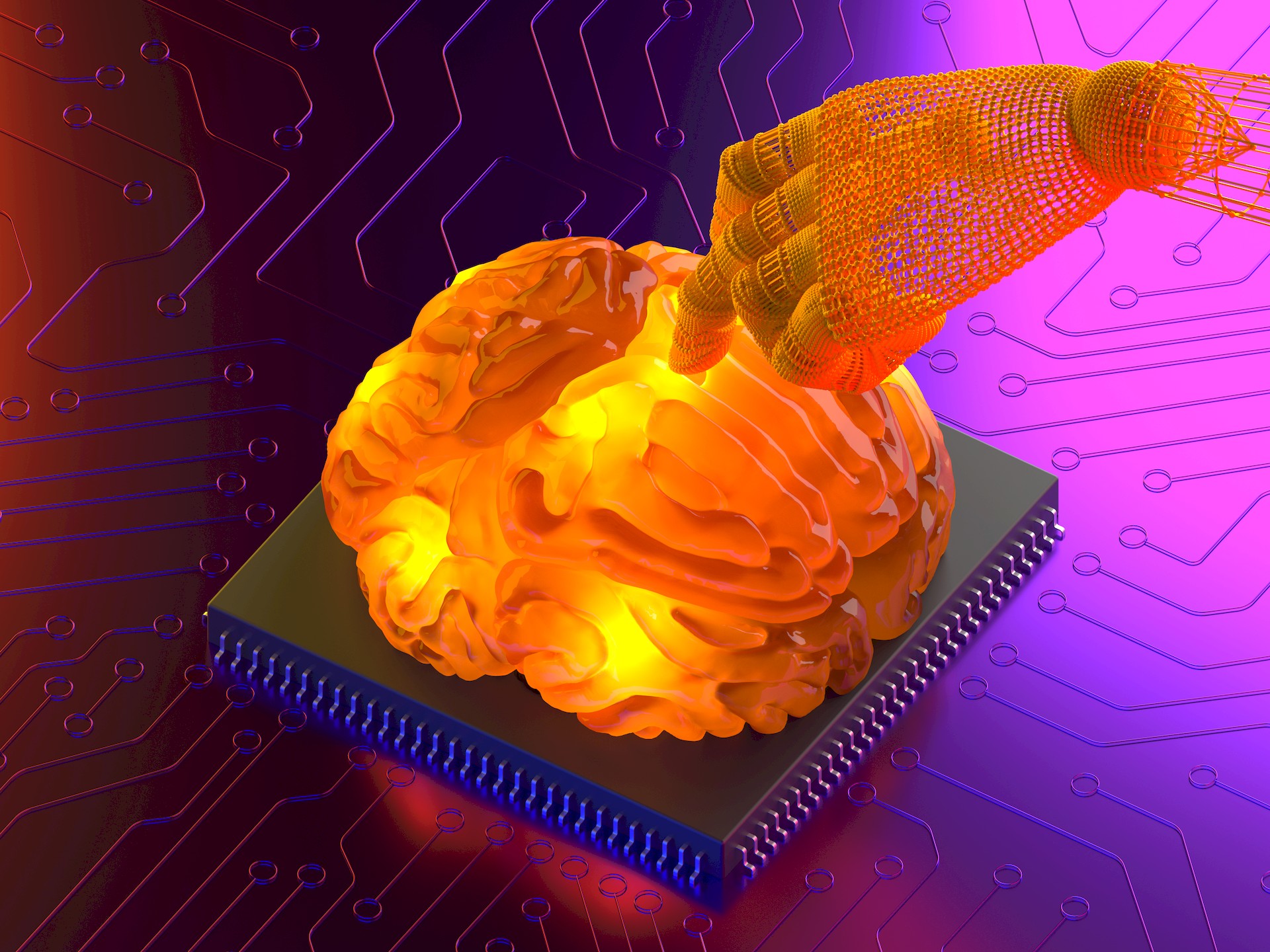

Ces dernières années, le besoin de matériel spécialisé est devenu de plus en plus évident pour les technologies d’IA. Les entreprises d’IA repoussent leurs limites pour proposer des expériences personnalisées à leurs clients. Les NPU de Rain AI, surnommées « Dendrites numériques », sont inspiré de la structure et du fonctionnement du cerveau humain. Ils sont conçus pour imiter la capacité du cerveau à traiter les informations de manière efficace et avec une faible consommation d’énergie, ce qui en fait une solution prometteuse pour les besoins informatiques exigeants des tâches d’IA.

Au cœur de ce partenariat se trouve une lettre d’intention signée en 2019, décrivant Intention d’OpenAI d’acheter pour 51 millions de dollars de NPU de Rain AI dès leur disponibilité commerciale. Cet investissement substantiel souligne la conviction d’OpenAI dans le potentiel de transformation de la technologie Rain AI.

Qu’est-ce que RainAI ?

Rain AI est une startup qui développe des processeurs neuromorphiques (NPU), qui sont un type de puce informatique conçue pour imiter la structure et le fonctionnement du cerveau humain. Les NPU sont considérés comme une technologie prometteuse pour les applications d’intelligence artificielle (IA), car ils ont le potentiel d’être beaucoup plus économes en énergie que les GPU traditionnels, qui sont actuellement le type d’accélérateur d’IA le plus largement utilisé.

Les NPU de Rain AI, surnommés « Digital Dendrites », sont encore en développement, mais la société a affirmé qu’elles pourraient être potentiellement 100 fois plus puissant et 10 000 fois plus économe en énergie que les GPU. La société a également déclaré que ses NPU pourraient être utilisées pour entraîner des modèles d’IA ainsi que pour les exécuter une fois déployés.

Rain AI a reçu des financements d’un certain nombre d’investisseurs de premier plan, dont Sam Altman, PDG d’OpenAI, et Aramco Ventures, la branche de capital-risque de Saudi Aramco. La société travaillerait également avec un certain nombre de grandes entreprises technologiques, notamment Google, Oracle, Meta, Microsoft et Amazon.

Malgré sa technologie prometteuse et ses bailleurs de fonds de premier plan, Rain AI est confrontée à un certain nombre de défis. Les NPU de la société sont encore en développement et on ne sait pas quand elles seront disponibles dans le commerce. De plus, Rain AI devra rivaliser avec un certain nombre d’acteurs établis sur le marché du matériel d’IA, notamment Nvidia, Google et Amazon.

Comment fonctionnent les NPU ?

Comme mentionné précédemment, les processeurs neuromorphiques (NPU) sont un type d’accélérateur d’intelligence artificielle (IA) conçu pour imiter la structure et le fonctionnement du cerveau humain. Contrairement aux processeurs traditionnels qui reposent sur des instructions séquentielles, les NPU reposent sur un réseau de synapses artificielles interconnectées, semblables aux connexions neuronales du cerveau.

Cette architecture permet aux NPU de traiter les informations de manière parallèle et distribuée, ce qui les rend bien adaptées aux tâches de calcul intensives impliquées dans les applications d’IA.

Voici une description détaillée du fonctionnement des NPU :

- Entrée et synapses: Les informations sont introduites dans le NPU via sa couche d’entrée, où elles sont représentées sous forme de pics ou d’impulsions d’activité électrique. Ces pics sont ensuite transmis aux synapses artificielles, qui agissent comme unités de calcul de base du NPU.

- Pondération synaptique: Chaque synapse est associée à un poids, qui détermine la force de la connexion entre les neurones d’entrée et de sortie. Ces poids sont ajustés dynamiquement pendant le processus de formation, permettant au NPU d’apprendre des données et d’améliorer ses performances.

- Activation neuronale: Lorsqu’un pic arrive au niveau d’une synapse, il contribue à l’activation du neurone postsynaptique. Si l’activation cumulée dépasse un certain seuil, le neurone se déclenche, générant son propre pic. Ce processus est répliqué sur tout le réseau, permettant au NPU d’effectuer des calculs complexes

- Apprentissage et adaptation: Les NPU sont capables d’apprendre et de s’adapter à de nouvelles données en ajustant le poids de leurs synapses. Ce processus, connu sous le nom de plasticité synaptique, imite la façon dont le cerveau humain apprend et forme de nouveaux souvenirs.

- Traitement parallèle: Contrairement aux processeurs traditionnels qui exécutent les instructions de manière séquentielle, les NPU effectuent des calculs en parallèle sur le réseau de neurones interconnectés. Cette architecture parallèle permet aux NPU d’atteindre des vitesses de traitement nettement plus élevées pour les charges de travail d’IA.

En résumé, les NPU offrent plusieurs avantages par rapport aux processeurs traditionnels pour les applications d’IA, notamment :

- Traitement parallèle pour des calculs plus rapides

- Plasticité synaptique pour l’apprentissage et l’adaptation

- Efficacité énergétique pour les appareils à puissance limitée

Comment les puces Rain peuvent-elles aider au développement de l’IA ?

Les unités de traitement neuronal (NPU) sont des accélérateurs matériels spécialisés conçus pour gérer les tâches exigeantes en termes de calcul de l’intelligence artificielle (IA), en particulier l’apprentissage automatique et l’apprentissage profond. Ils offrent plusieurs avantages par rapport aux CPU et GPU traditionnels, ce qui les rend de plus en plus cruciaux pour le développement de l’IA.

Performances et efficacité améliorées

Les NPU sont spécialement conçus pour accélérer les opérations mathématiques couramment utilisées en IA, telles que les multiplications matricielles et les convolutions. Cette architecture spécialisée leur permet d’effectuer ces opérations beaucoup plus rapidement et plus efficacement que les CPU et les GPU, conduisant à des améliorations substantielles de la formation des modèles d’IA et de la vitesse d’inférence.

Consommation d’énergie réduite

Les NPU sont conçus pour être très économes en énergie, consommant beaucoup moins d’énergie que les CPU et les GPU tout en offrant des performances comparables, voire supérieures. Cette efficacité énergétique est particulièrement importante pour les appareils de pointe, tels que les smartphones et les appareils IoT, où la durée de vie de la batterie constitue une contrainte critique.

Fonctionnalités spécialisées pour les charges de travail d’IA

Les NPU intègrent souvent des fonctionnalités spécialisées adaptées aux charges de travail d’IA, telles que des fonctions d’activation accélérées par le matériel et la prise en charge de divers formats de données couramment utilisés dans les modèles d’IA. Ces fonctionnalités améliorent encore les performances et l’efficacité des applications d’IA.

Latence réduite

Les NPU offrent une latence plus faible que les CPU et les GPU, ce qui signifie qu’ils peuvent traiter les données et produire des résultats plus rapidement. Ceci est particulièrement important pour les applications d’IA en temps réel, telles que les véhicules autonomes et le traitement du langage naturel.

Permettre des modèles d’IA plus complexes

Les performances et l’efficacité améliorées des NPU permettent le développement et l’exécution de modèles d’IA plus complexes et plus exigeants qui ne seraient pas réalisables avec les CPU et GPU conventionnels. Cela permet de faire progresser des domaines tels que le traitement du langage naturel, l’analyse d’images et l’apprentissage automatique.

En bref, les NPU constituent une technologie essentielle au développement de l’IA. Ils offrent de nombreux avantages par rapport au matériel traditionnel, ce qui les rend parfaitement adaptés aux tâches d’IA complexes et exigeantes.

À mesure que la technologie de l’IA continue de progresser, les NPU devraient jouer un rôle encore plus important dans la création de la prochaine génération d’applications d’IA.

Altman revient

Les semaines mouvementées de Sam Altman avec OpenAI sont terminées et il retourne au travail. Alors que l’on s’attendait à ce que l’entreprise d’IA subisse de nombreux dégâts dans le processus, au contraire, la révélation de Q-étoile, ChatGPT avec voixet maintenant, l’investissement de Rain AI montre une fois de plus à de nombreux acteurs du secteur pourquoi OpenAI est une entreprise prospère.

Les entreprises d’intelligence artificielle ont un enjeu énorme dans notre avenir et nous sommes chaque jour confrontés à une nouvelle invention. L’utilisation généralisée de l’IA, qui a commencé avec des chatbots lents et défectueux au début de 2023, est une question de curiosité quant à ce qu’elle nous montrera de plus un mois avant 2024.

En tant qu’utilisateurs et journalistes, tout ce que nous pouvons faire, c’est espérer qu’une vie pleinement autonome dans les dessins animés nous attend, et non l’avenir chaotique de la science-fiction.

Crédit image en vedette: Pluie IA.