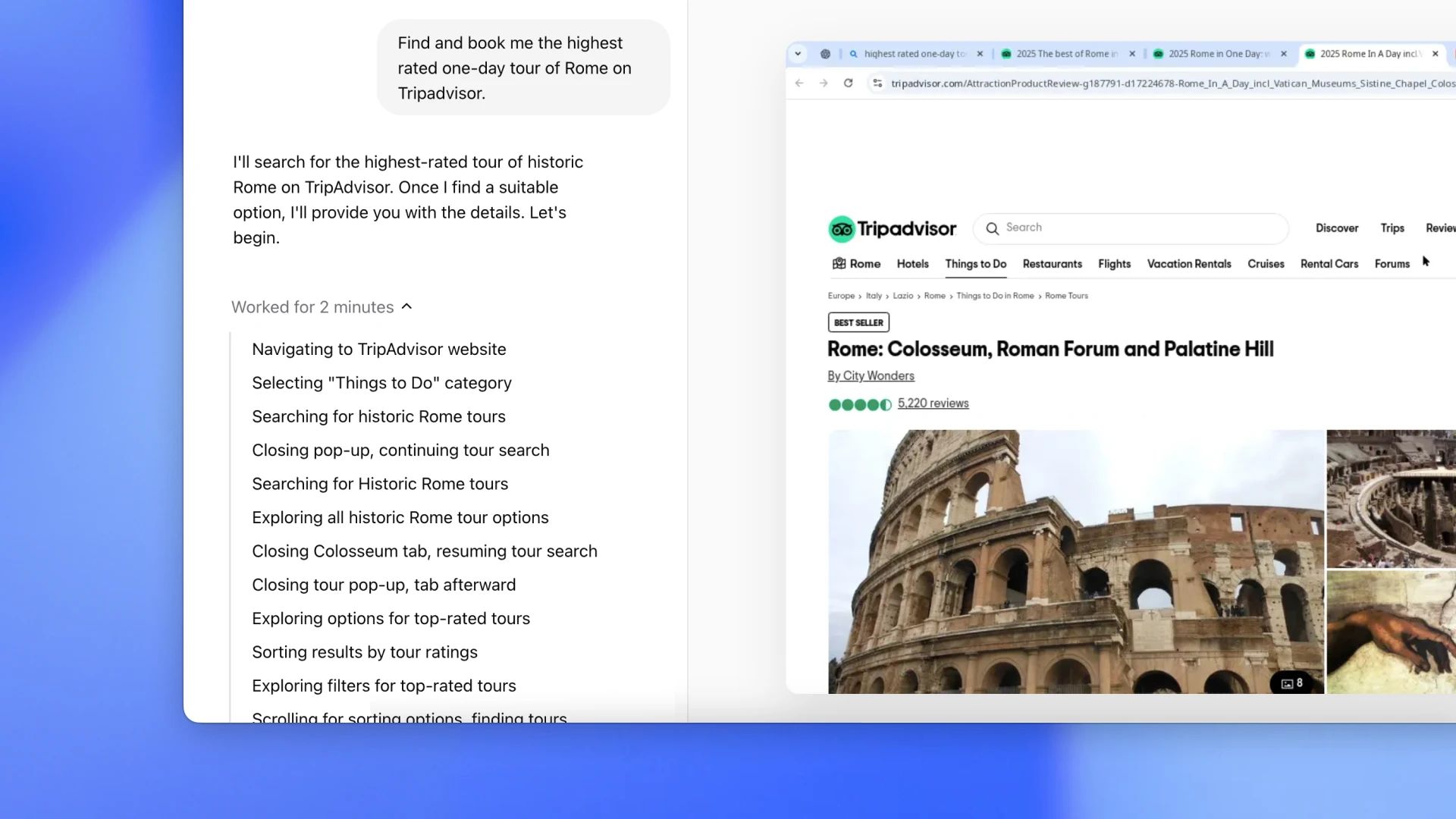

Apple a discrètement présenté le Ferret LLM, un modèle de langage multimodal tout sauf ordinaire. Ce lancement silencieux s’écarte de la norme en fusionnant la compréhension du langage avec l’analyse d’images, redéfinissant ainsi la portée des capacités de l’IA.

Diffusé discrètement sur GitHub, Ferret LLM marque le pas subtil d’Apple vers l’ouverture, invitant les développeurs et les chercheurs à découvrir son potentiel. Cependant, lors de son lancement, des défis se profilent pour adapter Ferret à des modèles plus grands, posant des obstacles liés à l’infrastructure. Pourtant, l’impact potentiel de Ferret sur les appareils Apple est considérable, promettant une nouvelle dimension dans les interactions des utilisateurs et une compréhension plus profonde du contenu visuel. Vous voulez en savoir plus ? Nous avons rassemblé tout ce que vous devez savoir sur la dernière initiative d’Apple dans le paysage de l’IA.

Qu’est-ce que le LLM Apple Ferret ?

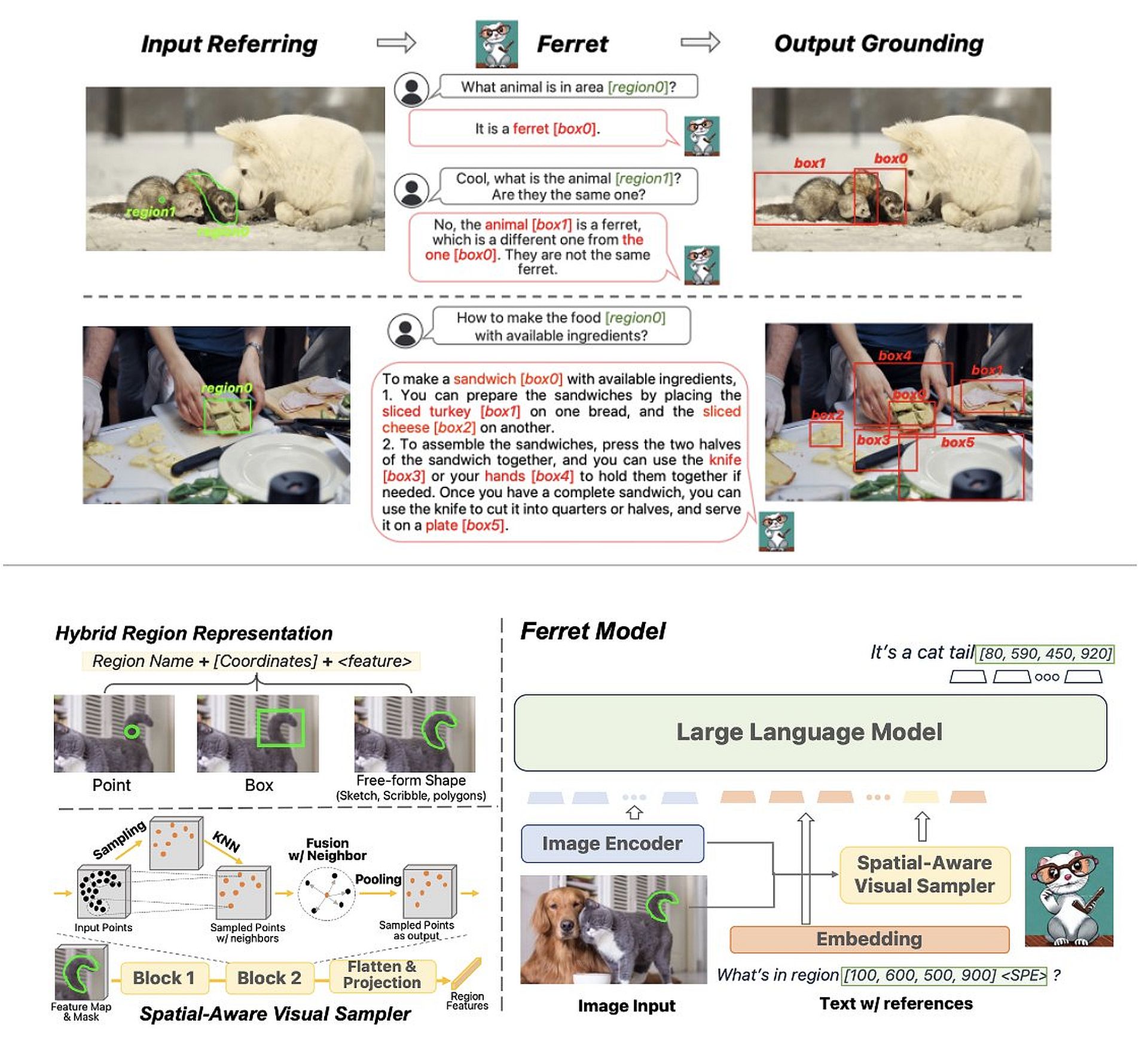

Ferret, un grand modèle de langage multimodal (LLM) open source développé par Apple Inc. en collaboration avec l’Université Cornell, se distingue par son intégration unique de la compréhension du langage avec l’analyse d’images. Sorti le GitHubil s’écarte des modèles de langage traditionnels en incorporant des éléments visuels dans son traitement.

Voici comment fonctionne le LLM Apple Ferret :

- Intégration visuelle : Ferret ne se limite pas à la compréhension textuelle mais analyse des régions spécifiques des images, en identifiant les éléments qu’elles contiennent. Ces éléments sont ensuite utilisés dans le cadre d’une requête, permettant à Ferret de répondre à des invites impliquant à la fois du texte et des images.

- Réponses contextuelles : Par exemple, lorsqu’on lui demande d’identifier un objet dans une image, Ferret non seulement reconnaît l’objet, mais exploite les éléments environnants pour fournir des informations ou un contexte plus profonds, allant au-delà de la simple reconnaissance d’objet.

Zhe Gan, chercheur scientifique chez Apple AI, a souligné la capacité de Ferret à référencer et comprendre les éléments des images à différents niveaux de détail. Cette flexibilité permet à Ferret de comprendre des requêtes impliquant un contenu visuel complexe.

Ce qui distingue l’introduction de Ferret, ce sont ses prouesses technologiques et l’évolution stratégique d’Apple vers l’ouverture. S’écartant de sa nature généralement réservée, Apple a choisi de publier Ferret en tant que Open source modèle. Ce changement vers la transparence signifie une approche collaborative, invitant les contributions et favorisant un écosystème où les chercheurs et les développeurs du monde entier peuvent améliorer, affiner et explorer les capacités du modèle.

Défis à venir

L’émergence de Ferret annonce une nouvelle ère dans l’IA, où la compréhension multimodale devient la norme plutôt que l’exception. Ses capacités ouvrent les portes à une myriade d’applications dans divers domaines, de l’analyse de contenu améliorée aux interactions innovantes homme-IA.

Cependant, Apple est confronté à des difficultés pour faire évoluer Ferret en raison des limitations de l’infrastructure, soulevant des questions sur sa capacité à rivaliser avec des géants de l’industrie comme GPT-4 dans le déploiement de modèles linguistiques à grande échelle. Ce dilemme nécessite des décisions stratégiques, impliquant potentiellement des partenariats ou une adoption plus poussée des principes de l’open source pour tirer parti de l’expertise et des ressources collectives.

Pour des informations plus détaillées sur le LLM Apple Ferret, visitez sa page arXiv.

Impact potentiel d’Apple Ferret LLM sur les iPhones et autres appareils Apple

L’introduction du Ferret LLM d’Apple pourrait potentiellement avoir un impact significatif sur divers produits Apple, notamment en améliorant l’expérience utilisateur et les fonctionnalités des manières suivantes :

Interactions basées sur des images améliorées

L’intégration de l’analyse d’image d’Apple Ferret LLM dans Siri pourrait permettre des interactions plus sophistiquées et contextuelles. Les utilisateurs peuvent poser des questions sur les images ou demander des actions basées sur le contenu visuel.

Les capacités de Ferret pourraient alimenter des fonctionnalités de recherche visuelle avancées au sein de l’écosystème d’Apple. Les utilisateurs peuvent rechercher des éléments ou des informations dans les images, conduisant ainsi à une expérience de recherche plus intuitive et plus complète.

Assistance utilisateur augmentée

La capacité de Ferret à interpréter des images et à fournir des informations contextuelles pourrait grandement profiter aux utilisateurs ayant des besoins d’accessibilité. Il pourrait aider à identifier des objets ou des scènes pour les utilisateurs malvoyants, améliorant ainsi leurs interactions quotidiennes avec les appareils Apple.

L’intégration de Ferret pourrait améliorer les capacités d’ARKit d’Apple, permettant des expériences de réalité augmentée plus sophistiquées et interactives basées sur la compréhension des images et des réponses contextuelles.

Compréhension enrichie des médias et du contenu

Ferret pourrait améliorer les fonctionnalités d’organisation et de recherche au sein de l’application Photos en reconnaissant et en indexant des éléments spécifiques dans les images et les vidéos, permettant ainsi une catégorisation et une recherche plus intelligentes.

En tirant parti de la compréhension des images de Ferret, Apple pourrait proposer des recommandations de contenu plus personnalisées basées sur les interactions des utilisateurs avec le contenu visuel de son écosystème.

Innovation des développeurs

Les développeurs pourraient exploiter les capacités de Ferret pour créer des applications innovantes dans divers domaines, de l’éducation aux soins de santé, en intégrant une compréhension avancée des images et du langage dans leurs applications.

Cependant, la mise en œuvre des capacités de Ferret dans les produits Apple dépendrait de divers facteurs, notamment de la faisabilité technologique, des considérations relatives à la confidentialité des utilisateurs et du degré d’intégration dans les logiciels et matériels Apple existants. De plus, les décisions stratégiques d’Apple concernant l’évolutivité et le déploiement de Ferret au sein de sa gamme de produits détermineront l’impact réel sur les fonctionnalités destinées aux consommateurs.

Crédit image en vedette : Jhon Paul Dela Cruz/Unsplash