S’appuyant sur le succès de Lama 2Meta AI dévoile Code Lama 70B, un modèle de génération de code considérablement amélioré. Cette centrale peut écrire du code dans différents langages (Python, C++, Java, PHP) à partir d’invites en langage naturel ou d’extraits de code existants, et ce avec une vitesse, une précision et une qualité sans précédent.

Code Llama 70B est l’un des plus grands modèles d’IA open source pour la génération de code, établissant une nouvelle référence dans ce domaine. Son objectif est d’automatiser la création et la modification de logiciels, rendant ainsi le développement de logiciels plus efficace, accessible et créatif. Imaginez décrire le programme souhaité sur votre ordinateur et lui demander de le coder pour vous. Ou modifier sans effort le code existant avec des commandes simples. Peut-être même traduire le code entre les langues de manière transparente. Ce ne sont là que quelques possibilités offertes par des modèles comme le Code Llama 70B.

Cependant, générer du code présente des défis uniques. Contrairement à l’ambiguïté et à la flexibilité du langage naturel, le code exige précision et rigidité. Il doit respecter des règles et une syntaxe strictes, produisant le résultat et le comportement escomptés. De plus, le code peut être complexe et long, nécessitant un contexte et une logique importants à comprendre et à générer. Pour surmonter ces obstacles, il faut des modèles dotés d’immenses données, puissance de traitement et intelligence.

Qu’est-ce que le code Lama 70B ?

Ce modèle de langage étendu (LLM) de pointe propose une formation sur un nombre impressionnant de 500 milliards de jetons de code et de données associées, surpassant ses prédécesseurs en termes de capacité et de robustesse. De plus, sa fenêtre contextuelle étendue de 100 000 jetons lui permet de traiter et de générer un code plus long et plus complexe.

Code Llama 70B s’appuie sur Llama 2, un LLM de 175 milliards de paramètres capable de générer du texte dans divers domaines et styles. Cette version spécialisée subit des réglages précis pour la génération de code utilisant l’auto-attention, une technique lui permettant d’apprendre les relations et les dépendances au sein du code.

Code Llama 70B peut être utilisé pour diverses tâches, notamment :

- Générer du code à partir de descriptions en langage naturel

- Traduire du code entre différents langages de programmation

- Rédaction de tests unitaires

- Code de débogage

- Répondre aux questions sur le code

De nouveaux sommets en matière de précision et d’adaptabilité

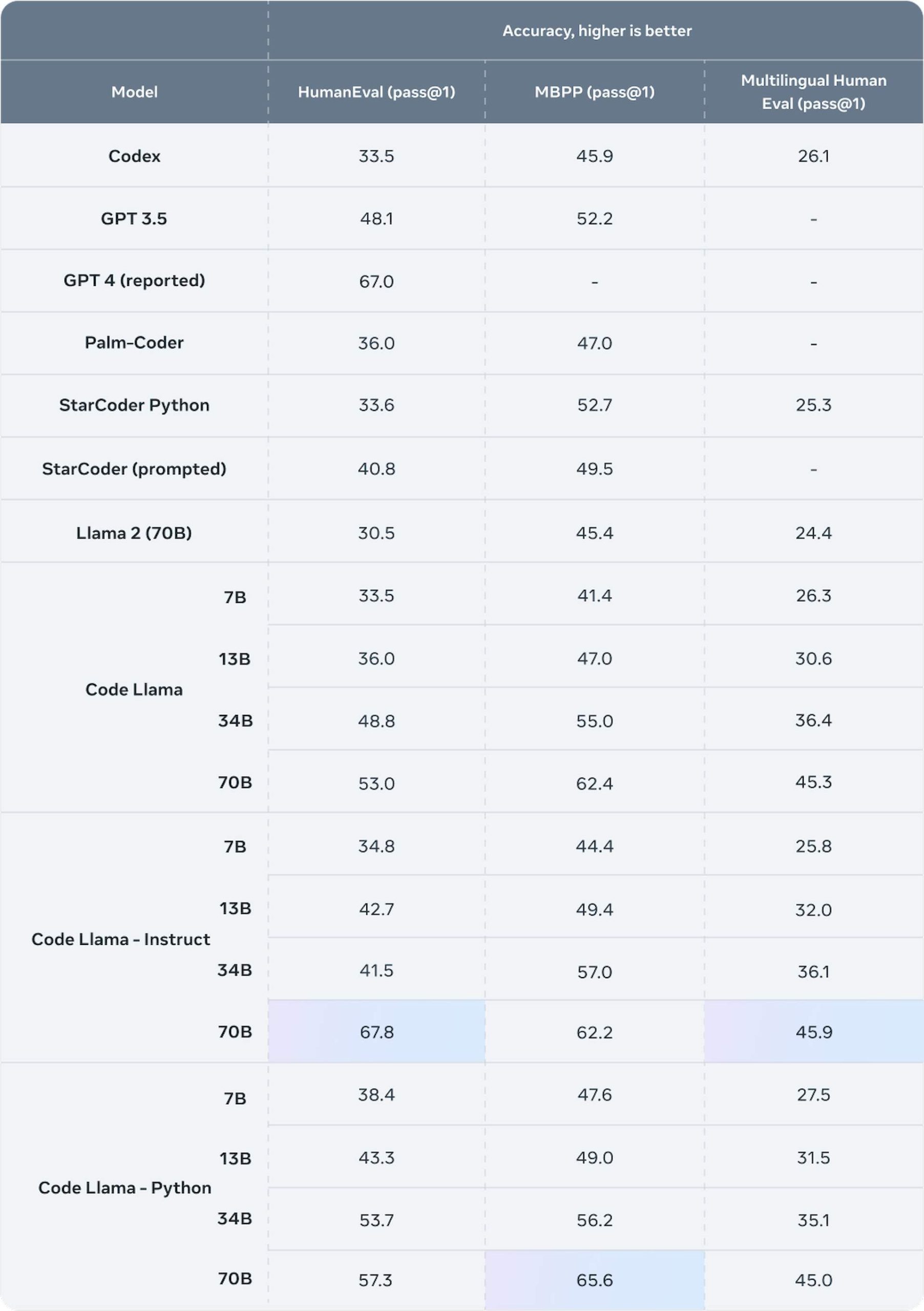

L’un des points forts de Code Llama 70B est CodeLlama-70B-Instruct, une variante capable de comprendre les instructions en langage naturel et de générer le code correspondant. Cette variante a obtenu un score de 67,8 sur HumanEvalun benchmark mesurant l’exactitude fonctionnelle et la logique des modèles de génération de code à l’aide de 164 problèmes de programmation.

Cela surpasse les résultats précédents du modèle ouvert (CodeGen-16B-Mono : 29,3, StarCoder : 40,1) et rivalise avec les modèles fermés (GPT-4 : 68,2, Gemini Pro : 69,4). CodeLlama-70B-Instruct s’attaque à diverses tâches telles que le tri, la recherche, le filtrage et la manipulation de données, ainsi que la mise en œuvre d’algorithmes (recherche binaire, Fibonacci, factorielle).

Code Llama 70B propose également CodeLlama-70B-Python, une variante optimisée pour Python, un langage largement utilisé. Formé sur 100 milliards de jetons supplémentaires de code Python, il excelle dans la génération de code Python fluide et précis. Ses capacités couvrent le web scraping, l’analyse de données, l’apprentissage automatique et le développement Web.

Accessible pour la recherche et l’usage commercial

Code Llama 70B, sous la même licence que Llama 2 et les modèles Code Llama antérieurs, est téléchargeable gratuitement pour les chercheurs et les utilisateurs commerciaux, permettant son utilisation et sa modification. L’accès et l’utilisation sont possibles via diverses plates-formes et frameworks tels que Hugging Face, PyTorch, TensorFlow et Jupyter Notebook. De plus, Meta AI fournit de la documentation et des didacticiels pour l’utilisation et le réglage du modèle dans différents objectifs et langages.

Mark Zuckerberg, PDG de Meta AI, a déclaré dans un message sur Facebook : « Nous mettons en open source un nouveau Code Llama amélioré, comprenant un modèle de paramètres plus grand de 70 B. L’écriture et l’édition de code sont aujourd’hui devenues l’une des utilisations les plus cruciales des modèles d’IA. La capacité de coder s’est également avérée précieuse pour les modèles d’IA afin de traiter les informations dans d’autres domaines de manière plus rigoureuse et logique. Je suis fier des progrès réalisés ici et j’ai hâte de voir ces avancées intégrées dans Llama 3 et les futurs modèles également ».

Comment installer Code Lama 70B

Voici les étapes pour installer CodeLlama 70B localement gratuitement :

- Demande de téléchargement depuis Meta AI ou visitez le lien ici pour accéder à la fiche modèle

- Cliquez sur le bouton de téléchargement à côté du modèle de base

- Ouvrez l’onglet de conversation dans Studio LM

- Sélectionnez le modèle Code Llama que vous venez de télécharger

- Commencez à discuter avec le modèle dans l’interface de LM studio

Code Llama 70B est sur le point d’avoir un impact significatif sur la génération de code et l’industrie du développement de logiciels en fournissant un outil puissant et accessible pour la création et l’amélioration de code. Il a le potentiel de réduire les barrières à l’entrée pour les aspirants codeurs en offrant des conseils et des commentaires basés sur des instructions en langage naturel. De plus, Code Llama 70B pourrait ouvrir la voie à de nouvelles applications et cas d’utilisation, notamment la traduction, la synthèse, la documentation, l’analyse et le débogage de code.

Crédit image en vedette: WangXiNa/Freepik.