La course à des modèles d’intelligence artificielle toujours plus grands est l’une des caractéristiques des progrès récents. Cependant, Microsoft fait bouger les choses avec le Phi-3 Mini, un modèle d’IA aux capacités impressionnantes malgré sa taille compacte.

Traditionnellement, le succès des grands modèles de langage (LLM) est lié au nombre de paramètres – essentiellement les éléments constitutifs qui éclairent la compréhension du langage par le modèle.

En tenant compte des coûts informatiques et de la disponibilité pour tous, Microsoft Phi-3 est là pour changer cette approche « traditionnelle ».

Microsoft Phi-3 Mini tient un géant dans vos poches

GPT-3.5, actuellement en tête de la course LLM, possède un nombre impressionnant de 175 milliards de paramètres. Ce nombre immense permet à GPT-3.5 de traiter de grandes quantités de données textuelles, lui donnant ainsi une compréhension large et nuancée du langage. Mais cette complexité a aussi un coût. L’exécution d’un modèle avec un nombre de paramètres aussi élevé nécessite des ressources de calcul importantes, ce qui le rend coûteux et gourmand en énergie.

Le mini modèle de Microsoft, en revanche, adopte une approche différente. En utilisant un ensemble de paramètres beaucoup plus réduit – seulement 3,8 milliards – le Phi-3 Mini fonctionne avec un niveau d’efficacité qui éclipse ses homologues plus grands. Cette réduction de taille se traduit par plusieurs avantages.

Tout cela fait de Microsoft Phi-3 :

- Nettement moins cher à exploiter

- Une centrale potentielle pour les applications d’IA sur appareil

Programme d’entraînement du Phi-3 Mini

Un autre aspect intrigant du Phi-3 Mini est sa méthode de formation.

Contrairement à ses homologues plus grands formés sur des ensembles de données massifs de texte et de code, la formation de Phi-3 Mini impliquait une sélection plus organisée. Les chercheurs ont opté pour un programme inspiré de la manière dont les enfants apprennent – en utilisant les livres pour enfants comme base.

Cette approche semble avoir donné des résultats positifs, le Phi-3 Mini démontrant des performances rivalisant avec celles du GPT-3.5 sur plusieurs repères.

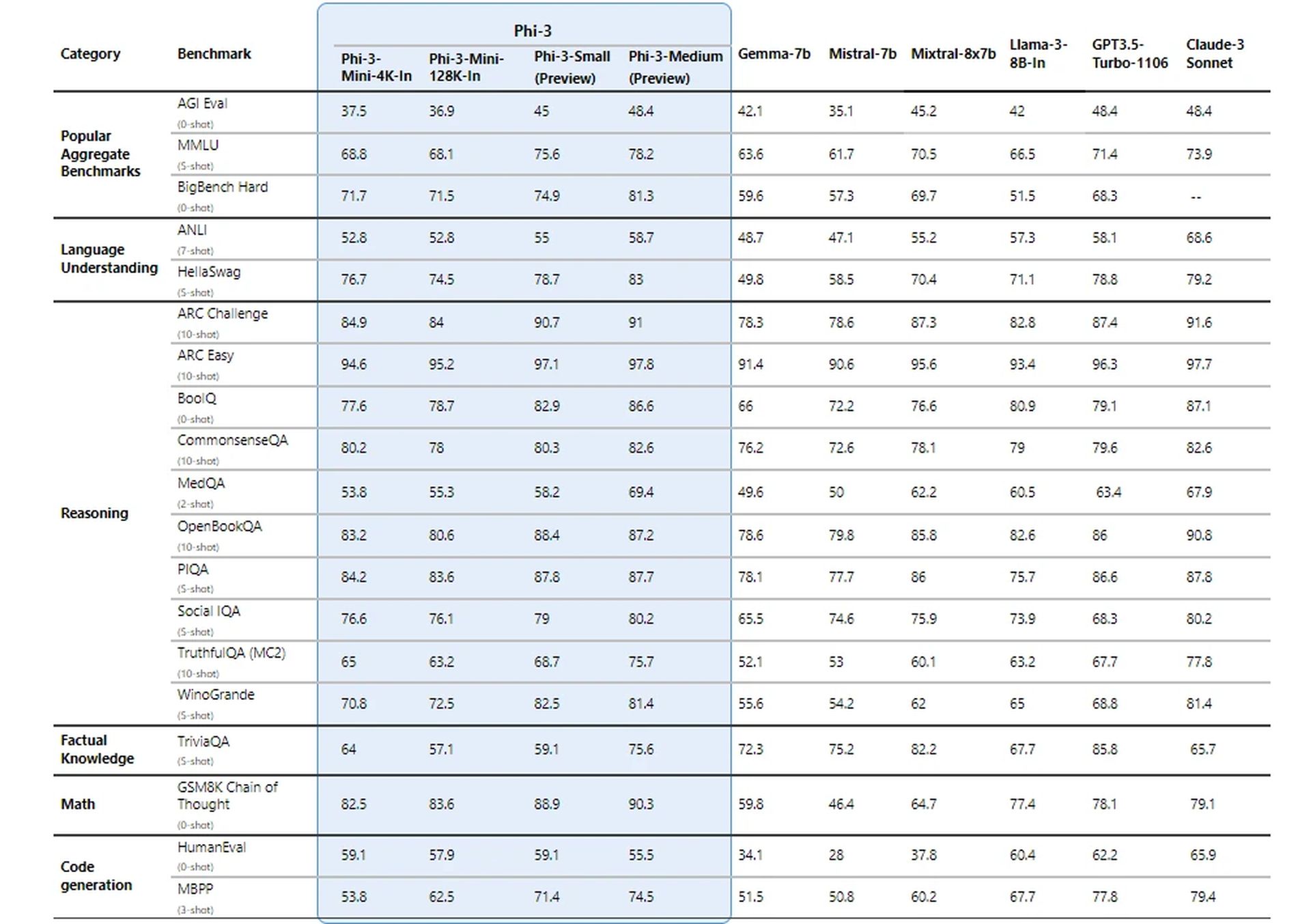

Évalué pour le succès

Les chercheurs de Microsoft ont mis son nouveau modèle à l’épreuve en utilisant des références établies pour les LLM. Le modèle a obtenu des scores impressionnants sur des mesures telles que MMLU (une mesure de la capacité d’un modèle à comprendre des relations complexes dans le langage) et MT-bench (un test des capacités de traduction automatique).

Ces résultats suggèrent que Phi-3 Mini, malgré sa taille, peut rivaliser avec les grands noms du jeu LLM.

Comment obtient-on des résultats aussi impressionnants ?

Les détails techniques du Phi-3 Mini révèlent une approche fascinante pour obtenir des résultats impressionnants avec une taille de modèle remarquablement petite. Voici un aperçu des aspects clés :

Architecture du décodeur de transformateur

Phi-3 Mini utilise une architecture de décodeur de transformateur, un choix de conception répandu pour des modèles de langage efficaces. Cette architecture excelle dans le traitement des données séquentielles comme le texte, permettant au modèle de comprendre les relations entre les mots d’une phrase.

Longueur du contexte

Le Phi-3 Mini standard fonctionne avec une longueur de contexte de 4 000 jetons. Ceci définit le nombre maximum de jetons (mots ou parties de mots) que le modèle prend en compte lors de la génération du texte. Une longueur de contexte plus longue permet une compréhension plus approfondie de la conversation précédente mais nécessite également plus de puissance de traitement.

Version contextuelle longue (Phi-3-Mini-128K)

Pour les tâches nécessitant un contexte plus large, une variante appelée Phi-3-Mini-128K est disponible. Cette version étend la longueur du contexte à 128 000 jetons, ce qui lui permet de gérer des séquences d’informations plus complexes.

Compatibilité avec les outils existants

Pour bénéficier à la communauté des développeurs, Phi-3 Mini partage une structure et une taille de vocabulaire similaires (320 641) avec la famille de modèles Llama-2. Cette compatibilité permet aux développeurs d’exploiter les outils et bibliothèques existants conçus pour Llama-2 lorsqu’ils travaillent avec Phi-3 Mini.

Paramètres du modèle

C’est ici que le Phi-3 Mini brille vraiment. Avec seulement 3,072 milliards de paramètres, il fonctionne bien en dessous des chiffres stupéfiants observés dans des modèles plus grands comme GPT-3.5 (175 milliards de paramètres).

Cette réduction significative des paramètres se traduit par une efficacité exceptionnelle en termes de puissance de traitement et d’utilisation de la mémoire.

Saif Naik de Microsoft explique :

« Notre objectif avec le copilote Krishi Mitra est d’améliorer l’efficacité tout en conservant la précision d’un grand modèle de langage. Nous sommes ravis de nous associer à Microsoft pour utiliser des versions optimisées de Phi-3 afin d’atteindre nos deux objectifs : efficacité et précision ! »

– Saif Naik, responsable de la technologie, ITCMAARS

Méthodologie de formation

La formation de Phi-3 Mini s’inspire de l’approche « Les manuels sont tout ce dont vous avez besoin ». Cette méthode met l’accent sur les données d’entraînement de haute qualité plutôt que sur la simple augmentation de la taille du modèle. Les données de formation sont soigneusement organisées, en se concentrant sur des sources Web avec un « niveau de formation » spécifique et des données synthétiques générées par d’autres LLM.

Cette stratégie permet au Phi-3 Mini d’obtenir des résultats impressionnants malgré sa taille compacte.

Filtrage des données pour un apprentissage optimal

Contrairement aux approches traditionnelles qui privilégient soit les ressources informatiques, soit un entraînement excessif, Phi-3 Mini se concentre sur un « régime de données optimal » pour sa taille. Cela implique de filtrer méticuleusement les données Web pour garantir qu’elles contiennent le bon niveau de « connaissances » et favorisent les capacités de raisonnement.

Par exemple, les données sportives générales peuvent être exclues pour donner la priorité aux informations qui améliorent la capacité de raisonnement du modèle.

Mise au point post-formation

Après le processus de formation de base, le nouveau modèle subit un affinement supplémentaire grâce à un réglage fin supervisé (SFT) et à une optimisation directe des préférences (DPO). SFT expose le modèle à des données organisées dans divers domaines, notamment les mathématiques, le codage et les principes de sécurité. DPO aide à éloigner le modèle des comportements indésirables en identifiant et en excluant les résultats indésirables.

Cette phase post-formation transforme le Phi-3 Mini d’un modèle de langage en un assistant IA polyvalent et sûr.

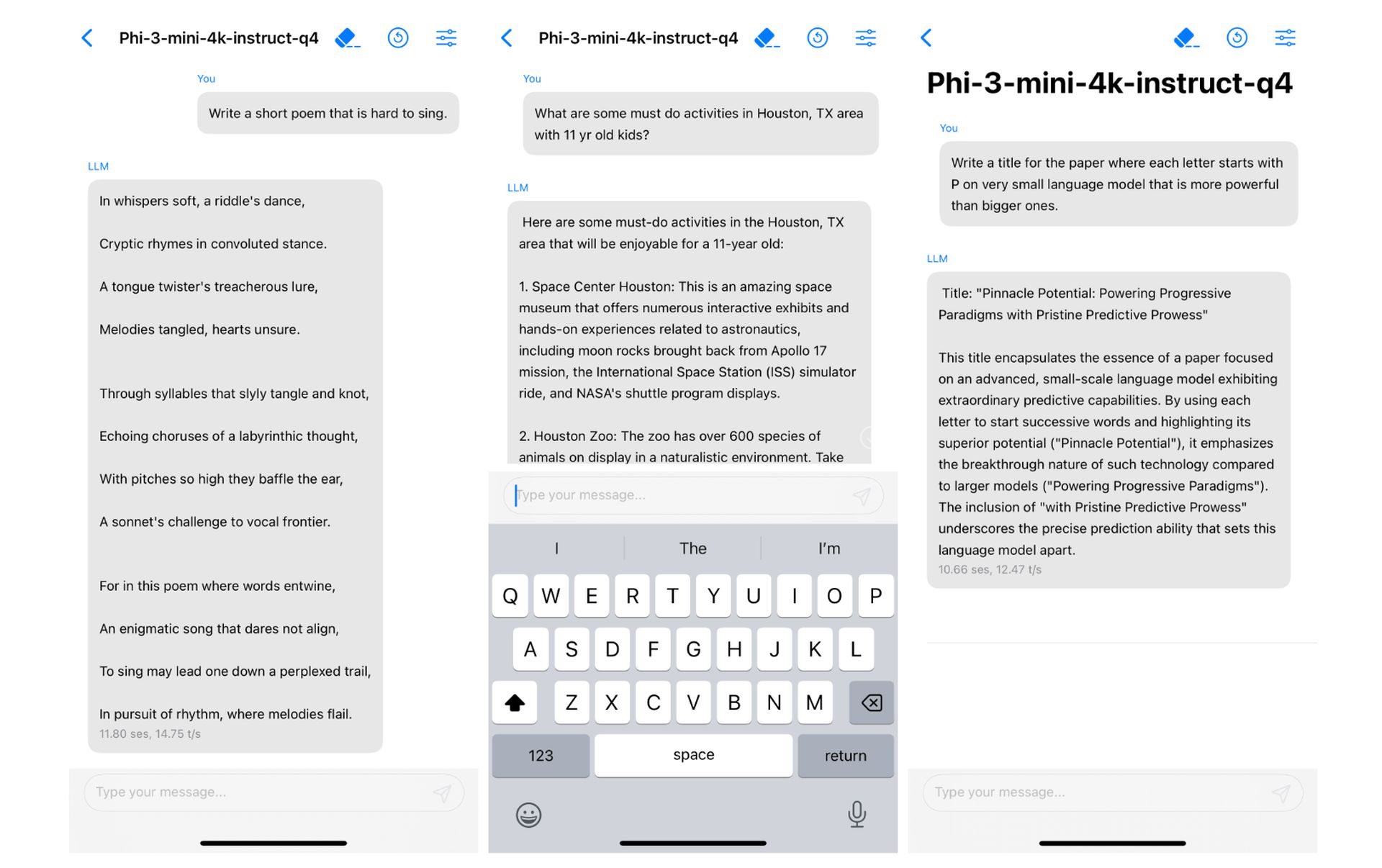

Performances efficaces sur l’appareil

La petite taille du Phi-3 Mini se traduit par des performances exceptionnelles sur l’appareil. En quantifiant le modèle sur 4 bits, il n’occupe que 1,8 Go de mémoire.

Un match paradisiaque

Vous souvenez-vous des tentatives ratées de Microsoft sur les smartphones ? Qu’en est-il de Les accords d’intégration Google Gemini d’Apple ont échoué Ces derniers mois? Ou avez-vous suivi l’actualité selon laquelle Apple s’est exprimé sur l’intégration d’un LLM sur appareil avec iOS 18 au cours des dernières semaines ?

Est ce que cela te dis quelque chose?

Les applications potentielles du Phi-3 Mini sont vastes. Son efficacité le rend idéal pour l’intégration dans les appareils mobiles, permettant potentiellement des fonctionnalités telles que des assistants virtuels plus intelligents et la traduction linguistique en temps réel. De plus, sa rentabilité pourrait ouvrir la porte à une adoption plus large par les développeurs travaillant sur divers projets basés sur l’IA.

Et c’est exactement ce que recherchait Apple. Bien sûr, cette affirmation n’est pour l’instant qu’une supposition, mais il ne serait pas faux de dire qu’il s’agit d’un « match parfait ». En outre, dans le document de recherche, le nouveau projet de Microsoft a déjà été exécuté sur un iPhone avec une puce A16 Bionic nativement.

Le succès de Phi-3 Mini dépend d’une combinaison de facteurs : une architecture bien adaptée, une utilisation efficace de la longueur du contexte, une compatibilité avec les outils existants, une concentration sur des données de formation de haute qualité et des techniques d’optimisation. Cette approche unique ouvre la voie à des modèles d’IA puissants et efficaces pouvant fonctionner de manière transparente sur les appareils personnels.

Crédit image en vedette: vecteur/Freepik