Stable Diffusion 3 Medium, la dernière offre de Stability AI, a récemment fait ses débuts, suscitant à la fois enthousiasme et controverse au sein de la communauté SD3.

En tant que modèle texte-image, Stable Diffusion 3 Medium vise à transformer des invites textuelles en images visuellement convaincantes, mais son accueil a suscité des réactions mitigées, notamment en ce qui concerne sa représentation de figures humaines.

Bien que Stability AI le décrit comme son « modèle de génération d’images le plus sophistiqué à ce jour » dans un article de blogles résultats que nous avons vus sont… Ne nous édulcorons pas : Carburants de cauchemar!

Lignée de Stable Diffusion 3 Medium

Stable Diffusion 3 Medium trouve ses racines dans une lignée de modèles de synthèse d’images d’IA développés par Stability AI. Cette itération s’appuie sur les bases posées par ses prédécesseurs, en intégrant les avancées technologiques et les méthodologies de formation. Le nom du modèle, « Medium », signifie sa position dans la série plus large Stable Diffusion 3, suggérant un équilibre entre l’efficacité informatique et les capacités génératives.

À la base, Stable Diffusion 3 Medium utilise une architecture de réseau neuronal sophistiquée interpréter et traduire des invites textuelles en représentations visuelles. Les données d’entraînement du modèle, qui comprennent une vaste collection d’images et leurs descriptions textuelles correspondantes, jouent un rôle central dans la formation de sa capacité à générer des images cohérentes et contextuellement pertinentes.

Où SD3 échoue-t-il ?

Stable Diffusion 3 Medium présente des atouts notables dans divers domaines. Sa capacité à saisir et à répondre à des sollicitations complexes impliquant des relations spatiales, des éléments de composition et des styles divers est louable. La capacité du modèle à générer des images avec des détails complexes et des couleurs vives est également évidente.

Cependantil a suscité des critiques pour ses difficultés occasionnelles à représenter avec précision l’anatomie humaine, en particulier les mains et les visages, comme le raconte En chaleurMétalÊtreet bien d’autres publications sur les réseaux sociaux. Ces lacunes ont soulevé des questions sur les données d’entraînement du modèle et sur l’impact potentiel des mécanismes de filtrage utilisés lors de son développement.

Pourquoi le SD3 est-il si mauvais pour générer des filles allongées sur l’herbe ?

paru/HornyMetalBeing dansDiffusion stable

Les données de formation utilisées pour former Stable Diffusion 3 Medium englobent un large éventail de contenus visuels, notamment :

- Photographies

- Oeuvres

- Illustrations

Cependant, les développeurs du modèle ont mis en place des processus de filtrage pour exclure le matériel explicite ou sensible de cet ensemble de données. Si ces filtres visent à garantir une utilisation responsable du modèle, ils ont involontairement conduit à la suppression d’images représentant certaines poses ou détails anatomiquescontribuant aux difficultés du modèle à restituer avec précision les figures humaines.

Testons Stable Diffusion 3 Medium

Vous pouvez facilement mettre le modèle à l’épreuve en utilisant des plateformes en ligne qui offrent des interfaces accessibles pour interagir avec lui.

Vous connaissez Internet, il contient tellement de personnes et tellement d’idées. Dans quelle mesure un modèle de génération d’images préparé selon les normes 2024 pourrait-il être mauvais ??

Nous avons essayé le démo en ligne gratuite de SD3 sur Hugging Face pour obtenir notre réponse.

Voici nos invites et nos résultats :

Il ne semble y avoir aucun problème avec l’anatomie du chien, à part l’absence d’un œil, mais les mains et les jambes de la femme semblent vraiment avoir eu un terrible accident…

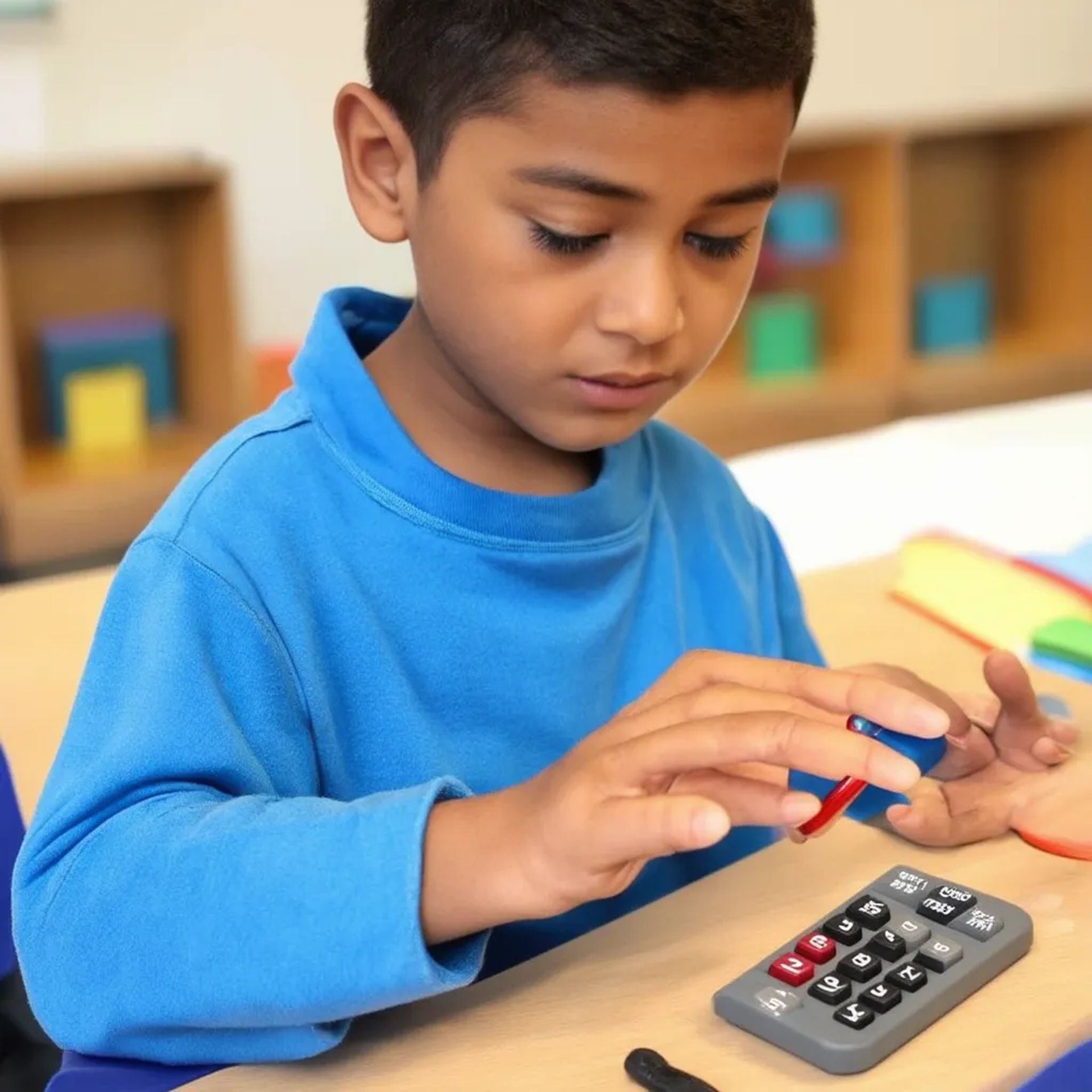

On dirait que les mathématiques ont non seulement dérouté le jeune garçon, mais ont également rendu ses doigts très longs et fait fondre une de ses mains sur la table !

Saviez-vous que si vous avez trois bras et 12 doigts (peut-être plus car on ne voit pas la main du troisième bras), vous pouvez administrer deux thérapies intraveineuses en même temps ? Au moins cette fois, il n’y a aucun problème avec le chien autre que le fait d’être malade…

Peu importe, il semble même que ce ne soit pas le cas ComfyUI Diffusion stable 3 peut le sauver…

Comment essayer SD3 en ligne

Si Stable Diffusion 3 Medium a rencontré son lot de critiques, et d’après notre expérience, ce ne sont pas de très mauvaises plaintes. Si vous souhaitez essayer SD3 par vous-même, voici ce que vous devez faire :

- Accédez à la démo : Visiter le Démo Stable Diffusion 3 Medium sur Hugging Face Spaces

- Entrez votre invite : Tapez une description de l’image souhaitée dans la zone de texte fournie.

- Générer: Cliquez sur le bouton « Générer » et attendez que le modèle crée votre image.

- Réviser et affiner : Examinez l’image générée. Si ce n’est pas ce à quoi vous vous attendiez, ajustez votre invite et réessayez.

Bien que Stable Diffusion 3 Medium ait rencontré son lot de critiques, il est crucial de reconnaître son potentiel en tant qu’atout précieux. La capacité du modèle à comprendre des invites complexes et à générer des images visuellement attrayantes dans divers styles reste remarquable. À mesure que la technologie mûrit et se développe davantage, elle est sur le point de contribuer de manière significative à nos méthodes d’expression créative en constante expansion.

Cependant, pour l’instant, nous recommandons d’utiliser Midjourney, surtout après l’introduction de Personnalisation du modèle à mi-parcours.

Crédit image en vedette: IA de stabilité