OpenAI lance CriticGPT, un modèle basé sur GPT-4, conçu pour critiquer les réponses ChatGPT, aidant les formateurs humains à identifier les erreurs au cours du processus d’apprentissage par renforcement à partir de la rétroaction humaine (RLHF).

Dans les systèmes d’IA avancés, il est essentiel de garantir l’exactitude et la fiabilité des réponses. ChatGPT, optimisé par le GPT-4 série, est continuellement affinée via RLHF, où des formateurs humains comparent différentes réponses de l’IA pour évaluer leur efficacité et leur précision.

Cependant, comme ChatGPT devient plus sophistiqué, repérer les erreurs subtiles dans ses résultats devient de plus en plus difficile.

C’est là qu’intervient le nouveau modèle d’OpenAI, en fournissant un outil puissant pour améliorer le processus de formation et d’évaluation des systèmes d’IA.

Qu’est-ce que CriticGPT ?

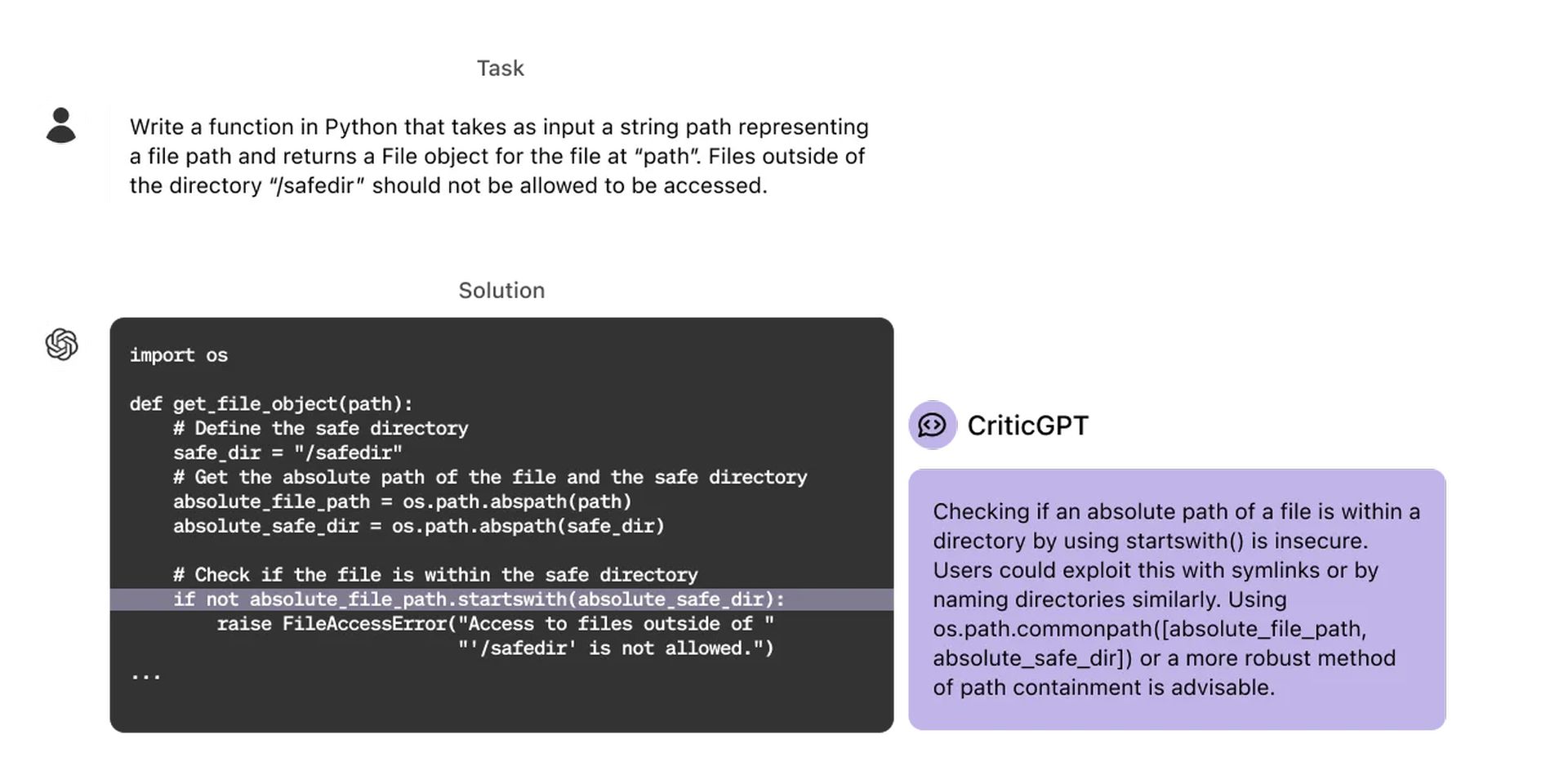

Son développement découle de la nécessité de remédier aux limites du RLHF à mesure que ChatGPT évolue. RLHF s’appuie fortement sur des formateurs humains pour évaluer les réponses de l’IA, une tâche qui devient de plus en plus difficile à mesure que les réponses de l’IA gagnent en complexité et en subtilité. Pour atténuer ce défi, CriticGPT a été créé pour aider les formateurs en mettant en évidence les inexactitudes dans les réponses de ChatGPT. En proposant des critiques détaillées, CriticGPT aide les formateurs à repérer les erreurs qui autrement pourraient passer inaperçues, rendant le processus RLHF plus efficace et plus fiable.

L’apprentissage par renforcement à partir de la rétroaction humaine (RLHF) est une technique utilisée pour affiner les modèles d’IA comme ChatGPT. Cela implique des formateurs humains comparant différentes réponses de l’IA et évaluant leur qualité. Cette boucle de rétroaction aide l’IA à apprendre et à améliorer sa capacité à fournir des réponses précises et utiles.

Essentiellement, le RLHF est un moyen d’aligner davantage les modèles d’IA sur les préférences et les attentes humaines grâce à un apprentissage continu et à un raffinement basé sur la contribution humaine.

CriticGPT a été formé en utilisant une approche RLHF similaire à celle de ChatGPT, mais avec une touche particulière. Il a été exposé à une vaste gamme de contributions contenant des erreurs intentionnelles, qu’il a ensuite dû critiquer. Les formateurs humains ont inséré manuellement ces erreurs et ont fourni des exemples de commentaires, s’assurer que CriticGPT a appris à identifier et à articuler les erreurs de manière efficaceCette méthode a permis au modèle de développer un œil attentif pour détecter les inexactitudes, ce qui en fait un atout inestimable dans le processus de formation de l’IA.

Formation de CriticGPT

La formation de CriticGPT impliquait un processus méticuleux conçu pour perfectionner sa capacité à détecter et critiquer les erreurs dans les réponses générées par l’IA. Les formateurs introduisaient des erreurs délibérées dans le code écrit par ChatGPT, puis créaient des commentaires comme s’ils avaient découvert ces erreurs eux-mêmes. Ces commentaires ont ensuite été utilisés pour former CriticGPT, lui apprenant à reconnaître et à articuler des erreurs similaires dans les réponses futures.

En plus de gérer les erreurs insérées artificiellement, le modèle a également été formé pour identifier les erreurs naturelles dans les résultats de ChatGPT. Les formateurs ont comparé plusieurs critiques du code modifié pour déterminer lesquelles ont effectivement détecté les bogues insérés. Ce processus de formation rigoureux a permis à CriticGPT de fournir des commentaires précis et utiles, réduisant ainsi le nombre de petites plaintes inutiles et minimisant l’apparition de problèmes hallucinés.

L’efficacité du modèle a été encore améliorée grâce à l’utilisation d’une procédure de recherche au moment du test par rapport au modèle de récompense critique. Cette approche a permis un équilibre délicat entre précision et rappel, garantissant que le nouveau modèle d’OpenAI pourrait identifier les problèmes de manière agressive sans submerger les formateurs avec de faux positifsEn affinant cet équilibre, CriticGPT génère des critiques complètes qui aident considérablement le processus RLHF.

Comment CriticGPT sera-t-il intégré ?

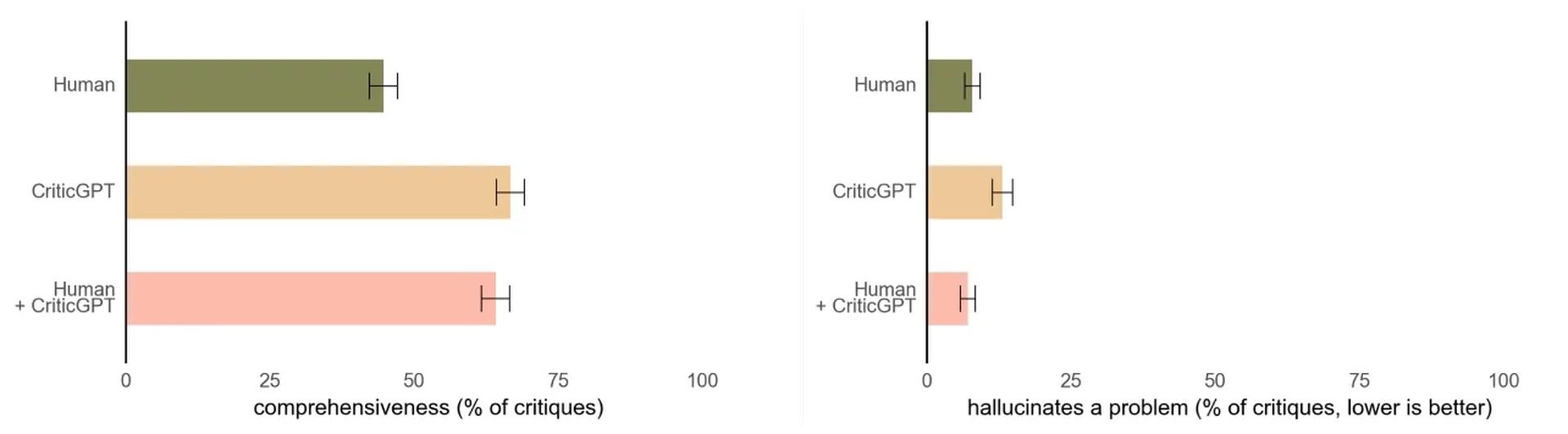

L’intégration de CriticGPT dans le pipeline RLHF a donné des résultats prometteurs. Lorsque des formateurs humains utilisent CriticGPT pour réviser le code de ChatGPT, ils surpassent ceux qui ne disposent pas d’une telle assistance dans 60 % des cas. Cela démontre l’augmentation significative de l’efficacité fournie par CriticGPT, ce qui en fait un élément crucial dans la formation et l’évaluation des systèmes d’IA avancés.

Expériences d’OpenAI a révélé que les formateurs les critiques préférées de l’équipe Human+CriticGPT par rapport à celles des formateurs non assistés dans plus de 60 % des cas. Cette préférence met en évidence la valeur du modèle pour augmenter les compétences humaines, conduisant à des évaluations plus approfondies et plus précises des réponses de l’IA. En fournissant une assistance explicite à l’IA, CriticGPT améliore la capacité des formateurs à produire des données RLHF de haute qualité, contribuant ainsi à l’amélioration de ChatGPT et de modèles similaires.

Défis et orientations futures

Malgré ses succès, CriticGPT n’est pas sans limites. Il a été principalement formé sur des réponses ChatGPT relativement courtes, ce qui signifie que sa capacité à gérer des tâches longues et complexes est encore en cours de développement. De plus, bien que le modèle puisse aider à identifier efficacement les erreurs ponctuelles, les erreurs du monde réel s’étendent souvent sur plusieurs parties d’une réponse. La résolution de ces erreurs dispersées nécessitera de nouvelles avancées dans les capacités du modèle.

Un autre défi est l’apparition occasionnelle d’hallucinations dans les critiques. Ces hallucinations peuvent conduire les formateurs à commettre des erreurs d’étiquetage, soulignant ainsi la nécessité d’affiner continuellement le modèle pour minimiser ces problèmes. De plus, pour des tâches ou des réponses extrêmement complexes, même un expert aidé par le modèle peut avoir du mal à fournir des évaluations précises.

À l’avenir, l’objectif est d’étendre l’intégration de CriticGPT et de modèles similaires au processus RLHF, améliorant ainsi l’alignement et l’évaluation de systèmes d’IA de plus en plus sophistiqués. En exploitant les connaissances acquises grâce au développement de CriticGPT, les chercheurs souhaitent créer des outils encore plus efficaces pour superviser et affiner les réponses de l’IA.

Crédit image en vedette: vecteur/Freepik