Université de Tsinghua et IA Zhipu ont présenté CogVideoX en collaboration, un modèle texte-vidéo open source prêt à défier les poids lourds de l’IA comme Piste, Luma IAet Laboratoires PikaDétaillée dans une récente publication arXiv, cette innovation offre des capacités avancées de génération vidéo aux développeurs du monde entier.

CogVideoX : nouvel outil d’IA open source de conversion de texte en vidéo

« Nous présentons CogVideoX, des modèles de transformateurs de diffusion à grande échelle conçus pour générer des vidéos basées sur des invites textuelles. Pour modéliser efficacement les données vidéo, nous proposons d’utiliser un autoencodeur variationnel 3D (VAE) pour compresser les vidéos selon les dimensions spatiales et temporelles. Pour améliorer l’alignement texte-vidéo, nous proposons un transformateur expert avec le LayerNorm adaptatif expert pour faciliter la fusion profonde entre les deux modalités. En utilisant une technique d’entraînement progressive, CogVideoX est capable de produire des vidéos cohérentes et de longue durée caractérisées par des mouvements significatifs », explique le le papier lit.

Récemment, ils ont collaboré sur OpenVoice, une plate-forme de clonage vocal open source développée en collaboration avec le MIT et MonShellet ils ont maintenant introduit CogVideoX-5B, un modèle de conversion de texte en vidéo. Ils se sont également associés à Shengshu Technology pour lancer Vidu IAun outil conçu pour simplifier la création de vidéos à l’aide de l’IA.

CogVideoX peut créer des vidéos cohérentes et de haute qualité d’une durée maximale de six secondes à partir de simples invites de texte.

Le modèle phare, CogVideoX-5B, dispose de 5 milliards de paramètres et produit des vidéos à une résolution de 720 × 480 et 8 images par seconde. Même si ces spécifications ne rivalisent pas avec les derniers systèmes propriétaires, la véritable avancée réside dans l’approche open source de CogVideoX.

Les modèles open source révolutionnent le domaine par rallégeant leur poids de code et de modèle Pour le public, l’équipe de Tsinghua a effectivement démocratisé une technologie qui était autrefois le domaine de géants technologiques bien financés. Cette initiative devrait accélérer les progrès dans le domaine de la vidéo générée par l’IA en exploitant l’expertise collective de la communauté mondiale des développeurs.

Les chercheurs ont obtenu les résultats impressionnants de CogVideoX grâce à plusieurs innovations clés, notamment un Autoencodeur variationnel 3D pour une compression vidéo efficace et un « transformateur expert » conçu pour améliorer l’alignement texte-vidéo.

« Pour améliorer l’alignement entre les vidéos et les textes, nous proposons un transformateur expert avec LayerNorm adaptatif expert pour faciliter la fusion entre les deux modalités », explique l’article. Cette avancée permet une interprétation plus précise des invites de texte et une génération de vidéos plus précise.

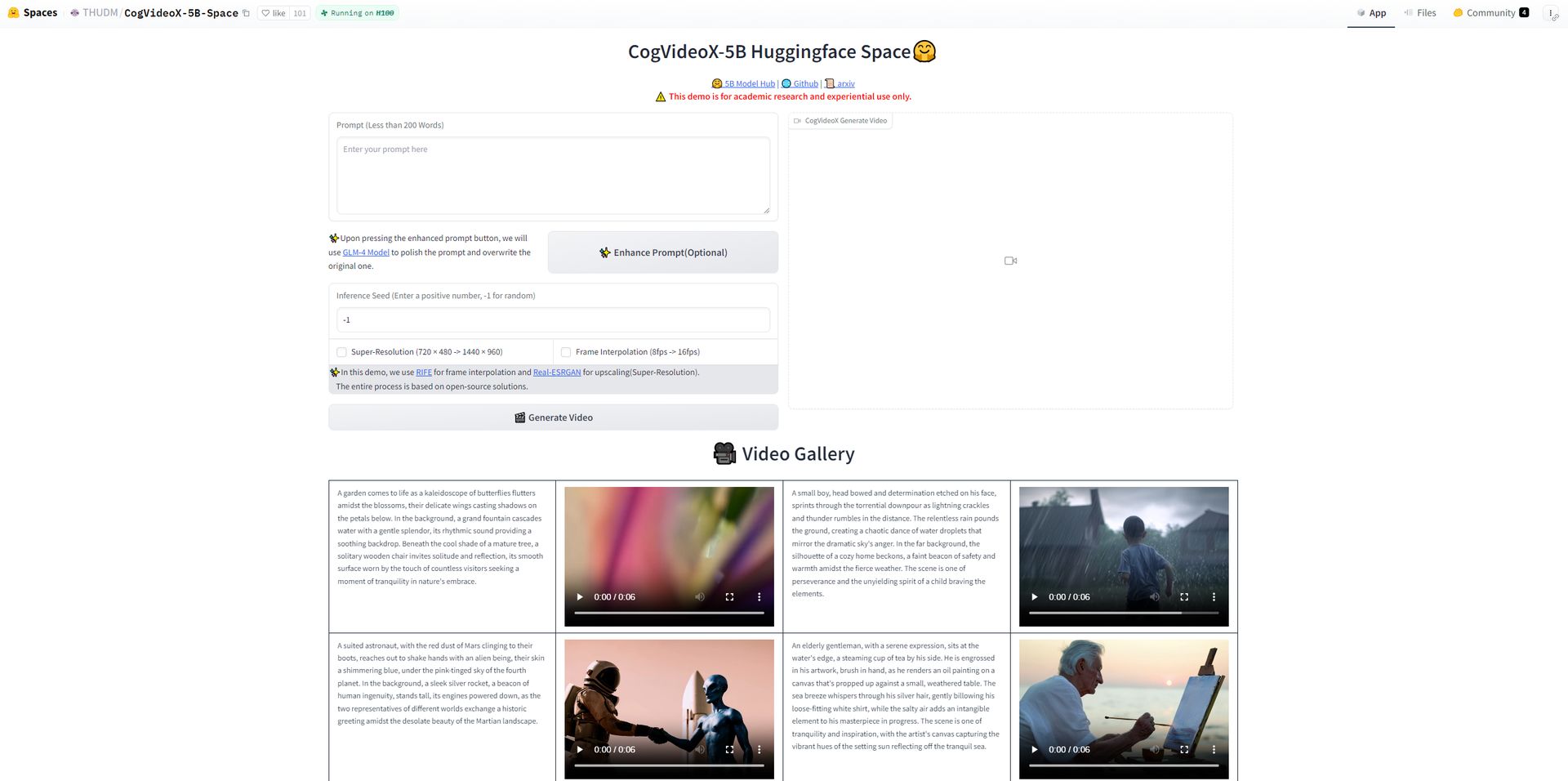

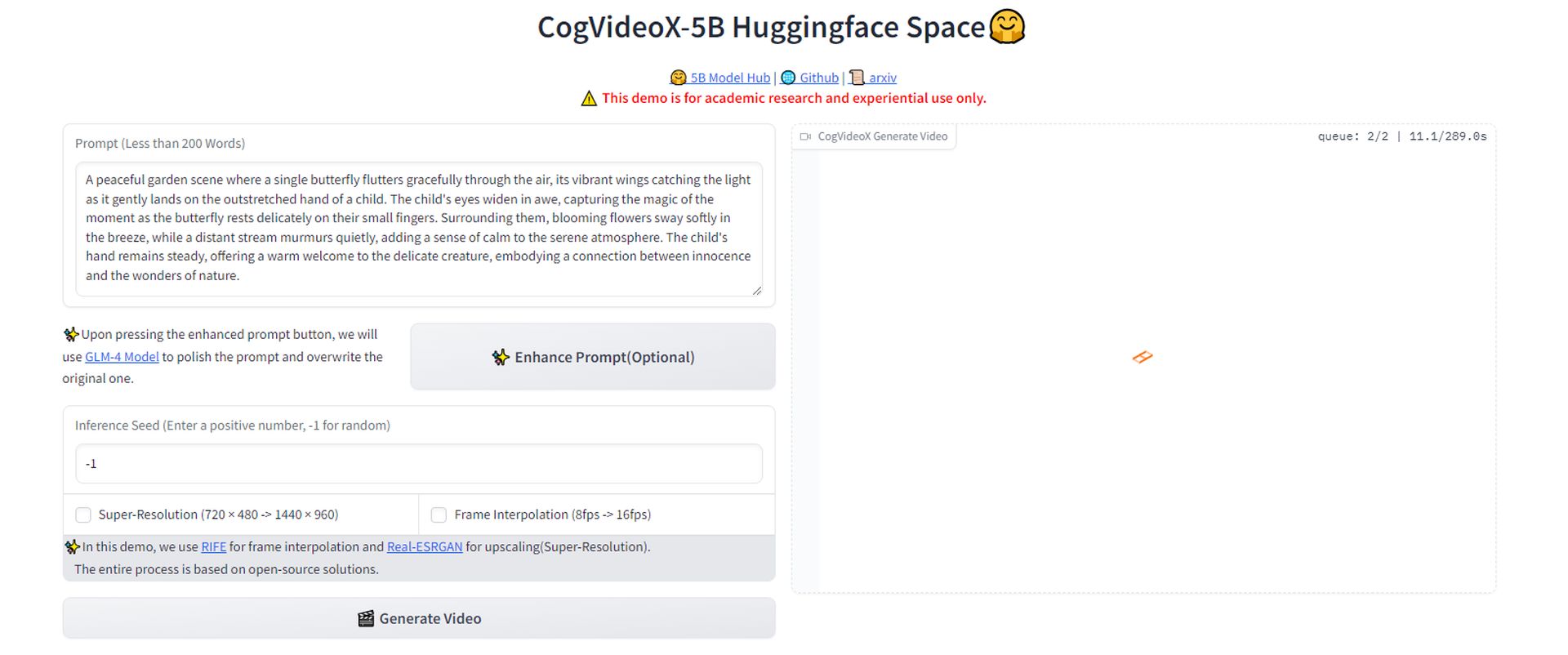

Comment essayer CogVideoX ?

- Commencez par vous rendre sur la plateforme HuggingFace où le Outil de génération de vidéo open source CogVideoX-5B est disponible pour les tests.

- Rédigez une invite descriptive pour la vidéo que vous souhaitez générer. Par exemple, nous avons utilisé :

- Une fois votre invite prête, cliquez sur le bouton pour générer la vidéoVous devrez patienter un instant pendant que l’outil traite votre demande et crée la vidéo en fonction de votre description.

- Une fois la vidéo générée, vous pouvez la télécharger directement depuis la plateforme. Cela vous permet de visualiser le résultat de votre invite et de voir avec quelle précision l’outil a interprété votre description.

- Regardez la vidéo. Même si le résultat n’est pas forcément époustouflant, il est important de noter que ces types d’outils s’améliorent rapidement. Tout comme nous l’avons vu avec l’évolution de ChatGPT, une avancée significative dans le domaine de la vidéo générée par l’IA est probablement à l’horizon.

J’ai essayé, même si ce n’est pas encore une innovation, ces outils apparaissent partout. Je m’attends à une avancée majeure prochainement, comme nous l’avons vu avec ChatGPT. pic.twitter.com/53xYz6lBLf

— Kerem Gülen (@kgulenn) 28 août 2024

Nous allons voir de plus en plus de deepfakes

Cependant, la large disponibilité d’une technologie aussi puissante n’est pas sans danger. Le risque d’utilisation abusive, notamment dans la création de deepfakes ou de contenus trompeurs, est un problème sérieux auquel la communauté de l’IA doit faire face. Les chercheurs eux-mêmes reconnaissent ces préoccupations éthiques et demandent instamment que la technologie soit utilisée de manière responsable.

Alors que la vidéo générée par l’IA devient de plus en plus accessible et avancée, nous nous aventurons en territoire inconnu dans la création de contenu numérique. Le lancement de CogVideoX pourrait représenter un moment clé, susceptible de redistribuer le pouvoir des grands acteurs du secteur vers un modèle de développement de l’IA plus ouvert et décentralisé.

Les effets réels de cette démocratisation restent encore incertains. Va-t-elle créer une nouvelle vague de créativité et d’innovation, ou va-t-elle aggraver les problèmes existants de désinformation et de manipulation numérique ?

Crédits de l’image en vedette : Kerem Gülen/Mi-parcours