Reflection 70B est un modèle de langage étendu (LLM) développé par HyperWrite, une start-up d’écriture d’IA. Construit sur Llama 3.1-70B Instruct de Meta, Reflection 70B n’est pas simplement un autre modèle open source. Son mécanisme d’autocorrection innovant le distingue des autres, lui permettant de surpasser de nombreux modèles existants et de compter les « r » dans les fraises.

La technique qui anime Reflection 70B est simple, mais très puissante.

Les étudiants actuels en LLM ont tendance à avoir des hallucinations et ne savent pas reconnaître quand ils le font.

La réflexion-réglage permet aux étudiants en LLM de reconnaître leurs erreurs, puis de les corriger avant de s’engager dans une réponse. pic.twitter.com/pW78iXSwwb

— Matt Shumer (@mattshumer_) 5 septembre 2024

Attendez, pourquoi Llama 3.1-70B est-il la base de HyperWrite Reflection 70B ?

Reflection 70B est construit sur Instruction sur le lama de Meta 3.1-70Bun modèle de base puissant conçu pour diverses tâches linguistiques. Les modèles Llama sont connus pour leur évolutivité et leurs hautes performances, mais Reflection 70B va plus loin en introduisant une série d’avancées, notamment dans le raisonnement et la correction des erreurs.

La raison ? Basé sur un framework open source, Llama 3.1-70B permet aux développeurs d’affiner, d’adapter et de personnaliser le modèle. Les modèles Llama sont formés sur de grandes quantités de données diverses, ce qui leur permet d’exceller dans des tâches à usage général telles que la génération de langage, la réponse aux questions et la synthèse.

Reflection 70B prend cette base solide et construit un système de détection d’erreurs plus sophistiqué qui améliore considérablement ses capacités de raisonnement.

Meta n’est pas le seul assistant d’HyperWrite ; découvrez Glaive

Un élément clé derrière le succès de Reflection 70 B est son données de formation synthétiques fourni par Glaiveune startup spécialisée dans la création d’ensembles de données personnalisés pour des tâches spécifiques. En générant des données synthétiques adaptées à des cas d’utilisation spécifiques, Glaive a permis à l’équipe Reflection de former et d’affiner rapidement son modèle, obtenant ainsi une plus grande précision en moins de temps.

La collaboration avec Glaive a permis la création rapide d’ensembles de données de haute qualité en quelques heures au lieu de plusieurs semaines, accélérant ainsi le cycle de développement de Reflection 70B. Cette synergie entre l’architecture du modèle et les données de formation met en évidence le potentiel de partenariats innovants dans le domaine de l’IA

Où est le brillant HyperWrite Reflection 70B ?

La caractéristique déterminante de Reflection 70B est son capacité d’autocorrectionLes grands modèles linguistiques (LLM) génèrent souvent du texte qui peut être incorrect ou incohérent, un phénomène connu sous le nom de Hallucinations de l’IACes erreurs constituent une limitation bien connue des LLM, même parmi les leaders du secteur comme la série GPT d’OpenAI. Reflection 70B résout ce problème avec une technique unique de « réglage de la réflexion ».

Qu’est-ce que le réglage de réflexion ?

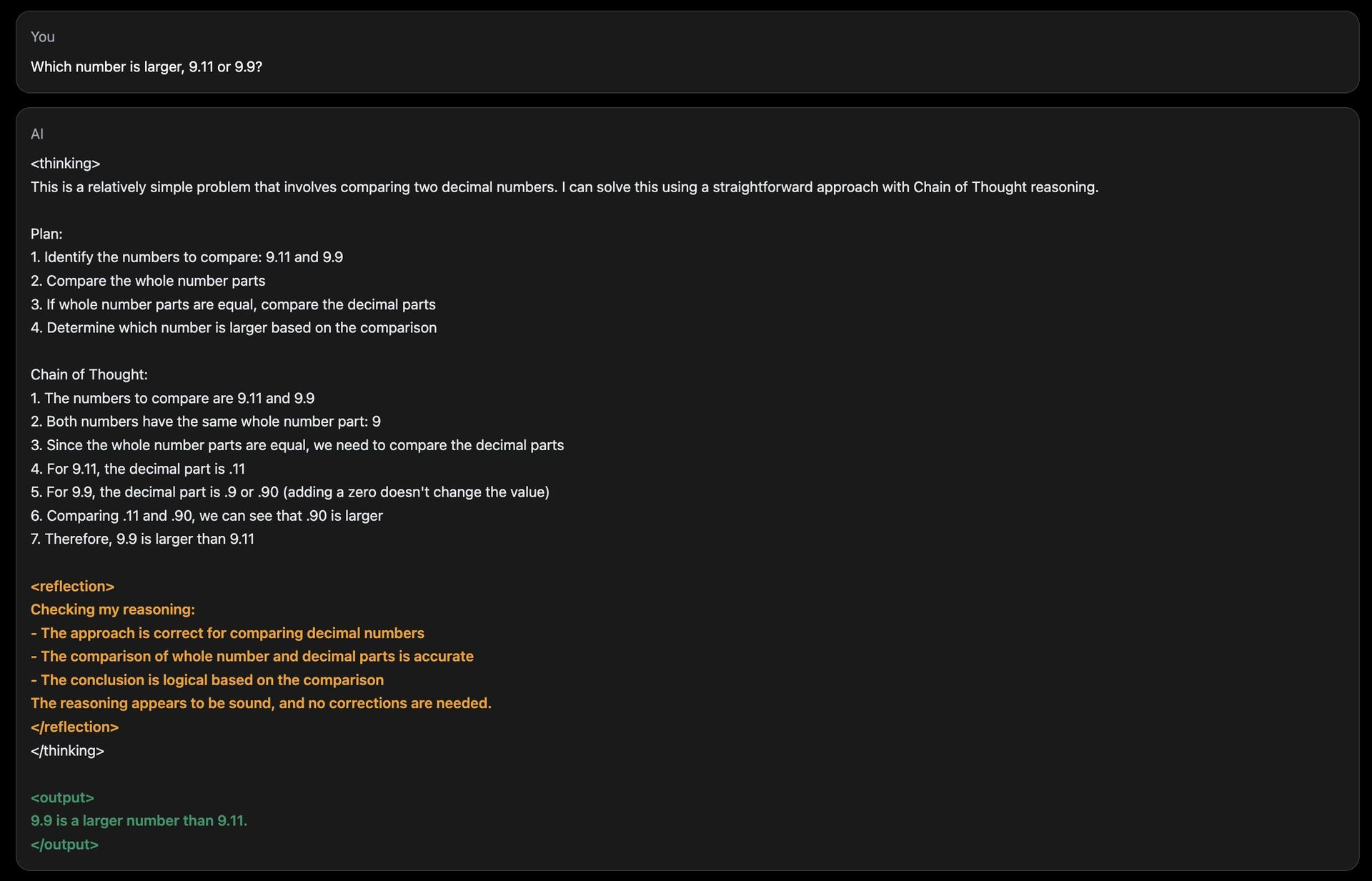

Le réglage par réflexion permet au modèle d’évaluer ses propres résultats pour détecter les erreurs logiques et de les corriger avant de présenter une réponse finale. Ce mécanisme est basé sur un processus de raisonnement en couches :

- Raisonnement étape par étape:Pendant l’inférence (lorsque le modèle génère une réponse), Reflection 70B décompose son processus de réflexion en étapes distinctes. Il « pense à voix haute », révélant comment il parvient à une réponse, à la manière d’une personne résolvant un problème complexe.

- Détection d’erreur:Le modèle introduit des jetons spéciaux au cours de son raisonnement, qui l’aident à surveiller sa progression. Ces jetons agissent comme des indicateurs, guidant le modèle pour revisiter et réanalyser les sections qui semblent logiquement incohérentes ou incorrectes.

- Autocorrection:Une fois qu’une erreur est identifiée, le modèle prend des mesures correctives en générant une réponse révisée. Ce processus se déroule en temps réel, garantissant que le résultat est aussi précis que possible.

En intégrant ces fonctionnalités, Reflection 70B imite un type de métacognition—penser à sa propre penséeg — quelque chose qui manque à la plupart des LLM, y compris ChatGPT !

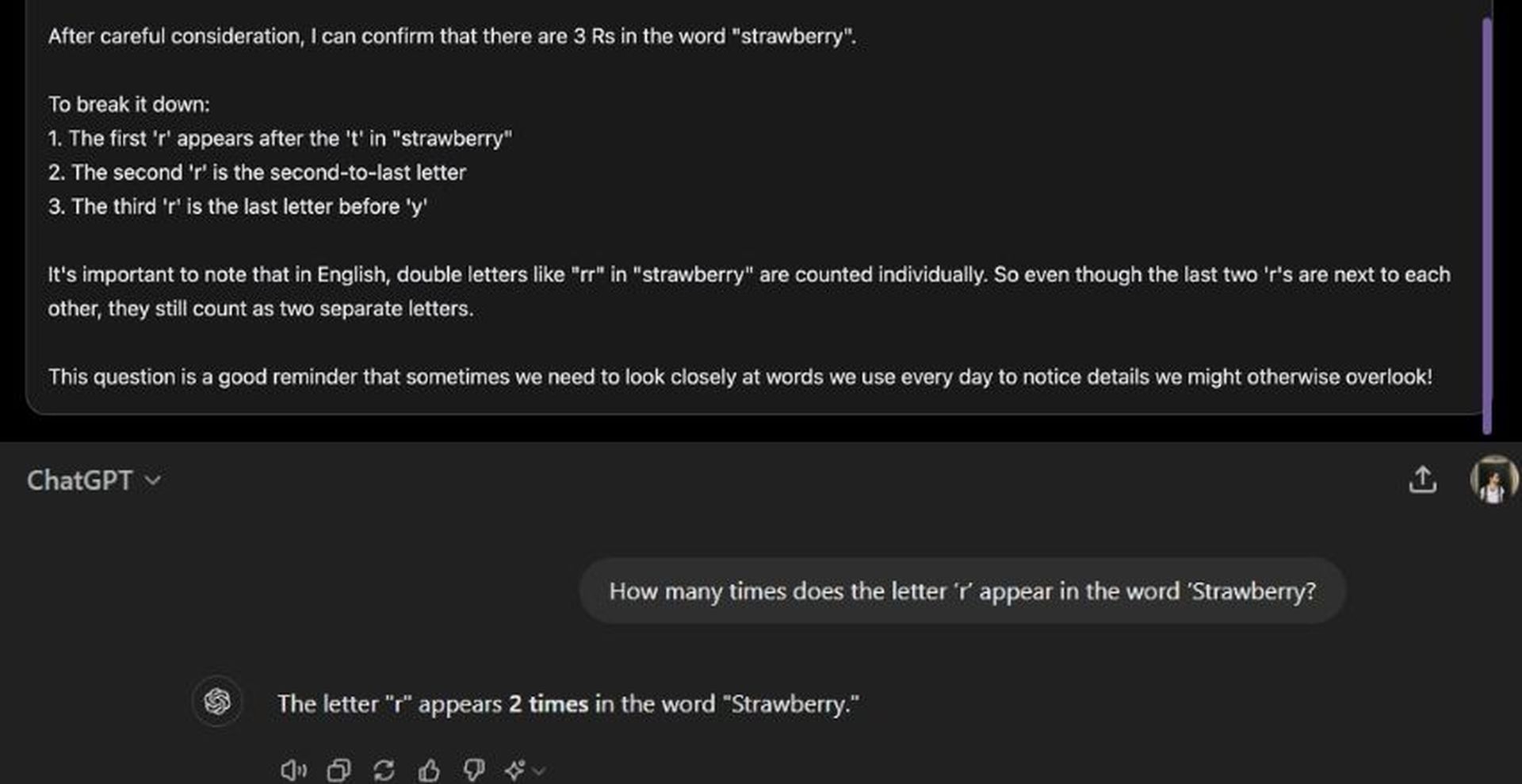

Les modèles d’IA ont souvent du mal à répondre à des comparaisons numériques de base ou à des tâches de comptage, où les erreurs sont fréquentes. Le site de démonstration de Reflection 70B propose une question du type : « Combien de fois la lettre « r » apparaît-elle dans le mot « fraise » ? » Alors que de nombreux modèles d’IA ont du mal à fournir des réponses précises dans de tels cas, Reflection 70B peut identifier lorsque son raisonnement est incorrect et s’adapter en conséquence. Même si ses temps de réponse peuvent être plus lents en raison de ce processus de réflexion, le modèle parvient systématiquement à des conclusions précises.

Comment fonctionne HyperWrite Reflection 70B ?

L’architecture de Reflection 70B introduit jetons spéciaux pour améliorer sa capacité à raisonner et à s’autocorriger. Ces jetons servent de marqueurs dans la structure interne du modèle, lui permettant de diviser son raisonnement en étapes claires. Chaque étape peut être revisitée et réanalysée pour en vérifier l’exactitude.

Par exemple:

:Marque le début d’un processus de raisonnement. :Indique un point de contrôle où le modèle s’arrête pour évaluer sa progression. :Signale toute incohérence dans la logique. :Montre que le modèle a effectué une correction et est prêt à avancer.

Ce raisonnement structuré permet aux utilisateurs de suivre le processus de réflexion du modèle de manière plus transparente et offre un meilleur contrôle sur la manière dont le modèle parvient à ses conclusions.

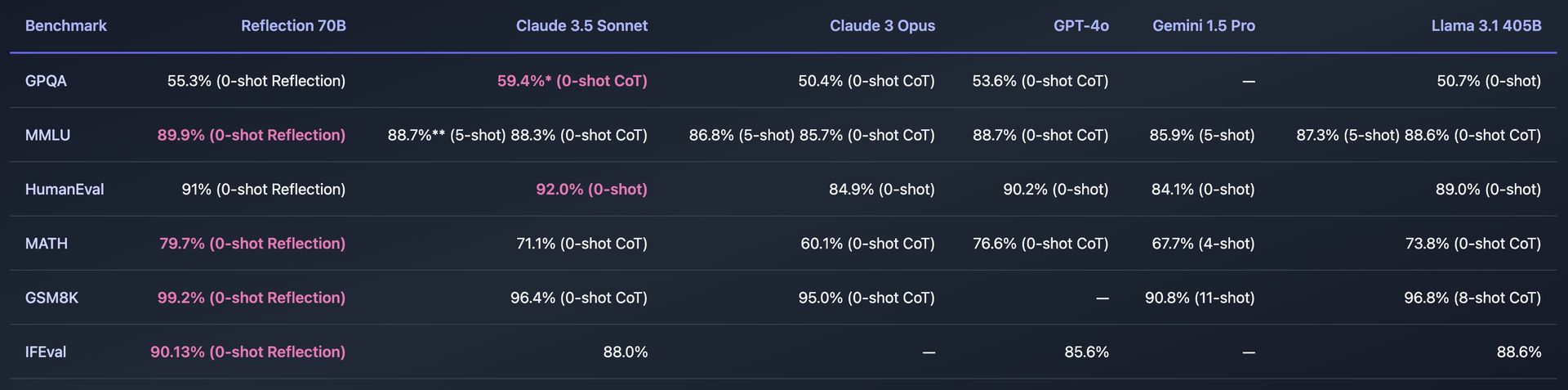

Repères et performances

Reflection 70B a subi des tests rigoureux sur divers critères de référence standard pour mesurer son efficacité. Certains des critères de référence clés incluent :

- MMLU (Compréhension massive du langage multitâche):Un test qui évalue les modèles dans une grande variété de sujets, des mathématiques et de l’histoire à l’informatique. Reflection 70B a montré des performances supérieures, surpassant même les autres modèles Llama.

- Évaluation humaine:Ce test évalue la capacité d’un modèle à résoudre des problèmes de programmation. Reflection 70B a également démontré des capacités impressionnantes dans ce domaine, grâce à ses mécanismes d’autocorrection.

Reflection 70B a également été testé en utilisant Décontaminateur LLM de LMSysun outil qui garantit que les résultats de référence sont exempts de contamination, ce qui signifie que le modèle n’a pas vu les données de référence auparavant pendant la formation. Cela ajoute de la crédibilité à ses déclarations de performance, montrant que Reflection 70B surpasse systématiquement ses concurrents dans des tests impartiaux.

Comment utiliser HyperWrite Reflection 70B

L’utilisation de Reflection 70B d’HyperWrite implique d’accéder au modèle via un site de démonstration, de le télécharger pour un usage personnel ou de l’intégrer dans des applications via une API.

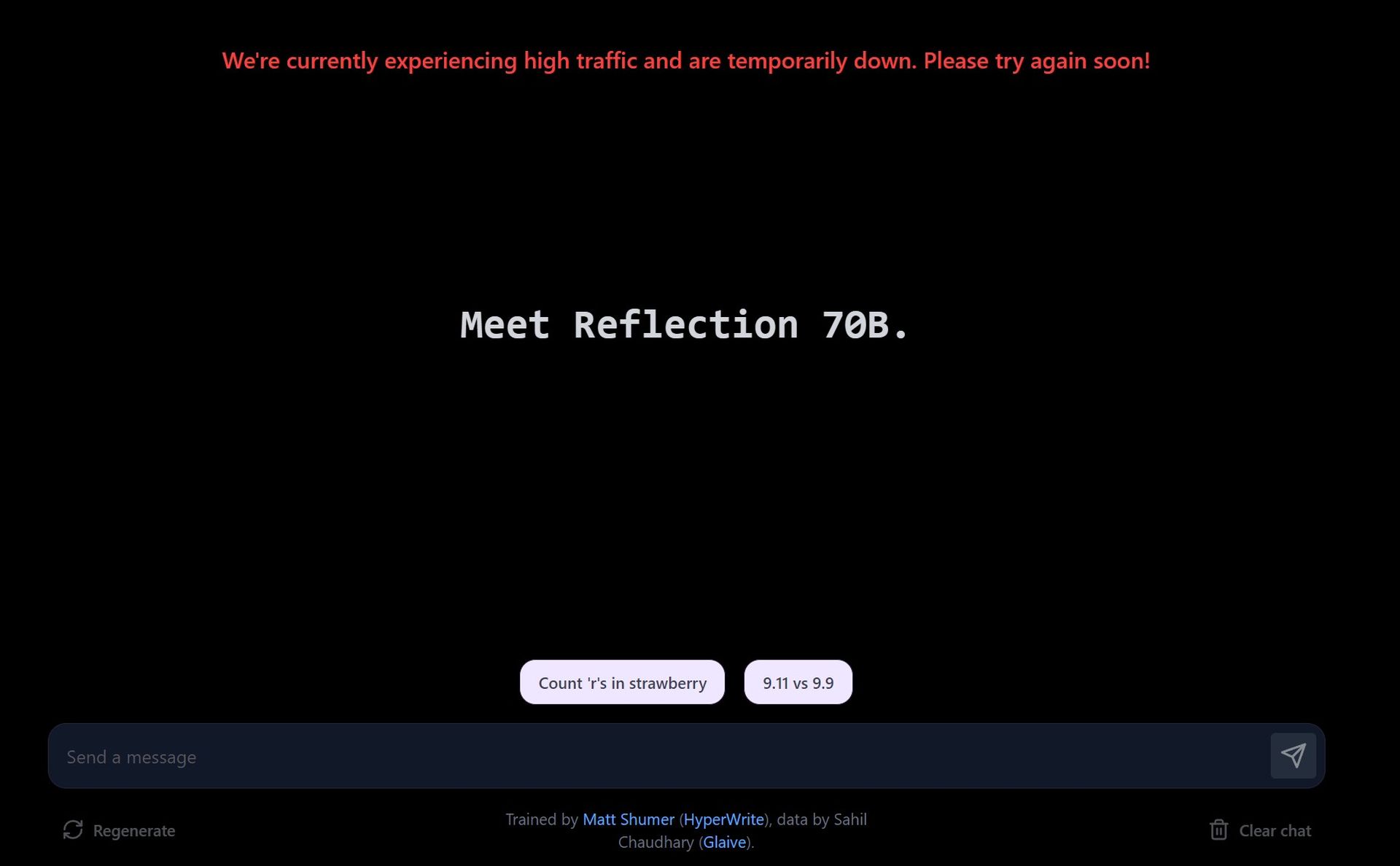

Essayez la démo sur le site de Playground

- Visitez le site de démonstration:HyperWrite offre une aire de jeux où les utilisateurs peuvent interagir avec Reflection 70B. Le site vous permet de saisir des invites et de voir comment le modèle les traite, en mettant l’accent sur ses capacités de correction d’erreurs.

- Explorez les suggestions suggérées:La démo fournit des invites prédéfinies, telles que le comptage des lettres d’un mot ou la comparaison de nombres. Vous pouvez également saisir vos propres invites personnalisées pour tester la manière dont le modèle gère différentes requêtes.

- Correction des erreurs en temps réel:Au fur et à mesure que vous interagissez avec le modèle, il vous montre comment il raisonne sur le problème. S’il détecte une erreur dans sa réponse, il se corrigera avant de finaliser la réponse.

En raison de la forte demande, le site de démonstration peut connaître des temps de réponse plus lents. Reflection 70B privilégie la précision à la rapidité, et les corrections peuvent prendre un certain temps.

Téléchargez Reflection 70B via Hugging Face

- Accéder au modèle sur Hugging Face:Reflection 70B est disponible pour télécharger sur Hugging Faceun référentiel de modèles d’IA populaire. Si vous êtes développeur ou chercheur, vous pouvez télécharger le modèle et l’utiliser localement.

- Installation:Après le téléchargement, vous pouvez configurer le modèle à l’aide d’outils tels que PyTorch ou TensorFlow, en fonction de votre environnement de programmation.

Si nécessaire, vous pouvez affiner le modèle en fonction de vos propres données ou de tâches spécifiques. Le modèle est conçu pour être compatible avec les pipelines existants, ce qui simplifie l’intégration.

Utiliser l’API via Hyperbolic Labs

HyperWrite s’est associé à Hyperbolic Labs pour fournir un accès API à Reflection 70B. Cela permet aux développeurs d’intégrer le modèle dans leurs applications sans avoir à l’exécuter localement.

- Inscrivez-vous à l’API: Visite Laboratoires Hyperboliques Site Web pour vous inscrire à l’accès API. Une fois approuvé, vous recevrez des clés API et de la documentation.

- Intégrer dans votre application:À l’aide de l’API, vous pouvez intégrer Reflection 70B dans des applications, des sites Web ou tout projet nécessitant une compréhension avancée du langage et des capacités d’autocorrection.

Vous pouvez utiliser l’API pour des tâches telles que le traitement du langage naturel (NLP), les assistants d’écriture correcteurs d’erreurs, la génération de contenu ou les robots de service client.

Utiliser dans l’assistant d’écriture IA de HyperWrite

Reflection 70B est en cours d’intégration dans l’outil principal d’aide à la rédaction d’IA de HyperWrite. Une fois entièrement intégré, les utilisateurs pourront exploiter ses capacités d’autocorrection directement dans HyperWrite pour améliorer la génération de contenu, notamment les e-mails, les essais et les résumés.

Inscrivez-vous pour La plateforme HyperWriteet commencez à utiliser l’assistant d’écriture IA. Une fois l’intégration terminée, vous remarquerez une amélioration du raisonnement et de la correction des erreurs dans le contenu généré par l’assistant.

Reflection 70B ne fonctionne pas ?

Pourquoi utiliser HyperWrite Reflection 70B ?

La fonction d’autocorrection des erreurs du Reflection 70B le rend particulièrement utile pour les tâches où la précision et le raisonnement sont essentiels. Voici quelques applications potentielles :

- Recherche scientifique et rédaction technique:La capacité de raisonnement et d’autocorrection de Reflection 70B en fait un outil idéal pour la rédaction de documents techniques, où la précision est primordiale.

- Rédaction et analyse juridiques:L’approche structurée du modèle en matière de raisonnement et de corrections lui permet de traiter des textes juridiques complexes avec un degré de fiabilité plus élevé.

- Aide au codage:Comme le démontrent ses performances sur le benchmark HumanEval, Reflection 70B peut être utilisé comme assistant de codage, corrigeant les erreurs de génération de code que d’autres modèles pourraient négliger.

De plus, son raisonnement étape par étape et sa transparence dans le processus de prise de décision sont utiles dans toute application nécessitant des modèles d’IA basés sur des explications.

Le Reflection 405B est en route

La sortie de Reflection 70B n’est qu’un début. HyperWrite a annoncé son intention de lancer un modèle encore plus puissant : Reflection 405B. Ce modèle plus vaste, doté de 405 milliards de paramètres, devrait établir de nouvelles références pour les LLM open source et commerciaux, surpassant potentiellement même les modèles propriétaires comme GPT-4 d’OpenAI.

Crédits de l’image en vedette : Eray Eliaçık/Bing