Selon les meilleures estimations, au nord de 7 000 langues sont parlées dans le monde entier aujourd’hui. 400 langues environ comptent plus d’un million de locuteurs. Étant donné que certaines langues, notamment l’anglais, semblent dominer le monde numérique, il existe un besoin énorme d’outils capables de fonctionner dans différentes langues et d’effectuer diverses tâches.

L’intelligence artificielle et le traitement du langage naturel, une branche de l’informatique, travaillent depuis des décennies à développer des outils capables de faire exactement cela. Au cours des dernières années, de nombreux outils basés sur des modèles multilingues pour le traitement du langage naturel (TALN) ont vu le jour. Ces modèles servent de pierre de Rosette à l’ère de l’information, permettant aux ordinateurs de passer sans problème d’une langue à l’autre. Ils ne se contentent pas de fournir des traductions, mais prennent en charge diverses applications, telles que l’analyse des sentiments et du contenu.

Le traitement automatique du langage naturel (TALN) multilingue a donc un rôle essentiel à jouer à l’avenir. Il peut être utilisé pour la traduction automatique ou pour analyser les publications sur les réseaux sociaux dans différentes langues afin de déterminer le sentiment, ce qui pourrait être utilisé pour éclairer les stratégies marketing ou le service client. Le TALN multilingue peut également étayer les recommandations de contenu sur les services de streaming ou rendre le service client disponible dans plusieurs langues. Il peut alimenter l’analyse du contenu des actualités ou permettre la traduction de dossiers médicaux à grande échelle. En bref, de nombreuses tâches qui auraient pu sembler impossibles à un moment donné – traduire les dossiers médicaux d’un hôpital français en anglais, par exemple – sont désormais possibles grâce au TALN multilingue.

Certains voient également dans l’essor du TALN multilingue une force de démocratisation des données, rendant accessibles à tous des contenus et des services autrefois disponibles dans quelques langues seulement. Et le TALN multilingue continue de se développer, intégrant même des données non textuelles.

De l’homme et de la machine : avancées récentes dans les architectures de modèles multilingues

Le traitement du langage naturel a des racines profondes. Le mathématicien et informaticien anglais Alan Turing a décrit le potentiel des ordinateurs à générer du langage naturel dans son essai fondateur de 1950 «Machines informatiques et intelligence.” Le traitement du langage naturel (NLP) s’est développé de manière constante au cours des décennies suivantes, et le NLP multilingue a commencé à se développer rapidement dans les années 2000. Cependant, certaines des avancées les plus significatives dans les architectures de modèles multilingues ont eu lieu au cours de la dernière décennie.

Certains noms de ces modèles sont familiers à presque tous ceux qui se sont consacrés à la traduction. ProfondLpar exemple, appartient à DeepL SE, basé à Cologne, en Allemagne, et s’appuie sur son propre algorithme associé à des réseaux neuronaux convolutifs pour offrir une traduction entre 33 langues et dialectesLancé pour la première fois en 2017, il s’agit d’un exemple bien connu de PNL multilingue.

Bien sûr, il y a aussi ChatGPTlancé par OpenAI, basé à San Francisco, et basé sur son modèle fondamental Generative Pre-trained Transformer 3.5, qui a ensuite été mis à niveau vers la version 4. GPT 3.5 et 4 font partie des plus grands modèles de langage existants, formés sur des ensembles de données massifs, ce qui leur permet d’étudier de grandes quantités de données textuelles, de capturer des modèles complexes dans le langage et de produire du texte de haute qualité.

Ce NLP multilingue a été adopté en masse pour la traduction linguistique, l’analyse des sentiments et de nombreuses autres fins. GPT 3.5 et GPT 4 ont été rendus accessibles via une API. En 2018, les chercheurs de Google ont introduit un modèle de langage appelé Bidirectionnel Encoder Representations from Transformers ou (BERT). Le modèle comprend une architecture d’encodeur de transformateur et est utilisé par l’entreprise pour mieux comprendre les recherches sur sa plateforme, ainsi que pour renvoyer des informations plus pertinentes dans les requêtes. Le modèle est formé via la prédiction de jetons masqués et la prédiction de la phrase suivante.

Divers modèles connexes ont innové sur le modèle BERT, tels que Robertaqui modifie les hyperparamètres, supprime l’objectif de pré-formation de la phrase suivante et permet la formation avec des mini-lots plus grands.

Pour ne pas être en reste, Facebook AI a publié un modèle appelé XLM-R en 2019dans lequel il a formé le RoBERTa susmentionné sur un ensemble de données multilingues composé d’une centaine de langues provenant d’ensembles de données CommonCrawl.

Les scientifiques qui ont décrit l’outil ont souligné sa capacité à fonctionner correctement dans des langues avec des ensembles de données plus petits, comme le swahili et l’ourdou, qui comptent tous deux des dizaines de millions de locuteurs. Ils ont également noté ses performances en matière de compréhension interlinguistique, où un modèle est formé sur une langue puis utilisé avec une autre sans nécessiter de données de formation supplémentaires.

Défis actuels et solutions proposées

Bien que le traitement du langage naturel multilingue se soit développé à un rythme effréné au cours des dernières années, il doit faire face à divers obstacles, dont l’un est tout simplement la diversité linguistique.

La création de tels modèles ne se limite pas à la fourniture de traductions fluides. Les langues peuvent varier d’une région à l’autre ou dépendre davantage du contexte, et l’argot peut également changer. Cela signifie que les modèles de PNL doivent être continuellement améliorés pour être pertinents.

De plus, certaines langues ne sont pas bien représentées en termes de commentaires numériques, et avec ces ensembles de données, il est plus facile de former un modèle. Les petites communautés qui utilisent des alphabets non latins, par exemple, sont particulièrement laissées pour compte.

Un troisième défi, plutôt intriguant, concerne le changement de code, où les membres de la communauté peuvent passer d’une langue à l’autre. Pensez à un poète anglais qui cite soudainement un texte en français ou à un écrivain japonais qui pimente sa prose avec des références en anglais. Si un modèle reconnaît la langue comme étant le japonais, comment gère-t-il ces segments en anglais dans le texte ?

Il existe également des problèmes d’accès aux ressources et de partialité. Étant donné les ressources informatiques nécessaires pour obtenir des TALN multilingues, seules les entreprises les plus puissantes du monde seront-elles en mesure de réunir les ressources nécessaires pour les créer ? Ou existe-t-il un moyen de les rendre plus accessibles aux chercheurs et aux organisations ? Et si les ensembles de données favorisent les langues ou les communautés les plus vastes, comment peut-on garantir que les locuteurs de langues plus petites soient bien représentés ?

Enfin, il y a aussi le problème omniprésent des données de mauvaise qualité. Les chercheurs doivent faire face au fait que leurs données sources pour certaines langues peuvent ne pas être exactes, ce qui conduit à des résultats faussés.

Les solutions reposent toutes sur un investissement accru en temps de recherche et sur la coopération. Les chercheurs doivent s’efforcer d’obtenir de meilleures données sur les langues sous-représentées tout en améliorant leurs modèles. Certains ont déjà utilisé des approches d’apprentissage à coup zéro ou à coup peu fréquent pour gérer les situations où peu de données sont disponibles pour une langue.

Pour réduire les biais, ils travaillent également à la création d’ensembles de données de formation diversifiés et au développement de mesures pour garantir l’équité. Les développeurs sont également conscients que le contenu dans une langue peut être offensant ou inapproprié s’il est mal rendu dans une autre et s’attaquent à ce problème.

En termes d’accessibilité, des modèles à plus petite échelle ont vu le jour pour répondre au problème des ressources. Certains de ces modèles à plus petite échelle comprennent Orca 2 de Microsoft et Phi 2EleutherAI GPT-J et GPT-Néoet T5 Small, une version allégée du Text-to-Text Transfer Transformer (T5) de Google.

L’avenir du TALN multilingue

Alors que les développeurs cherchent des solutions aux défis auxquels sont confrontés les modèles de la génération actuelle, des innovations sont en cours qui changent complètement ce que ces modèles peuvent faire.

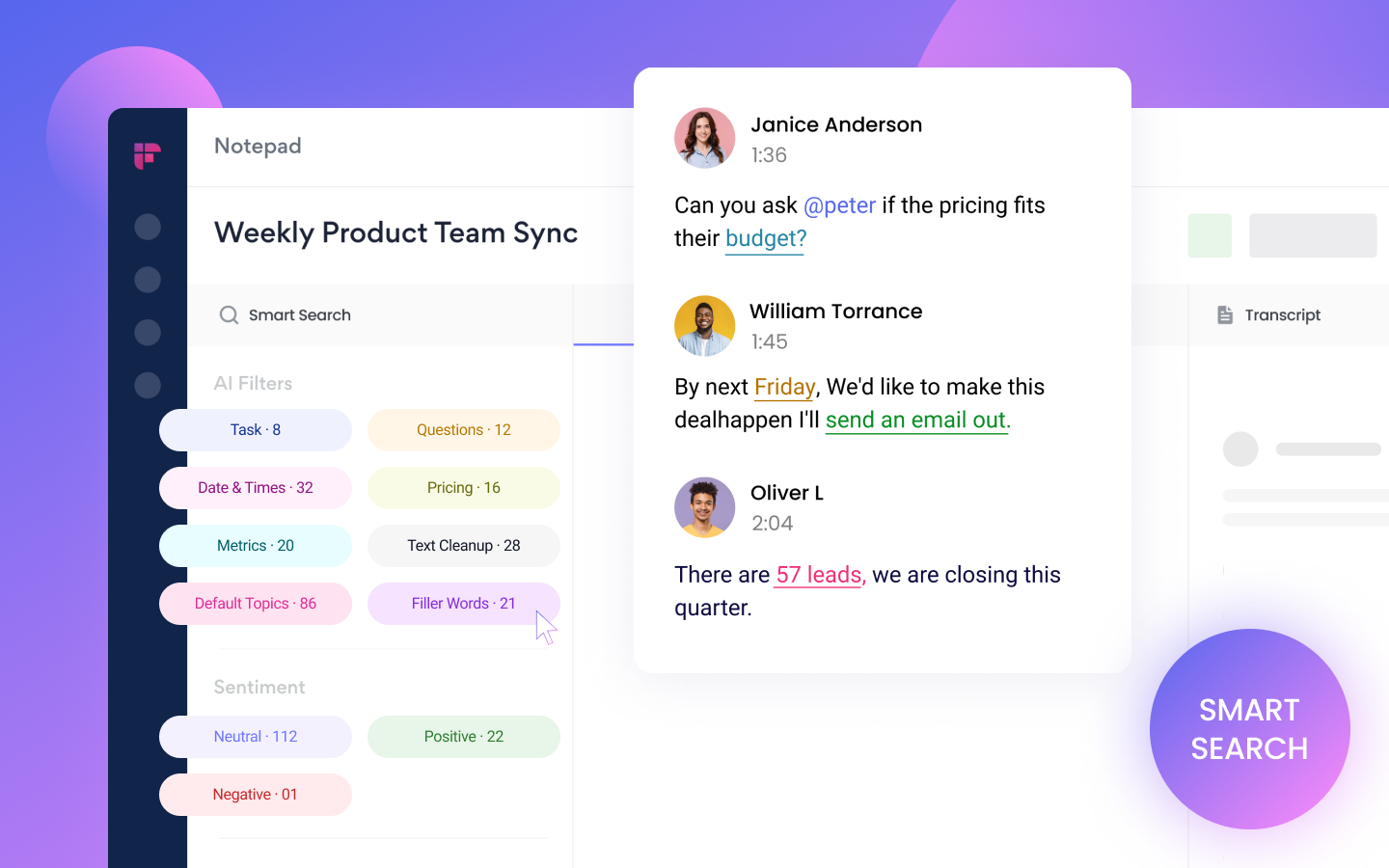

Le traitement automatique du langage naturel multilingue multimodal permet de faire exactement cela en traitant d’autres types de données, telles que des images ou d’autres données audiovisuelles, en plus du texte. Il pourrait potentiellement analyser le contenu pour les expressions faciales ou le ton, par exemple, ce qui pourrait être utilisé pour améliorer la traduction automatique ou l’analyse des sentiments, en ajoutant de nouvelles dimensions de données au pipeline de traitement.

Des innovations sont également en cours pour améliorer les assistants vocaux et les chatbots multilingues existants. L’assistant vocal Siri d’Apple peut actuellement répondre aux requêtes en environ 25 langues et dialectestandis qu’Alexa d’Amazon est disponible en neufEn utilisant le PNL multilingue, ces assistants vocaux pourraient être rendus accessibles à des millions de personnes supplémentaires dans le monde.

De même, les chatbots et les agents virtuels peuvent également être améliorés, non seulement en termes de contenu, mais aussi en rendant leurs réponses plus contextuelles et spécifiques à la requête de la personne, ce qui, à son tour, améliorera l’expérience de l’utilisateur.

À mesure que la technologie évolue, le traitement du langage naturel multilingue s’étendra au-delà de la traduction, de l’analyse des sentiments et d’autres utilisations actuelles pour atteindre des applications à plus grande échelle. Par exemple, les outils d’enseignement en ligne pourraient être plus facilement disponibles dans plusieurs langues.

Les entreprises peuvent améliorer leurs recherches, atteindre davantage de clients et mieux servir les marchés locaux qu’elles ne le font actuellement, tout cela grâce à l’aide du traitement du langage naturel multilingue. En bref, le traitement du langage naturel multilingue n’en est qu’à ses débuts. Compte tenu de la rapidité des développements, le futur ne tardera pas à arriver.

Crédit de l’image en vedette: Freepik