Google a franchi une nouvelle étape significative dans la course à l’amélioration de la précision et de la fiabilité des modèles d’IA avec le introduction de DataGemma, une approche innovante qui combine ses grands modèles de langage (LLM) Gemma et le projet Data Commons. L’accent est mis ici sur une technique appelée Génération augmentée par récupération (RAG)une méthode qui gagne du terrain dans les entreprises, mais désormais, avec DataGemma, Google vise à l’intégrer au courant dominant de l’IA.

RAG cherche à résoudre l’un des plus grands défis auxquels sont confrontés les LLM : le problème des hallucinations. Dans le monde de l’IA générative, les hallucinations désignent les cas où le modèle génère des informations qui semblent plausibles mais qui sont factuellement incorrectes. Il s’agit d’un problème courant dans les systèmes d’IA, en particulier lorsqu’ils ne s’appuient pas sur des données factuelles fiables. L’objectif de Google avec DataGemma est de « tirer parti des connaissances de Data Commons pour améliorer la factualité et le raisonnement des LLM », en s’attaquant de front à ce problème.

Qu’est-ce que RAG ?

La génération augmentée par récupération change la donne car elle ne s’appuie pas uniquement sur des modèles d’IA pré-entraînés pour générer des réponses. Au lieu de cela, elle récupère les données pertinentes à partir d’une source externe avant de générer une réponse. Cette approche permet à l’IA de fournir des réponses plus précises et contextuellement pertinentes en extrayant des données du monde réel à partir de référentiels. Dans le cas de DataGemma, la source de ces données est Projet Data Commons de Googleune ressource accessible au public qui regroupe des données statistiques provenant d’institutions réputées comme les Nations Unies.

Cette initiative de Google visant à intégrer Data Commons à ses modèles d’IA génératifs représente la première implémentation à grande échelle de RAG basée sur le cloud. Alors que de nombreuses entreprises ont utilisé RAG pour fonder leurs modèles d’IA sur des données propriétaires, l’utilisation d’une ressource de données publique comme Data Commons permet de franchir une nouvelle étape. Cela témoigne de l’intention de Google d’utiliser des données vérifiables et de haute qualité pour rendre l’IA plus fiable et plus utile dans un large éventail d’applications.

L’approche à deux volets de Google

Selon Google, DataGemma adopte « deux approches distinctes » pour intégrer la récupération de données avec la sortie LLM. La première méthode est appelée génération entrelacée de récupération (RIG). Avec RIG, l’IA récupère des données statistiques spécifiques pour vérifier les faits posés dans la requête. Par exemple, si un utilisateur demande : « L’utilisation des énergies renouvelables a-t-elle augmenté dans le monde ? », le système peut extraire des statistiques à jour de Data Commons et les citer directement dans sa réponse. Cela améliore non seulement l’exactitude factuelle de la réponse, mais fournit également aux utilisateurs des sources concrètes d’information.

La deuxième méthode est plus proche de l’approche RAG traditionnelle. Dans ce cas, le modèle récupère des données pour générer des réponses plus complètes et détaillées, en citant les sources des données pour créer une image plus complète. « DataGemma récupère les informations contextuelles pertinentes de Data Commons avant que le modèle ne lance la génération de réponses », Google précise que cela permet à l’IA de disposer de tous les éléments nécessaires avant de commencer à générer une réponse, réduisant ainsi considérablement le risque d’hallucinations.

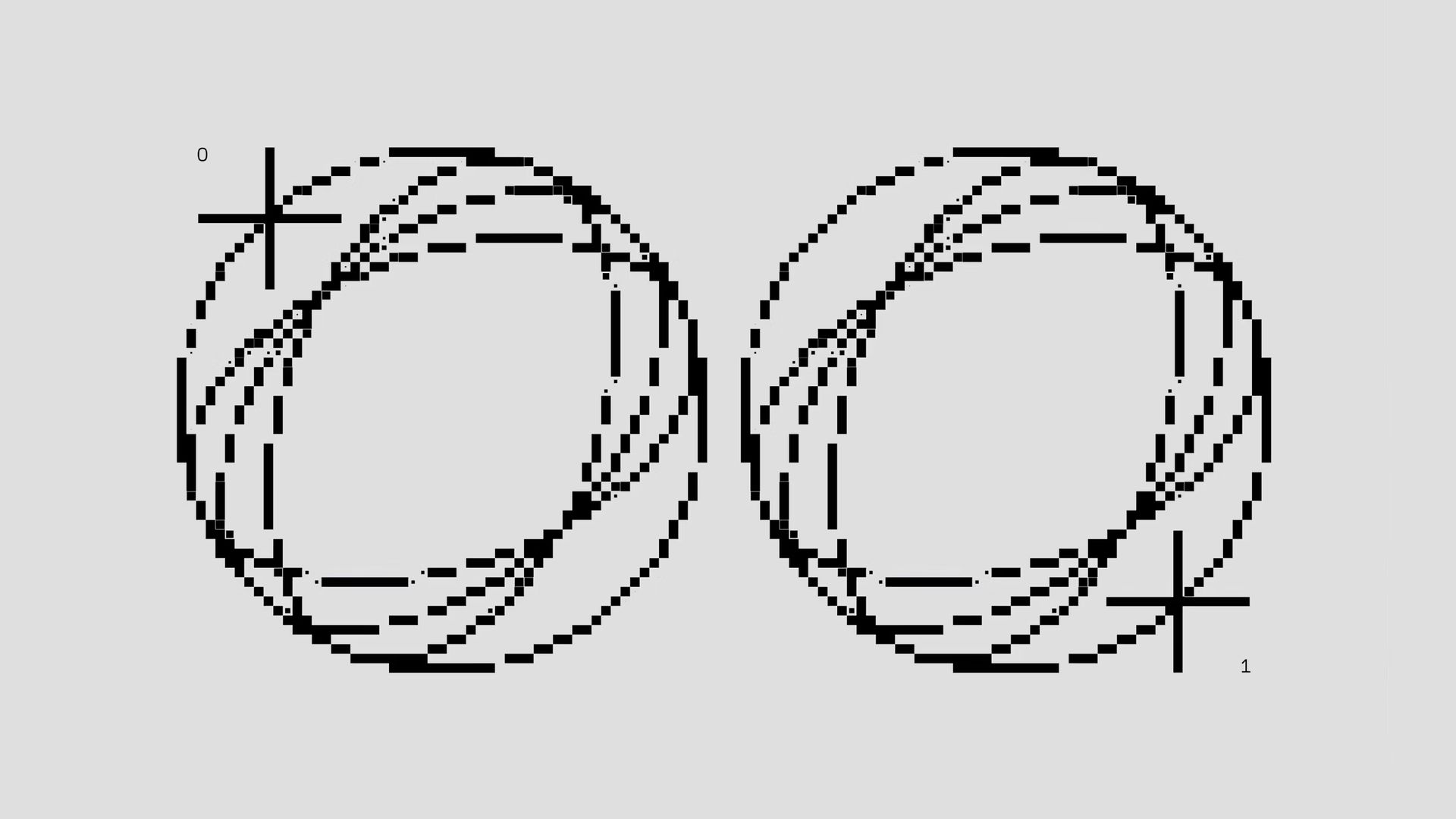

Une caractéristique clé de DataGemma est l’utilisation de Google Modèle Gemini 1.5qui se vante d’une impressionnante fenêtre de contexte jusqu’à 128 000 jetonsEn termes d’IA, la fenêtre de contexte fait référence à la quantité d’informations que le modèle peut conserver en mémoire pendant le traitement d’une requête. Plus la fenêtre est grande, plus le modèle peut prendre en compte de données lors de la génération d’une réponse. Gemini 1.5 peut même évoluer jusqu’à une taille stupéfiante 1 million de jetonslui permettant d’extraire d’énormes quantités de données de Data Commons et de les utiliser pour élaborer des réponses détaillées et nuancées.

Cette fenêtre de contexte étendue est essentielle car elle permet à DataGemma de « minimiser le risque d’hallucinations et améliorer la précision des réponses », Selon Google, en conservant des informations plus pertinentes en mémoire, le modèle peut recouper ses propres résultats avec des données du monde réel, garantissant ainsi que les réponses qu’il fournit sont non seulement pertinentes mais également fondées sur des faits.

Au-delà des LLM

Bien que l’intégration des techniques RAG soit passionnante en soi, DataGemma représente également un changement plus large dans le paysage de l’IAIl ne s’agit plus seulement de grands modèles linguistiques générant du texte ou répondant à des questions en fonction de ce sur quoi ils ont été formés. L’avenir de l’IA réside dans sa capacité à s’intégrer aux sources de données en temps réelen veillant à ce que ses résultats soient aussi précis et à jour que possible.

Google n’est pas le seul à se lancer dans cette aventure. La semaine dernière, OpenAI dévoilé c’est Projet « Fraise »qui adopte une approche différente pour améliorer le raisonnement de l’IA. Strawberry utilise une méthode connue sous le nom de « chaîne de pensée »où l’IA décrit les étapes ou les facteurs qu’elle utilise pour arriver à une prédiction ou à une conclusion. Bien que différent de RAG, l’objectif est similaire : rendre l’IA plus transparente, fiable et utile en fournissant des informations sur le raisonnement derrière ses réponses.

Quelle est la prochaine étape pour DataGemma ?

Pour l’instant, DataGemma reste un travail en cours. Google reconnaît que davantage de tests et de développement sont nécessaires avant que le système puisse être mis à la disposition du public. Cependant, les premiers résultats sont prometteurs. Google affirme que les approches RIG et RAG ont conduit à des améliorations de la qualité de sortie, avec « Moins d’hallucinations pour les cas d’utilisation dans la recherche, la prise de décision ou simplement pour satisfaire la curiosité. »

Il est clair que Google, comme d’autres grandes entreprises d’IA, va au-delà des capacités de base des grands modèles linguistiques. L’avenir de l’IA réside dans sa capacité à s’intégrer à des sources de données externes, qu’il s’agisse de bases de données publiques comme Data Commons ou de données d’entreprise propriétaires. Ce faisant, l’IA peut dépasser ses limites et devenir un outil plus puissant pour la prise de décision, la recherche et l’exploration.

Crédits de l’image en vedette : Google