OpenAI, la société à l’origine de ChatGPT, étend ses efforts pour garantir une puissance de calcul fiable et rentable pour ses modèles d’IA. En développant du silicium personnalisé, OpenAI vise à réduire la dépendance vis-à-vis de fournisseurs externes comme NVIDIA, dont les GPU dominent le marché des puces IA. Selon Reuters OpenAI s’est associé à Broadcom et a sécurisé la capacité de fabrication de Taiwan Semiconductor Manufacturing Company (TSMC), tout en intégrant des puces AMD dans sa configuration Microsoft Azure.

OpenAI va créer des puces IA personnalisées avec Broadcom et TSMC

Le parcours d’OpenAI vers le développement de ses propres puces d’IA a commencé par la constitution d’une équipe d’environ 20 personnes, dont des ingénieurs de haut niveau qui ont déjà travaillé sur les unités de traitement tensoriel (TPU) de Google. Cette équipe interne de puces, dirigée par des ingénieurs expérimentés comme Thomas Norrie et Richard Ho, travaille en étroite collaboration avec Broadcom pour concevoir et produire du silicium personnalisé qui se concentrera sur les charges de travail d’inférence. Les puces devraient être fabriquées par TSMC, la plus grande fonderie de semi-conducteurs au monde, à partir de 2026.

L’objectif du développement de silicium en interne est double : garantir un approvisionnement stable en puces hautes performances et gérer l’augmentation des coûts associés aux charges de travail d’IA. Bien que la demande de puces de formation soit actuellement plus élevée, les experts du secteur prévoient que le besoin en puces d’inférence dépassera celui des puces de formation à mesure que davantage d’applications d’IA atteindront la phase de déploiement. L’expertise de Broadcom pour aider à affiner la conception des puces pour la production de masse et fournir des composants qui optimisent le mouvement des données en fait un partenaire idéal pour ce projet ambitieux.

OpenAI avait auparavant envisagé de construire ses propres fonderies de puces, mais a finalement décidé d’abandonner ces projets en raison des coûts et du temps énormes nécessaires. Au lieu de cela, OpenAI se concentre sur la conception de puces personnalisées tout en s’appuyant sur TSMC pour la fabrication.

Intégration de puces AMD pour la diversification

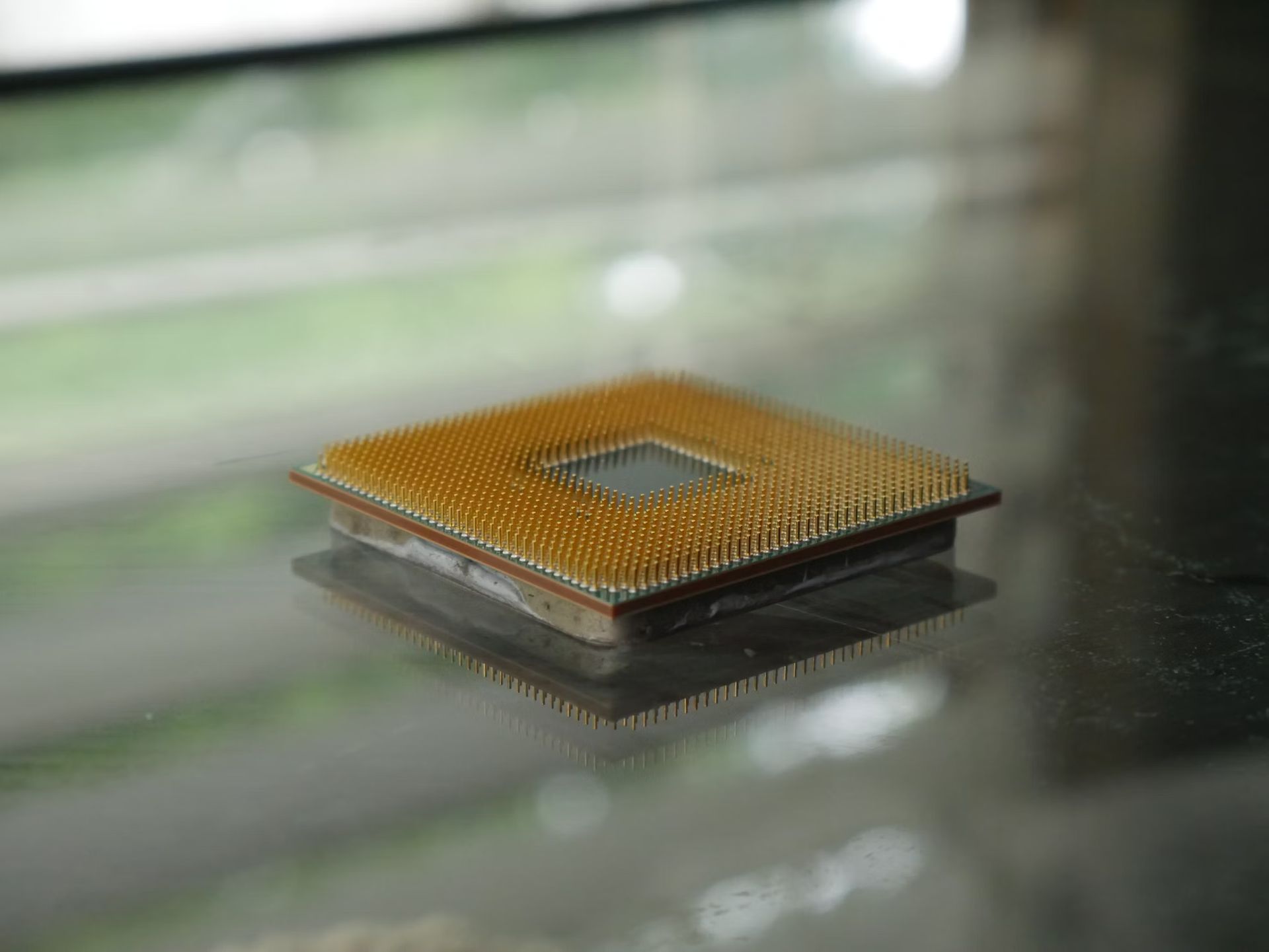

Parallèlement à son partenariat avec Broadcom, OpenAI intègre également le nouveau MI300X puces dans sa configuration Microsoft Azure. AMD a introduit ces puces l’année dernière dans le cadre de sa stratégie d’expansion des centres de données, visant à conquérir une partie de la part de marché actuellement détenue par NVIDIA. L’inclusion des puces AMD permettra à OpenAI de diversifier son approvisionnement en puces, réduisant ainsi sa dépendance à l’égard d’un seul fournisseur et contribuant à gérer les coûts plus efficacement.

Les puces MI300X d’AMD s’inscrivent dans sa volonté de concurrencer NVIDIA, qui détient actuellement plus de 80 % des parts de marché du matériel d’IA. Les puces MI300X sont conçues pour prendre en charge les charges de travail d’IA, notamment en matière d’inférence et de formation de modèles. En ajoutant des puces AMD à son infrastructure, OpenAI espère atténuer certaines des contraintes d’approvisionnement auxquelles elle est confrontée avec les GPU NVIDIA, qui sont très demandés et sujets à des pénuries.

Cette évolution stratégique est également une réponse à la hausse des coûts de calcul, qui sont devenus un enjeu majeur pour OpenAI. L’entreprise a dû faire face à des dépenses élevées en matériel informatique, en électricité et en services cloud, ce qui a entraîné des pertes prévues de 5 milliards de dollars cette année. Réduire sa dépendance à l’égard d’un fournisseur unique comme NVIDIA, qui a augmenté ses prix, pourrait aider OpenAI à mieux gérer ces coûts et à continuer de développer ses modèles d’IA sans retards ni interruptions importants.

La route à suivre

Malgré le projet ambitieux de développer des puces personnalisées, des défis importants attendent OpenAI. Construire une solution silicium en interne prend du temps et de l’argent, et les premières puces conçues sur mesure ne devraient pas être en production avant 2026. Ce calendrier place OpenAI derrière certains de ses plus grands concurrents comme Google, Microsoft et Amazon, qui ont déjà a réalisé des progrès substantiels dans le développement de son propre matériel d’IA personnalisé.

Le partenariat avec Broadcom et TSMC représente une avancée importante, mais il met également en évidence les difficultés rencontrées par les entreprises qui tentent de percer sur le marché des puces. La fabrication de puces IA hautes performances nécessite une expertise considérable, des installations de production avancées et des investissements considérables. TSMC, en tant que partenaire de fabrication, jouera un rôle clé dans la réussite de cette entreprise. Le calendrier de production des puces pourrait encore changer, en fonction de facteurs tels que la complexité de la conception et la capacité de fabrication.

Un autre défi réside dans l’acquisition de talents. OpenAI se méfie du braconnage des talents de NVIDIA, car il souhaite maintenir de bonnes relations avec le fabricant de puces, d’autant plus qu’il s’appuie toujours fortement sur NVIDIA pour ses modèles d’IA de génération actuelle. Les puces Blackwell de NVIDIA devraient être cruciales pour les prochains projets d’IA, et le maintien d’une relation positive est essentiel pour l’accès continu d’OpenAI à ces GPU de pointe.

Pourquoi OpenAI a besoin de silicium personnalisé

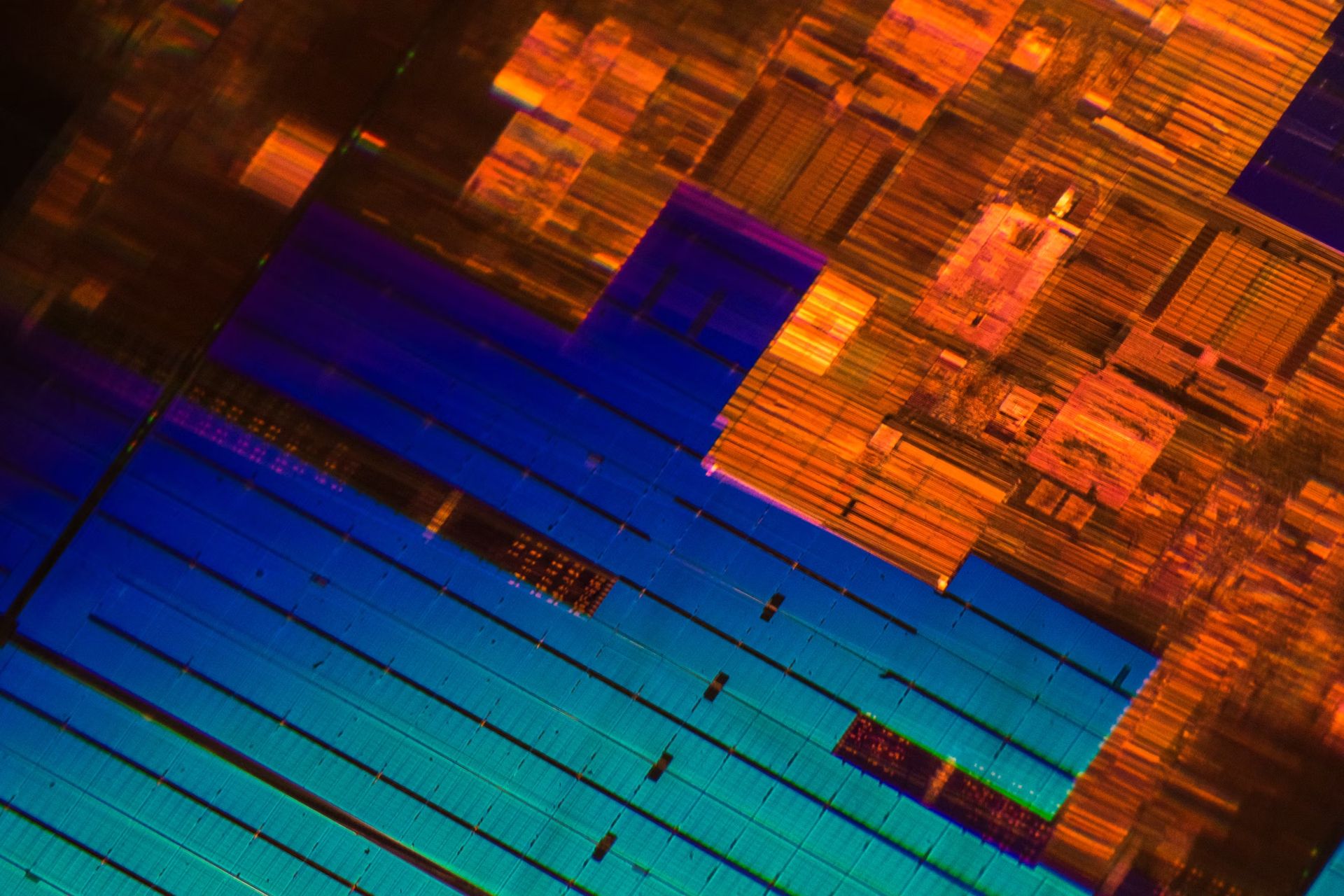

Le principal moteur de l’initiative de puce personnalisée d’OpenAI est le coût. La formation et le déploiement de grands modèles d’IA comme GPT-4 nécessitent une puissance de calcul massive, ce qui se traduit par des dépenses d’infrastructure élevées. Les coûts de calcul annuels d’OpenAI devraient constituer l’une de ses dépenses les plus importantes, la société s’attendant à une perte de 5 milliards de dollars cette année malgré un chiffre d’affaires de 3,7 milliards de dollars. En développant ses propres puces, OpenAI espère maîtriser ces coûts, lui donnant ainsi un avantage concurrentiel sur le marché encombré de l’IA.

Le silicium personnalisé offre également des avantages en termes de performances. En adaptant les puces spécifiquement aux besoins de l’inférence de l’IA, OpenAI peut optimiser les performances, améliorer l’efficacité et réduire la latence. Ceci est particulièrement important pour fournir des réponses de haute qualité en temps réel dans des produits comme ChatGPT. Bien que les GPU NVIDIA soient très performants, le matériel conçu sur mesure peut fournir une optimisation plus ciblée, conduisant potentiellement à des gains significatifs en termes de performances et de rentabilité.

L’approche consistant à mélanger des solutions de puces internes et externes offre à OpenAI une plus grande flexibilité dans la manière dont elle fait évoluer son infrastructure. En travaillant avec Broadcom sur des conceptions personnalisées tout en intégrant également des GPU AMD et NVIDIA, OpenAI se positionne pour mieux relever les défis liés à la forte demande et aux limitations de la chaîne d’approvisionnement. Cette approche diversifiée aidera l’entreprise à s’adapter aux conditions changeantes du marché et à garantir qu’elle dispose des ressources informatiques nécessaires pour continuer à repousser les limites de l’IA.

Crédit image en vedette : Andrew Neel/Unsplash