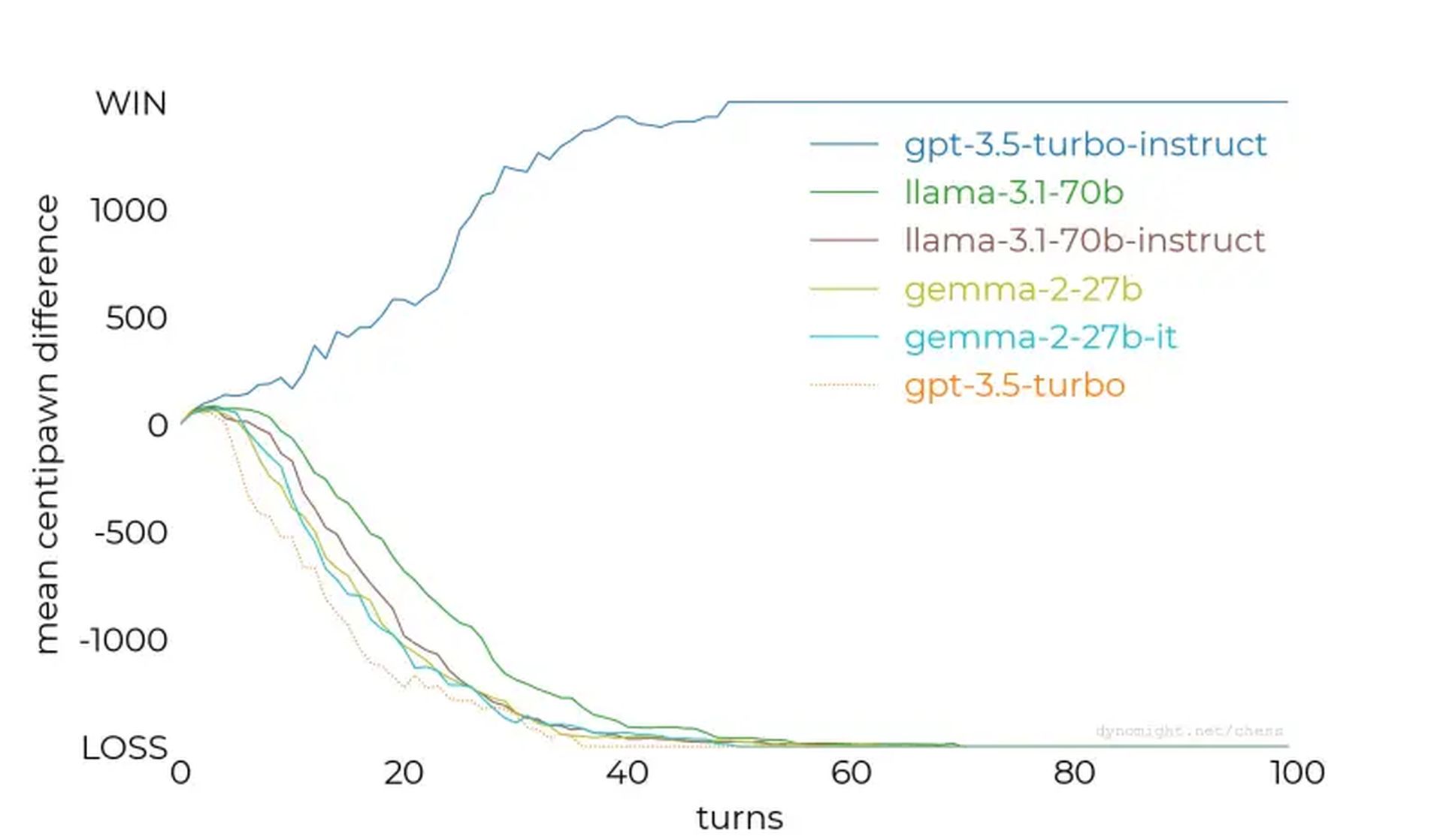

- Tous les LLM ne sont pas égaux : GPT-3.5-turbo-instruct se distingue comme le modèle de jeu d’échecs le plus performant testé.

- Un réglage fin est crucial : Le réglage des instructions et l’exposition ciblée des ensembles de données améliorent considérablement les performances dans des domaines spécifiques.

- Les échecs comme référence : L’expérience met en évidence les échecs comme une référence précieuse pour évaluer les capacités du LLM et affiner les systèmes d’IA.

Les modèles de langage d’IA peuvent-ils jouer aux échecs ? Cette question a déclenché une enquête récente sur la manière dont les grands modèles de langage (LLM) gèrent les tâches d’échecs, révélant des informations inattendues sur leurs forces, leurs faiblesses et leurs méthodologies de formation.

Alors que certains modèles ont échoué même face aux moteurs d’échecs les plus simples, d’autres, comme l’instruction turbo GPT-3.5 d’OpenAI, ont montré un potentiel surprenant, pointant vers des implications intrigantes pour le développement de l’IA.

Tester les LLM par rapport aux moteurs d’échecs

Les chercheurs ont testé divers LLM en leur demandant de jouer aux échecs en tant que grands maîtres, en fournissant des états de jeu en notation algébrique. L’enthousiasme initial était centré sur la question de savoir si les LLM, formés sur de vastes corpus de textes, pouvaient exploiter les connaissances intégrées sur les échecs pour prédire efficacement les mouvements.

Cependant, les résultats ont montré que tous les LLM ne sont pas créés égaux.

Le étude a commencé avec des modèles plus petits comme lama-3.2-3bqui a 3 milliards de paramètres. Après 50 parties contre le niveau de difficulté le plus bas de Stockfish, le modèle a perdu chaque match, ne parvenant pas à protéger ses pièces ou à maintenir une position favorable sur le plateau.

Les tests ont été étendus à des modèles plus grands, tels que lama-3.1-70b et sa variante adaptée aux instructions, mais ils ont également connu des difficultés, ne montrant que de légères améliorations. D’autres modèles, dont Qwen-2.5-72b et commande-r-v01a poursuivi la tendance, révélant une incapacité générale à comprendre même les stratégies d’échecs de base.

GPT-3.5-turbo-instruct a été le gagnant inattendu

Le tournant est venu avec GPT-3.5-turbo-instructqui a excellé contre Stockfish, même lorsque le niveau de difficulté du moteur a été augmenté. Contrairement à ses homologues orientés chat comme gpt-3.5-turbo et gpt-4ole modèle optimisé par les instructions produisait systématiquement des mouvements gagnants.

Pourquoi certains modèles excellent tandis que d’autres échouent ?

Les principales conclusions de la recherche ont fourni des informations précieuses :

- Le réglage des instructions est important : Des modèles tels que GPT-3.5-turbo-instruct ont bénéficié d’un réglage fin du feedback humain, ce qui a amélioré leur capacité à traiter des tâches structurées comme les échecs.

- Exposition aux ensembles de données : Il y a des spéculations selon lesquelles les modèles d’instructions pourraient avoir été exposés à un ensemble de données plus riche sur les jeux d’échecs, leur offrant ainsi un raisonnement stratégique supérieur.

- Défis de la tokenisation : De petites nuances, comme des espaces incorrects dans les invites, ont perturbé les performances, soulignant la sensibilité des LLM au formatage d’entrée.

- Les données concurrentes influencent : La formation des LLM sur divers ensembles de données peut diluer leur capacité à exceller dans des tâches spécialisées, telles que les échecs, à moins qu’elle ne soit contrebalancée par un réglage précis ciblé.

À mesure que l’IA continue de s’améliorer, ces enseignements éclaireront les stratégies visant à améliorer les performances des modèles dans toutes les disciplines. Qu’il s’agisse d’échecs, de compréhension du langage naturel ou d’autres tâches complexes, comprendre comment entraîner et régler l’IA est essentiel pour libérer tout son potentiel.

Crédit image en vedette: Piotr Makowski/Unsplash