Lors de la dernière conférence sur l’IA, nous avons eu l’occasion de nous asseoir avec Roman Shaposhnik et Tanya Dadasheva, les cofondateurs d’Ainekko/AIFoundry, et de discuter avec eux du sujet ambigu de la valeur des données pour les entreprises à l’ère de l’IA. L’une des questions clés à partir desquelles nous sommes partis était la suivante : la plupart des entreprises utilisent-elles les mêmes modèles d’IA d’avant-garde ? L’intégration de leurs données est-elle le seul moyen pour elles de se différencier ? Les données sont-elles vraiment un fossé pour les entreprises ?

Romain se souvient : «En 2009, lorsqu’il a débuté dans la communauté du Big Data, tout le monde parlait de la manière dont les entreprises allaient se transformer en exploitant les données. À cette époque, elles n’étaient même pas des entreprises numériques ; la transformation numérique n’avait pas encore eu lieu. Il s’agissait pour la plupart d’entreprises analogiques, mais elles mettaient déjà l’accent sur la valeur des données qu’elles collectaient : données sur leurs clients, leurs transactions, leurs chaînes d’approvisionnement, etc. Les gens comparaient les données au pétrole, quelque chose ayant une valeur inhérente qui devait être extraite pour réaliser son véritable potentiel..»

Or, le pétrole est une marchandise. Ainsi, si nous comparons les données au pétrole, cela suggère que tout le monde a accès aux mêmes données, bien qu’en quantités différentes et plus faciles à récolter pour certains. Cette comparaison donne l’impression que les données sont une marchandise, accessible à tous mais traitée de différentes manières.

Lorsque les données se trouvent dans un entrepôt de données d’entreprise sous leur forme brute, elles ressemblent à une goutte amorphe : un bien que tout le monde possède. Cependant, une fois que vous commencez à les affiner, c’est là que la valeur réelle entre en jeu. Il ne s’agit pas seulement d’acquérir des données, mais de construire un processus depuis l’extraction jusqu’au raffinement de toute la valeur à travers le pipeline.

« Fait intéressant, cela me rappelle quelque chose qu’un dirigeant d’une société pétrolière m’a dit un jour.» – partage Roman. « Ce dirigeant a décrit l’entreprise non pas comme une extraction de pétrole mais comme une reconfiguration de molécules de carbone. Le pétrole, pour eux, n’était qu’une simple source de carbone. Ils avaient construit des chaînes d’approvisionnement capables de reconfigurer ces molécules de carbone en produits adaptés aux demandes du marché dans différents endroits : plastiques, essence, quels que soient les besoins. Il envisageait des raffineries définies par logiciel qui pourraient adapter leurs résultats en fonction des besoins du marché en temps réel. Ce concept m’a époustouflé et je pense qu’il ressemble à ce que nous voyons actuellement dans les données : apporter le calcul aux données, les affiner pour obtenir ce dont vous avez besoin, là où vous en avez besoin.» – telle était la perspicacité de Roman.

Dans les entreprises, lorsque vous commencez à collecter des données, vous réalisez qu’elles sont fragmentées et réparties à de nombreux endroits, parfois bloquées dans les mainframes ou dispersées dans des systèmes comme Salesforce. Même si vous parvenez à le collecter, il y a tellement de silos et nous avons besoin d’une approche similaire à celle de la fracturation hydraulique pour extraire les parties précieuses. Tout comme la fracturation hydraulique extrait le pétrole d’endroits auparavant inaccessibles, nous avons besoin de méthodes pour obtenir des données d’entreprise qui autrement seraient verrouillées.

De nombreuses données d’entreprise résident encore dans des mainframes et il est difficile de les extraire. Voici un fait amusant : avec une forte probabilité, si vous réservez un vol aujourd’hui, le backend touche toujours un ordinateur central. Il ne s’agit pas seulement d’extraire ces données une seule fois ; vous avez besoin d’un accès continu. De nombreuses entreprises font leur métier en aidant les entreprises à extraire les données des anciens systèmes, et des outils comme Apache Airflow contribuent à rationaliser ces processus.

Mais même si les données ne sont plus bloquées dans les mainframes, elles restent fragmentées entre des systèmes tels que les services cloud SaaS ou les lacs de données. Cela signifie que les entreprises ne disposent pas de toutes leurs données au même endroit, et qu’elles ne sont certainement pas aussi accessibles ou opportunes qu’elles le souhaiteraient. Vous pensez peut-être que repartir de zéro vous donnerait un avantage, mais même les systèmes les plus récents dépendent de plusieurs partenaires, et ces partenaires contrôlent une partie des données dont vous avez besoin.

La notion même de données comme fossé s’avère alors trompeuse. Théoriquement, les entreprises sont propriétaires de leurs données, mais elles n’y ont souvent pas réellement accès. Par exemple, une entreprise utilisant Salesforce est propriétaire des données, mais le contrôle réel et l’accès à ces données sont limités par Salesforce. La distinction entre posséder et avoir des données est significative.

« Les choses deviennent encore plus compliquées lorsque l’IA commence à s’impliquer» – déclare Tanya Dadasheva, une autre co-fondatrice d’AInekko et d’AIFoundry.org. « Une entreprise peut posséder des données, mais cela ne signifie pas nécessairement qu’une entreprise comme Salesforce peut les utiliser pour former des modèles. Il y a aussi le débat sur la question de savoir si les données anonymisées peuvent être utilisées à des fins de formation : sur le plan juridique, c’est une zone grise. En général, plus les données sont anonymisées, moins elles ont de valeur. À un moment donné, obtenir une autorisation explicite devient la seule voie à suivre».

Cette question de propriété s’étend au-delà des entreprises ; cela affecte également les utilisateurs finaux. Les utilisateurs acceptent souvent de partager des données, mais ils peuvent ne pas accepter qu’elles soient utilisées pour des modèles de formation. Il y a eu des cas de rétro-ingénierie des données de modèles, conduisant à des violations potentielles de la vie privée.

À un stade précoce de l’équilibre entre les producteurs de données, les consommateurs de données et les entités qui affinent les données, sur le plan juridique et technologique, il est extrêmement complexe de déterminer comment ces relations fonctionneront. L’Europe, par exemple, a des règles de confidentialité beaucoup plus strictes que les États-Unis (https://artificialintelligenceact.eu/). Aux États-Unis, le système juridique découvre souvent les choses à la volée, alors que l’Europe préfère établir des lois à l’avance.

Tanya aborde ici la disponibilité des données : «Tout cela est lié à la valeur des données disponibles. Les modèles linguistiques massifs que nous avons construits sont devenus impressionnants grâce aux données publiques et semi-publiques. Cependant, une grande partie des contenus les plus récents sont désormais piégés dans des « jardins clos » comme WeChat, Telegram ou Discord, où ils sont inaccessibles pour la formation – un véritable dark web ! Cela signifie que les modèles peuvent devenir obsolètes, incapables de tirer des enseignements de nouvelles données ou de comprendre les nouvelles tendances.

En fin de compte, nous risquons de créer des modèles coincés dans le passé, sans aucun moyen d’absorber de nouvelles informations ou de s’adapter à de nouveaux styles de conversation. Ils contiendront toujours des données plus anciennes et le comportement et la culture de la nouvelle génération ne seront pas représentés. Ce sera comme parler à un grand-parent : intéressant, mais certainement d’une autre époque.»

Mais qui sont les utilisateurs internes des données dans une entreprise ? Roman rappelle les trois époques du concept d’utilisation des données au sein des entreprises : «Évidemment, elle est utilisée pour de nombreuses décisions, c’est pourquoi toute la partie business intelligence existe. Tout a commencé avec la business intelligence. Les entreprises ont dû faire des prévisions et signaler aux marchés boursiers ce qu’elles prévoient de se produire au cours du prochain trimestre ou de quelques trimestres à venir. Beaucoup de ces décisions sont fondées depuis longtemps sur des données. Il s’agit du premier niveau d’utilisation des données : très simple et orienté métier.

Le deuxième niveau a démarré avec la notion d’entreprises définies numériquement ou de transformation numérique. Les entreprises ont réalisé que la façon dont elles interagissent avec leurs clients est ce qui a de la valeur, et pas nécessairement le produit qu’elles vendent actuellement. La relation avec le client est la valeur en soi. Ils voulaient que cette relation dure le plus longtemps possible, allant parfois jusqu’à vous garder collé à l’écran le plus longtemps possible. Il s’agit de façonner le comportement du consommateur et de lui faire faire certaines choses. Cela ne peut être fait qu’en analysant de nombreuses choses différentes à votre sujet : votre statut social et économique, votre identité de genre et d’autres données qui leur permettent de maintenir cette relation aussi longtemps qu’ils le peuvent.

Nous arrivons maintenant au troisième niveau ou troisième étape dans la manière dont les entreprises peuvent bénéficier des produits de données. Tout le monde parle de ces systèmes agentiques parce que les entreprises veulent désormais être aidées non seulement par la main d’œuvre humaine. Même si cela semble futuriste, c’est souvent aussi simple que de déterminer quand une réunion est censée avoir lieu. Nous avons toujours été dans des situations où il faut cinq courriels différents et trois appels pour déterminer comment deux personnes peuvent se rencontrer pour un déjeuner. Ce serait beaucoup plus simple si un agent électronique pouvait négocier tout cela pour nous et nous aider. C’est un exemple simple, mais les entreprises en ont bien d’autres. Il s’agit désormais d’externaliser certains aspects de l’entreprise vers ces agents. Cela ne peut être fait que si vous pouvez former un agent IA sur de nombreux types de modèles que l’entreprise a adoptés dans le passé..»

Revenons à qui collecte, qui possède et, finalement, profite des données : le premier aperçu de ce que Roman a eu en travaillant chez Pivotal sur quelques projets impliquant des compagnies aériennes et des entreprises qui fabriquent des moteurs :

« Ce que je ne savais pas à l’époque, c’est qu’apparemment, on n’achète pas réellement le moteur ; vous louez le moteur. C’est le modèle économique. Et les entreprises produisant les moteurs disposaient de toutes ces données, de toute la télémétrie dont elles avaient besoin pour optimiser le moteur. Mais ensuite la compagnie aérienne m’a dit : « Attendez une minute. Ce sont exactement les mêmes données dont nous avons besoin pour optimiser les itinéraires de vol. Et c’est nous qui collectons ces données pour vous parce que nous pilotons réellement l’avion. Votre moteur reste au sol jusqu’à ce qu’il y ait un pilote dans le cockpit qui pilote réellement l’avion. Alors, qui profite des données ? Nous payons déjà beaucoup trop cher aux motoristes pour entretenir ces moteurs. Alors maintenant, vous nous dites que nous allons vous fournir les données gratuitement ? Non, non, non.

Tout cet argument est vraiment convaincant car c’est exactement ce qui se répète actuellement entre OpenAI et toutes les grandes entreprises. Les grandes entreprises pensent qu’OpenAI est génial ; ils peuvent créer ce chatbot en quelques minutes, c’est génial. Mais peuvent-ils réellement envoyer à OpenAI les données nécessaires au réglage fin et à toutes ces autres choses ? Et deuxièmement, supposons que ces entreprises le puissent. Supposons que ce soit le type de données qui soit acceptable, mais que ce soient leurs données – collectées par ces entreprises. Cela vaut sûrement quelque chose pour OpenAI, alors pourquoi ne baissent-ils pas la facture du côté de l’inférence pour les entreprises qui l’ont collecté ?

Et c’est ici qu’intervient la principale question du monde des données d’aujourd’hui : est-ce la même chose avec l’IA ?

D’une certaine manière, c’est le cas, mais avec des nuances importantes. Si nous pouvons avoir un avenir dans lequel le « moteur » central d’un avion, le modèle, sera produit par ces grandes entreprises, et où les entreprises exploiteront ensuite leurs données pour affiner ou augmenter ces modèles, alors il y aura une coexistence très harmonieuse de une chose vraiment complexe et une chose plus hautement spécialisée, peut-être moins complexe en plus. Si cela se produit et réussit sur le plan technologique, il sera alors beaucoup plus facile de discuter au niveau économique et politique de ce qui appartient à qui et de la manière dont nous répartissons les ensembles de données.

A titre d’exemple, Roman cite sa conversation avec un expert qui conçoit des voitures pour gagner sa vie : «Il a expliqué qu’il existe essentiellement deux types de concepteurs automobiles : l’un qui conçoit une voiture pour un moteur, et l’autre qui conçoit une voiture puis l’achète pour un moteur. Si vous produisez une voiture aujourd’hui, il est beaucoup plus facile d’obtenir le moteur car le moteur est la partie la plus complexe de la voiture. Cependant, cela ne définit certainement pas le produit. Mais quand même, la façon dont fonctionne l’industrie : il est beaucoup plus facile de dire, eh bien, compte tenu de certaines contraintes, je choisis un moteur, puis je conçois toute une gamme de voitures autour de ce moteur ou de ce type de moteur au moins.»

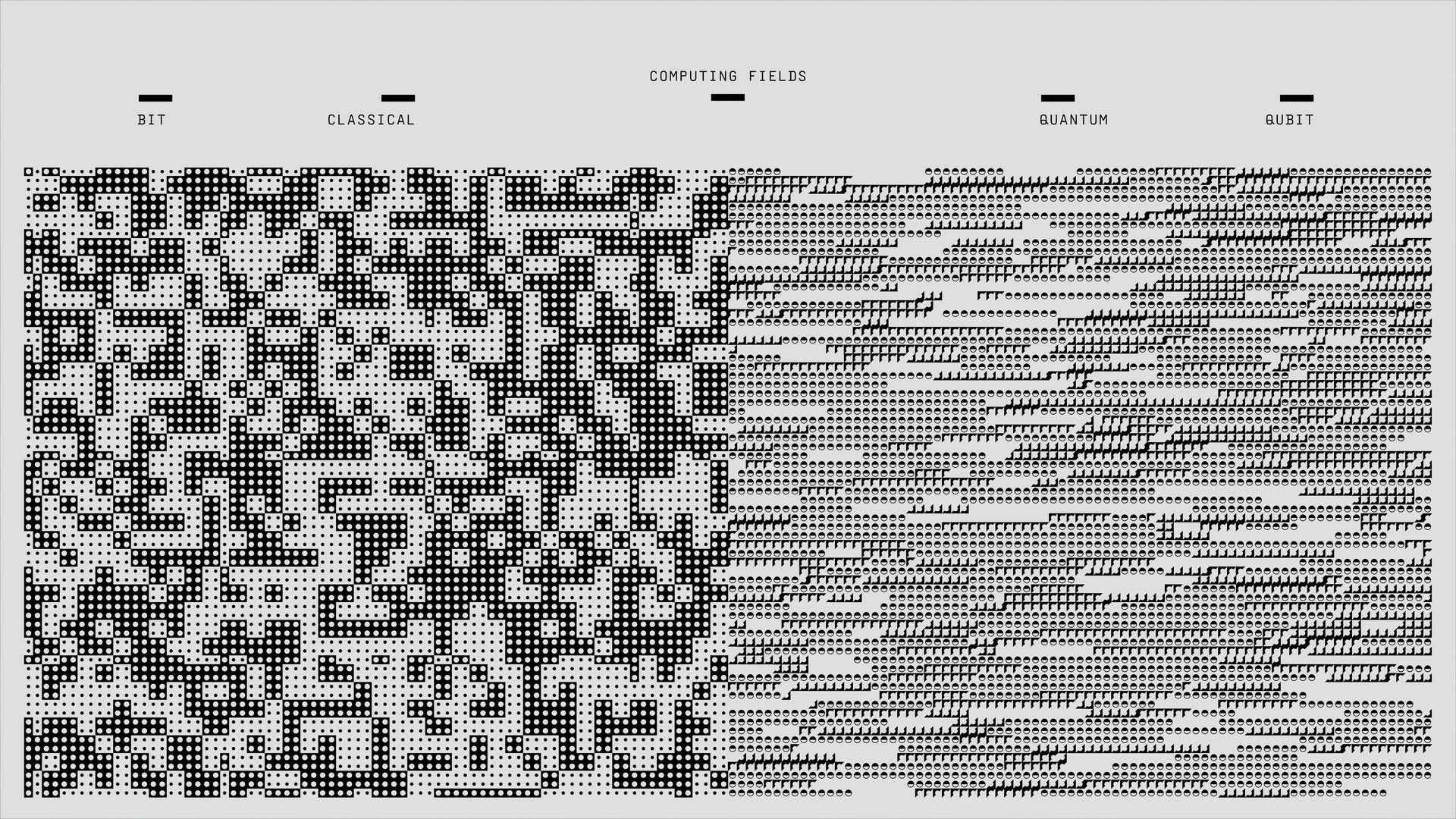

Cela nous amène au concept suivant : nous pensons que c’est à cela que ressemblera le monde des données piloté par l’IA. Il y aura le camp « Google » et le « camp Meta », et vous choisirez l’un de ces modèles ouverts – ils seront tous suffisants. Et puis, tout ce qui vous intéresse en tant qu’entreprise repose sur l’application de vos données et de votre savoir-faire pour les affiner et mettre à jour continuellement ces modèles provenant de différents « camps ». . Si cela fonctionne technologiquement et économiquement, un nouveau monde émergera.