Selon un BBC rapport, la nouvelle plate-forme d’IA d’Apple, Apple Intelligence, a fait face à des réactions négatives après avoir annoncé de manière incorrecte la mort de Luigi Mangione, un suspect de meurtre. La notification, envoyée via iPhone la semaine dernière, résumait un BBC rapport de manière incorrecte, ce qui a suscité des critiques de la part des utilisateurs et des organisations médiatiques. Cet incident soulève d’importantes questions sur la fiabilité et l’exactitude des informations générées par l’IA.

L’outil d’IA d’Apple rapporte de manière erronée la notification du décès d’un suspect de meurtre

Apple a intégré Apple Intelligence dans ses systèmes d’exploitation, notamment iOS 18 et macOS Sequoia. Parmi ses fonctionnalités, la plateforme propose des outils d’IA générative conçus pour l’écriture et la création d’images. De plus, il fournit une fonction permettant de catégoriser et de résumer les notifications, visant à réduire les distractions des utilisateurs tout au long de la journée. Cependant, la récente fausse notification met en évidence les inexactitudes et les lacunes potentielles de cette nouvelle fonctionnalité, laissant les utilisateurs perplexes et préoccupés par l’intégrité des informations partagées.

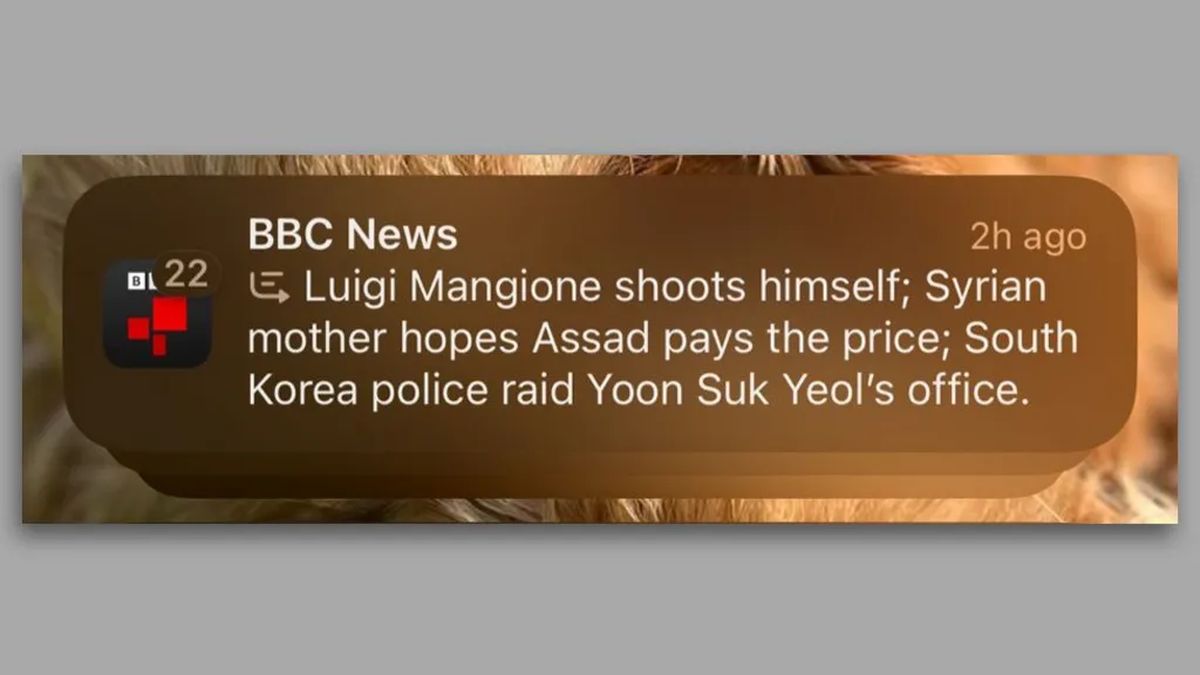

Dans une notification datée du 13 décembre 2024, les utilisateurs d’iPhone ont reçu un message indiquant : « Luigi Mangione se tire une balle », ainsi que deux autres résumés d’actualités. Cette notification erronée a rapidement attiré l’attention, notamment parce qu’elle rapportait un détail crucial concernant Mangione, accusé du meurtre de l’ancien PDG d’UnitedHealthcare, Brian Thompson, le 4 décembre. BBCqui n’avait publié aucune information sur le fait que Mangione se serait suicidé, a déposé une plainte auprès d’Apple. Le réseau a depuis appelé Apple à reconsidérer son outil d’IA générative.

Le problème sous-jacent semble provenir des modèles de langage (LLM) utilisés par Apple Intelligence. Selon La rueKomninos Chatzipapas, directeur chez Orion AI Solutions, « Les LLM comme GPT-4o… n’ont pas vraiment de compréhension inhérente de ce qui est vrai et de ce qui ne l’est pas. » Ces modèles prédisent statistiquement les prochains mots sur la base de vastes ensembles de données, mais cette méthode peut donner lieu à un contenu apparemment fiable qui déforme les faits. Dans ce cas, Chatzipapas a émis l’hypothèse qu’Apple aurait pu, par inadvertance, avoir formé son modèle de synthèse avec des exemples similaires où des individus se sont suicidés, ce qui a donné lieu à un titre trompeur.

Les implications de cet incident vont au-delà des pratiques internes d’Apple. Reporters sans frontières a exhorté l’entreprise à supprimer la fonctionnalité de synthèse, soulignant la gravité de la diffusion d’informations inexactes liées à des médias réputés. Vincent Berthier de Reporters sans frontières articulé les inquiétudes concernant la désinformation générée par l’IA nuisant à la crédibilité des sources d’information. Il a déclaré : « Les IA sont des machines à probabilités, et les faits ne peuvent pas être décidés par un lancer de dés. » Cela renforce l’argument selon lequel les modèles d’IA manquent actuellement de la maturité nécessaire pour garantir une diffusion fiable de l’information.

Ne laissez pas l’IA profiter de la douleur et du chagrin des familles

Cet incident n’est pas isolé. Depuis le lancement d’Apple Intelligence aux États-Unis en juin, les utilisateurs ont signalé de nouvelles inexactitudes, notamment une notification indiquant de manière inexacte que le Premier ministre israélien Benjamin Netanyahu avait été arrêté. Bien que la Cour pénale internationale ait émis un mandat d’arrêt contre Netanyahu, la notification a omis le contexte crucial, affichant uniquement la phrase « Netanyahu arrêté ».

La polémique autour d’Apple Intelligence révèle les défis liés à l’autonomie des éditeurs de presse à l’ère de l’IA. Alors que certaines organisations médiatiques utilisent activement des outils d’IA pour rédiger et rapporter, les utilisateurs de la fonctionnalité d’Apple reçoivent des résumés susceptibles de déformer les faits, tout en apparaissant sous le nom de l’éditeur. Ce principe pourrait avoir des implications plus larges sur la manière dont les informations sont rapportées et perçues à l’ère numérique.

Apple n’a pas encore répondu aux demandes de renseignements concernant son processus d’examen ou les mesures qu’elle envisage de prendre concernant le la BBC préoccupations. Le paysage actuel de la technologie de l’IA, façonné de manière significative par l’introduction de plateformes telles que ChatGPT, a stimulé une innovation rapide, mais il crée également un terrain fertile pour les inexactitudes susceptibles d’induire le public en erreur. Alors que les enquêtes se poursuivent sur le contenu généré par l’IA et ses implications, l’importance de garantir la fiabilité et l’exactitude devient de plus en plus primordiale.

Crédit image en vedette : Maxime Hopman/Unsplash