Génération de texte en vidéo n’est plus ce qu’il était il y a seulement quelques années. Nous l’avons transformé en un outil doté de fonctionnalités véritablement futuristes. Les utilisateurs créent du contenu pour leurs pages personnelles, les influenceurs l’exploitent pour leur auto-promotion et les entreprises l’utilisent pour tout, de la publicité et du matériel pédagogique à la formation virtuelle et à la production de films. La majorité des systèmes texte-vidéo reposent sur l’architecture des transformateurs de diffusion, qui constituent la pointe du monde de la génération vidéo. Cette technologie sert de base à des services comme Luma et Kling. Cependant, ce statut ne s’est consolidé qu’en 2024, lorsque les premiers transformateurs de diffusion pour la vidéo ont été adoptés sur le marché.

Le tournant est venu avec Sortie d’OpenAI de SORAprésentant des clichés incroyablement réalistes, presque impossibles à distinguer de la vie réelle. OpenAI a montré que son transformateur de diffusion pouvait générer avec succès du contenu vidéo. Cette décision a validé le potentiel de la technologie et a déclenché une tendance dans l’ensemble de l’industrie : désormais, environ 90 % des modèles actuels sont basés sur des transformateurs de diffusion.

La diffusion est un processus fascinant qui mérite une exploration plus approfondie. Comprenons comment fonctionne la diffusion, les défis que la technologie du transformateur relève dans ce processus et pourquoi elle joue un rôle si important dans la génération texte-vidéo.

Quel est le processus de diffusion dans GénAI?

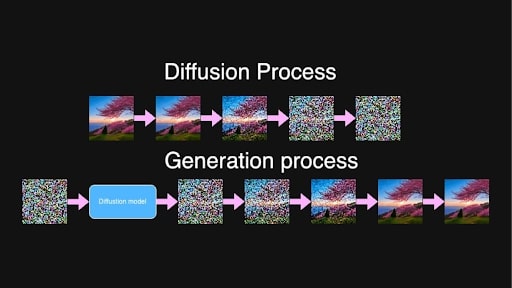

Au cœur de la génération de texte en vidéo et de texte en image se trouve le processus de diffusion. Inspirés par le phénomène physique où les substances se mélangent progressivement – comme l’encre se diffusant dans l’eau – les modèles de diffusion en apprentissage automatique impliquent un processus en deux étapes : ajouter du bruit aux données, puis apprendre à le supprimer.

Pendant la formation, le modèle prend des images ou des séquences d’images vidéo et ajoute progressivement du bruit sur plusieurs étapes jusqu’à ce que le contenu original devienne indiscernable. Essentiellement, cela le transforme en pur bruit.

Processus de diffusion et de génération pour l’invite « Bel arbre de sakura soufflé placé sur la colline au lever du soleil »

Processus de diffusion et de génération pour l’invite « Bel arbre de sakura soufflé placé sur la colline au lever du soleil »

Lors de la génération d’un nouveau contenu, le processus fonctionne à l’envers. Le modèle est entraîné pour prédire et supprimer le bruit par incréments, en se concentrant sur une étape de bruit intermédiaire aléatoire entre deux points, t et t+1. En raison du long processus de formation, le modèle a observé toutes les étapes de la progression du bruit pur vers des images presque nettes et a désormais la capacité d’identifier et de réduire le bruit à pratiquement n’importe quel niveau.

À partir d’un bruit pur et aléatoire, le modèle, guidé par le texte saisi, crée de manière itérative des images vidéo cohérentes et correspondant à la description textuelle. Un contenu vidéo détaillé et de haute qualité est le résultat de ce processus très progressif.

La diffusion latente est ce qui rend cela possible sur le plan informatique. Au lieu de travailler directement avec des images ou des vidéos haute résolution, les données sont compressées dans un espace latent par un encodeur.

Ceci est fait pour réduire (de manière significative) la quantité de données que le modèle doit traiter, accélérant ainsi la génération sans compromettre la qualité. Une fois que le processus de diffusion a affiné les représentations latentes, un décodeur les retransforme en images ou vidéos pleine résolution.

Le problème avec la génération vidéo

Contrairement à une image unique, la vidéo nécessite que les objets et les personnages restent stables tout au long, évitant ainsi les changements ou changements d’apparence inattendus. Nous avons tous vu les merveilles dont l’IA générative est capable, mais le bras manquant occasionnel ou l’expression faciale indiscernable restent tout à fait dans la norme. Dans la vidéo, cependant, les enjeux sont plus importants ; la consistance est primordiale pour une sensation fluide.

Ainsi, si un personnage apparaît dans la première image portant une tenue spécifique, cette tenue doit être identique dans chaque image suivante. Tout changement dans l’apparence du personnage, ou toute « transformation » d’objets en arrière-plan, brise la continuité et donne à la vidéo un aspect artificiel, voire étrange.

Image fournie par l’auteur

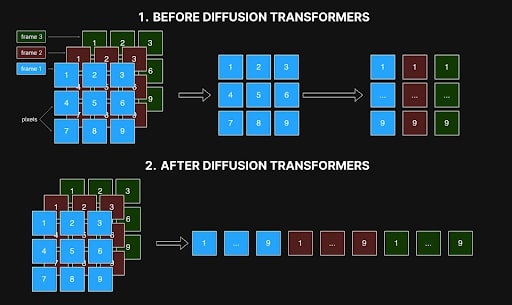

Les premières méthodes abordaient la génération vidéo en traitant les images individuellement, chaque pixel d’une image faisant uniquement référence à son pixel correspondant dans les autres. Cependant, cette approche image par image entraînait souvent des incohérences, car elle ne parvenait pas à capturer les relations spatiales et temporelles entre les images qui sont essentielles pour des transitions fluides et un mouvement réaliste. Des artefacts tels que des couleurs changeantes, des formes fluctuantes ou des caractéristiques mal alignées sont le résultat de ce manque de cohérence et diminuent la qualité globale de la vidéo.

Image fournie par l’auteur

Image fournie par l’auteur

Le principal obstacle à la résolution de ce problème était la demande de calcul – et le coût. Pour une vidéo de 10 secondes à 10 images par seconde, générer 100 images augmente la complexité de façon exponentielle. La création de ces 100 images est environ 10 000 fois plus complexe que la génération d’une seule image en raison de la nécessité d’une cohérence précise d’image à image. Cette tâche nécessite 10 000 fois plus en termes de mémoire, de temps de traitement et de ressources de calcul, dépassant souvent les limites pratiques. Comme vous pouvez l’imaginer, le luxe d’expérimenter ce processus était réservé à quelques privilégiés de l’industrie.

C’est ce qui a rendu la sortie de SORA par OpenAI si importante : ils ont démontré que les transformateurs de diffusion pouvaient effectivement gérer la génération vidéo malgré l’immense complexité de la tâche.

Comment les transformateurs de diffusion ont résolu le problème d’auto-cohérence dans la génération vidéo

L’émergence des transformateurs de diffusion a résolu plusieurs problèmes : ils ont permis de générer des vidéos de résolution et de longueur arbitraires tout en atteignant une auto-cohérence élevée. Cela s’explique en grande partie par le fait qu’ils peuvent travailler avec de longues séquences, à condition qu’elles restent en mémoire, et grâce au mécanisme d’auto-attention.

En intelligence artificielle, l’auto-attention est un mécanisme qui calcule les pondérations d’attention entre les éléments d’une séquence, déterminant dans quelle mesure chaque élément doit être influencé par les autres. Il permet à chaque élément d’une séquence de prendre en compte tous les autres éléments simultanément et permet aux modèles de se concentrer sur les parties pertinentes des données d’entrée lors de la génération de sortie, en capturant les dépendances dans l’espace et dans le temps.

Dans la génération vidéo, cela signifie que chaque pixel de chaque image peut être lié à tous les autres pixels de toutes les images. Cette interconnectivité garantit que les objets et les personnages restent cohérents tout au long de la vidéo, du début à la fin. Si un personnage apparaît dans une image, l’attention personnelle permet d’éviter les changements et de conserver l’apparence de ce personnage dans toutes les images suivantes.

Auparavant, les modèles incorporaient une forme d’auto-attention au sein d’un réseau convolutif, mais cette structure limitait leur capacité à atteindre la même cohérence et la même cohérence désormais possibles avec les transformateurs de diffusion.

Cependant, avec une attention spatio-temporelle simultanée dans les transformateurs de diffusion, l’architecture peut charger simultanément des données provenant de différentes trames et les analyser comme une séquence unifiée. Comme le montre l’image ci-dessous, les méthodes précédentes traitaient les interactions au sein de chaque image et liaient uniquement chaque pixel à sa position correspondante dans d’autres images (voir Figure 1). Cette vue restreinte a entravé leur capacité à capturer les relations spatiales et temporelles essentielles à un mouvement fluide et réaliste. Désormais, avec les transformateurs de diffusion, tout est traité simultanément (Figure 2).

Interaction spatio-temporelle dans les réseaux de diffusion avant et après transformateurs. Image fournie par l’auteur

Interaction spatio-temporelle dans les réseaux de diffusion avant et après transformateurs. Image fournie par l’auteur

Ce traitement holistique maintient des détails stables à travers les images, garantissant que les scènes ne se transforment pas de manière inattendue et ne se transforment pas en un désordre incohérent du produit final. Les transformateurs de diffusion peuvent également gérer des séquences de longueur et de résolution arbitraires, à condition qu’elles tiennent dans la mémoire. Grâce à cette avancée, la génération de vidéos plus longues est réalisable sans sacrifier la cohérence ou la qualité, répondant ainsi à des défis que les méthodes précédentes basées sur la convolution ne pouvaient pas surmonter.

L’arrivée des transformateurs de diffusion a remodelé la génération texte-vidéo. Il a permis la production de vidéos cohérentes et de haute qualité sur des longueurs et des résolutions arbitraires. L’attention personnelle au sein des transformateurs est un élément clé pour relever des défis tels que le maintien de la cohérence du cadre et la gestion de relations spatiales et temporelles complexes. La sortie de SORA par OpenAI a prouvé cette capacité, établissant une nouvelle norme dans l’industrie : désormais, environ 90 % des systèmes texte-vidéo avancés sont basés sur des transformateurs de diffusion, avec des acteurs majeurs comme Luma, Clink et Runway Gen-3 en tête. marché.

Malgré ces avancées époustouflantes, les transformateurs de diffusion restent très gourmands en ressources, nécessitant près de 10 000 fois plus de ressources qu’une génération d’image unique, ce qui rend la formation de modèles de haute qualité encore une entreprise très coûteuse. Néanmoins, la communauté open source a pris des mesures importantes pour rendre cette technologie plus accessible. Des projets comme Open-SORA et Open-SORA-Plan, ainsi que d’autres initiatives telles que Mira Video Generation, Cog et Cog-2, ont ouvert de nouvelles possibilités aux développeurs et aux chercheurs pour expérimenter et innover. Soutenus par des entreprises et des institutions académiques, ces projets open source laissent espérer des progrès continus et une plus grande accessibilité dans la génération vidéo, bénéficiant non seulement aux grandes entreprises mais aussi aux créateurs indépendants et aux passionnés avides d’expérimentation. Ceci, comme tout autre effort communautaire, ouvre un avenir où la génération vidéo sera démocratisée, offrant cette technologie puissante à de nombreux autres créatifs à explorer.