Le visage étreint a libéré Deux nouveaux modèles d’IA, SMOLVLM-256M et SMOLVLM-500M, affirmant qu’ils sont les plus petits de leur genre capables d’analyser des images, des vidéos et du texte sur des appareils avec des RAM limités, tels que des ordinateurs portables.

Hugging Face lance des modèles d’IA compacts pour l’analyse d’image et de texte

UN Modèle de petite langue (SLM) est un réseau neuronal conçu pour produire du texte en langage naturel. Le descripteur «petit» s’applique non seulement aux dimensions physiques du modèle mais également à son nombre de paramètres, à la structure neuronale et au volume de données utilisé pendant la formation.

SMOLVLM-256M et SMOLVLM-500M se composent respectivement de 256 millions de paramètres et de 500 millions de paramètres. Ces modèles peuvent effectuer diverses tâches, notamment en décrivant des images et des clips vidéo, ainsi que des questions sur les PDF et leur contenu, tels que le texte et les graphiques numérisés.

Sam Altman pour brèves les fonctionnaires sur le «au niveau du doctorat» Super AI

Pour former ces modèles, Hugging Face a utilisé le chaudron, une collection organisée de 50 ensembles de données d’image et de texte de haute qualité, aux côtés de Docmatix, un ensemble de données comprenant des analyses de fichiers avec des légendes détaillées. Les deux ensembles de données ont été créés par l’équipe M4 de Hugging Face, axée sur les technologies multimodales d’IA.

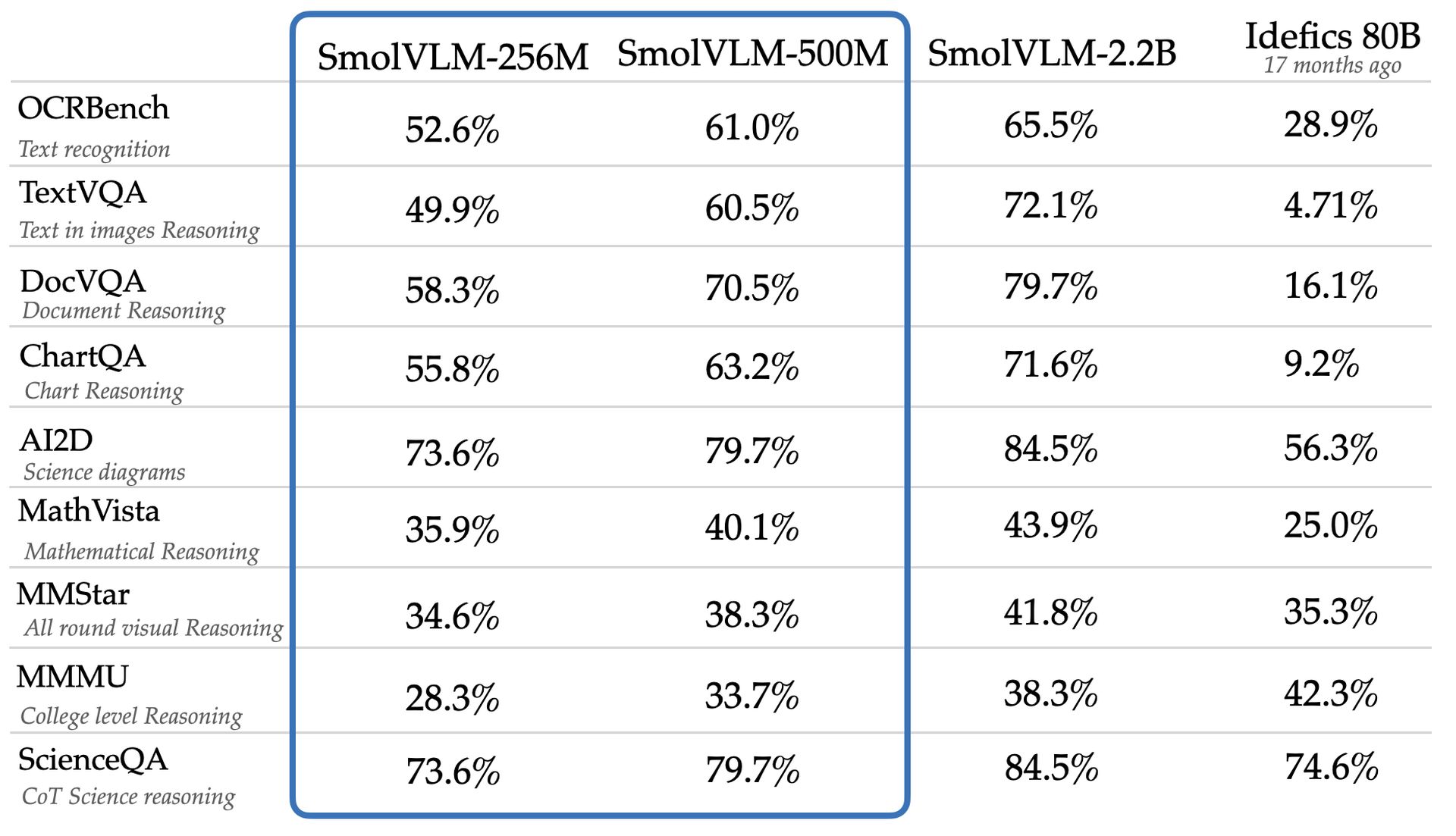

L’équipe affirme que SMOLVLM-256M et SMOLVLM-500M surpassent un modèle significativement plus important, IDEFICS 80B, dans des références telles que AI2D, qui évalue les capacités des modèles pour analyser les diagrammes scientifiques au niveau de l’école. Les nouveaux modèles sont disponibles pour l’accès Web et le téléchargement sous une licence Apache 2.0, qui permet une utilisation sans restriction.

Malgré leur polyvalence et leur rentabilité, des modèles plus petits comme SmolVLM-256M et SmolVLM-500M peuvent présenter des limitations non observées dans des modèles plus grands. Une étude de Google Deepmind, de Microsoft Research et du Mila Research Institute a souligné que les modèles plus petits fonctionnent souvent sous-optimalement sur des tâches de raisonnement complexes, potentiellement en raison de leur tendance à reconnaître les modèles au niveau de la surface plutôt que d’appliquer des connaissances dans de nouveaux contextes.

Le modèle SMOLVLM-256M de Hugging Face fonctionne avec moins d’un gigaoctet de mémoire GPU et surpasse le modèle IDEFICS 80B, un système 300 fois plus grand, réalisant cette réduction et amélioration dans les 17 mois. Andrés Marafioti, ingénieur de recherche sur l’apprentissage automatique à Hugging Face, a noté que cette réalisation reflète une percée importante dans les modèles de vision.

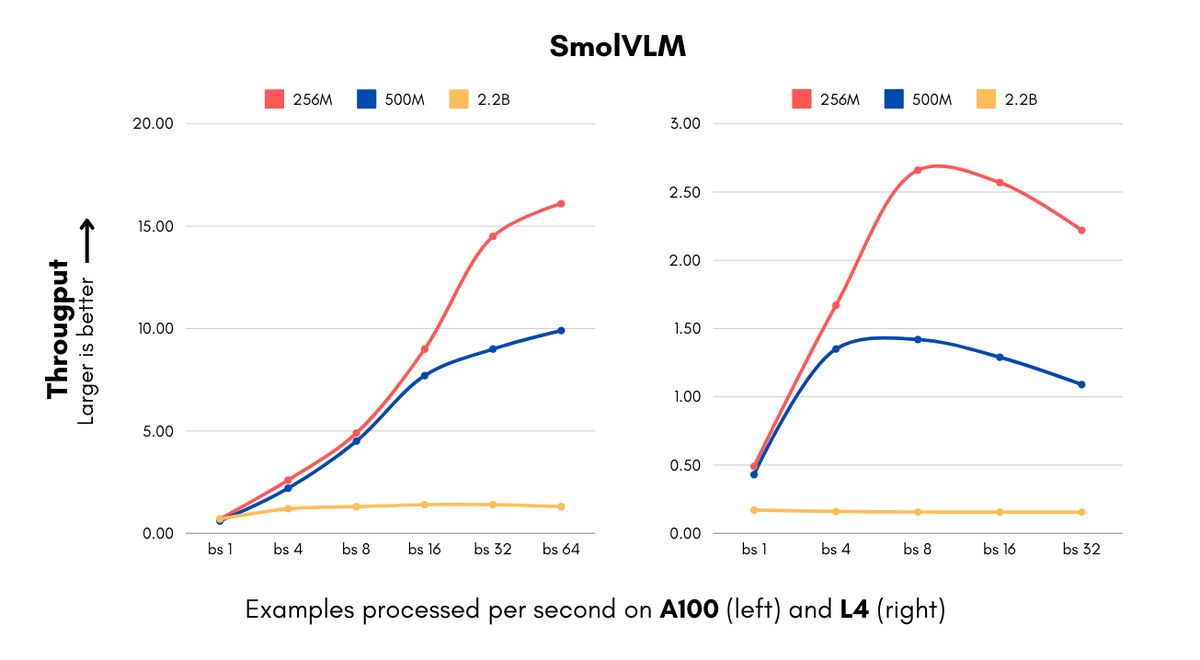

L’introduction de ces modèles est opportune pour les entreprises confrontées à des coûts informatiques élevés associés aux implémentations de l’IA. Les modèles SMOLVLM sont capables de traiter les images et de comprendre le contenu visuel à des vitesses sans précédent pour les modèles de leur taille. La version 256m peut traiter 16 exemples par seconde tout en ne consommant que 15 Go de RAM avec une taille de lot de 64, conduisant à des économies de coûts considérables pour les entreprises qui gèrent de grands volumes de données visuelles.

IBM a formé un partenariat avec Hugging Face pour incorporer le modèle 256m dans son logiciel de traitement de document, docling. Comme l’a expliqué Marafioti, même les organisations avec des ressources informatiques substantielles peuvent bénéficier de l’utilisation de modèles plus petits pour traiter efficacement des millions de documents à des coûts réduits.

Les étreintes de la face ont réalisé des réductions de taille tout en maintenant les performances grâce à des progrès dans les composants de traitement de la vision et de langage, y compris un passage d’un encodeur de vision de paramètre de 400 m à une version de paramètre de 93 m et l’utilisation de techniques de compression de jetons agressives. Cette efficacité ouvre de nouvelles possibilités pour les startups et les petites entreprises, ce qui leur permet de développer plus rapidement des produits de vision informatique sophistiqués et de réduire leurs coûts d’infrastructure.

Les modèles SMOLVLM améliorent les capacités au-delà des économies de coûts, facilitant de nouvelles applications telles que la recherche de documents avancée via un algorithme nommé Colipali, qui crée des bases de données consultables à partir d’archives de documents. Selon Marafioti, ces modèles correspondent presque aux performances des modèles 10 fois leur taille tout en augmentant considérablement la vitesse de création et de recherche de base de données, ce qui rend la recherche visuelle à l’échelle de l’entreprise possible pour diverses entreprises.

Les modèles SMOLVLM remettent en question la croyance conventionnelle que des modèles plus grands sont nécessaires pour les tâches avancées en langue de vision, la version de paramètre de 500 m atteignant 90% des performances d’un homologue de paramètre 2.2b sur des références clés. Marafioti a souligné que ce développement démontre l’utilité des modèles plus petits, suggérant qu’ils peuvent jouer un rôle crucial pour les entreprises.

Crédit d’image en vedette: Visage étreint