Les analyses des utilisateurs et les tests de référence révèlent un verdict divisé entre Deepseek R1 et O3-MinI, avec les développeurs et les entreprises hiérarchisant des forces distinctes dans les performances, les prix et l’accessibilité du modèle d’IA. Les commentaires des gens mettent en évidence la rentabilité et l’innovation technique de Deepseek R1 contre la fiabilité et l’intégration des écosystèmes d’O3-Mini. Plus à ce sujet ci-dessous…

Openai O3-Mini vs Deepseek-R1: Quel est le meilleur?

Les références de performance révèlent des forces divergentes

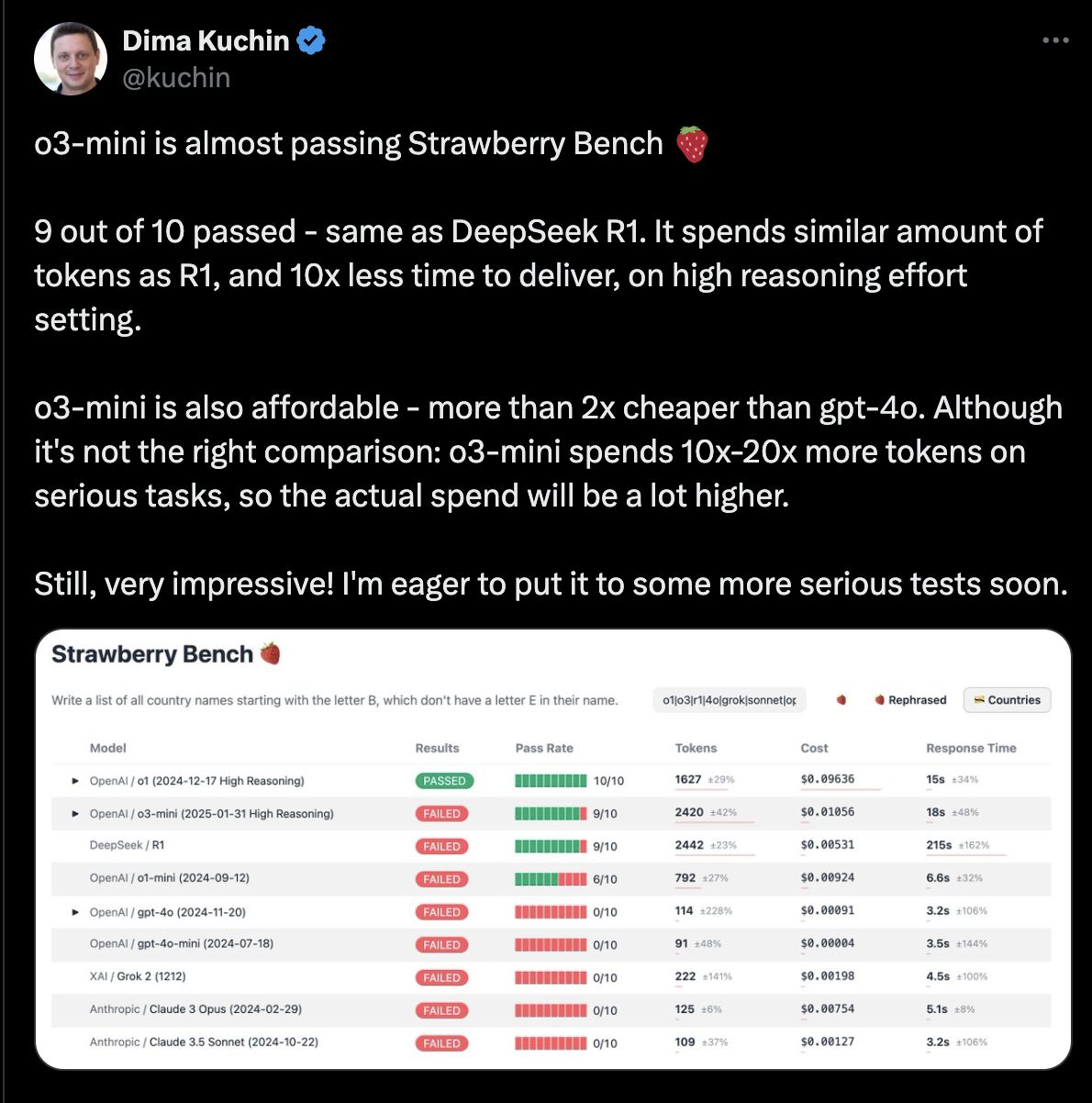

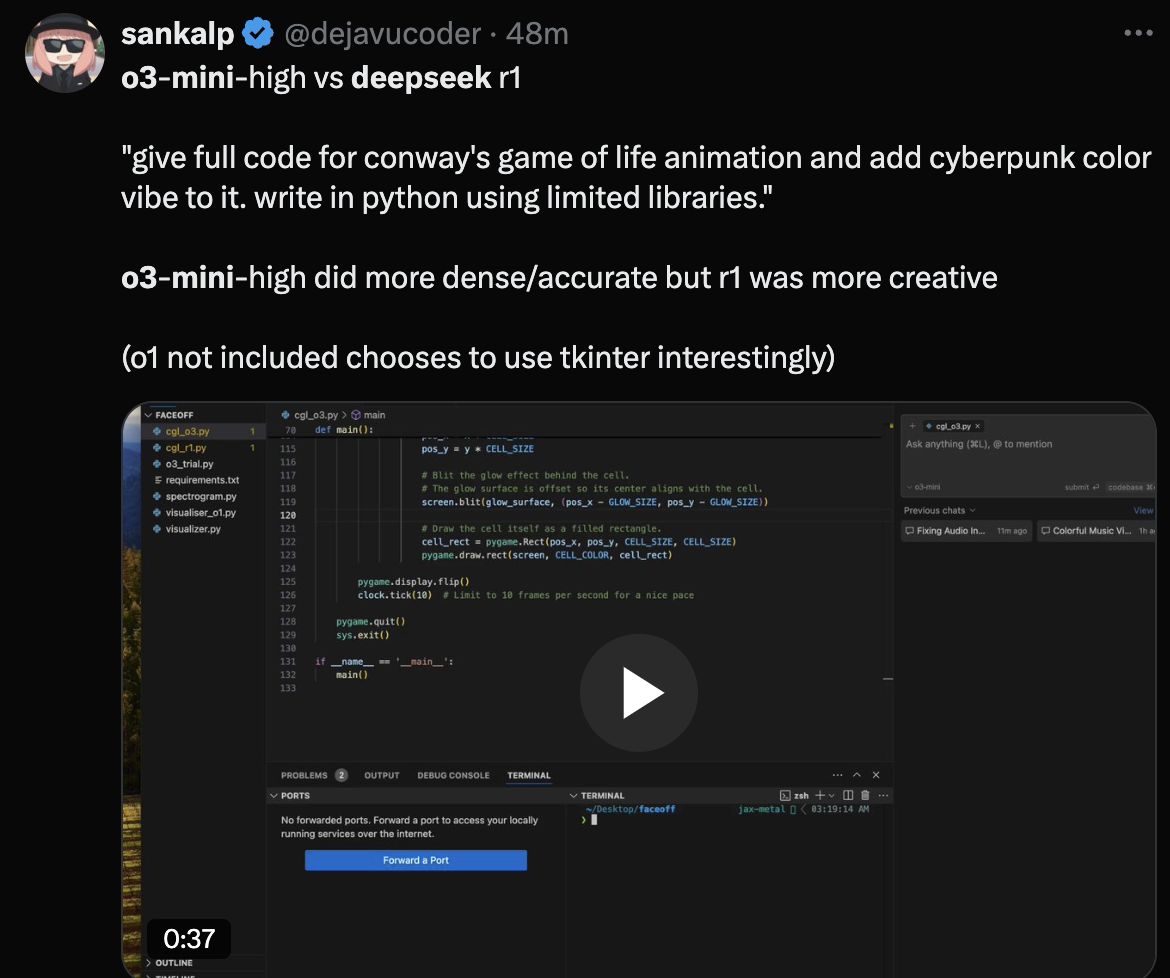

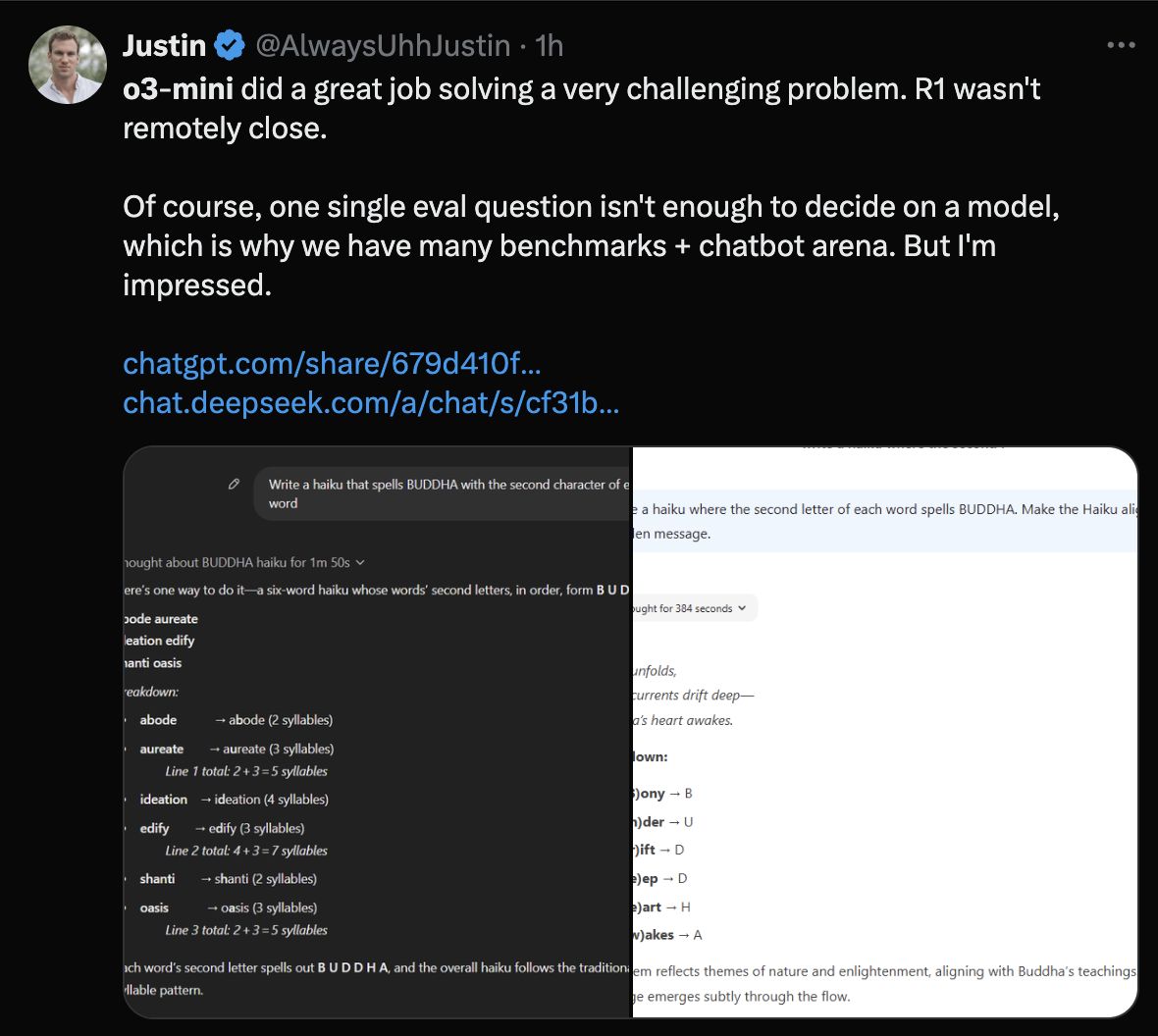

Deepseek R1 a marqué 79,8% sur la référence en mathématiques AIME et 93% sur MATH-500, surpassant les concurrents dans des tâches de raisonnement complexes. Les utilisateurs ont salué ses résultats transparents de «chaîne de pensée», que les chercheurs et les universitaires trouvent précieux pour reproduire les résultats. Cependant, les testeurs ont noté des incohérences dans les conversations multi-tours et un mélange de langage occasionnel dans les réponses.

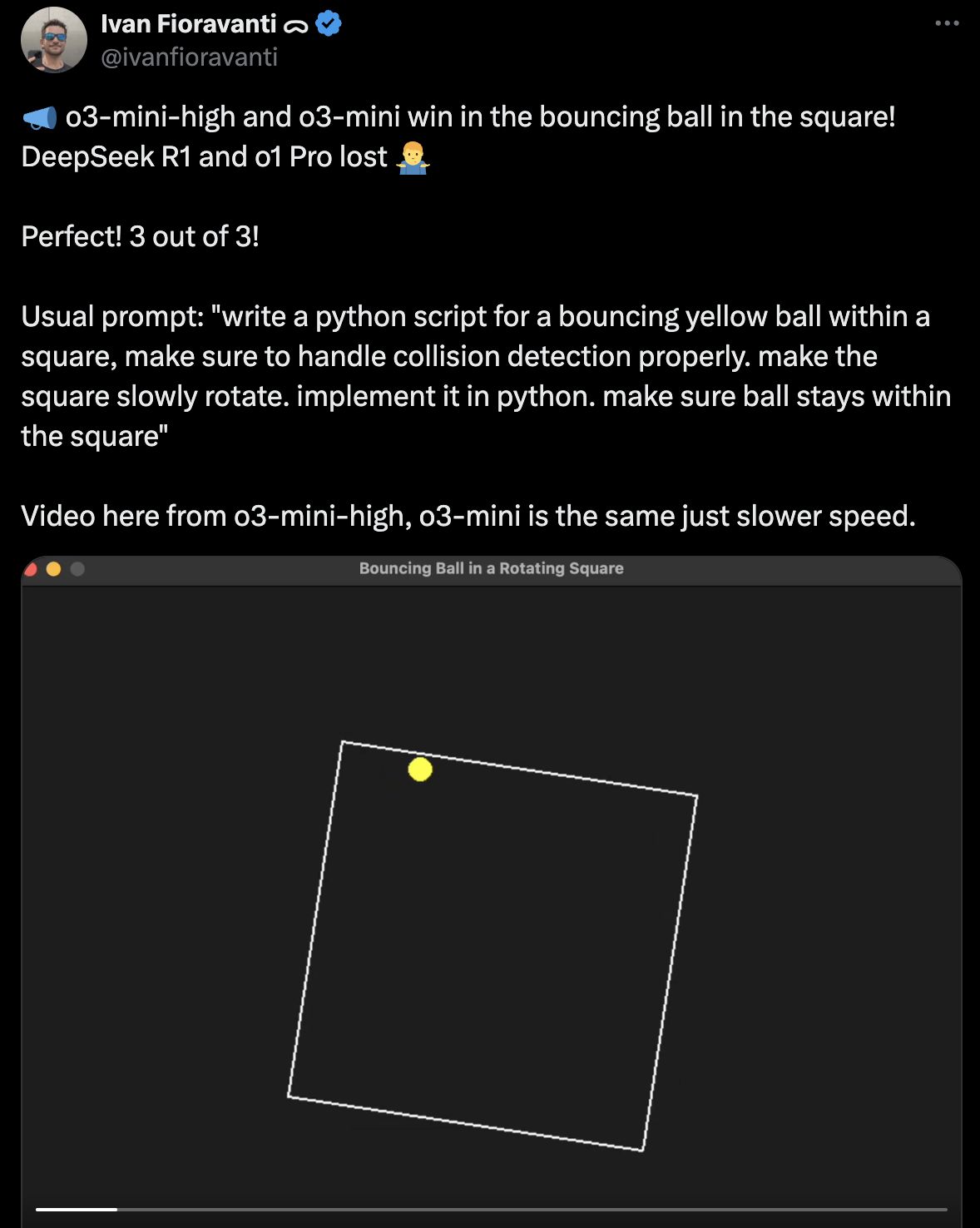

O3-min Des vitesses d’inférence plus rapides démontrées et des performances plus stables dans des dialogues structurés et multi-tours, selon les rapports d’utilisateurs du monde réel. Bien qu’il suit Deepseek R1 dans des repères mathématiques spécialisés, les développeurs l’ont décrit comme «prévisible et poli» pour des tâches de routine telles que la génération de code et l’analyse des données.

O3-min Des vitesses d’inférence plus rapides démontrées et des performances plus stables dans des dialogues structurés et multi-tours, selon les rapports d’utilisateurs du monde réel. Bien qu’il suit Deepseek R1 dans des repères mathématiques spécialisés, les développeurs l’ont décrit comme «prévisible et poli» pour des tâches de routine telles que la génération de code et l’analyse des données.

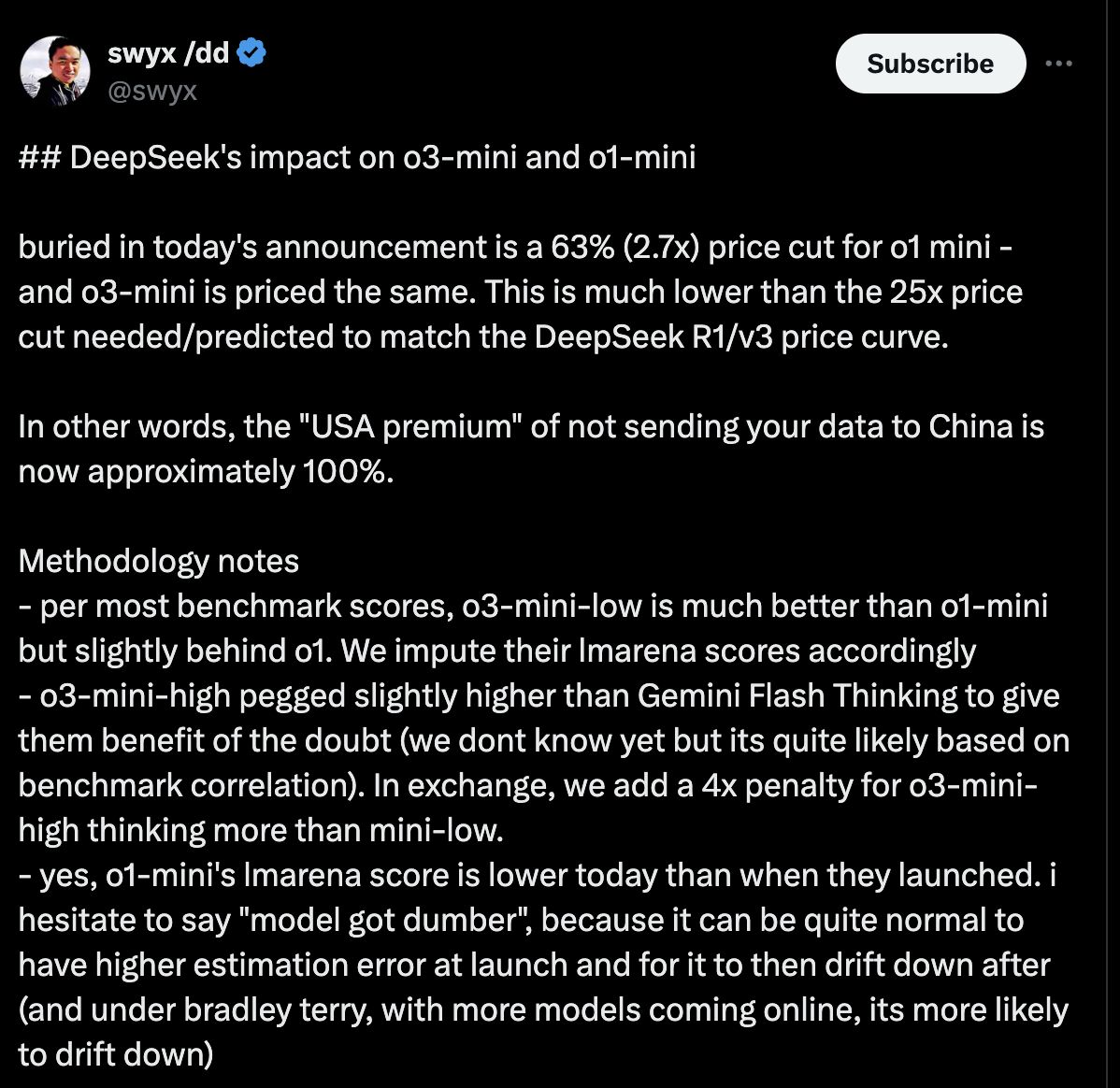

La comparaison des coûts met en évidence les perturbations du marché

Deepseek R1 apparaît comme l’option la plus abordable dans les comparaisons de modèles d’IA récentes, sapant les modèles O3-Mini, O1-Mini et O1 d’OpenAI par des marges significatives. Les données sur les prix révèlent des différences frappantes dans les coûts de jetons entre les services concurrents.

Triques de prix du modèle Openai

Triques de prix du modèle Openai

O3-MinI coûte 1,10 $ par million de jetons d’entrée et 4,40 $ par million de jetons de production, ce qui représente une remise de 63% par rapport à O1-MinI et une réduction de 93% par rapport aux prix du modèle O1 complet. Une remise de 50% de cache réduit encore les taux effectifs d’O3-Mini pour les utilisateurs éligibles.

La stratégie de tarification agressive de Deepseek

Deepseek R1 facture 0,14 $ par million de jetons d’entrée et 0,55 $ par million de jetons de production – environ 87% moins cher que les taux de base d’O3-MinI. Cela fait R1:

• 96% moins cher que les prix équivalents d’O1-Mini

• 99% moins cher que les coûts d’origine du modèle O1 complet

L’écart de tarification persiste même lors de l’application de la remise de cache d’O3-Mini: à 0,55 $ / 2,20 $ par million de jetons (entrée / sortie), O3-MinI reste presque 4x plus cher que les tarifs non évités de R1. Les développeurs de X ont appelé cela un «changement de jeu» pour les startups et les projets académiques nécessitant une IA de haute performance sans frais de licence.

Les prix d’O3-Mini s’alignent sur les modèles commerciaux d’Openai, mais comprennent l’accès aux outils d’entreprise de Chatgpt, y compris la conformité SOC 2 et les contrôles d’utilisation granulaire. Les utilisateurs de l’entreprise justifient le coût plus élevé en citant une complexité de déploiement réduite et des fonctionnalités de sécurité intégrées.

Les prix d’O3-Mini s’alignent sur les modèles commerciaux d’Openai, mais comprennent l’accès aux outils d’entreprise de Chatgpt, y compris la conformité SOC 2 et les contrôles d’utilisation granulaire. Les utilisateurs de l’entreprise justifient le coût plus élevé en citant une complexité de déploiement réduite et des fonctionnalités de sécurité intégrées.

Facilité d’utilisation: accessibilité vs personnalisation

O3-MinI domine la convivialité avec son interface de style ChatGPT, le niveau gratuit pour les utilisateurs de base et l’API nécessitant une expertise de codage minimale. Les testeurs non techniques ont terminé l’intégration en moins de 30 minutes, faisant l’éloge de sa «conception intuitive» pour le prototypage rapide.

Deepseek R1 exige une compétence technique pour le déploiement, obligeant les utilisateurs à gérer l’infrastructure et à affiner les modèles via le code. Alors que les développeurs apprécient sa flexibilité, les petites équipes rapportent des dépenses de «configurations de dépannage des heures» pour optimiser les sorties.

Deepseek R1 exige une compétence technique pour le déploiement, obligeant les utilisateurs à gérer l’infrastructure et à affiner les modèles via le code. Alors que les développeurs apprécient sa flexibilité, les petites équipes rapportent des dépenses de «configurations de dépannage des heures» pour optimiser les sorties.

Les réactions de la communauté montrent des préférences divisées

Les utilisateurs X mettent en évidence l’abordabilité et la transparence de Deepseek R1. Les critiques citent une «formatage maladroit» et des performances plus faibles dans les tâches d’écriture créative par rapport à O3-MinI.

O3-Mini gagne des éloges pour la fiabilité, mais les sceptiques soutiennent que son coût interdit la mise à l’échelle, tandis que certains développeurs déplorent un contrôle limité sur le comportement du modèle par rapport aux alternatives open source.

O3-Mini gagne des éloges pour la fiabilité, mais les sceptiques soutiennent que son coût interdit la mise à l’échelle, tandis que certains développeurs déplorent un contrôle limité sur le comportement du modèle par rapport aux alternatives open source.

Verdict final: spécialistes vs généralistes

Les équipes techniques favorisent Deepseek R1 pour ses prouesses mathématiques, son code open-source et ses économies de coûts radicales, malgré des courbes d’apprentissage plus élevées. Les entreprises et les utilisateurs occasionnels préfèrent les fonctionnalités plug-and-play d’O3-Mini et l’intégration transparente avec les flux de travail OpenAI existants.

Les discussions communautaires soulignent un fossé croissant: Deepseek R1 attire des chercheurs et des développeurs privilégiant les performances brutes, tandis que O3-Mini conserve les entreprises et les individus évaluant la stabilité et la facilité d’adoption.

Les discussions communautaires soulignent un fossé croissant: Deepseek R1 attire des chercheurs et des développeurs privilégiant les performances brutes, tandis que O3-Mini conserve les entreprises et les individus évaluant la stabilité et la facilité d’adoption.