Un nouveau modèle d’IA nommé S1, dévoilé Dans un article publié le 2 février, attire l’attention pour ses performances rentables qui rivalisent avec l’O1 d’Openai, atteignant des capacités importantes à un coût de formation de seulement 6 $.

Le modèle AI S1 apparaît comme une alternative rentable à l’O1 d’Openai

Le modèle S1 atteint des niveaux de performance proches de la pointe, en utilisant une infrastructure plus simple. Il améliore les modèles de langue importants (LLM) lors de l’inférence en prolongeant le «temps de réflexion» à travers des interventions telles que le remplacement des balises terminales par des invites comme «attendre».

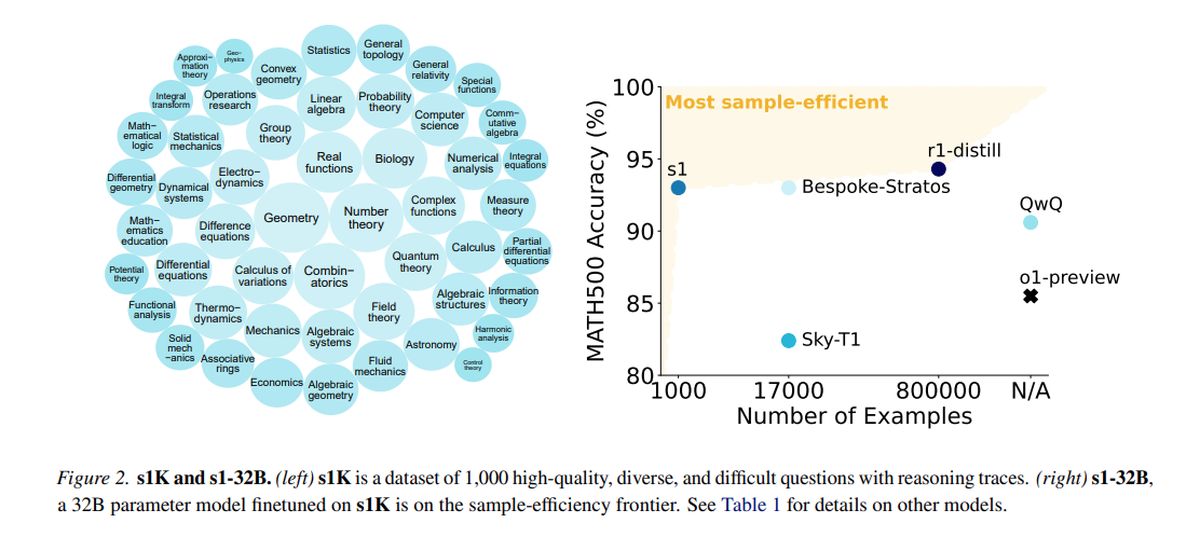

Formé sur un ensemble de données distillé composé de 1 000 exemples de haute qualité de QWEN2.5, développés par Alibaba Cloud, S1 a utilisé 16 GPU NVIDIA H100, avec une seule formation d’une durée d’environ 26 minutes. Le coût de calcul total était d’environ 6 $, permettant une expérimentation plus fréquente, même pour les équipes avec des ressources limitées.

Alors que les grandes organisations comme OpenAI et anthropic dépendent d’une infrastructure étendue, des innovations comme S1 démontrent le potentiel de progrès dans les budgets contraints. Cependant, l’introduction de S1 a suscité des préoccupations concernant la «distariment», une pratique où les modèles utilisent des ensembles de données distillés d’autres systèmes d’IA, soulevant des questions éthiques et juridiques qui ont déclenché des discussions sur l’industrie.

Dans les tests mesurant les capacités de mathématiques et de codage, S1 fonctionne de manière comparable aux principaux modèles de raisonnement, tels que O1 d’OpenAI et R1 de Deepseek. Le modèle S1, y compris son code de données et de formation, est accessible sur GitHub.

L’équipe derrière S1 a commencé avec un modèle de base standard et l’a affiné par la distillation, une méthode pour extraire les capacités de raisonnement d’un modèle d’IA existant en utilisant ses réponses. Plus précisément, S1 est distillé de Google Gémeaux 2.0 Flash Thinking Experimental, représentant une approche similaire utilisée par les chercheurs de Berkeley pour développer un modèle de raisonnement en IA pour environ 450 $ le mois dernier.

La capacité des petites équipes de recherche à innover dans l’espace d’IA sans soutien financier substantiel présente à la fois l’excitation et les défis. La question se pose sur la durabilité des avantages propriétaires dans un paysage où les modèles coûteux peuvent être reproduits à abondance.

OpenAI a exprimé l’insatisfaction, alléguant que Deepseek a récolté de manière inappropriée les données de son API aux fins de la distillation du modèle. Les chercheurs visaient à concevoir une approche simple qui atteint des performances de raisonnement robustes et une «mise à l’échelle du temps de test», permettant aux modèles d’IA de s’engager dans une analyse plus approfondie avant de répondre.

La recherche S1 indique que les modèles de raisonnement peuvent être distillés à l’aide d’un ensemble de données relativement petit via une méthode appelée réglage fin supervisé (SFT), qui demande au modèle d’IA d’imiter certains comportements dans un ensemble de données. Cette méthode a tendance à être plus économique que l’approche d’apprentissage par renforcement à grande échelle utilisée par Deepseek pour son modèle R1.

Google offre un accès gratuit à l’expérimentation de la pensée Flash Gemini 2.0, bien que l’utilisation soit soumise à des limites de taux quotidiennes, et ses termes interdisent les modèles d’inversion de rétro-ingénierie pour créer des services concurrents. Le processus de formation S1 impliquait la conservation d’un ensemble de données de 1 000 questions et réponses sur mesure ainsi que les processus de raisonnement dérivés de Gemini 2.0.

Après la formation, qui a pris moins de 30 minutes, S1 a démontré de solides performances sur des repères d’IA spécifiques. Niklas Muennighoff, chercheur de Stanford impliqué dans le projet, a indiqué que les ressources informatiques nécessaires pourraient être louées aujourd’hui pour environ 20 $.

Les chercheurs ont également mis en œuvre une technique pour améliorer la précision de S1 en lui demandant de «attendre» pendant le raisonnement, prolongeant ainsi son temps de réflexion et réalisant des réponses légèrement améliorées.

Crédit d’image en vedette: Google Deepmind / Unsplash