L’intelligence artificielle s’améliore pour comprendre le monde en trois dimensions, mais une nouvelle étude suggère que beaucoup Benchmarks du modèle de grande langue 3D (LLM) pourrait ne pas tester des capacités 3D du tout. Au lieu de cela, ces évaluations peuvent être victimes de ce que les chercheurs appellent le problème de la «batterie 2D» – où les modèles d’IA formés principalement sur des images 2D peuvent surpasser les modèles 3D dédiés simplement en rendant les nuages de points en images.

Une équipe de l’Université de Shanghai Jiao Tong, dont Jiahe Jin, Yanheng HE et Mingyan Yang, a trouvé dans leur étude, «Revisiter les références 3D LLM: testons-nous vraiment les capacités 3D? », Le fait que de nombreuses tâches utilisées pour évaluer l’IA 3D peuvent être résolues tout aussi facilement par des modèles de vision (VLMS) – les systèmes AI principalement formés sur les images 2D et le texte. Cela soulève une question cruciale: les repères actuels mesuraient-ils vraiment la compréhension 3D, ou testent-ils simplement dans quelle mesure l’IA peut-il traiter les rendus 2D de données 3D?

2D-Cheeting: Le raccourci qui expose les références faibles

Le problème découle de la façon dont les LLM 3D sont évaluées. De nombreux repères existants comptent sur Q&A et tâches de sous-titrageoù une IA est invitée à décrire un objet 3D ou à répondre aux questions à ce sujet. L’hypothèse est qu’un AI formé en 3D devrait fonctionner mieux que celui qui ne comprend que des images 2D.

Cependant, les chercheurs ont découvert que VLMS comme GPT-4O et QWEN2-VLqui n’ont pas été spécialement conçus pour les tâches 3D, pouvaient Surperfient souvent les modèles 3D de pointe– Simplement en regardant des images 2D de nuages ponctuels. Cela suggère que ces repères ne testent pas réellement si l’IA comprend les structures 3D, mais plutôt dans quelle mesure il peut déduire les informations 3D à partir d’images plates.

Pour démontrer cela, l’équipe s’est développée Vlm3dune méthode qui convertit les nuages de points 3D en images rendues avant de les nourrir dans un VLM. Lorsqu’il a été testé sur des références 3D majeures, notamment 3D MM-VET, OBJAVERSEXL-Lvis, ScanQA et SQA3D—Vlm3d a systématiquement surpassé ou apparié les principaux modèles 3D dans de nombreuses tâches.

Pourquoi certaines tâches 3D sont plus vulnérables que d’autres

Alors que les VLM ont excellé dans des tâches comme la reconnaissance d’objets et la description de la scène de base, ils ont lutté sur des tâches qui nécessitaient une compréhension plus profonde de relations spatiales, occlusions et cohérence multi-visualités.

- Benchmarks d’objet 3D simples: De nombreuses tâches de reconnaissance d’objets dans les repères 3D pourraient être facilement résolu à l’aide d’images 2D. L’étude a révélé que les VLM pourraient correspondre ou dépasser les modèles 3D dans ces cas, prouvant que les repères ne testaient pas efficacement la compréhension 3D.

- Benchmarks de scène complexes: Les tâches exigeant que l’IA comprenne des environnements 3D complets, tels que Q&R au niveau de la scène, navigationet raisonnement situationnelétaient beaucoup plus difficiles à tricher pour les VLM. Ici, les LLM 3D ont toujours mieux performé, montrant que ces tâches reposent sur le vrai raisonnement spatial 3D.

Cela signifie que Tous les références 3D ne sont pas défectueuses– mais beaucoup d’entre eux ne parviennent pas à distinguer véritable capacité 3D et astuces d’inférence 2D.

Quand les modèles 2D sont coincés

L’une des plus grandes faiblesses de VLMS dans les tâches 3D provient de Sélection de point de vue—Le fait qu’une seule image 2D ne capture qu’une partie d’une scène 3D.

Les chercheurs ont testé Trois approches de rendu différentes Pour évaluer combien cela a un impact sur les performances:

- Vue unique: L’approche la plus simple, où un objet ou une scène est rendu dans une perspective fixe. VLMS a fonctionné le mieux icicar ils pouvaient extraire suffisamment d’informations à partir d’une seule image.

- Multi-View: Des images ont été capturées à partir de Quatre angles différentsdonnant plus de contextes sur les modèles AI. Étonnamment, VLMS ne s’est pas amélioré de manière significative Par rapport aux modèles à vue unique, suggérant qu’ils ont du mal à combiner plusieurs perspectives dans une compréhension 3D unifiée.

- View Oracle: L’IA a été donnée Le meilleur point de vue possible pour répondre à chaque question. Ici, les VLM ont beaucoup mieux fonctionnémais n’a toujours pas réussi à des LLM 3D dédiés, montrant que même lorsqu’ils ont donné des images parfaites, elles manquent de véritables capacités de raisonnement 3D.

Cela renforce l’idée que Les VLM ne «comprennent pas» 3D– Ils réussissent bien quand on leur donne les bonnes vues 2D.

Ce qui doit changer

Pour vraiment évaluer les modèles d’IA 3D, l’étude propose Quatre principes clés Pour concevoir de meilleures repères:

- Données 3D plus complexes: Au lieu d’utiliser des nuages de points d’objet simples, les repères devraient inclure scènes 3D détaillées et réalistes avec complexité structurelle.

- Tâches qui nécessitent un vrai raisonnement 3D: Plutôt que de simplement reconnaître les objets, l’IA doit être testé sur des tâches qui nécessitent compréhension spatialecomme la prévision des surfaces cachées ou le raisonnement sur les interactions objets.

- Défis de contexte: Les questions doivent être conçues pour se concentrer sur Propriétés 3D uniquesen s’assurant qu’ils ne peuvent pas répondre en utilisant une seule image 2D.

- Meilleures métriques d’évaluation: Les repères actuels comptent souvent Scores de similitude du textequi ne capture pas Véritable compréhension 3D. Au lieu de cela, les modèles d’IA doivent être évalués en fonction de leur capacité à Inférer la profondeur, la structure et les relations d’objet dans l’espace tridimensionnel.

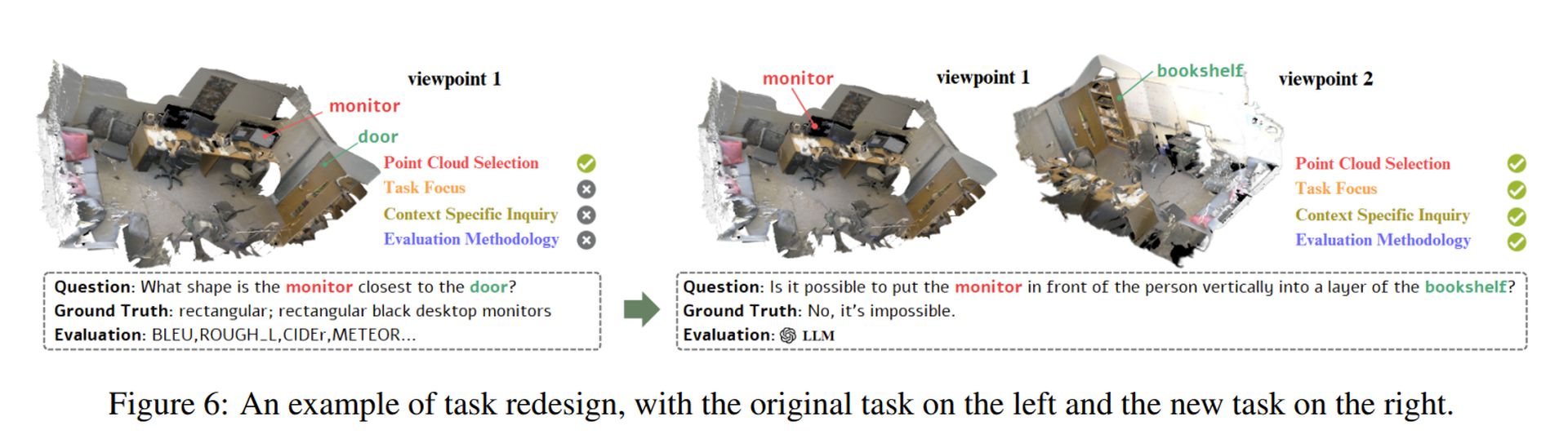

Les chercheurs ont démontré comment ces principes pouvaient être appliqués par repenser une tâche erronée (voir l’image ci-dessus). Leur approche garantit que les modèles d’IA doivent en fait Processus Structures 3D Plutôt que de compter sur les raccourcis 2D.

Crédit d’image en vedette: Sebastian Svenson / Unsplash