Les grands modèles de langue (LLM) deviennent plus intelligents, mais ils frappent également un mur: la manipulation de longs morceaux de texte est lent et coûteux en calcul. Les mécanismes d’attention traditionnels – le cœur de la façon dont l’IA traite et se souvient des informations – à l’échelle efficace, ce qui rend les modèles coûteux pour s’entraîner et courir.

Maintenant, des chercheurs de Université Deepseek-ai et de Pékin avoir présenté Une approche qui change la donne appelée Attention nativement clairsemée (NSA). Cette nouvelle méthode promet de faire des modèles d’IA significativement plus rapide, moins cher et plus efficacetout en maintenant le même niveau de capacité de raisonnement que les approches traditionnelles.

Pourquoi le problème d’attention de l’IA a besoin d’un correctif

Imaginez lire un livre où vous devez garder chaque phrase à l’esprit à tout moment – c’est ainsi que Pleine attention Les mécanismes fonctionnent dans l’IA. Ils numérisent et stockent des informations sur de longues séquences, mais à mesure que la longueur du contexte augmente (pensez à des milliers de mots), cette approche devient incroyablement lente et lourde par calcul.

Pour y remédier, les chercheurs ont exploré Attention clairsemée— Qui ne traite sélectivement que les informations les plus importantes au lieu de tout. Cependant, les méthodes clairsemées existantes ont faiblesses majeures:

- Ils sont difficiles à entraîner à partir de zéronécessitant souvent des modèles pour apprendre d’abord en toute attention avant de passer à une approche clairsemée.

- Ils n’optimisent pas complètement pour le matériel modernece qui signifie que les améliorations théoriques de la vitesse ne se traduisent pas toujours par l’efficacité du monde réel.

Comment la NSA change le jeu

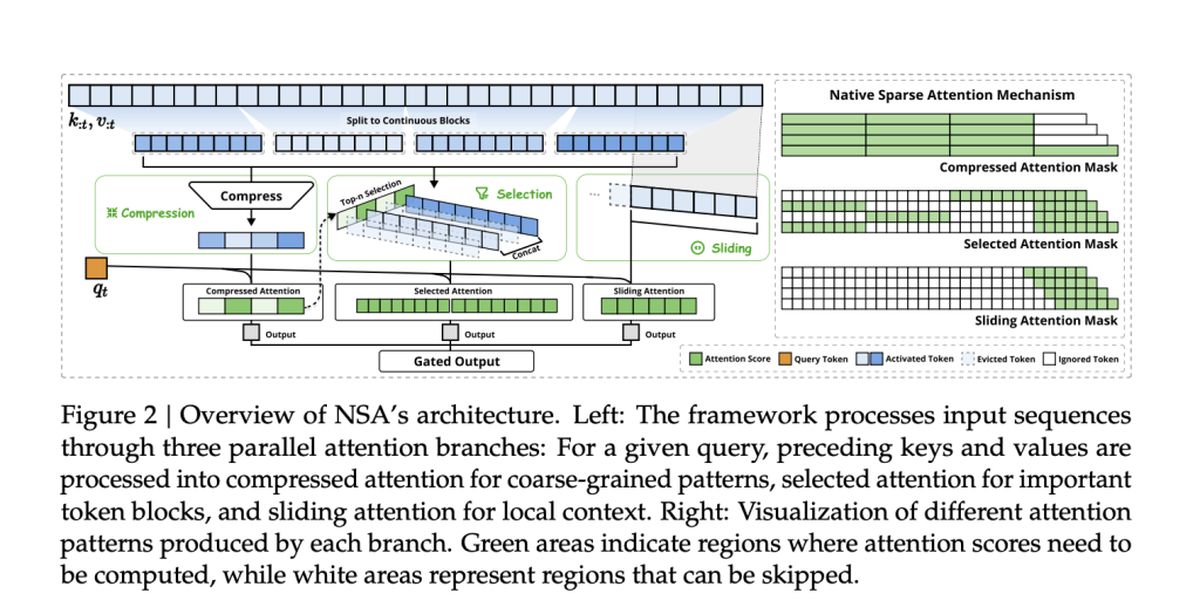

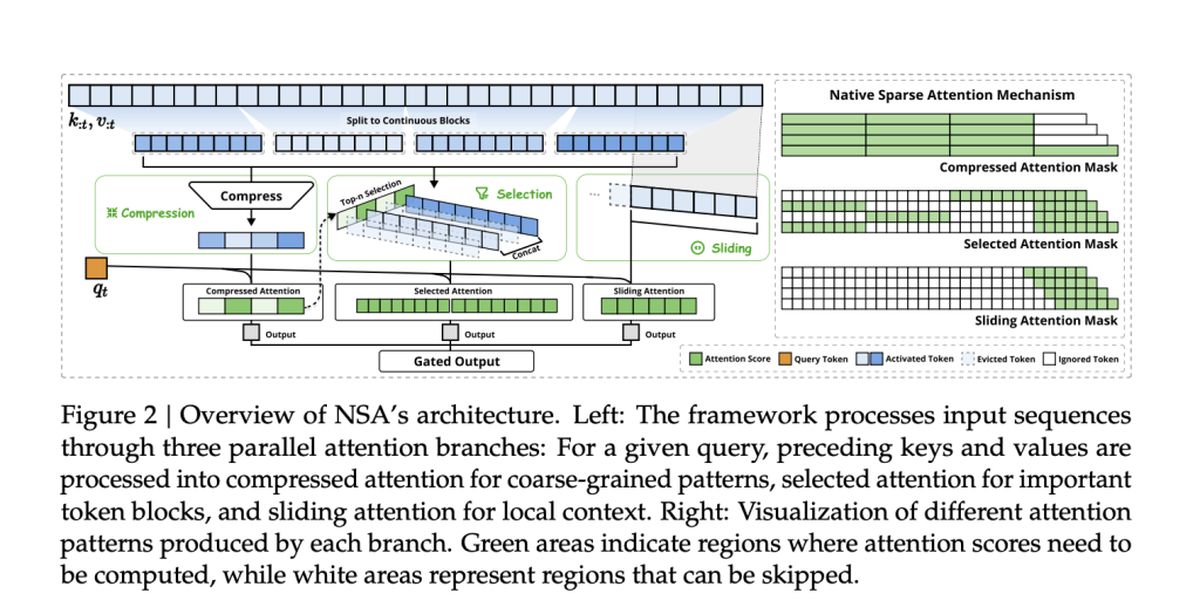

L’équipe derrière la NSA, dont Jingyang Yuan, Huazuo Gao, Damai Dai et leurs collègues, a adopté une nouvelle approche. Leur méthode intègre nativement la rareté dès le débutplutôt que de l’appliquer après coup.

La NSA y parvient avec Deux innovations clés:

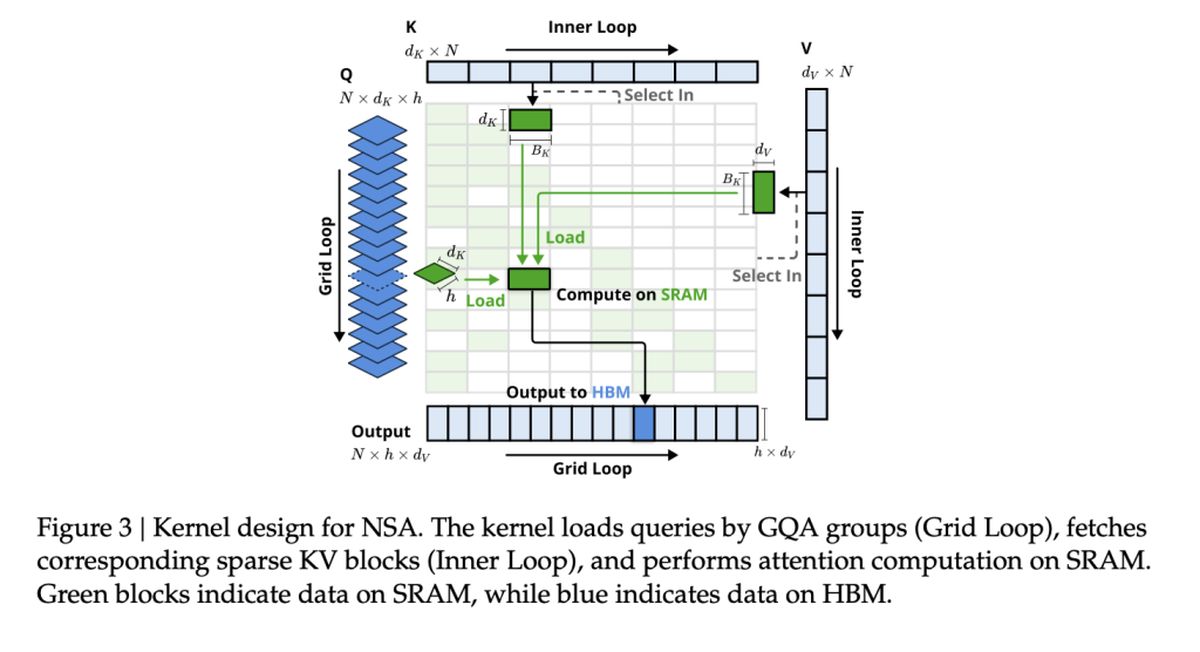

- Efficacité alignée sur le matériel: La NSA est conçue pour maximiser les performances du GPU, en évitant les goulots d’étranglement de mémoire et en garantissant des accéléreuses du monde réel.

- Entraînement de bout en bout: Contrairement aux méthodes clairsemées précédentes, la NSA est entièrement entraînable à partir de zéro, réduisant les coûts de formation sans perdre sa précision.

Vitesse et précision: l’avantage de la NSA

Alors, comment la NSA s’accumule-t-elle contre les modèles traditionnels de l’attention complète? Selon l’étude, La NSA atteint jusqu’à 11 × améliorations de vitesse tout en faisant la correspondance – ou même surperformant – une attention particulière sur les références clés.

Certaines des plus grandes victoires comprennent:

- Traitement plus rapide: NSA accélère la capacité de l’IA à gérer les documents longs, les bases de code et les conversations multi-tournées.

- Meilleur raisonnement: En dépit d’être «clairsemé», les modèles de la NSA faire correspondre ou dépasser Modèles d’attention complètes dans les tâches de raisonnement en chaîne.

- Réduire les coûts: En réduisant le calcul sans sacrifier les performances, la NSA pourrait rendre l’IA avancée plus abordable pour s’entraîner et déployer.

Méthodes d’attention clairsemées existantes

De nombreux mécanismes d’attention clairsemés existants tentent de réduire tokens d’élagage sélectif ou Optimisation de l’accès à la mémoire. Cependant, ils échouent souvent à la mise en œuvre pratique, soit parce qu’ils introduisent des composants non traçables ou ne parviennent pas à s’aligner sur les architectures GPU modernes.

Par exemple:

- Clusterkv et magicpig Comptez sur des techniques de regroupement ou de hachage discrètes, qui perturbent le flux de gradient et entravent l’entraînement du modèle.

- H2O et Minférence Appliquer la rareté uniquement pendant les stades spécifiques de l’inférence, limitant les améliorations de la vitesse à travers le pipeline complet.

- Quête et infllm Utilisez des méthodes de sélection en blocs, mais leur notation basée sur l’heuristique entraîne souvent des taux de rappel plus bas.

NSA aborde ces limites en intégrant la rativité nativement—Efficacité de l’intention de la formation et de l’inférence tout en préservant la précision du modèle. Cela signifie Aucune approximation post-hoc ou des compromis entre la vitesse et la capacité de raisonnement.

Les performances de la NSA sur les tâches du monde réel

Pour valider l’efficacité de la NSA, les chercheurs l’ont testé à travers une gamme de tâches d’IA, en comparant ses performances avec des modèles d’attention complets traditionnels et des méthodes d’attention clairsemées de pointe. Les résultats mettent en évidence la capacité de la NSA à faire correspondre ou dépasser les modèles d’attention complets tout en réduisant considérablement les coûts de calcul.

Performance générale de référence

La NSA a démontré Forte précision à travers les connaissances, le raisonnement et les références codantesy compris:

- MMLU & CMMLU: Correspondant à toute l’attention des tâches basées sur les connaissances

- GSM8K et mathématiques: Surpasser toute l’attention dans un raisonnement complexe

- Humaneval & MBPP: Offrir des performances de codage solide

Compréhension du contexte à long terme

NSA excelle à gérer les séquences de contexte long dans des repères comme Secouer. Dans les tâches nécessitant une mémoire contextuelle profonde, la NSA a maintenu:

- Rappel élevé dans les tâches de récupération (Aiguille dans un haystack, document QA)

- Précision stable dans le raisonnement multi-HOP (HPQ, 2Wiki, Govrpt)

Gains de vitesse du monde réel

Les optimisations alignées sur le matériel dans la NSA conduisent à:

- 9 × vitesses d’inférence plus rapides pour des séquences de longueur de 64 000

- 6 × efficacité d’entraînement plus rapide par rapport aux modèles d’attention complets

- Réduction de la consommation de bande passante de mémoirerendre les applications d’IA à grande échelle plus réalisables