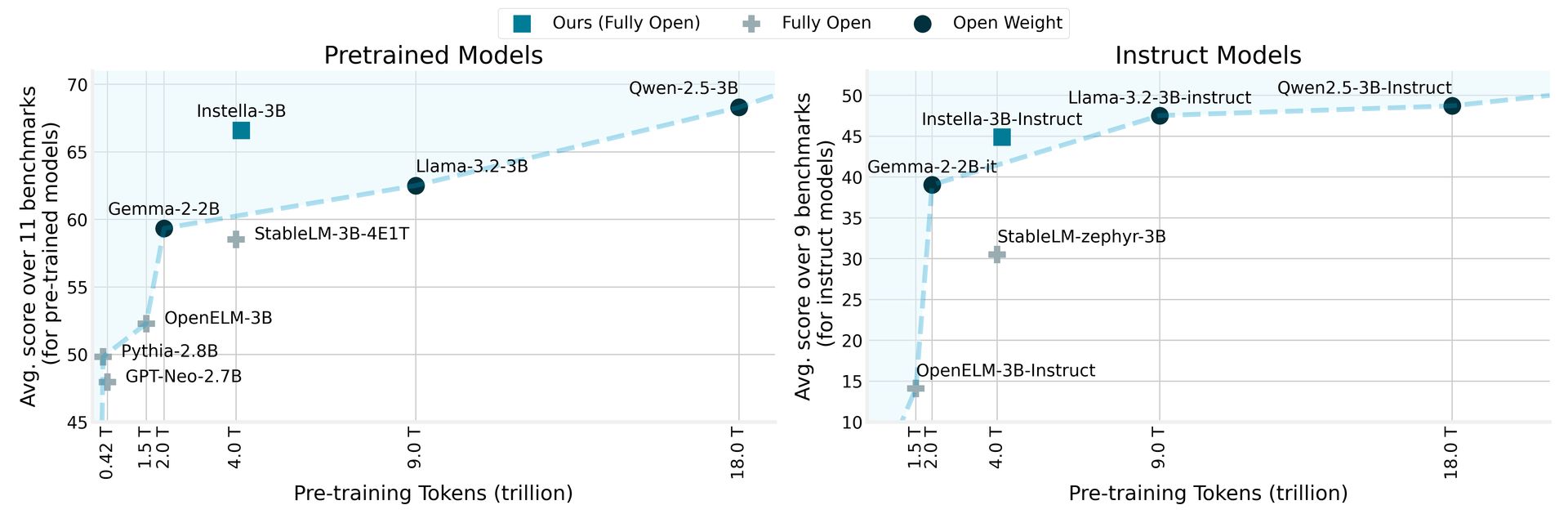

AMD a dévoilé Intella, une famille de modèles de langage entièrement open source avec 3 milliards de paramètres, formés à partir de zéro sur les GPU AMD Instinct ™ MI300X. Les modèles Intella surpassent les modèles ouverts existants de tailles similaires et rivalisent efficacement avec les principaux modèles de poids ouvert, y compris LLAMA-3.2-3B, GEMMA-2-2B et QWEN-2.5-3B, y compris leurs versions réglées par l’instruction.

AMD dévoile Intella: les modèles de langue open source surpassent les rivaux

Intella utilise une architecture de transformateur autorégressive composée de 36 couches de décodeur et 32 têtes d’attention, ce qui lui permet de traiter de longues séquences allant jusqu’à 4 096 jetons. Le modèle utilise un vocabulaire d’environ 50 000 jetons, gérés par le tokenizer Olmo, ce qui le rend apte à générer et à interpréter du texte dans divers domaines.

La procédure de formation pour Ingella met en évidence la collaboration entre les innovations matérielles et logicielles d’AMD. Ce nouveau modèle s’appuie sur les bases établies par les modèles précédents de 1 milliard de paramètres d’AMD, passant de l’entraînement sur 64 GPU Instinct Mi250 avec 1,3 billion de jetons à l’utilisation de 128 GPU Instinct Mi300X avec 4,15 billions de jetons pour le modèle actuel de 3 milliards de paramètres.

En comparant Intella aux modèles antérieurs, AMD rapporte qu’il dépasse non seulement les modèles entièrement ouverts existants, mais réalise également des performances concurrentielles avec des modèles de pointe ouverte de pointe, marquant une étape importante dans le domaine du traitement du langage naturel. Cette initiative s’aligne sur l’engagement d’AMD à rendre les technologies de pointe plus accessibles et favoriser la collaboration et l’innovation au sein de la communauté de l’IA.

Les prix AMD RX 9000 pourraient vous faire repenser cet achat RTX 5090

Phases du modèle Intella et données de formation

Cette version comprend plusieurs versions des modèles Intella, chacun représentant différentes étapes de formation:

| Modèle | Scène | Données de formation (jetons) | Description |

|---|---|---|---|

| Intella-3b-stage1 | Pré-formation (étape 1) | 4,065 billions | Première étape avant la formation pour développer la maîtrise du langage naturel. |

| Intella-3B | Pré-formation (étape 2) | 57,575 milliards | Pré-formation en deuxième étape pour améliorer les capacités de résolution de problèmes. |

| Intella-3B-SFT | SFT | 8,902 milliards (x3 époques) | Le réglage fin supervisé (SFT) pour permettre les capacités de suivi des instructions. |

| Instruct Intella-3B | DPO | 760 millions | Alignement sur les préférences humaines et l’amélioration des capacités de chat avec l’optimisation directe des préférences (DPO). |

Dans le pipeline de formation en plusieurs étapes, la première étape de pré-formation a utilisé 4,065 billions de jetons à partir de divers ensembles de données, établissant une compréhension des langues fondamentales. La formation ultérieure sur 57,575 milliards de jetons supplémentaires a encore amélioré les performances du modèle à travers des tâches et des domaines variés.

Pendant le réglage fin supervisé, Intella-3B-SFT a été formé avec 8,9 milliards de jetons, améliorant les capacités de réponse interactive. La dernière étape, Instructe Intella-3B, a suivi une formation d’alignement avec une optimisation directe de préférence en utilisant 0,76 milliard de jetons, garantissant que les résultats du modèle sont alignés sur les valeurs et les préférences humaines.

AMD a créé tous les artefacts associés aux modèles Intella entièrement open-source, y compris les poids des modèles, les configurations de formation, les ensembles de données et le code, favorisant la collaboration et l’innovation dans la communauté d’IA. Ces ressources sont accessibles via Visage étreint cartes modèles et Github référentiels.

Crédit d’image en vedette: DMLA