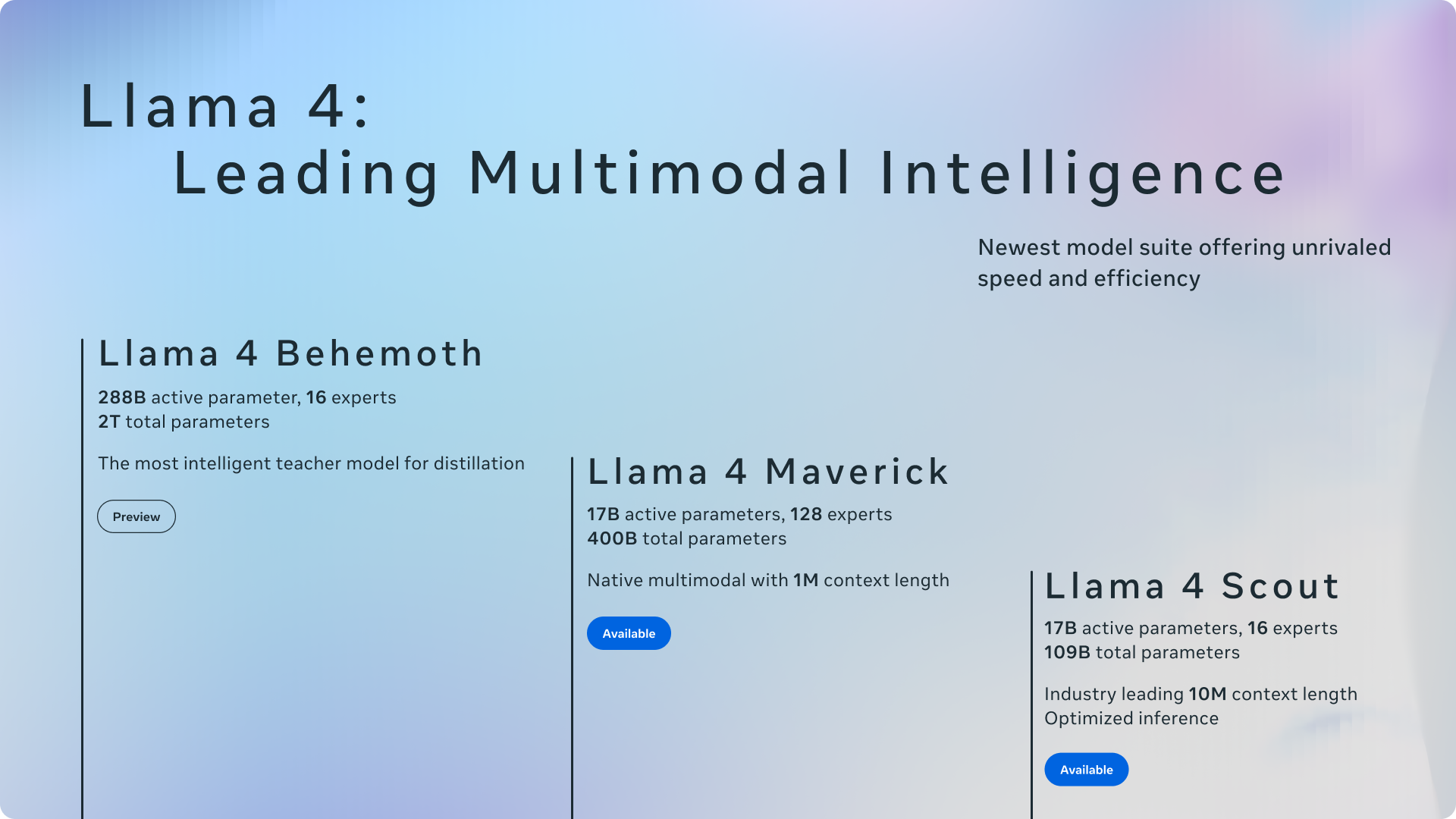

Meta a annoncé officiellement Sa suite la plus avancée de modèles d’intelligence artificielle à ce jour: la famille Llama 4. Cette nouvelle génération comprend Llama 4 Scout et Llama 4 Maverick, la première des modèles de poids ouvert de Meta à offrir une multimodalité native et un support de longueur de contexte sans précédent. Ces modèles marquent également l’incursion initiale de Meta dans l’utilisation d’une architecture de mélange d’Experts (MOE). Meta a également fourni un aperçu de Llama 4 Behemoth, un LLM très intelligent actuellement en formation, conçu pour servir d’enseignant pour les futurs modèles.

Cette mise à jour importante de l’écosystème de lama arrive environ un an après la sortie de Llama 3 en 2024souligner l’engagement de Meta à ouvrir l’innovation dans l’espace d’IA. Selon Meta, rendre les principaux modèles disponibles ouvertement est crucial pour favoriser le développement d’expériences personnalisées.

Scout et Maverick: modèles multimodaux avec une architecture innovante

Llama 4 Scout et Llama 4 Maverick sont les modèles efficaces initiaux de cette série. LLAMA 4 Scout possède 17 milliards de paramètres actifs dans 16 experts, tandis que Llama 4 Maverick propose également 17 milliards de paramètres actifs mais exploite un plus grand pool de 128 experts au sein de son architecture MOE. Meta met en évidence l’efficacité de cette conception, notant que Llama 4 Scout peut s’adapter sur un seul GPU H100 (avec quantification INT4) et LLAMA 4 Maverick sur un seul hôte H100, facilitant un déploiement plus facile.

L’adoption d’une architecture de mélange des experts (MOE) est un progrès clé. Dans les modèles MOE, seule une fraction des paramètres totaux est activée pour chaque jeton, conduisant à une formation et une inférence plus économes en calcul, offrant finalement une qualité supérieure pour un budget de calcul donné. Par exemple, Llama 4 Maverick a 400 milliards de paramètres au total, mais seulement 17 milliards sont actifs pendant l’utilisation.

Le Llama 4 Scout et Llama 4 Maverick sont multimodaux nativement, incorporant une fusion précoce pour traiter de manière transparente du texte et des jetons de vision dans une squelette unifiée du modèle. Cela permet une pré-formation conjointe sur de grandes quantités de données de texte, d’image et de vidéo non marquées. Meta a également amélioré l’encodeur de vision dans LLAMA 4, s’appuyant sur Metaclip mais l’entraîne séparément aux côtés d’un modèle de lama gelé pour une meilleure adaptation.

LLAMA 4 Behemoth: un modèle d’enseignant avec des repères prometteurs

Meta a fourni un aperçu du géant de Llama 4, un modèle axé sur les enseignants avec 288 milliards de paramètres actifs stupéfiants et près de deux billions de paramètres au total chez 16 experts. Meta affirme que Behemoth surpasse les principaux modèles comme GPT-4.5, Claude Sonnet 3.7, et Gemini 2.0 Pro Sur les références axées sur les STEM telles que Math-500 et GPQA Diamond. Alors que le géant de Llama 4 est toujours en formation et n’est pas encore disponible, il a joué un rôle crucial dans le «codistoulage» du modèle LLAMA 4 Maverick, conduisant à des améliorations de qualité importantes.

Longueur de contexte et capacités multilingues

Une caractéristique remarquable des modèles LLAMA 4 est leur longueur de contexte considérablement accrue. LLAMA 4 Scout mène l’industrie avec une fenêtre de contexte d’entrée de 10 millions de jetons, une augmentation spectaculaire par rapport à la 128K de Llama 3. Ce contexte étendu permet des capacités avancées comme le résumé multi-documents et le raisonnement par rapport aux grandes bases de code. Les deux modèles ont été formés sur un ensemble de données massif dépassant 30 billions de jetons, plus du double de celui de Llama 3, et englobant plus de 200 langues, avec plus de 100 langues ayant plus d’un milliard de jetons chacun.

Intégration dans les meta applications et la disponibilité des développeurs

Reflétant l’engagement de Meta à ouvrir l’innovation, LLAMA 4 Scout et Llama 4 Maverick sont disponibles en téléchargement aujourd’hui sur llama.com et étreignant le visage. Meta a également annoncé que ces modèles alimentent désormais Meta Ai dans des applications populaires comme WhatsApp, Messenger, Instagram Direct et sur le site Web Meta.ai. Cette intégration permet aux utilisateurs de découvrir directement les capacités des nouveaux modèles Llama 4.

Meta a souligné son engagement à développer des modèles d’IA utiles et sûrs. LLAMA 4 intègre les meilleures pratiques décrites dans leur guide d’utilisation des développeurs de protections d’IA, y compris les atténuations à divers stades de développement. Ils ont également mis en évidence des garanties open source comme Llama Guard et Prompt Guard pour aider les développeurs à identifier et à prévenir les entrées et les sorties nocives.

S’adressant à la question bien connue du biais dans les LLM, Meta a déclaré que des améliorations significatives ont été apportées dans LLAMA 4. Le modèle refuse moins d’invites sur des sujets politiques et sociaux débattus et démontre une réponse plus équilibrée entre différents points de vue, montrant des performances comparables à Grok dans ce domaine.