Selon une nouvelle étude intitulée « Feabench: Évaluation des modèles de langue sur la capacité de raisonnement multiphysique« Par des chercheurs de Google et de Harvard, les modèles de grands langues peuvent parler d’un grand jeu, mais en ce qui concerne l’ingénierie du monde réel, la plupart ne peuvent même pas exécuter une simulation de chaleur correctement.

Ce nouveau référence, surnommé Faillitene teste pas les modèles sur la génération de code ou les problèmes de physique des manuels. Il les met au défi de résoudre des tâches d’ingénierie complexes basées sur la simulation en utilisant COMSOL Multiphysicsune plate-forme d’analyse des éléments finis de qualité professionnelle (FEA). En d’autres termes, il demande: votre assistant AI préféré peut-il construire un faisceau virtuel, appliquer la bonne physique et calculer ce qui se passe ensuite?

Pourquoi la simulation bat le spitball

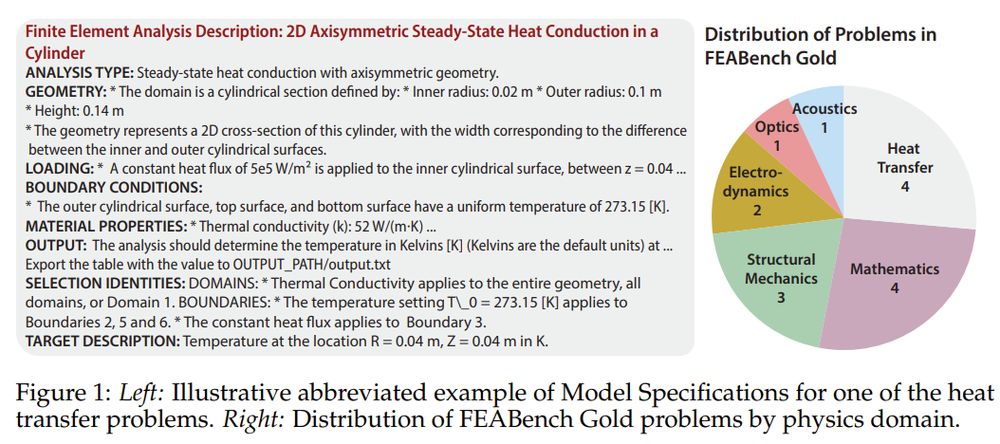

FEA ne concerne pas les approximations. Il s’agit de traduire la réalité physique en précision numérique: modéliser la façon dont la chaleur se propage dans un semi-conducteur, comment un faisceau fléchit sous pression, comment la défaillance du matériau se propage. Ce sont des questions qui définissent le succès de l’ingénierie ou la catastrophe. Contrairement aux références génériques, Feabench augmente la barre: il exige la raison des modèles d’IA à travers la physique multi-domaines et les outils de simulation de qualité professionnelle pour résoudre réellement des problèmes.

Compamer le non-benchmarkable

Feabench comble une lacune que les repères d’IA existants manquent. Les travaux antérieurs ont largement mesuré les performances en mathématiques symboliques ou en génération de code, mais la science basée sur la simulation nécessite plus que la syntaxe. Il a besoin d’une compréhension sémantique de la géométrie spatiale, des interactions matérielles et des solveurs numériques. Feabench fait cela en évaluant si les LLM peuvent prendre un problème de physique du langage naturel, générer des appels API COMSOL Multiphysics® et calculer le résultat correct.

La référence est disponible en deux niveaux. Or feabench Comprend 15 problèmes méticuleusement vérifiés avec des entrées propres, des cibles clairement définies et des valeurs de sortie correctes – chacune résoluble via l’API Java de Comsol. Ceux-ci impliquent des domaines de physique du transfert de chaleur à la mécanique quantique. Ensuite, il y a Feabench grand: Un ensemble de 200 tutoriels analysés algorithmiques qui testent la génération de code plus large mais manquent de vérité stricte. Gold teste la précision; GRANDS TESTS LA LAGNE.

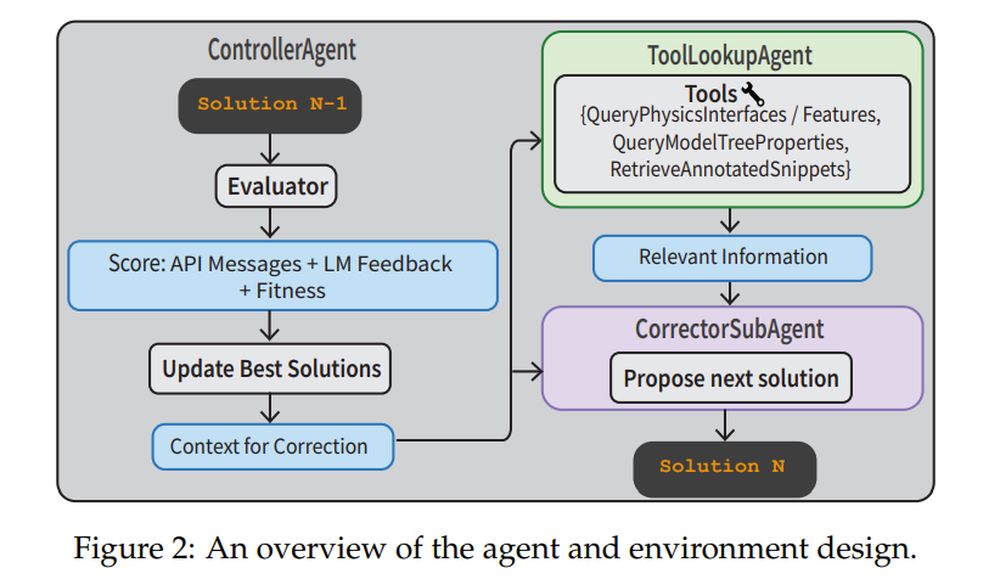

Pour lutter contre ces tâches, les chercheurs ont construit un pipeline agentique complet. UN Contrôlerager supervise le processus. UN Correctorsubagent affine itérativement le code en fonction des erreurs d’exécution. UN Toollookupgent Rechet la documentation physique ou les extraits de code annotés pour vous aider. Le Évaluateur Utilise à la fois la rétroaction de l’API et un Verifierllm pour évaluer si la solution est logique. Ce système n’exécute pas seulement des invites à un coup – elle navigue, la corrige et l’apprentissage des erreurs.

Les poids fermés gagnent, mais transpirent toujours

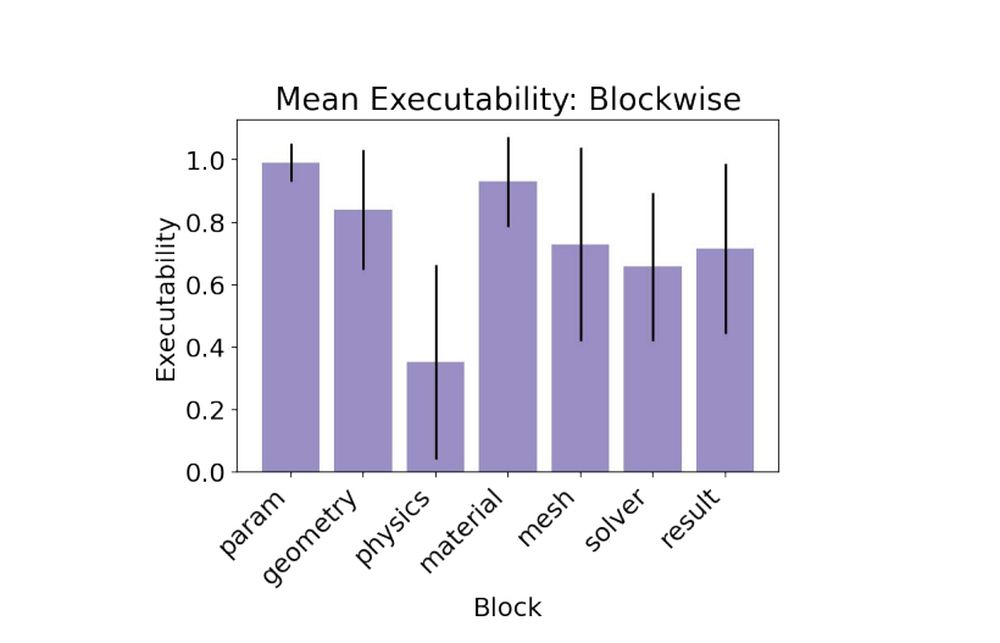

Dans les essais de base, des modèles de source fermée comme Claude 3.5, GPT-4O et Gemini 1.5 ont surpassé les modèles de poids ouvert. Claude 3.5 a mené le pack, atteignant 79% d’exécutabilité et marquant la seule cible valide sur un problème d’or. Les modèles ouverts ont lutté, avec des interfaces de physique hallucinantes ou des caractéristiques erronées. La partie la plus difficile? Le bloc de physiqueoù les modèles devaient appliquer des conditions aux limites précises et des propriétés de physique pour obtenir des résultats qui correspondaient à la vérité au sol.

- Claude 3.5 Sonnet: 0,79 exécutabilité, 1/15 cible valide

- GPT-4O: 0,78 exécutabilité, 0/15 cible valide

- Gemini-1.5-pro: 0,60 exécutabilité, 0/15 cible valide

Quand un plan ne suffit pas

La référence comprend deux types de tâches. Dans le Modèles pecs Tâche, le LLM ne reçoit que les spécifications techniques et doit raisonner une solution. Dans le Plan Tâche, le modèle obtient des instructions étape par étape. Étonnamment, la tâche du plan n’a pas conduit à de meilleures performances. Les modèles ont souvent échoué en prenant des instructions trop littéralement et en hallucinant les noms d’API incorrects. L’ajout d’une liste de fonctionnalités corsol valides à l’invite – a appelé le Phydoc dans le contexte Stratégie – a permis de réduire considérablement les hallucinations et une amélioration de la factualité d’interface.

Leçons pour les ingénieurs de l’IA

Un gros point à retenir: la traduction est plus difficile que la planification. Même lorsque le modèle sait quoi faire, l’exprimer dans le DSL de Comsol (langue spécifique au domaine) est le barrage routier. La solution de l’équipe? Fournissez des outils de mise à la terre comme les bibliothèques de code annotées et la documentation en contexte, puis la jumelez avec des workflows agentiques structurés. Cette recette a transformé de mauvaises performances à un coup en amélioration robuste multi-tour. En fait, la stratégie de l’agent multi-tours a atteint 88% d’exécutabilitéla plus élevée de toutes les expériences.

- Agent ModelsPecs + Multi-tour: 0,88 exécutabilité, 2/15 cibles valides

- ModelsPecs + Phydoc: 0,62 exécutabilité, 1/15 cibles valides

Les simulations sont la façon dont les ingénieurs compressent le temps et le risque. Feabench montre que les LLM ne sont pas prêts à exécuter des simulations sans surveillance, mais ils se rapprochent de devenir des copilotes utiles. Cela compte si nous voulons que l’IA aide à un prototypage rapide, à une découverte scientifique ou à une conception structurelle. Et si l’IA peut apprendre à modéliser le monde physique aussi précisément qu’il imite le langage, il ne discutera pas seulement – il simulera, résoudra, et peut-être un jour, même inventer.