Les chercheurs en semences de Bytedance ont déployé la valeur de la valeur augmentée de la politique proximale (VAPO), un cadre de formation d’apprentissage en renforcement conçu pour affiner le raisonnement des modèles de grande langue sur des tâches complexes et longues, obtenant de nouveaux résultats de pointe sur la référence AIME24.

Formation LLMS pour un raisonnement complexe en utilisant l’apprentissage par renforcement basé sur la valeur auparavant confronté à des obstacles importants. Les méthodes ont lutté avec le biais du modèle de valeur, l’adaptation efficace aux séquences de réponse de longueurs très variables et la gestion des signaux de récompense clairsemés, en particulier dans les tâches basées sur les vérificateurs ne fournissant que des commentaires binaires.

VAPO relève ces défis grâce à trois innovations de base: un cadre de formation basé sur la valeur détaillée, un mécanisme d’estimation généralisée de la longueur d’estimation des avantages généralisés (GAE) ajusté les paramètres basés sur la longueur de la réponse et l’intégration systématique des techniques à partir de recherches antérieures.

Cette combinaison crée un système où les améliorations fonctionnent en synergie. En utilisant le modèle QWEN2.5-32B sans données SFT spécifiques, VAPO a amélioré les scores de référence de 5 à 60, dépassant les méthodes antérieures de pointe de 10 points.

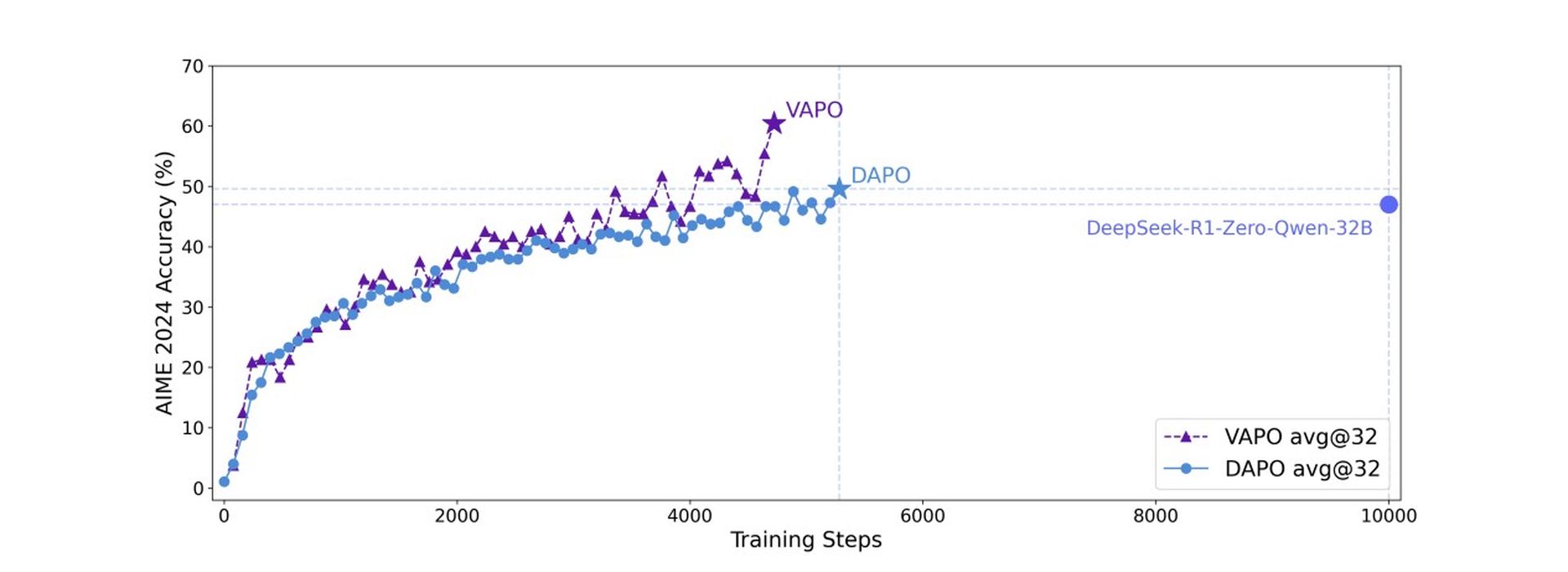

VAPO s’appuie sur l’algorithme d’optimisation de la politique proximale (PPO) mais intègre des modifications clés pour améliorer le raisonnement mathématique. L’analyse de la formation a révélé que VAPO présente des courbes de formation plus lisses par rapport à la méthode DAPO sans valeur, indiquant une optimisation plus stable.

Vapo a également démontré une meilleure mise à l’échelle de longueur pour une généralisation améliorée, une croissance plus rapide du score attribuable aux signaux granulaires de son modèle de valeur et une entropie inférieure aux étapes de formation ultérieures. Bien que l’entropie réduite puisse potentiellement limiter l’exploration, la méthode équilibre effectivement cela, améliorant la reproductibilité et la stabilité avec un impact sur les performances minimales.

Sur la référence AIME24, Deepseek R1 en utilisant GRPO a atteint 47 points et Dapo a atteint 50 points. Vapo, en utilisant le modèle QWEN-32B, a fait correspondre les performances de DAPO avec seulement 60% des étapes de mise à jour et définir un nouveau score de pointe de 60,4 dans les 5 000 étapes. En revanche, la vanille PPO n’a marqué que 5 points en raison de l’effondrement de l’apprentissage du modèle de valeur.

Cette référence demande si l’IA peut penser comme un ingénieur

Des études d’ablation ont confirmé l’efficacité de sept modifications distinctes au sein du vapo. Le prélèvement de valeur empêche l’effondrement du modèle; Le GAE découplé permet une optimisation complète des longues réponses; Boulances de GAE adaptatives à l’optimisation de la réponse courte et longue; Clip plus élevé encourage une exploration approfondie; La perte au niveau des jetons augmente la pondération pour les longues réponses; L’incorporation de la perte de LM à l’exemple positif a ajouté 6 points; Et l’échantillonnage de groupe a contribué 5 points au score final.

Chercheurs souligner Le vapo, en utilisant le modèle QWEN2.5-32b, démontre que cette approche basée sur la valeur peut surpasser de manière décisive des méthodes sans valeur telles que GRPO et DAPO, établissant un nouveau niveau de performance pour des tâches de raisonnement complexes et relever des défis fondamentaux dans les modèles de valeur de formation pour les scénarios à longue chaîne de chaîne.