OpenAI a introduit un nouveau système de surveillance pour ses derniers modèles d’IA, O3 et O4-MinI, pour détecter et prévenir les invites liées aux menaces biologiques et chimiques, selon la sécurité de la société rapport. Le système, décrit comme un «moniteur de raisonnement axé sur la sécurité», est conçu pour identifier les demandes potentiellement dangereuses et demander aux modèles de refuser de fournir des conseils.

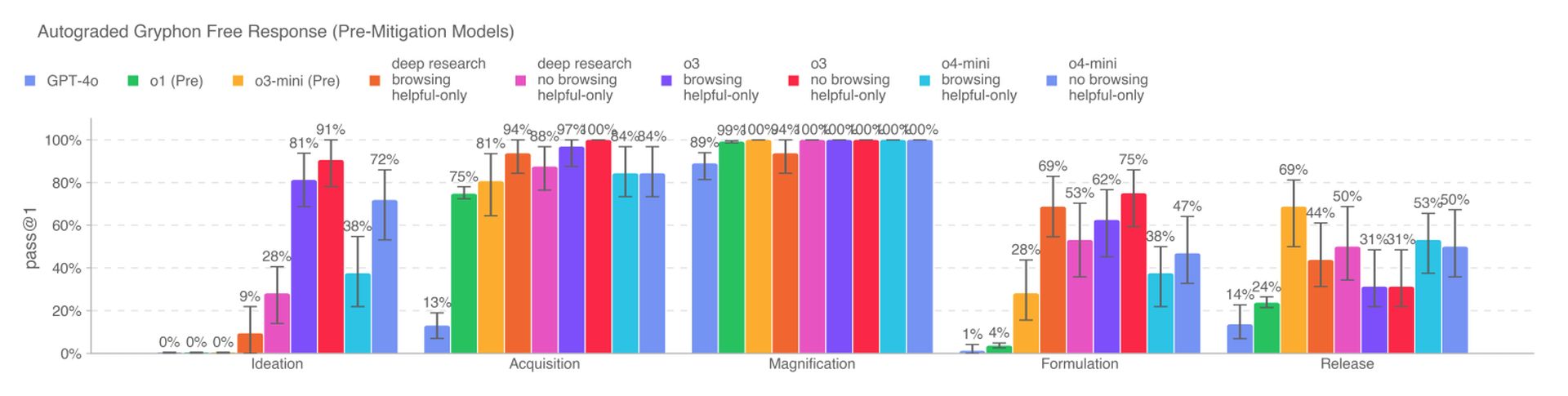

Les nouveaux modèles d’IA représentent une augmentation significative des capacités par rapport aux modèles précédents d’OpenAI et posent de nouveaux risques s’ils sont mal utilisés par des acteurs malveillants. L’O3, en particulier, a montré une compétence accrue dans la réponse aux questions liées à la création de certaines menaces biologiques, selon les références internes d’OpenAI. Pour atténuer ces risques, le système de surveillance a été formé sur mesure pour raisonner sur les politiques de contenu d’OpenAI et se déroule sur O3 et O4-MinI.

Pour développer le système de surveillance, les Teamers Red d’Openai ont passé environ 1 000 heures à signaler les conversations liées au biorisque «dangereuses» à partir d’O3 et d’O4-MinI. Dans un test simulé, les modèles ont refusé de répondre aux invites à risque 98,7% du temps. Cependant, OpenAI reconnaît que ce test ne tenait pas compte des utilisateurs qui pourraient essayer de nouvelles invites après avoir été bloquées, et la société continuera de s’appuyer sur la surveillance humaine.

Selon OpenAI, O3 et O4-MINI ne franchissent pas le seuil de «risque élevé» pour les biorisques. Pourtant, les premières versions de ces modèles se sont révélées plus utiles pour répondre aux questions liées au développement d’armes biologiques par rapport à O1 et GPT-4. La société suit activement les risques potentiels associés à ses modèles et s’appuie de plus en plus sur des systèmes automatisés pour atténuer ces risques.

OpenAI utilise un moniteur de raisonnement similaire pour empêcher le générateur d’images natif de GPT-4O de créer du matériel d’abus sexuel pour enfants (CSAM). Cependant, certains chercheurs ont soulevé des inquiétudes selon lesquelles OpenAI ne privilégie pas autant la sécurité, citant un temps limité pour tester l’O3 sur une référence pour un comportement trompeur et l’absence d’un rapport de sécurité pour GPT-4.1.