Imaginez un modèle de reconnaissance vocale qui non seulement comprend plusieurs langues, mais qui les traduit et les identifie également de manière transparente. Whisper v3 est l’incarnation de cette vision. Ce n’est pas seulement un modèle ; c’est une force dynamique qui remodèle les limites de la compréhension des données audio.

La capacité de transcrire, traduire et identifier les langues dans les mots parlés est depuis longtemps le Saint Graal de la technologie et OpenAI vient de le changer.

La révolution audio aux multiples facettes de Whisper v3

Whisper v3 est un modèle de reconnaissance vocale très avancé et polyvalent développé par OpenAI. Il fait partie de la famille de modèles Whisper et apporte des améliorations et des capacités significatives. Entrons dans les détails de Whisper v3 :

- Modèle de reconnaissance vocale à usage général: Whisper v3, comme ses prédécesseurs, est un modèle de reconnaissance vocale à usage général. Il est conçu pour transcrire le langage parlé en texte, ce qui en fait un outil inestimable pour un large éventail d’applications, notamment les services de transcription, les assistants vocaux, etc.

- Capacités multitâches: L’une des fonctionnalités remarquables de Whisper v3 est ses capacités multitâches. Il peut effectuer diverses tâches liées à la parole, notamment :

- Reconnaissance vocale multilingue: Whisper v3 peut reconnaître la parole dans plusieurs langues, ce qui le rend adapté à divers contextes linguistiques.

- Traduction vocale: Il peut non seulement transcrire la parole mais aussi la traduire dans différentes langues.

- Identification de la langue: Le modèle a la capacité d’identifier la langue parlée dans l’audio fourni.

- Détection d’activité vocale: Whisper v3 peut déterminer quand la parole est présente dans les données audio, ce qui le rend utile pour des applications telles que la détection de commandes vocales dans les assistants vocaux.

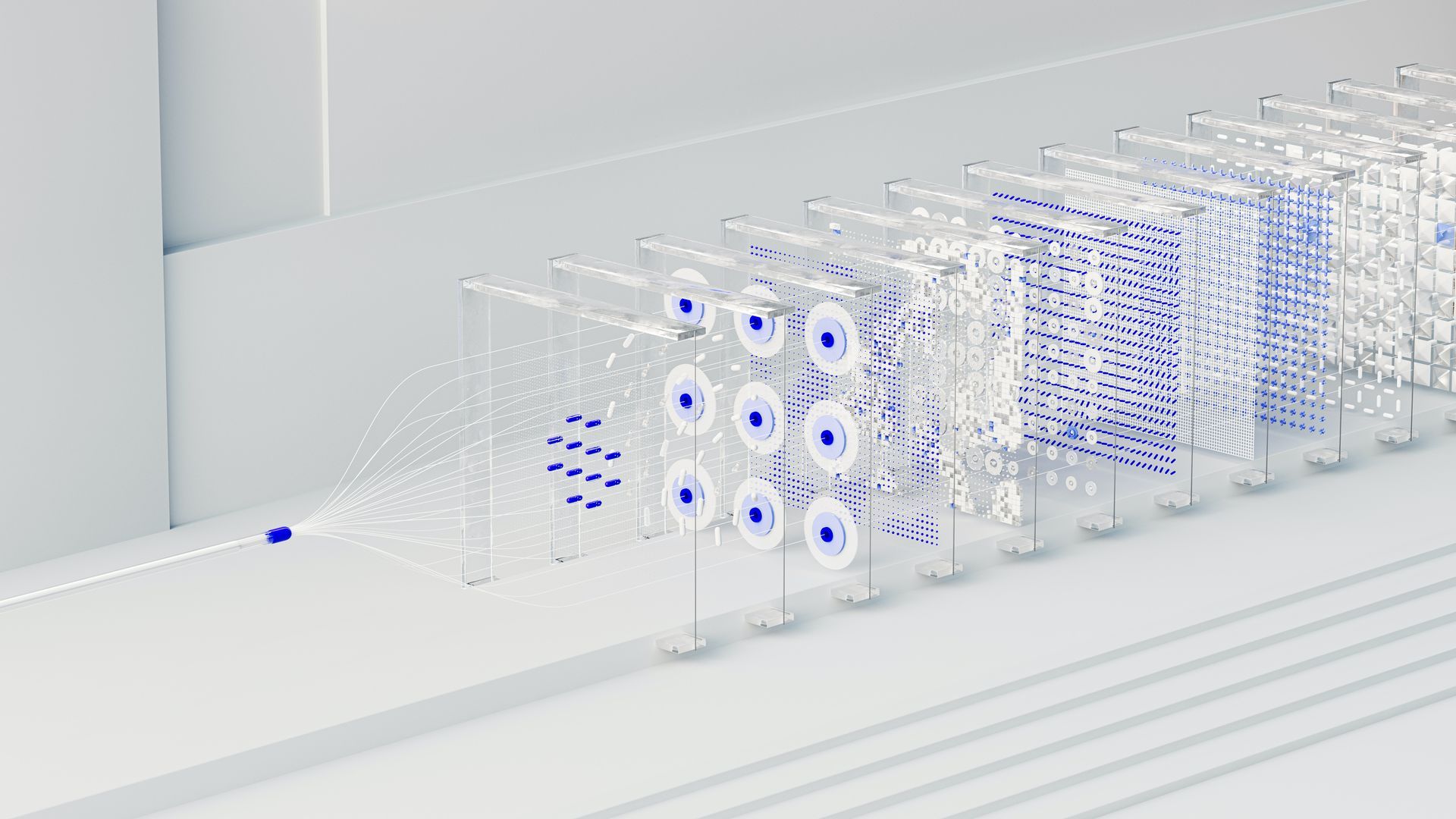

Whisper v3 est construit sur un modèle séquence à séquence Transformer de pointe. Dans ce modèle, une séquence de jetons représentant les données audio est traitée et décodée pour produire la sortie souhaitée. Cette architecture permet à Whisper v3 de remplacer plusieurs étapes d’un pipeline de traitement vocal traditionnel, simplifiant ainsi le processus global.

Pour effectuer diverses tâches, la v3 utilise des jetons spéciaux qui servent de spécificateurs de tâches ou de cibles de classification. Ces jetons guident le modèle dans la compréhension de la tâche spécifique qu’il doit effectuer.

Résumé de la journée de développement OpenAI: ChatGPT s’intégrera davantage dans la vie quotidienne

Modèles et langues disponibles

Whisper v3 propose une gamme de tailles de modèles, quatre d’entre eux ayant des versions uniquement en anglais. Ces modèles diffèrent en termes de compromis entre vitesse et précision. Les modèles disponibles, leurs besoins approximatifs en mémoire et leurs vitesses d’inférence relatives par rapport au grand modèle sont les suivants :

- Minuscule: 39 millions de paramètres, ~32x plus rapide que le grand modèle, et nécessite environ 1 Go de VRAM.

- Base: 74 millions de paramètres, ~16 fois plus rapide, et nécessite également environ 1 Go de VRAM.

- Petit: 244 millions de paramètres, ~6x plus rapide et nécessite environ 2 Go de VRAM.

- Moyen: 769 millions de paramètres, ~2x plus rapide et nécessite environ 5 Go de VRAM.

- Grand: 1550 millions de paramètres, qui sert de base, et nécessite environ 10 Go de VRAM.

Les modèles uniquement en anglais, en particulier le tiny.en et base.en versions, ont tendance à fonctionner mieux, la différence devenant moins significative à mesure que vous passez à la small.en et medium.en des modèles.

Les performances de Whisper v3 peuvent varier considérablement en fonction de la langue transcrite ou traduite. Les taux d’erreur sur les mots (WER) et les taux d’erreur sur les caractères (CER) sont utilisés pour évaluer les performances sur différents ensembles de données. Les performances du modèle sont détaillées dans les chiffres et les mesures fournis, offrant un aperçu de la façon dont il gère diverses langues et tâches.

Comment utiliser Whisper v3

Pour utiliser Whisper v3 efficacement, il est important de configurer l’environnement nécessaire. Le modèle a été développé à l’aide de Python 3.9.9 et PyTorch 1.10.1. Cependant, il devrait être compatible avec une gamme de versions de Python, de la 3.8 à la 3.11, ainsi qu’avec les versions récentes de PyTorch.

De plus, il s’appuie sur divers packages Python, notamment le tiktoken d’OpenAI pour une tokenisation efficace. L’installation de Whisper v3 peut être effectuée à l’aide des commandes pip fournies. Il est important de noter que la configuration du modèle nécessite également l’installation de ffmpeg, un outil de ligne de commande utilisé pour le traitement audio. Selon le système d’exploitation, différents gestionnaires de packages peuvent être utilisés pour l’installer.

Pour des informations plus détaillées, cliquez sur ici.

Conclusion

Whisper v3 est un modèle de reconnaissance vocale polyvalent d’OpenAI. Il offre une reconnaissance vocale multilingue, une traduction, une identification de la langue et une détection de l’activité vocale. Construit sur un modèle Transformer, il simplifie le traitement audio. Whisper v3 est compatible avec différentes versions de Python, a différentes tailles de modèle et est accessible via les interfaces de ligne de commande et Python. Publié sous licence MIT, il encourage l’innovation et permet aux utilisateurs d’extraire des connaissances du langage parlé, en transcendant les barrières linguistiques.

Crédit image en vedette : Andrew Neel/Pexels