Vous souvenez-vous de l’époque où le barde de Google, désormais appelé Gémeaux, je n’ai pas pu répondre à une question sur le télescope spatial James Webb dans sa publicité de lancement ? Laissez-moi vous rafraîchir la mémoire à propos de cette célèbre affaire : c’est l’un des plus grands exemples d’hallucinations de l’IA que nous ayons vu.

Qu’est-ce qui s’est passé ? Au cours de la publicité, la démo de Google Bard a été interrogée : « Quelles nouvelles découvertes du télescope spatial James Webb puis-je partager avec mon enfant de 9 ans ? » Après une brève pause, la démo de Google Bard a donné deux réponses correctes. Cependant, sa réponse finale était incorrecte. Selon la démo de Google Bard, le télescope avait capturé les premières images d’une planète en dehors de notre système solaire. Mais en réalité, le Very Large Telescope de l’Observatoire européen austral avait déjà pris des images de ces « exoplanètes », conservées dans les archives de la NASA.

Je ne veux pas être un imbécile ~en fait, en fait~, et je suis sûr que Bard sera impressionnant, mais pour mémoire : JWST n’a pas pris "la toute première image d’une planète en dehors de notre système solaire".

la première image a plutôt été réalisée par Chauvin et al. (2004) avec le VLT/NACO utilisant l’optique adaptative. https://t.co/bSBb5TOeUW pic.twitter.com/KnrZ1SSz7h

—Grant Tremblay (@astrogrant) 7 février 2023

Pourquoi les géants de la technologie comme Google ne peuvent-ils même pas empêcher de telles erreurs ? Découvrons-le!

Qu’est-ce qu’une hallucination IA ?

Une hallucination de l’IA se produit lorsqu’un programme informatique, généralement alimenté par l’intelligence artificielle (IA), produit des résultats incorrects, absurdes ou trompeurs. Ce terme est souvent utilisé pour décrire des situations dans lesquelles les modèles d’IA génèrent des réponses complètement erronées ou sans rapport avec les informations qui leur ont été fournies. C’est comme poser une question et obtenir une réponse qui n’a aucun sens ou qui n’est pas du tout celle à laquelle vous vous attendiez.

Comprendre pourquoi les hallucinations de l’IA se produit, regardons comment fonctionne l’IA. Les modèles d’IA, tels que les chatbots ou les systèmes de reconnaissance d’images, sont formés sur de grands ensembles de données pour apprendre des modèles et faire des prédictions. Cependant, si les données d’entraînement sont erronées, incomplètes ou biaisées, le modèle d’IA peut apprendre des modèles ou des associations incorrectes. Cela peut conduire à des résultats hallucinés où l’IA génère des réponses basées sur des informations erronées ou mal comprises. Et cela arrive souvent même si vous ne le remarquez peut-être pas.

Les hallucinations de l’IA peuvent se manifester sous diverses formes, chacune mettant en évidence différents défis et subtilités au sein des systèmes d’intelligence artificielle. Voici quelques types courants d’hallucinations IA :

- Phrase AI hallucination :

- Dans ce scénario, le modèle d’IA génère une phrase qui entre en conflit avec une déclaration précédente dans le même contexte. Par exemple:

- Invite : « Décrivez le parcours d’un personnage en phrases de trois mots. »

- Sortie : « Elle marchait lentement. Soudain, elle a couru. Ensuite, elle a marché.

- Dans ce scénario, le modèle d’IA génère une phrase qui entre en conflit avec une déclaration précédente dans le même contexte. Par exemple:

La dernière phrase contredit l’action précédente de courir, perturbant la cohérence du récit.

- Hallucination rapide de l’IA :

- Ce type se produit lorsque la réponse générée par l’IA entre en conflit avec l’invite ou la requête prévue. Par exemple:

- Invite : « Écrivez une recette de gâteau au chocolat. »

- Résultat : « Voici un poème sur les étoiles. »

- Ce type se produit lorsque la réponse générée par l’IA entre en conflit avec l’invite ou la requête prévue. Par exemple:

Le contenu généré ne répond pas à l’invite relative à la cuisine, ce qui indique une incapacité à saisir le contexte.

- Hallucination factuelle de l’IA :

- Des contradictions factuelles surviennent lorsque le modèle d’IA présente de fausses informations comme étant exactes. Par exemple:

- Invite : « Énumérez trois éléments du tableau périodique. »

- Résultat : « Hydrogène, oxygène, carbonite ».

- Des contradictions factuelles surviennent lorsque le modèle d’IA présente de fausses informations comme étant exactes. Par exemple:

La « carbonite » n’est pas un élément conduisant à une désinformation dans la réponse.

- Hallucinations IA non pertinentes ou aléatoires :

- Ces hallucinations impliquent la génération d’informations non pertinentes ou absurdes sans rapport avec l’entrée. Par exemple:

- Invite : « Décrivez une journée à la plage. »

- Sortie : « Le sable était chaud. Les mouettes chantaient du jazz. Les pingouins dansaient le ballet.

- Ces hallucinations impliquent la génération d’informations non pertinentes ou absurdes sans rapport avec l’entrée. Par exemple:

La mention des pingouins et du ballet ne correspond pas à la scène de plage typique, démontrant un manque de cohérence dans le récit généré.

Ces types d’hallucinations soulignent les défis auxquels les systèmes d’IA sont confrontés pour comprendre et contextualiser les informations avec précision. Pour résoudre ces problèmes, il faut améliorer la qualité des données de formation, affiner la compréhension du contexte par les modèles linguistiques et mettre en œuvre des mécanismes de validation robustes pour garantir la cohérence et l’exactitude des résultats générés par l’IA.

Les hallucinations de l’IA peuvent avoir de graves conséquences, en particulier dans les applications où l’IA est utilisée pour prendre des décisions importantes, telles que des diagnostics médicaux ou des transactions financières. Si un système d’IA hallucine et fournit des informations inexactes dans ces contextes, cela pourrait avoir des conséquences néfastes.

Que pouvez-vous faire contre les hallucinations de l’IA ?

Réduire les hallucinations de l’IA implique quelques étapes clés pour rendre les systèmes d’IA plus précis et plus fiables :

Premièrement, il est crucial d’utiliser des données de bonne qualité pour entraîner l’IA. Cela signifie s’assurer que les informations dont l’IA apprend sont diverses, précises et exemptes de préjugés.

Simplifier les modèles d’IA peut également aider. Les modèles complexes peuvent parfois conduire à des erreurs inattendues. En gardant les choses simples, nous pouvons réduire les risques d’erreurs.

Des instructions claires et faciles à comprendre sont également importantes. Lorsque l’IA reçoit des informations claires, elle est moins susceptible de se perdre et de commettre des erreurs.

Des tests réguliers permettent de détecter rapidement toute erreur. En vérifiant les performances de l’IA, nous pouvons résoudre tous les problèmes et apporter des améliorations.

L’ajout de contrôles dans les systèmes d’IA peut également aider. Ces contrôles recherchent les erreurs et les corrigent avant qu’elles ne causent des problèmes.

Plus important encore, la surveillance humaine est essentielle. Demander aux gens de revérifier les résultats générés par l’IA garantit l’exactitude et la fiabilité.

Enfin, entraîner l’IA à se défendre contre les attaques peut la rendre plus résiliente. Cela aide l’IA à reconnaître et à gérer les tentatives de manipulation ou de tromperie.

En suivant ces étapes, nous pouvons rendre les systèmes d’IA plus fiables et réduire les risques de sorties hallucinées.

Comment faire halluciner une IA ?

Si vous souhaitez profiter de cette faille et vous amuser, vous pouvez faire plusieurs choses :

- Changer l’entrée: Vous pouvez modifier les informations fournies à l’IA. Même de petits changements peuvent donner lieu à des réponses étranges ou incorrectes.

- Tromper le modèle: Créez des entrées spéciales qui trompent l’IA et lui font donner de mauvaises réponses. Ces astuces exploitent les faiblesses du modèle pour créer des sorties hallucinées.

- Jouer avec les données: En ajoutant des informations trompeuses ou incorrectes aux données d’entraînement de l’IA ou à votre invite, vous pouvez lui faire apprendre les mauvaises choses et produire des hallucinations.

- Ajuster le modèle: Modifier les paramètres ou la structure de l’IA pour introduire des défauts ou des biais. Ces changements peuvent l’amener à générer des sorties étranges ou absurdes.

- Donner des entrées déroutantes: Fournir à l’IA des instructions peu claires ou contradictoires. Cela peut confondre l’IA et conduire à des réponses incorrectes ou absurdes.

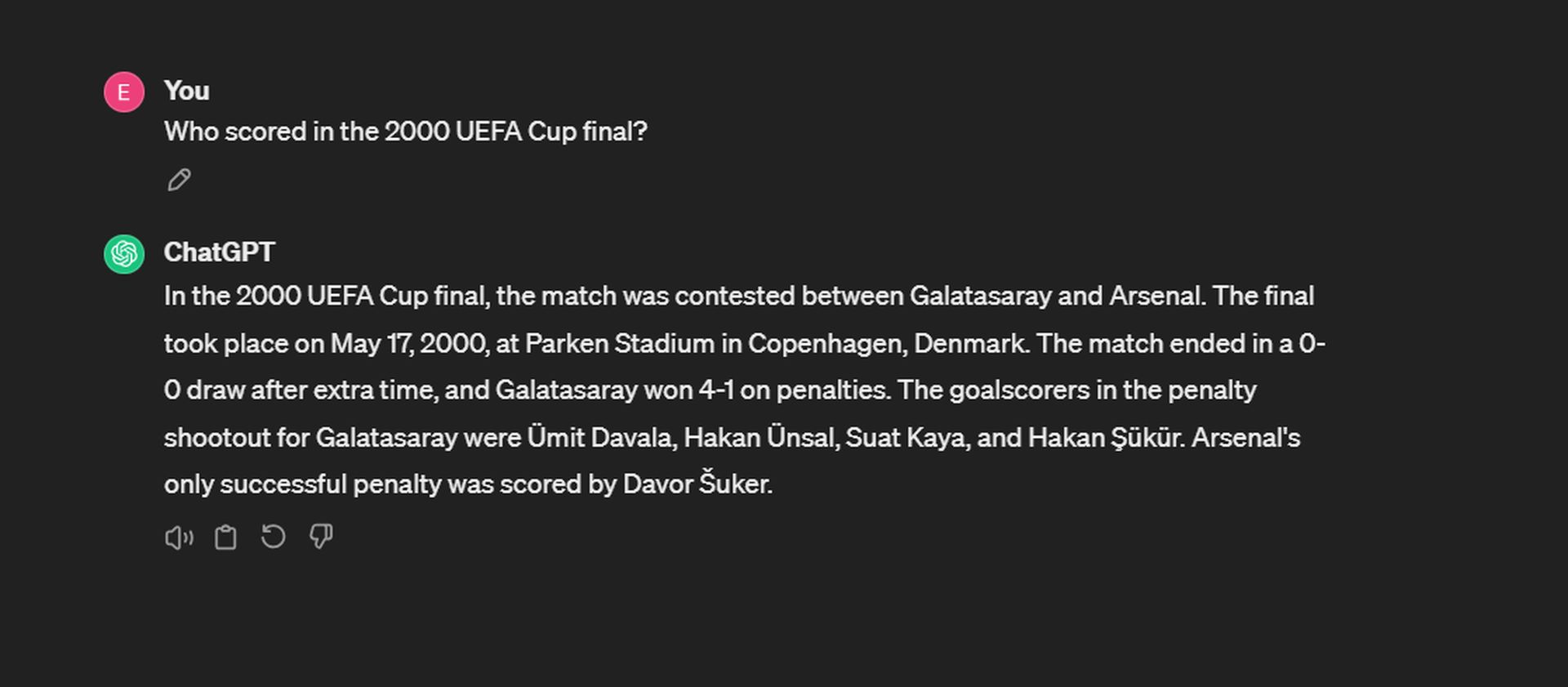

Ou vous pouvez simplement poser des questions et tenter votre chance ! Par exemple, nous avons essayé de faire halluciner ChatGPT :

Bien que ChatGPT se souvienne avec précision de la date et du score, il a du mal à rappeler les buteurs des tirs au but. Pour Galatasaray, les buts ont été marqués par Ergün Penbe, Hakan Şükür, Ümit Davala et Popescu. Du côté d’Arsenal, Ray Parlor a été le seul buteur de penalty réussi.

Même si faire halluciner l’IA peut nous aider à comprendre ses limites, il est important d’utiliser ces connaissances de manière responsable et de garantir que les systèmes d’IA restent fiables et dignes de confiance.

GPT 4 hallucine-t-il moins ?

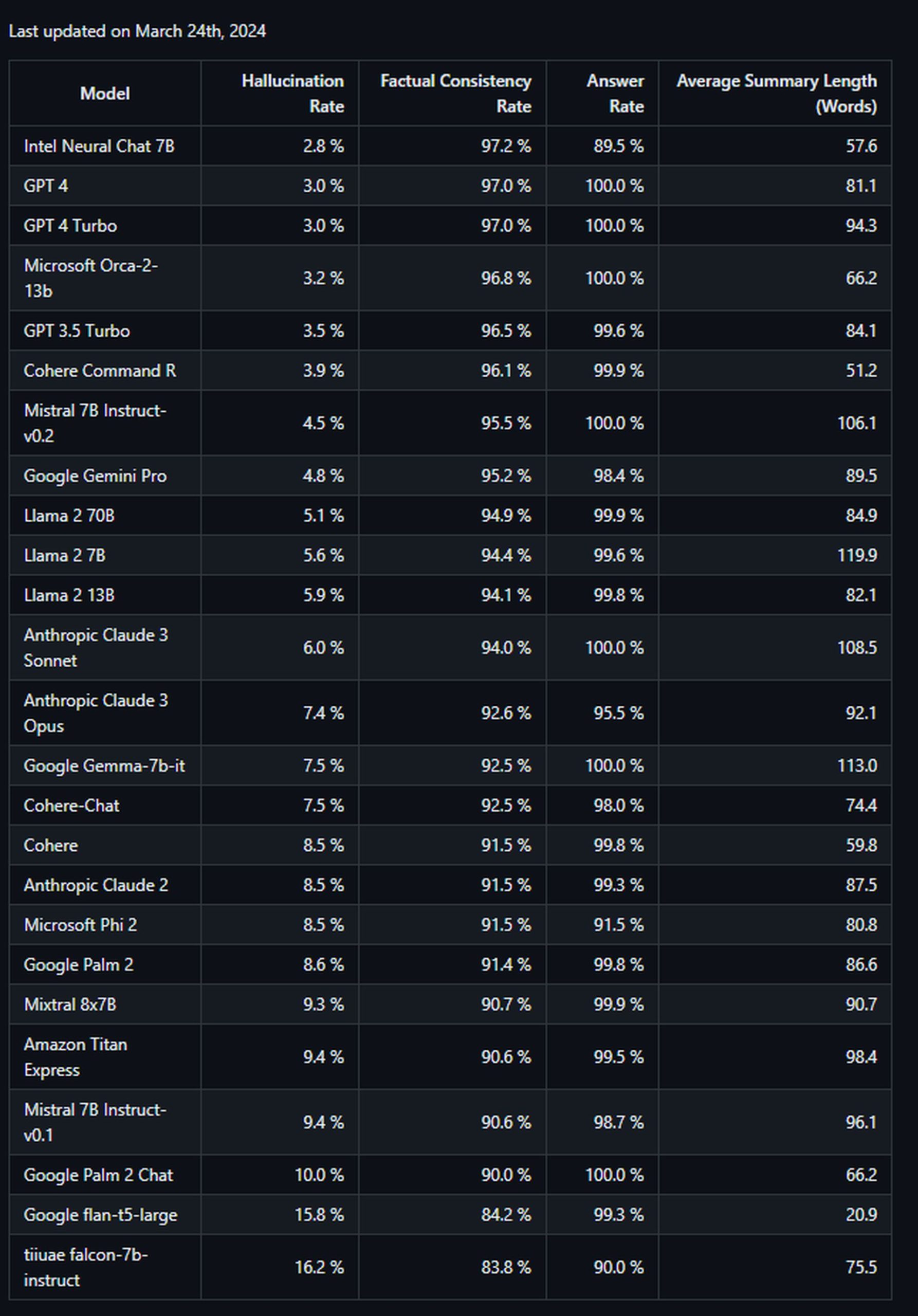

Oui, selon le évaluation menée par la société basée à Palo Alto à l’aide de son modèle d’évaluation des hallucinations, GPT-4 démontre un taux d’hallucinations inférieur à celui des autres modèles à grand langage, à l’exception d’Intel Neural Chat 7B (97,2 %). Avec un taux de précision de 97 % et un taux d’hallucinations de 3 %, GPT-4 présente un niveau de précision élevé et une tendance relativement faible à introduire des hallucinations lors de la synthèse de documents. Cela indique que GPT-4 est moins susceptible de générer des résultats incorrects ou absurdes par rapport aux autres modèles testés dans l’évaluation.

D’un autre côté, peu des modèles les moins efficaces provenaient de Google. Google Palme 2 a démontré un taux de précision de 90 % et un taux d’hallucinations de 10 %. Son homologue raffiné par chat a obtenu des résultats encore pires, avec un taux de précision de seulement 84,2 % et le score d’hallucinations le plus élevé de tous les modèles du classement à 16,2 %. Voici la liste :

En résumé, une hallucination de l’IA est une erreur commise par les systèmes d’IA lorsqu’ils produisent des résultats absurdes ou incorrects en raison de défauts dans les données d’entraînement ou dans la manière dont ils traitent les informations. Il s’agit d’un aspect fascinant, mais néanmoins stimulant, de l’IA que les chercheurs et les développeurs s’efforcent d’aborder.