Tout en apportant la mise à jour Meta AI sur chaque plate-forme, Meta a également publié le benchmark Llama 3 pour les passionnés de technologie.

Le benchmark propose aux chercheurs et développeurs indépendants une suite de tests standardisés pour évaluer les performances de Llama 3 sur diverses tâches.

Cette transparence permet aux utilisateurs de comparer les forces et les faiblesses de Llama 3 avec d’autres LLM en utilisant le même benchmark, favorisant ainsi une compréhension plus objective de ses capacités.

Que montre le benchmark Llama 3 ?

Meta AI a établi le benchmark Llama 3, une suite complète d’évaluations conçues pour évaluer les performances LLM dans diverses tâches. Ces tâches comprennent la réponse aux questions, le résumé, le suivi des instructions et l’apprentissage en quelques étapes. Le benchmark sert d’outil crucial pour évaluer les forces et les faiblesses de Llama 3 par rapport aux autres LLM.

Bien qu’une comparaison directe entre le benchmark Llama 3 et ceux utilisés pour les concurrents soit difficile en raison des différentes méthodologies d’évaluation, Meta affirme que les modèles Llama 3 formés sur leur ensemble de données ont atteint des performances exceptionnelles dans toutes les tâches évaluées. Cela indique que Meta AI est à égalité avec les meilleurs dans le domaine LLM.

Voici un aperçu plus approfondi de la façon dont les benchmarks Llama 3 se comparent :

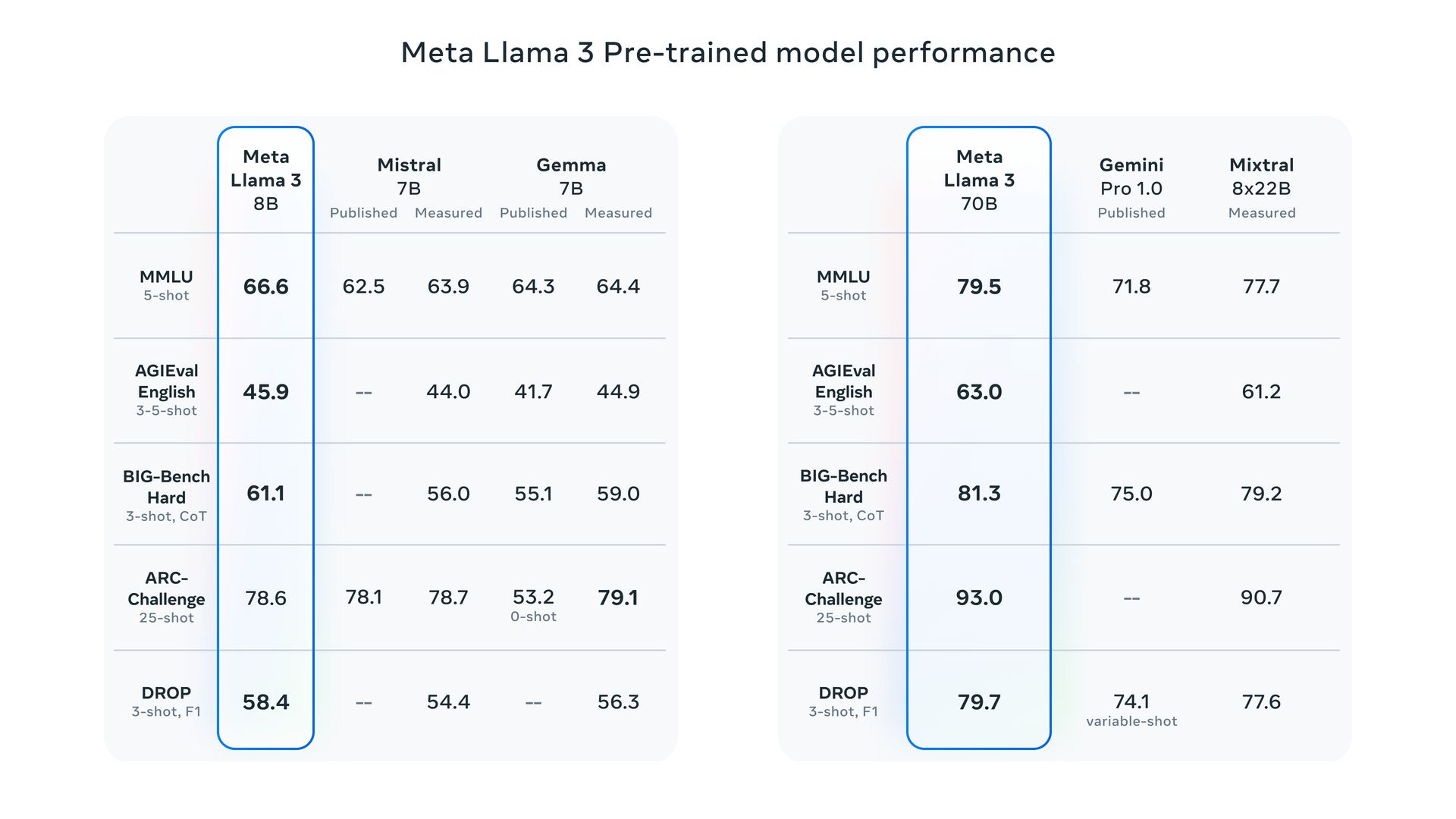

- Échelle des paramètres : Meta se vante que ses modèles Llama 3 aux paramètres 8B et 70B surpassent Llama 2 et établissent un nouvel état de l’art pour les LLM d’échelle similaire.

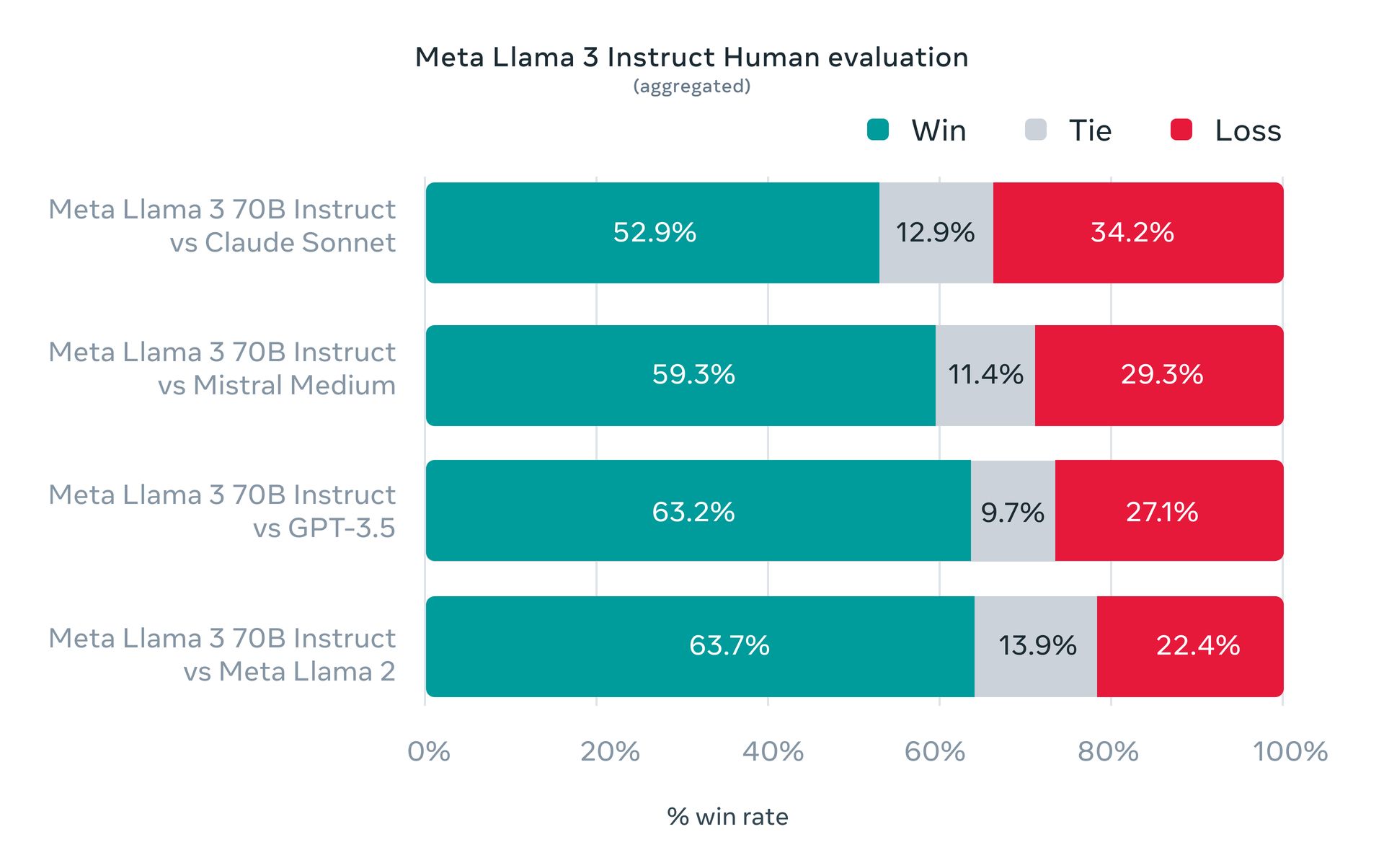

- Évaluation humaine : Meta a mené des évaluations humaines sur un ensemble de données complet englobant 12 cas d’utilisation clés. Cette évaluation positionne favorablement le modèle Llama 3 70B suivant les instructions par rapport à des rivaux de taille comparable dans des scénarios du monde réel.

Il s’agit des propres évaluations de Meta, et des références indépendantes pourraient être nécessaires pour une comparaison plus définitive.

Poids ouverts vs open source

Il est crucial de faire la différence entre « open-weights » et « open-source ». Bien que Llama 3 propose des modèles et des poids téléchargeables gratuitement, il ne relève pas de la définition stricte de l’open source en raison des limitations d’accès et des données de formation (contrairement aux logiciels véritablement open source).

Llama 3 est disponible en deux tailles : 8 milliards (8B) et 70 milliards (70B) paramètres. Les deux sont disponible en téléchargement gratuit sur le site de Meta après un simple processus d’inscription.

Une plongée technique approfondie dans Meta AI

Llama 3 propose deux versions :

- Pré-formé : Il s’agit du modèle brut axé sur la prédiction du prochain jeton.

- Adapté aux instructions : Cette version est optimisée pour suivre les instructions utilisateur spécifiques.

Les deux versions ont une limite de contexte de 8 192 jetons.

Détails de la formation

- Matériel de formation : Meta a utilisé deux clusters personnalisés, chacun contenant 24 000 GPU, pour entraîner Llama 3.

- Données d’entraînement: Mark Zuckerberg, PDG de Meta, a révélé dans une interview en podcast que le modèle 70B avait été formé sur un ensemble de données massif d’environ 15 000 milliards de jetons. Il est intéressant de noter que le modèle n’a jamais atteint un point de saturation (performance maximale) pendant l’entraînement, ce qui suggère qu’il pourrait y avoir des améliorations supplémentaires avec des ensembles de données encore plus volumineux.

- Plans futurs: Meta entraîne actuellement une version colossale de paramètres 400B de Llama 3, la plaçant potentiellement dans la même ligue de performances que des rivaux comme GPT-4 Turbo et Gémeaux Ultra sur des benchmarks comme MMLU, GPQA, HumanEval et MATH.

Les défis du benchmark Llama 3

Nous devons reconnaître les limites des références LLM actuelles en raison de facteurs tels que la contamination des données de formation et la sélection des résultats par les fournisseurs.

Malgré ces limitations, Meta a fourni quelques benchmarks démontrant les performances de Llama 3 sur des tâches telles que MMLU (connaissances générales), GSM-8K (mathématiques), HumanEval (codage), GPQA (questions avancées) et MATH (problèmes de mots).

Ces références positionnent favorablement le modèle 8B par rapport à des concurrents à pondération ouverte comme Gemma 7B de Google et Mistral7B Instruire. Le modèle 70B résiste également aux noms établis comme Gémeaux Pro 1.5 et Claude 3 Sonnet.

Accessibilité de Llama 3

Meta prévoit de rendre les modèles Llama 3 disponibles sur les principales plates-formes cloud telles qu’AWS, Databricks, Google Cloud et autres, garantissant ainsi une large accessibilité aux développeurs.

Llama 3 constitue la base de l’assistant virtuel de Meta, qui sera mis en évidence présenté dans les fonctionnalités de recherche sur Facebook, Instagram, WhatsApp, Messengeret un site dédié ressemblant à l’interface de ChatGPT (y compris la génération d’images).

En plus, Meta s’est associé à Google d’intégrer les résultats de recherche en temps réel dans l’assistant, en s’appuyant sur leurs partenariat existant avec Bing de Microsoft.

Crédit image en vedette: Méta