Un nouveau modèle d’IA appelé VASA-1 promet de transformer vos photos en vidéos et de leur donner une voix. Cette technologie passionnante de Microsoft utilise une seule photo de portrait et un fichier audio pour créer une vidéo de visage parlant avec une synchronisation labiale, des expressions faciales et des mouvements de tête réalistes.

La puissance du VASA-1

Les capacités de VASA-1 résident dans sa capacité à générer des animations faciales réalistes. Contrairement à ses prédécesseurs, VASA-1 minimise les erreurs autour de la bouche, un signe révélateur courant des deepfakes. De plus, il offre un réalisme de haute qualité grâce à sa compréhension nuancée des expressions faciales et des mouvements naturels de la tête.

Vidéos de démonstration publiées par Microsoft dans un article de blog présenter les résultats impressionnants, brouillant les frontières entre la réalité et le contenu généré par l’IA.

Où VASA-1 pourrait-il briller, demandez-vous ? Bien,

- Ga amélioréexpériences minantes : Imaginez des personnages du jeu avec des mouvements de lèvres parfaitement synchronisés et des visages expressifs, créant ainsi une expérience de jeu plus immersive et engageante.

- Avatars virtuels personnalisés : VASA-1 pourrait changer les médias sociaux en permettant aux utilisateurs de créer des avatars hyperréalistes qui bougent et parlent comme eux.

- Réalisation de films alimentés par l’IA : Les cinéastes pourraient utiliser VASA-1 pour générer des plans rapprochés réalistes, des expressions faciales complexes et des séquences de dialogue naturelles, repoussant ainsi les limites des effets spéciaux.

Comment fonctionne VASA-1 ?

VASA-1 relève le défi de générer des vidéos réalistes de visages parlants à partir d’une seule image et d’un clip audio. Examinons les aspects techniques de la façon dont il réalise cet exploit remarquable.

Imaginez une photo de quelqu’un et un enregistrement audio d’une autre personne parlant. VASA-1 vise à combiner ces éléments pour créer une vidéo dans laquelle la personne sur la photo semble prononcer les mots de l’audio. Cette vidéo doit être réaliste sur plusieurs aspects clés :

- Clarté et authenticité de l’image : Les images vidéo générées doivent ressembler à des images réelles et ne présenter aucun artefact d’apparence artificielle.

- Précision de la synchronisation labiale : Les mouvements des lèvres dans la vidéo doivent parfaitement se synchroniser avec l’audio.

- Expressions faciales : Le visage généré doit afficher des émotions et des expressions appropriées pour correspondre au contenu parlé.

- Mouvements naturels de la tête : Des mouvements de tête subtils devraient rehausser le réalisme du visage parlant.

VASA-1 peut également accepter des commandes supplémentaires pour personnaliser la sortie, telles que la direction principale du regard, la distance tête-caméra et un décalage général des émotions.

Cadre général

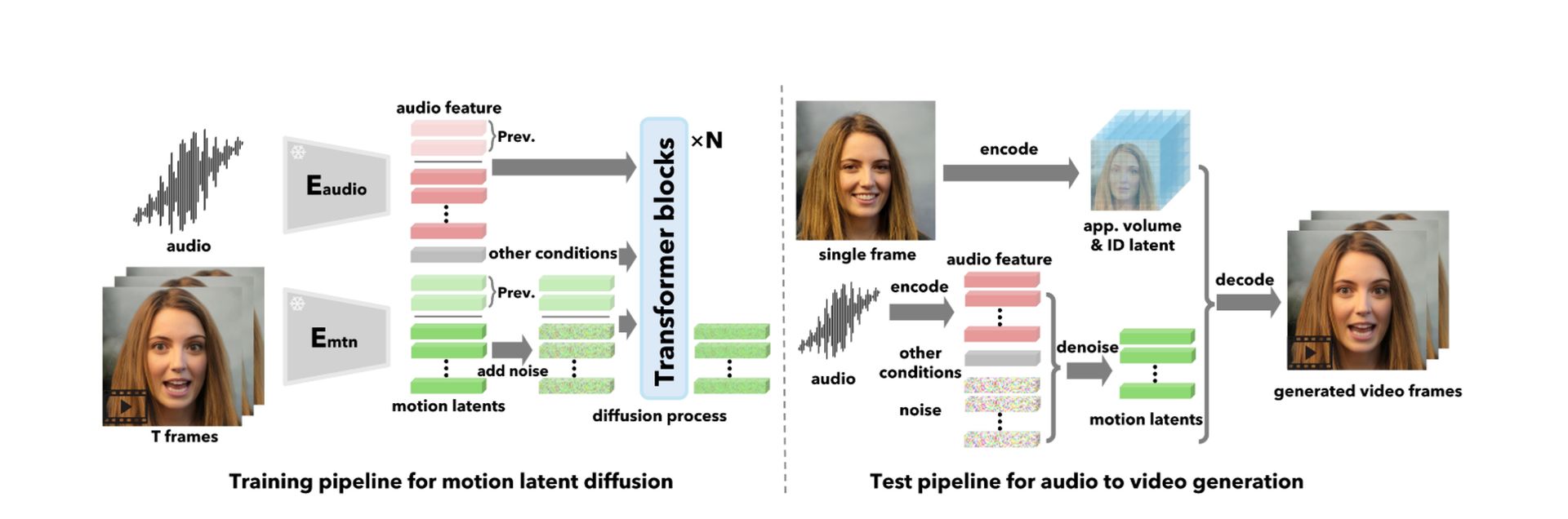

Au lieu de générer directement des images vidéo, VASA-1 fonctionne en deux étapes :

Génération de mouvements et de poses : il crée une séquence de codes qui représentent la dynamique du visage (mouvements des lèvres, expressions) et les mouvements de la tête (pose) conditionnés par l’audio et d’autres signaux d’entrée.

Génération d’images vidéo : ces codes de mouvement et de pose sont ensuite utilisés pour générer les images vidéo réelles, en tenant compte des informations d’apparence et d’identité extraites de l’image d’entrée.

Panne technique

Voici un aperçu des composants principaux de VASA-1 :

1. Construction d’espace latent de visage expressif et démêlé

VASA-1 commence par construire un type particulier d’espace numérique appelé « espace latent » spécialement conçu pour représenter les visages humains. Cet espace possède deux propriétés essentielles :

- Expressivité: Il peut capturer toute la gamme des expressions et des mouvements du visage humain avec un niveau de détail élevé.

- Démêlage: Différents aspects du visage, tels que l’identité, la pose de la tête et la dynamique faciale, sont représentés séparément dans cet espace. Cela permet un contrôle indépendant sur ces aspects lors de la génération vidéo.

VASA-1 y parvient en s’appuyant sur les techniques existantes de reconstitution de visages 3D. Il décompose une image de visage en plusieurs composants :

- Volume d’apparence 3D (Vapp): Cela capture la forme et la texture 3D détaillées du visage.

- Code d’identité (z_id): Cela représente les caractéristiques uniques de la personne dans l’image.

- Code de pose de la tête (z_pose): Ceci code l’orientation et l’inclinaison de la tête.

- Code de dynamique faciale (z_dyn): Ceci capture les expressions faciales et les mouvements actuels.

Pour garantir un démêlage approprié, VASA-1 utilise des fonctions de perte spécialisées pendant la formation. Ces fonctions pénalisent le modèle s’il mélange différents aspects de la représentation du visage.

2. Génération de dynamique faciale holistique avec transformateur de diffusion

Une fois que VASA-1 dispose d’un espace latent bien entraîné, il lui faut un moyen de générer les codes de mouvement et de pose pour une séquence de visage parlant basée sur un clip audio. C’est là qu’intervient le « Transformateur de diffusion ».

- Modèle de diffusion: VASA-1 exploite un modèle de diffusion, un type d’architecture d’apprentissage profond, pour y parvenir. Les modèles de diffusion fonctionnent en ajoutant progressivement du bruit à un signal clair, puis en apprenant à inverser ce processus. Dans le cas de VASA-1, le signal propre est la séquence de mouvement et de pose souhaitée, et le signal bruyant est un point de départ aléatoire. Le modèle de diffusion apprend essentiellement à « débruiter » pour revenir à la séquence de mouvements clairs en fonction des fonctionnalités audio fournies.

- Architecture du transformateur: VASA-1 utilise un type spécifique de modèle de diffusion appelé « transformateur ». Les transformateurs excellent dans les tâches d’apprentissage séquence à séquence, ce qui les rend bien adaptés pour générer une séquence de codes de mouvement et de pose correspondant à la séquence audio.

VASA-1 conditionne le transformateur de diffusion sur plusieurs entrées :

- Fonctionnalités audio: Extraites du clip audio, ces fonctionnalités représentent le contenu audio et informent le modèle sur les mouvements des lèvres et les émotions prévus.

- Signaux de commande supplémentaires: Ces signaux facultatifs permettent un contrôle supplémentaire sur la vidéo générée. Ils comprennent:

- Direction principale du regard (g): Ceci spécifie où regarde le visage généré.

- Distance tête-caméra (d): Ceci contrôle la taille apparente du visage dans la vidéo.

- Compensation d’émotion (e): Ceci peut être utilisé pour modifier légèrement l’expression émotionnelle globale affichée par le visage.

3. Génération de vidéo de visage parlant

Avec les codes de mouvement et de pose générés, VASA-1 peut enfin créer les images vidéo. Il le fait par :

- Réseau de décodeurs: Ce réseau prend le mouvement et pose des codes ainsi que les informations d’apparence et d’identité extraites de l’image d’entrée en entrée. Il utilise ensuite ces informations pour synthétiser des images vidéo réalistes qui représentent la personne dans l’image effectuant les mouvements du visage et les expressions correspondant à l’audio.

- Guide sans classificateur (CFG): VASA-1 intègre une technique appelée Classifier-free Guidance (CFG) pour améliorer la robustesse et la contrôlabilité du processus de génération. CFG implique de supprimer de manière aléatoire certaines des conditions d’entrée pendant la formation.

Cela oblige le modèle à apprendre à générer de bons résultats même lorsque toutes les informations ne sont pas disponibles. Par exemple, le modèle peut avoir besoin de générer le début de la vidéo sans aucune information audio ou de mouvement préalable.

Voir plus d’explications dans le document de recherche ici.

L’ombre menaçante des deepfakes

Deepfakes, des vidéos très réalistes générées par l’IA qui manipulent l’apparence et la voix des gens, sont devenues une source de préoccupation croissante. Des acteurs malveillants peuvent les utiliser pour diffuser des informations erronées, nuire à la réputation et même influencer les élections. La nature hyperréaliste de VASA-1 intensifie ces angoisses.

C’est là que réside le le point crucial de l’avenir incertain de VASA-1.

La décision de Microsoft de restreindre l’accès, en le gardant hors de portée du public et de certains chercheurs, suggère une approche prudente. Les dangers potentiels des deepfakes nécessitent un examen attentif avant de lancer une technologie aussi puissante.

Concilier innovation et responsabilité

À l’avenir, Microsoft est confronté à un défi crucial : trouver l’équilibre entre innovation et développement responsable. La voie à suivre réside peut-être dans des environnements de recherche contrôlés dotés de solides garanties contre les abus. De plus, favoriser l’éducation et la sensibilisation du public aux deepfakes peut permettre aux utilisateurs de distinguer le contenu authentique de celui manipulé par l’IA.

VASA-1 représente indéniablement une avancée significative dans la capacité de l’IA à manipuler les médias visuels. Ses applications potentielles sont tout simplement révolutionnaires.

Cependant, les considérations éthiques entourant les deepfakes nécessitent une approche mesurée. Ce n’est que grâce à un développement responsable et à l’éducation du public que nous pourrons libérer le véritable potentiel de VASA-1 tout en atténuant les risques potentiels.

Crédit image en vedette: Microsoft