Méta fait son nouveau Llama 3 LLM open source et vous pouvez l’exécuter localement avec Ollama. En rendant Llama 3 open source, Meta a libéré un potentiel considérable pour les entreprises de toutes tailles. Cela signifie que le code sous-jacent de Llama 3 est disponible gratuitement pour examen, adaptation et utilisation par toute partie intéressée. Les implications pour le monde des affaires, en particulier pour les petites et moyennes entreprises, sont considérables.

Grâce à une structure de licence permissive, les PME peuvent exploiter la puissance de Llama 3 pour leurs projets spécifiques sans se heurter à de lourdes restrictions. Tant que le respect des normes juridiques établies est maintenu, les PME ont la liberté d’explorer le vaste potentiel de cette technologie de pointe.

Qu’est-ce que Lama 3 ?

Llama 3 est un LLM développé par Meta, la société affirme qu’il s’agit de « le LLM librement disponible le plus performant à ce jour ».

Llama 3 existe en deux tailles : 8 milliards et 70 milliards de paramètres. Ce type de modèle est formé sur une quantité massive de données textuelles et peut être utilisé pour diverses tâches, notamment la génération de texte, la traduction de langues, la rédaction de différents types de contenu créatif et la réponse à vos questions de manière informative. Meta présente Llama 3 comme l’un des meilleurs modèles ouverts disponibles, mais il est encore en développement.

« Avec Llama 3, nous avons décidé de créer les meilleurs modèles ouverts, comparables aux meilleurs modèles propriétaires disponibles aujourd’hui », peut-on lire sur le blog de Meta.

Les modèles Llama 3 utilisent des données pour atteindre une mise à l’échelle sans précédent. Ils ont été formés à l’aide de deux clusters GPU 24K personnalisés récemment dévoilés sur plus de 15 000 milliards de jetons de données. Cet ensemble de données de formation est sept fois plus volumineux que celui utilisé pour Llama 2 et comprend quatre fois plus de code, améliorant considérablement leurs capacités et l’étendue de leurs connaissances.

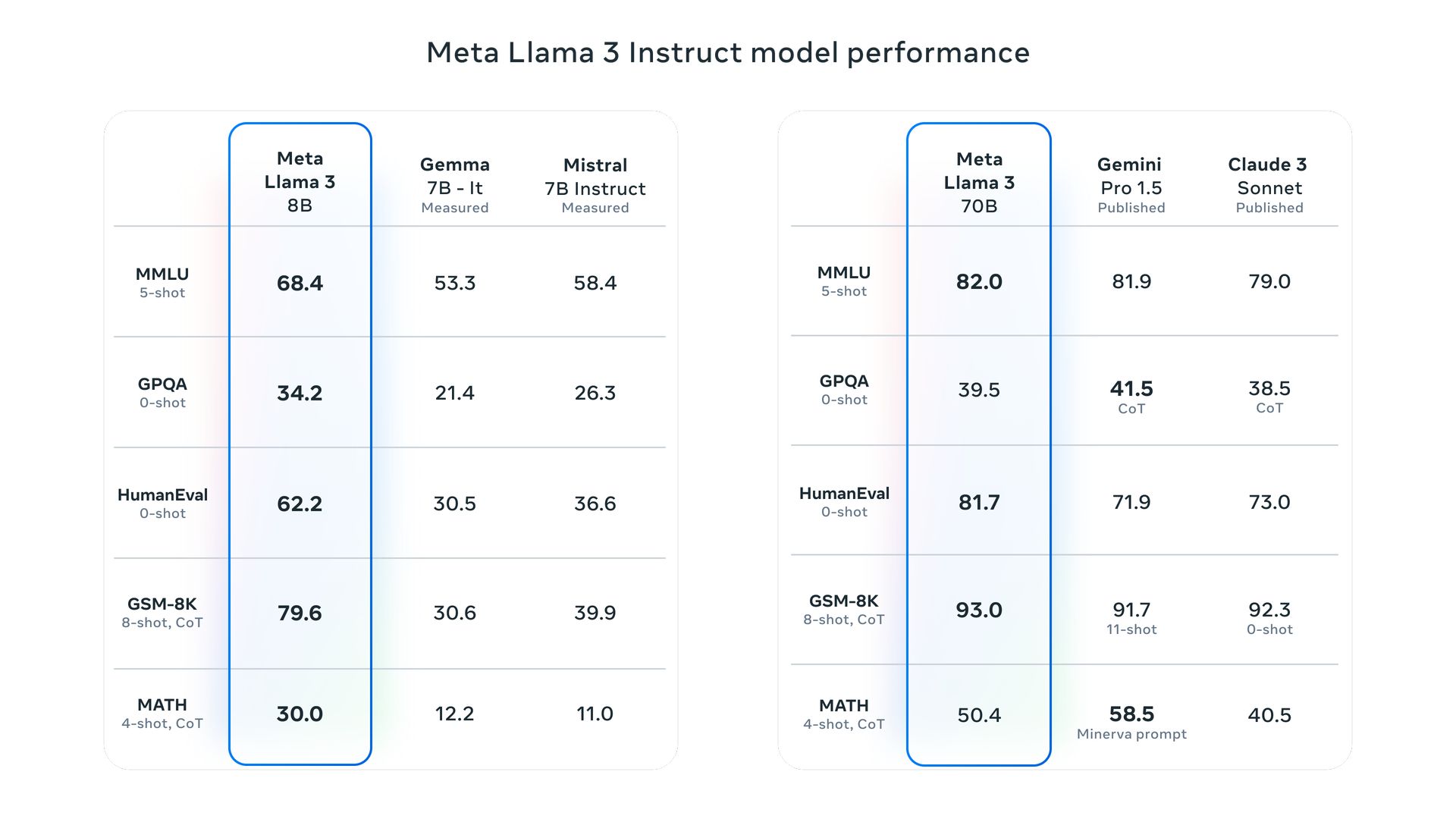

Nous avons discuté Lama 3 repères montrant comment le modèle a réalisé des performances exceptionnelles dans toutes les tâches évaluées.

Comment Meta Llama 3 s’améliore-t-il par rapport aux versions précédentes ?

Les modèles Meta Llama 3 ont subi des améliorations significatives dans les processus de pré-entraînement et de réglage fin, qui améliorent leur capacité à mieux s’aligner sur les instructions de l’utilisateur, à générer des réponses plus diversifiées et à réduire les taux d’erreur. Les principales améliorations technologiques incluent un tokenizer plus efficace et un Group Query Attention (GQA), améliorant l’efficacité de l’inférence.

Llama 3 est-il multimodal ?

Actuellement, Llama 3 fonctionne avec des données textuelles et visuelles pour certaines applications, mais Meta vise à améliorer ses capacités de traitement d’images. D’ici fin 2024, ils prévoient de lancer Llama 4, conçu pour exceller dans l’interprétation et la génération d’images complexes basées sur des descriptions textuelles.

Cette avancée permettra des modifications sophistiquées des images, des améliorations de la représentation des scènes et la création d’images réalistes dans différents styles, fusionnant les capacités de compréhension du langage et de perception visuelle pour des résultats plus impressionnants.

Comment accéder à Lama 3 ?

L’accès à Llama 3 est actuellement possible localement via Ollama, ce qui facilite le déploiement et l’exploitation de grands modèles de langage.

Que fait Ollama ?

Ollama fournit une plate-forme pour exécuter de grands modèles de langage open source tels que Llama 2 sur des systèmes locaux. Il intègre les poids du modèle, la configuration et les données nécessaires dans un package unifié spécifié par un fichier modèle et simplifie le processus de configuration, notamment en optimisant l’utilisation du GPU pour des performances améliorées.

Ollama est-il disponible sur Windows ?

Concernant la compatibilité, Ollama est désormais accessible sur Windows dans une version preview. Cette version permet aux utilisateurs de gérer de grands modèles de langage directement sur Windows, avec une accélération GPU, un accès complet à la bibliothèque de modèles et une API Ollama prenant en charge les protocoles OpenAI.

Comment fonctionne Ollama ?

Ollama utilise une architecture de transformateur, un type de modèle d’apprentissage profond qui joue un rôle essentiel dans les grands modèles de langage. En analysant de nombreuses données textuelles, Ollama maîtrise les nuances du langage, ce qui lui permet de comprendre le contexte des requêtes, de produire des réponses syntaxiquement correctes et contextuellement significatives, et d’effectuer une traduction linguistique précise en capturant l’essence de la langue source et en la transmettant efficacement dans la langue cible. langue.

Llama 3 sera-t-il open source ?

En termes de disponibilité, Meta a déclaré que Llama 3 est open source favorisant une accessibilité et une innovation plus larges au sein de la communauté technologique.

Puis-je exécuter Llama 3 localement ?

Oui, Ollama facilite l’exécution de divers grands modèles de langage, dont Llama 3, sur des ordinateurs personnels. Il exploite l’efficacité de llama.cpp, une bibliothèque open source qui permet le fonctionnement local des LLM même sur des systèmes dotés de spécifications matérielles modestes. De plus, Ollama intègre un type de gestionnaire de packages, qui simplifie le processus de téléchargement et d’utilisation des LLM via une seule commande, améliorant à la fois la vitesse et la facilité d’utilisation.

Quelles fonctionnalités de sécurité sont intégrées dans Meta Llama 3 ?

Meta a intégré plusieurs fonctionnalités de sécurité dans Llama 3, telles que Llama Guard 2 et Cybersec Eval 2, pour gérer les problèmes de sécurité et de sûreté. Ces outils aident à filtrer les sorties problématiques et à garantir un déploiement sécurisé. De plus, les modèles ont été soumis à une équipe rouge pour tester et affiner leur réponse aux entrées contradictoires.

Quels sont les futurs objectifs de Meta Llama 3 ?

Meta prévoit d’étendre Llama 3 pour prendre en charge les capacités multilingues et multimodales, gérer des longueurs de contexte plus longues et améliorer encore les performances de toutes les fonctionnalités de base des modèles de langage. L’objectif est également de garder les modèles ouverts à la participation communautaire et aux améliorations itératives.

Crédit image en vedette : Méta