NVIDIA NIM augmente la productivité des développeurs en offrant un moyen standardisé d’intégrer l’IA générative dans les applications.

Qu’est-ce que NVIDIA NIM ?

NVIDIA NIM (NVIDIA Inference Microservices) est une plateforme conçue pour améliorer le déploiement et l’intégration de modèles d’IA génératifs. Il fournit une approche standardisée pour intégrer l’IA générative dans diverses applications, augmentant ainsi considérablement la productivité des développeurs et optimisant les investissements en infrastructure.

Caractéristiques de NVIDIA NIM

Les principales fonctionnalités et capacités de NVIDIA NIM incluent :

- Déploiement rationalisé: Les conteneurs NVIDIA NIM sont livrés pré-construits avec des logiciels essentiels tels que NVIDIA CUDA, NVIDIA Triton Inference Server et NVIDIA TensorRT-LLM, permettant une inférence efficace accélérée par GPU.

- Prise en charge de plusieurs modèles: La plate-forme prend en charge un large éventail de modèles d’IA, notamment Databricks DBRX, Gemma de Google, Meta Llama 3, Microsoft Phi-3 et Mistral Large, les rendant accessibles en tant que points de terminaison sur ai.nvidia.com.

- Intégration avec les plateformes populaires: NVIDIA NIM peut être intégré à des plates-formes telles que Hugging Face, permettant aux développeurs d’accéder et d’exécuter facilement des modèles à l’aide de points de terminaison d’inférence alimentés par NVIDIA.

- Prise en charge étendue de l’écosystème: Il est supporté par de nombreux fournisseurs de plateformes (Canonical, Red Hat, Nutanix, VMware) et intégré aux principales plateformes cloud (Amazon Web Services, Google Cloud, Azure, Oracle Cloud Infrastructure).

- Adoption par l’industrie: Des entreprises leaders dans divers secteurs, telles que Foxconn, Pegatron, Amdocs et ServiceNow, exploitent NVIDIA NIM pour des applications telles que les usines d’IA, les villes intelligentes, les véhicules électriques, la facturation client et les modèles d’IA multimodaux.

- Accès développeur: Les membres du NVIDIA Developer Program peuvent accéder gratuitement à NIM pour la recherche, le développement et les tests, facilitant ainsi l’expérimentation et l’innovation dans les applications d’IA.

Presque 200 partenaires technologiques, dont Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI et Synopsys, intègrent NVIDIA NIM pour accélérer les déploiements d’IA générative adaptés à des applications spécifiques telles que les copilotes, les assistants de codage et les avatars humains numériques.. En plus, Hugging Face présente NVIDIA NIM, en commençant par Meta Llama 3.

Jensen Huang, fondateur et PDG de NVIDIA, a souligné l’accessibilité et l’importance de NVIDIA NIM, en déclarant : « Chaque entreprise vise à intégrer l’IA générative dans ses opérations, mais toutes ne disposent pas d’une équipe de chercheurs dédiés à l’IA. » NVIDIA NIM permet à presque toutes les organisations d’utiliser l’IA générative.

Les entreprises peuvent mettre en œuvre des applications d’IA à l’aide de NVIDIA NIM via la plateforme logicielle NVIDIA AI Enterprise.. À partir du mois prochain, Les membres du NVIDIA Developer Program auront un accès gratuit à NVIDIA NIM pour la recherche, le développement et les tests sur l’infrastructure de leur choix..

Les conteneurs NVIDIA NIM sont conçus pour rationaliser le déploiement de modèles pour l’inférence accélérée par GPU et sont équipés du logiciel NVIDIA CUDA, du serveur d’inférence NVIDIA Triton et du logiciel NVIDIA TensorRT-LLM.. Sur 40 modèles, tels que Databricks DBRX, Gemma de Google, Meta Llama 3, Microsoft Phi-3 et Mistral Large, sont accessibles en tant que points de terminaison NIM sur ai.nvidia.com.

À travers le Plateforme Hugging Face AI, les développeurs peuvent facilement accéder aux microservices NVIDIA NIM pour les modèles Meta Llama 3. Cette intégration leur permet de exécutez efficacement Llama 3 NIM à l’aide de points de terminaison d’inférence Hugging Face alimentés par des GPU NVIDIA.

De nombreux fournisseurs de plateformes, dont Canonical, Red Hat, Nutanix et VMware, prend en charge NVIDIA NIM sur les solutions open source KServe et d’entreprise. Les sociétés d’applications d’IA comme Hippocratic AI, Glean, Kinetica et Redis sont utiliser NIM pour piloter l’inférence générative de l’IA. Principaux outils d’IA et partenaires MLOps, tels que Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot et autres, ont intégré NIM dans leurs plates-formes, permettant aux développeurs de créer et de déployer des applications d’IA générative spécifiques à un domaine avec une inférence optimisée.

Obtenez votre gratuitement Passe de jeu NVIDIA offrir maintenant

Intégrateurs de systèmes mondiaux et partenaires de prestation de services, notamment Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS et Wipro, ont développé une expertise en NIM pour aider les entreprises à développer et à mettre en œuvre rapidement des stratégies d’IA de production. Les entreprises peuvent exécuter des applications compatibles NIM sur des systèmes certifiés NVIDIA provenant de fabricants tels que Cisco, Dell Technologies, Hewlett-Packard Enterprise, Lenovo et Supermicro, ainsi que sur les serveurs de ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron et Wiwynn. De plus, les microservices NIM sont intégrés aux principales plates-formes cloud, notamment Services Web Amazon, Google Cloud, Azuret Oracle Cloud Infrastructure.

Les grandes entreprises exploitent NIM pour diverses applications dans tous les secteurs. Foxconn utilise NIM pour les LLM spécifiques à un domaine dans les usines d’IA, les villes intelligentes et les véhicules électriques. Pégatron emploie NIM pour le projet TaME afin de faire progresser le développement local de LLM pour diverses industries. Amdocs utilise NIM pour un LLM de facturation client, réduisant considérablement les coûts et la latence tout en améliorant la précision. ServiceMaintenant intègre les microservices NIM dans son modèle multimodal Now AI, offrant aux clients un développement et un déploiement LLM rapides et évolutifs.

Comment essayer NVIDIA NIM ?

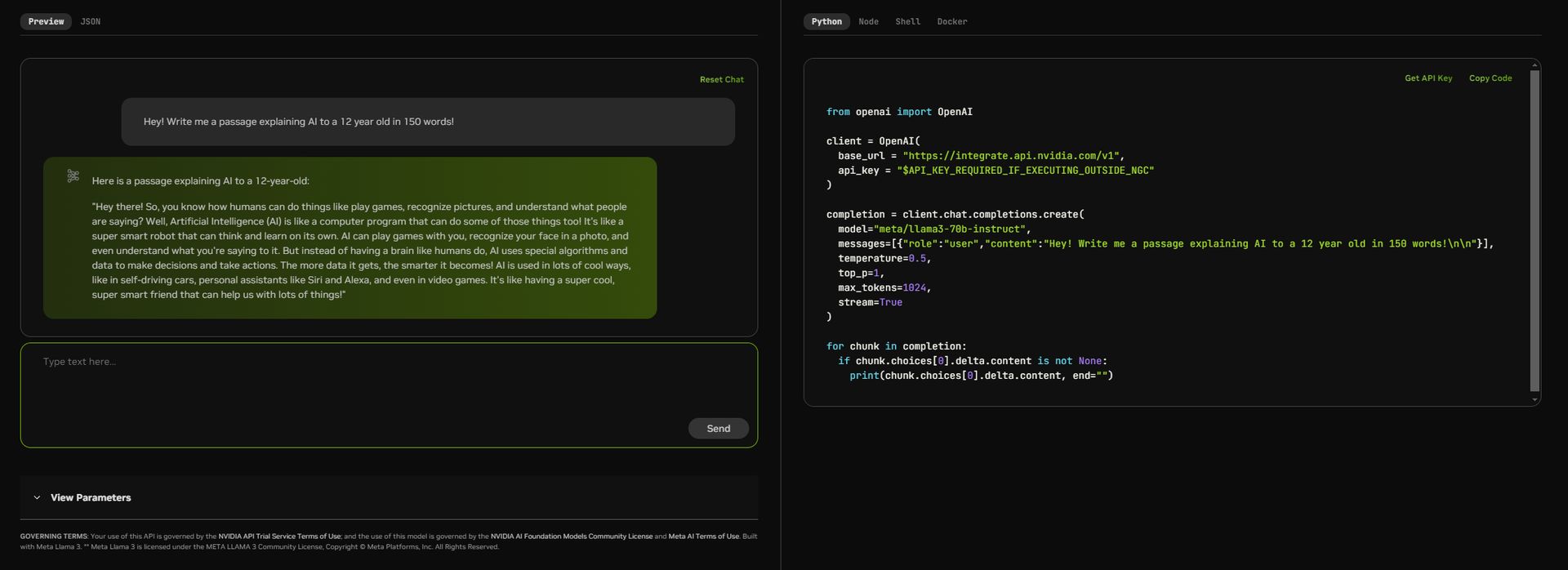

Utiliser NVIDIA NIM pour déployer et expérimenter des modèles d’IA génératifs est simple. Voici un guide étape par étape pour vous aider à démarrer :

- Visitez le site Web NVIDIA NIM:

- Ouvrez votre navigateur Web et accédez à ai.nvidia.com.

- Commencez à explorer:

- Sur la page d’accueil, vous trouverez une option « Essayer maintenant ». Cliquez sur ce bouton pour commencer.

- Sélectionnez votre modèle:

- Vous serez dirigé vers une page présentant différents modèles. Pour cet exemple, sélectionnez le modèle « llama3-70b-instruct » de Meta. Ce modèle est conçu pour les tâches de génération de langage.

- Déployer le modèle:

- Une fois que vous avez sélectionné le modèle, vous verrez une interface avec des options pour déployer le modèle. Cliquez sur « Exécuter n’importe où » pour continuer.

- Utiliser le point de terminaison d’inférence:

- Après le déploiement, vous aurez accès aux points de terminaison d’inférence Hugging Face alimentés par des GPU NVIDIA. Cela vous permet d’exécuter le modèle efficacement.

- Entrez votre invite:

- Dans l’interface, vous trouverez une zone de texte dans laquelle vous pourrez saisir votre invite. Par exemple, vous pouvez taper « Hé ! Écrivez-moi un passage expliquant l’IA à un enfant de 12 ans en 150 mots ! »

- Exécuter l’invite:

- Cliquez sur le bouton « Envoyer » pour exécuter l’invite. Le modèle générera une réponse basée sur votre entrée.

- Afficher la sortie:

- La réponse générée sera affichée dans la section de sortie. Vous pouvez consulter le texte généré par le modèle et l’utiliser selon vos besoins.

- Explorez des fonctionnalités supplémentaires:

- NVIDIA NIM vous permet également de modifier les paramètres et d’afficher le code JSON pour une utilisation plus avancée. Explorez ces options pour personnaliser davantage la sortie.

- Accès gratuit pour les développeurs:

- Si vous êtes développeur, vous pouvez accéder gratuitement aux microservices NVIDIA NIM pour la recherche, le développement et les tests en vous inscrivant via le programme pour développeurs NVIDIA.

Exemple d’interaction

Voici un exemple d’utilisation du modèle :

- Rapide: « Hé! Écrivez-moi un passage expliquant l’IA à un enfant de 12 ans en 150 mots ! »

- Réponse: « Salut! Alors, savez-vous comment les humains peuvent faire des choses comme jouer à des jeux, reconnaître des images et comprendre ce que les gens disent ? Eh bien, l’intelligence artificielle (IA) est comme un programme informatique qui peut également faire certaines de ces choses ! C’est comme un robot super intelligent, capable de penser et d’apprendre par lui-même. L’IA peut jouer à des jeux avec vous, reconnaître votre visage sur une photo et même comprendre ce que vous lui dites. Mais au lieu d’avoir un cerveau comme les humains, l’IA utilise des algorithmes et des données spéciaux pour prendre des décisions et agir. Plus il reçoit de données, plus il devient intelligent ! L’IA est utilisée de nombreuses manières intéressantes, comme dans les voitures autonomes, les assistants personnels comme Siri et Alexa, et même dans les jeux vidéo. C’est comme avoir un ami super cool et super intelligent qui peut nous aider pour beaucoup de choses ! »

Crédit image en vedette : Kerem Gülen/Milieu du voyage