Meta Segment Anything Model 2 (SAM 2) fait sensation grâce à ses capacités impressionnantes. Contrairement aux modèles traditionnels qui ont du mal avec les nouveaux types d’objets, SAM 2 utilise l’apprentissage sans coupure pour identifier et segmenter les éléments sur lesquels il n’a pas été spécifiquement formé. Cela signifie qu’il peut facilement gérer une grande variété de contenus visuels.

Imaginez un outil qui non seulement segmente les objets dans une seule image, mais qui suit et maintient la continuité des objets sur toute une séquence vidéo, même en cas d’occlusion et de changements rapides. SAM 2 y parvient grâce à son architecture unifiée et à son mécanisme de mémoire. Voici comment.

Explication du Meta Segment Anything Model 2 (SAM 2)

Meta Segment Anything Model 2 est un modèle de vision par ordinateur avancé conçu pour gérer la segmentation d’objets sur divers types de supports, notamment les images et les vidéos. Contrairement aux modèles de segmentation traditionnels qui peuvent nécessiter un recyclage approfondi pour de nouveaux types d’objets, SAM 2 est doté de capacités d’apprentissage sans apprentissage. Grâce à ses solides capacités de généralisation, cela signifie qu’il peut segmenter des objets sur lesquels il n’a pas été explicitement formé. Cela est particulièrement utile pour les applications avec un contenu visuel diversifié ou évolutif où de nouvelles catégories d’objets apparaissent fréquemment.

Le cœur des fonctionnalités de Meta SAM 2 réside dans son architecture unifiée, qui traite à la fois les images et les trames vidéo. Cette architecture intègre un mécanisme de mémoire qui permet de maintenir la continuité entre les trames vidéo, en répondant à des problèmes tels que l’occlusion et le mouvement des objets.

L’encodeur de mémoire du modèle capture les informations des images précédentes, qui sont stockées dans une banque de mémoire et accessibles par un module d’attention de mémoire. Cette configuration garantit que le modèle peut suivre et segmenter avec précision les objets au fil du temps, même lorsqu’ils sont partiellement masqués ou lorsque la scène change de manière dynamique.

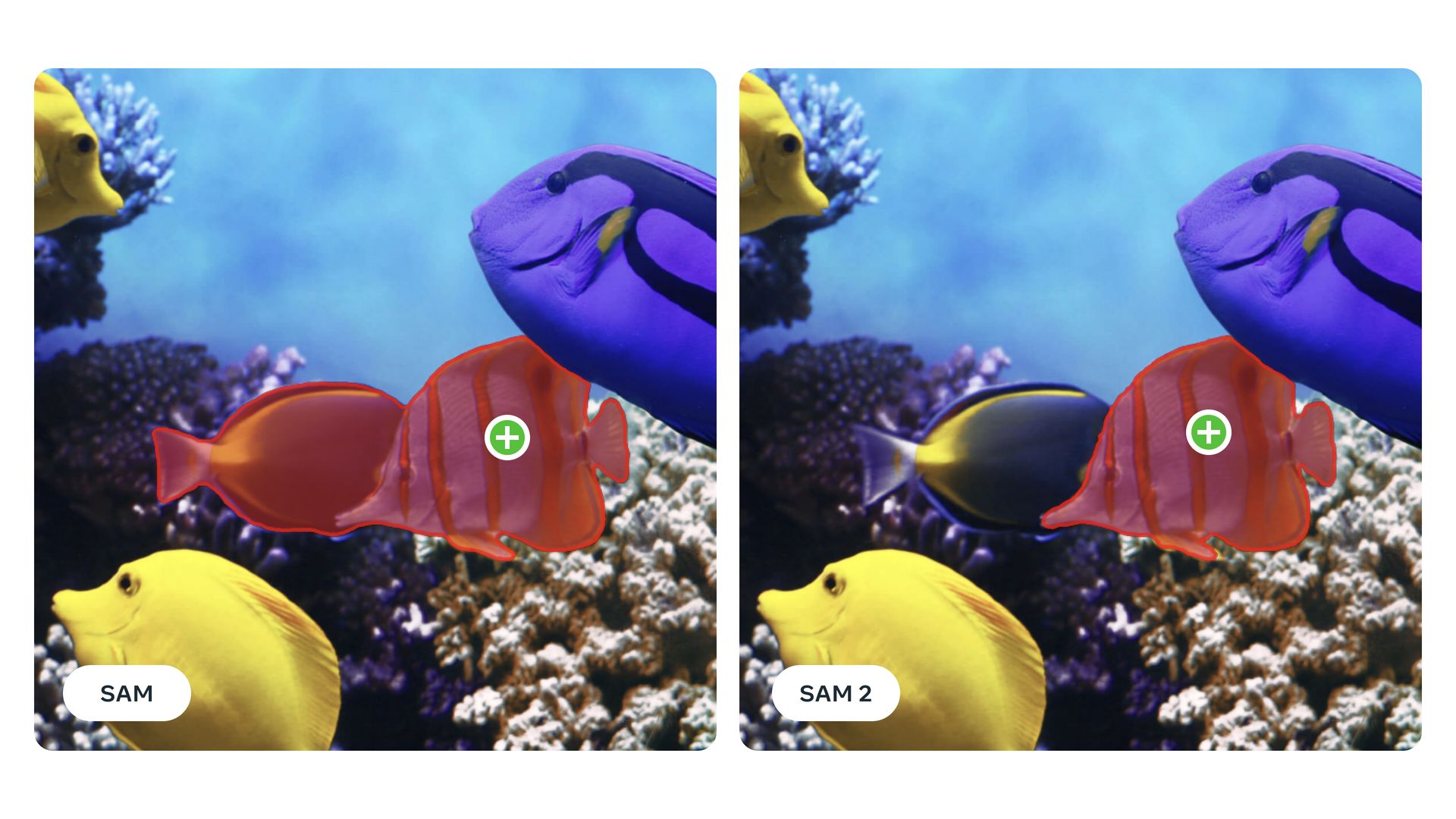

SAM 2 est également très interactif, permettant aux utilisateurs de fournir différents types d’invites, telles que des clics, des cadres de délimitation ou des masques, pour guider le processus de segmentation. Cette fonction de segmentation avec invite permet aux utilisateurs d’affiner les résultats de segmentation en fonction de leurs besoins spécifiques et de résoudre toute ambiguïté dans la détection d’objets. Lorsqu’il rencontre des scènes complexes où plusieurs interprétations sont possibles, SAM 2 peut générer plusieurs masques potentiels et sélectionner le plus approprié en fonction des niveaux de confiance.

Le modèle est formé et évalué à l’aide de Ensemble de données SA-Vqui se distingue par son ampleur et sa diversité. Cet ensemble de données comprend environ 51 000 séquences vidéo réelles et plus de 600 000 masques, offrant une ressource complète pour la formation et le test des modèles de segmentation. Les annotations de cet ensemble de données sont générées de manière interactive avec SAM 2 lui-même, garantissant une grande précision et une pertinence par rapport aux scénarios du monde réel. L’ensemble de données couvre un large éventail d’emplacements géographiques et divers types de contenu visuel, y compris des scénarios avec des vues d’objets partielles et des occlusions.

Le modèle Segment Anything Model (SAM) 2 de Meta représente une avancée majeure dans la segmentation vidéo interactive, surpassant considérablement les modèles précédents. Il excelle sur 17 ensembles de données vidéo à prise de vue nulle, nécessitant trois fois moins d’interactions humaines et fournissant des résultats six fois plus rapidement que son prédécesseur, SAM. SAM 2 surpasse les benchmarks existants tels que DAVIS et YouTube-VOS et traite la vidéo à environ 44 images par seconde, ce qui le rend très efficace pour les applications en temps réel. Sa capacité à effectuer une segmentation vidéo 8,4 fois plus rapide que l’annotation manuelle avec SAM souligne encore davantage son efficacité et son efficience dans la gestion de tâches vidéo complexes.

Les avancées de SAM 2 sont non seulement importantes pour des applications pratiques telles que l’analyse et l’annotation vidéo, mais contribuent également au domaine plus large de la recherche en vision par ordinateur. En rendant son code et son ensemble de données accessibles au public, Meta encourage l’innovation et le développement de la technologie de segmentation. Les améliorations futures pourraient se concentrer sur l’amélioration de la capacité du modèle à gérer les occlusions à long terme et les scènes de plus en plus complexes avec plusieurs objets en mouvement, continuant ainsi à repousser les limites de ce qui est possible en matière de segmentation d’objets.

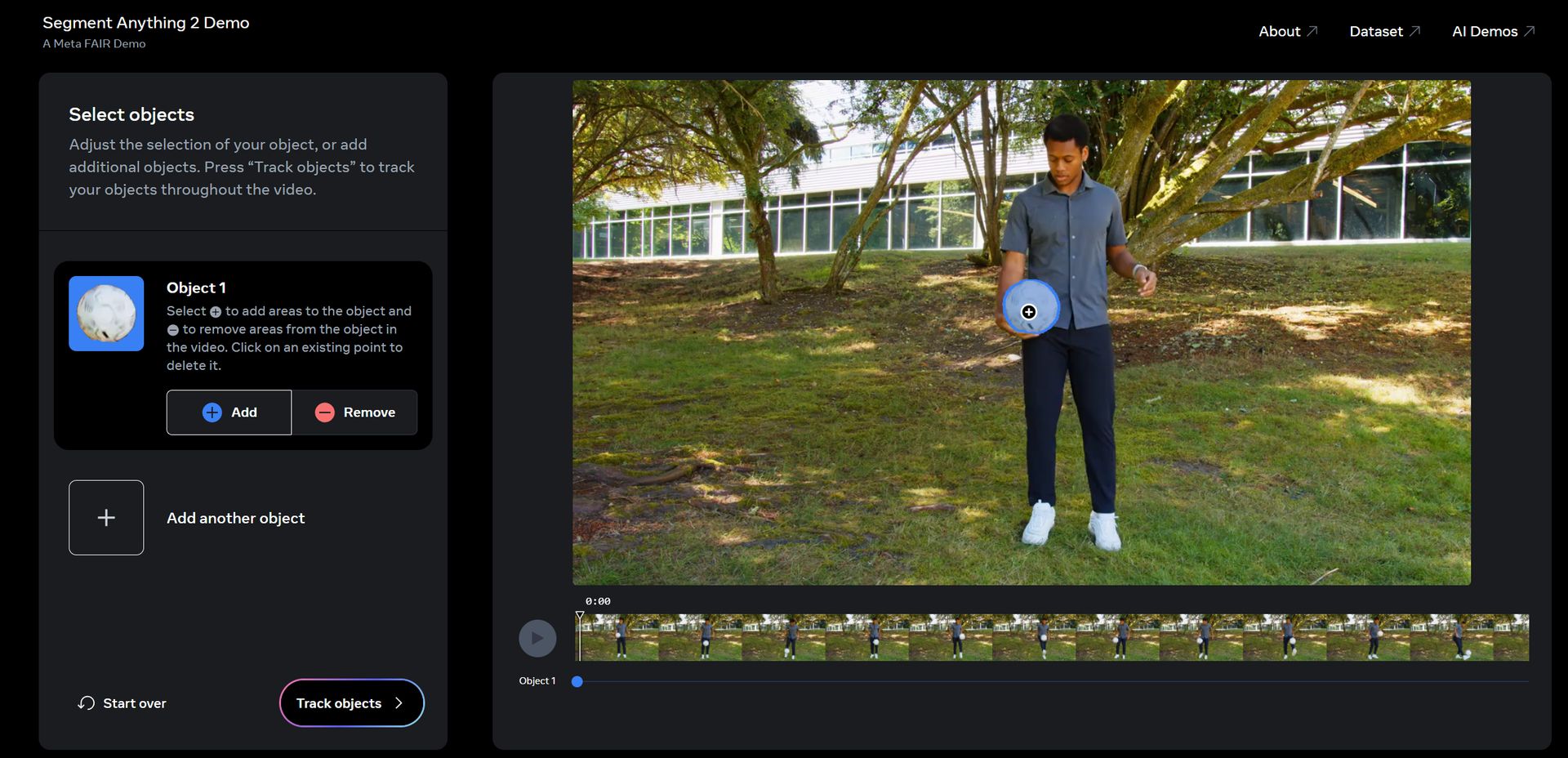

Comment utiliser SAM 2

Meta Segment Anything Model 2 (SAM 2) dispose d’une démo Web, il vous suffit de :

- Cliquez ici et visitez la page de démonstration.

- Accepter l’avertissement

- Cliquez sur un ou plusieurs objets que vous souhaitez suivre.

- Cliquez sur « Suivre les objets »

- Contrôlez la sortie. S’il n’y a aucun problème, cliquez sur « Suivant »

- Ajoutez des effets à votre guise ou laissez l’IA faire son travail en cliquant sur « Surprenez-moi »

- Cliquez sur Suivant »

- Vous pouvez maintenant obtenir un lien vers celui-ci ou le télécharger. Voici notre résultat :

Test du méta-segment Anything Model 2 (SAM 2) pic.twitter.com/d07PGto0eO

–Alan Davis (@AlanDav73775659) 30 juillet 2024

C’est tout!

Crédits de l’image en vedette : Méta