OpenAI Orion, le modèle d’IA de nouvelle génération de l’entreprise, se heurte à des obstacles de performances qui exposent les limites des approches de mise à l’échelle traditionnelles. Des sources proches du dossier révèlent qu’Orion offre des gains de performances inférieurs à ceux de ses prédécesseurs, ce qui incite OpenAI à repenser sa stratégie de développement.

Les premiers tests révèlent des améliorations stables

Les premiers tests effectués auprès des employés indiquent que OpenAI Orion a obtenu des performances de niveau GPT-4 après avoir terminé seulement 20 % de sa formation. Même si cela peut paraître impressionnant, il est important de noter que les premières étapes de la formation en IA génèrent généralement les améliorations les plus spectaculaires. Il est peu probable que les 80 % restants de la formation produisent des progrès significatifs, ce qui suggère qu’OpenAI Orion ne dépassera peut-être pas GPT-4 de loin.

« Certains chercheurs de l’entreprise pensent qu’Orion n’est pas vraiment meilleur que son prédécesseur dans la gestion de certaines tâches », a rapporté Les informations. « Orion est plus performant dans les tâches linguistiques mais peut ne pas surpasser les modèles précédents dans des tâches telles que le codage, selon un employé d’OpenAI. »

Le dilemme de la rareté des données

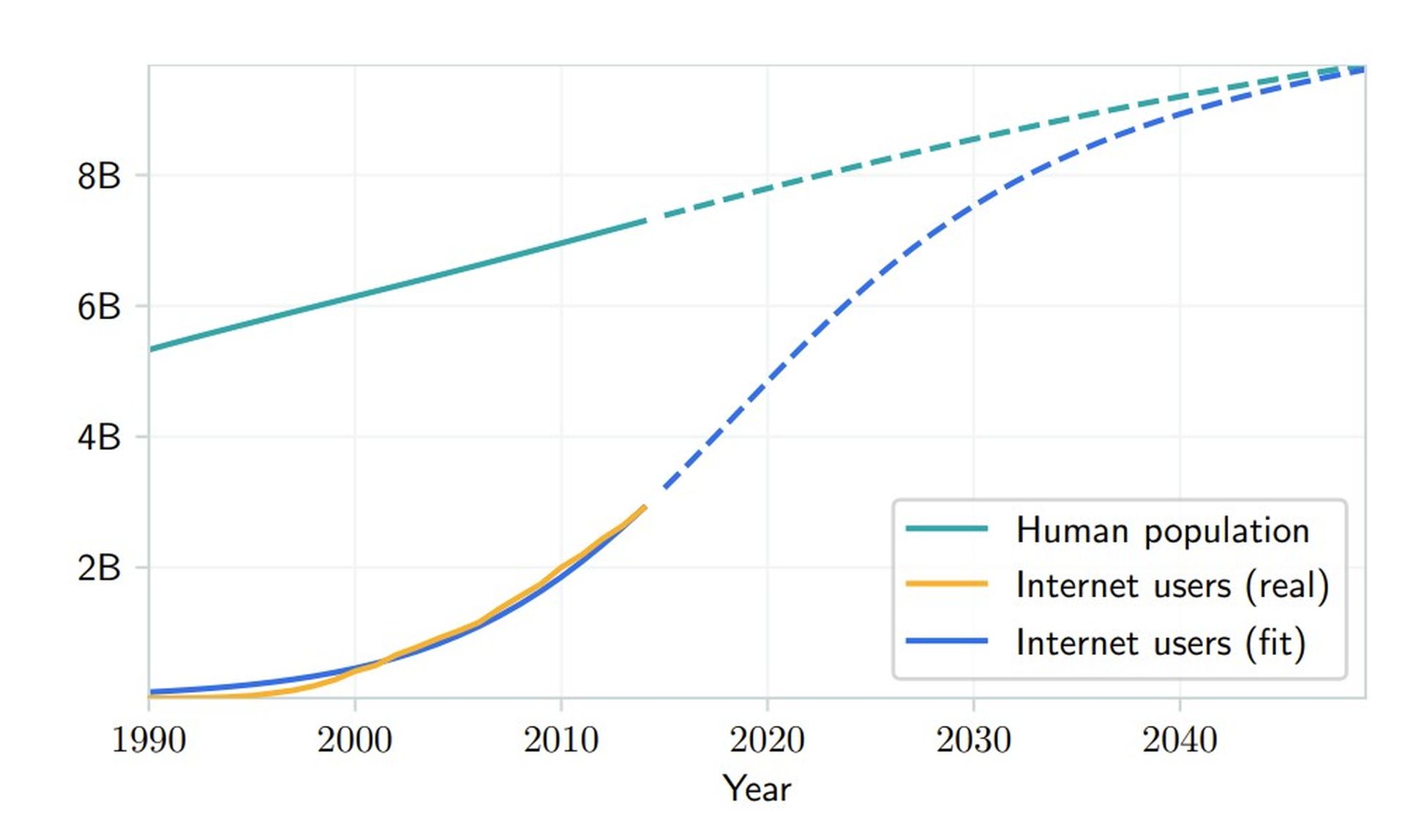

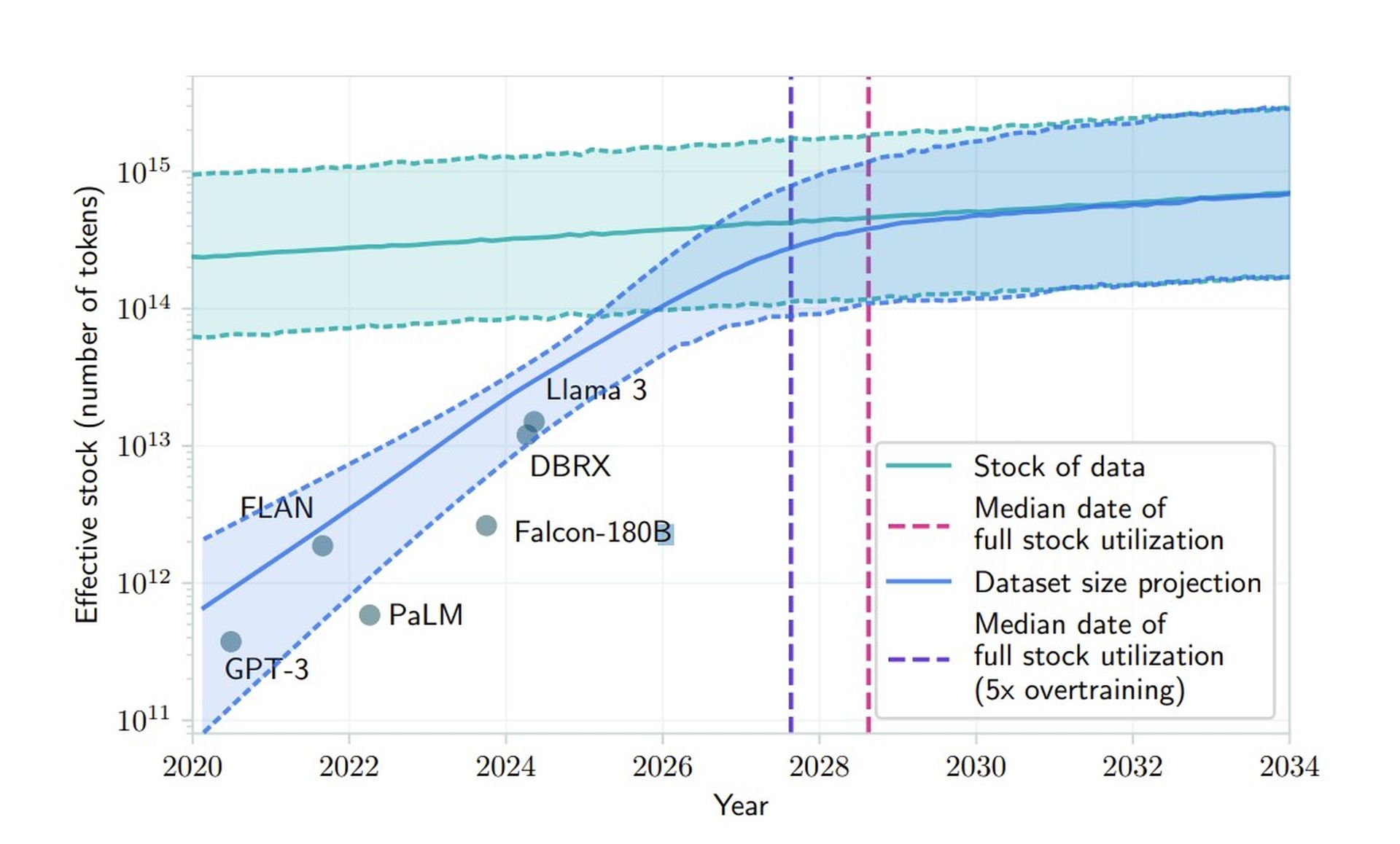

Les défis d’OpenAI avec Orion mettent en évidence un problème fondamental dans l’industrie de l’IA : la diminution de l’offre de données de formation de haute qualité. Une étude publiée en juin prédit que les entreprises d’IA épuiseront les données publiques disponibles sur les textes générés par l’homme entre 2026 et 2032. Cette rareté marque un point d’inflexion critique pour les approches de développement traditionnelles, obligeant des entreprises comme OpenAI à explorer des méthodes alternatives.

« Nos résultats indiquent que les tendances actuelles de développement du LLM ne peuvent pas être soutenues par la seule mise à l’échelle conventionnelle des données », conclut la recherche. états papier. Cela souligne la nécessité de générer des données synthétiques, d’apprendre par transfert et d’utiliser des données non publiques pour améliorer les performances du modèle.

La stratégie de développement à double voie d’OpenAI

Pour relever ces défis, OpenAI restructure son approche en séparant le développement de modèles en deux voies distinctes. La série O, nom de code Strawberry, se concentre sur les capacités de raisonnement et représente une nouvelle direction dans l’architecture des modèles. Ces modèles fonctionnent avec une intensité de calcul nettement plus élevée et sont explicitement conçus pour des tâches complexes de résolution de problèmes.

En parallèle, les modèles Orion – ou série GPT – continuent d’évoluer, se concentrant sur les tâches générales de traitement du langage et de communication. Kevin Weil, directeur produit d’OpenAI, a confirmé cette stratégie lors d’une AMA, en déclarant : « Ce n’est pas l’un ou l’autre, mais les deux : de meilleurs modèles de base et davantage de calculs de temps de mise à l’échelle et d’inférence en fraise. »

Données synthétiques : une arme à double tranchant

OpenAI explore la génération de données synthétiques pour remédier à la rareté des données pour OpenAI Orion. Cependant, cette solution introduit de nouvelles complications dans le maintien de la qualité et de la fiabilité des modèles. Les modèles de formation sur le contenu généré par l’IA peuvent conduire à des boucles de rétroaction qui amplifient des imperfections subtiles, créant un effet cumulatif de plus en plus difficile à détecter et à corriger.

Les chercheurs ont découvert que le fait de s’appuyer fortement sur des données synthétiques peut entraîner une dégradation des modèles au fil du temps. L’équipe Foundations d’OpenAI développe de nouveaux mécanismes de filtrage pour maintenir la qualité des données, en mettant en œuvre des techniques de validation pour faire la distinction entre le contenu synthétique de haute qualité et potentiellement problématique. Ils explorent également des approches de formation hybrides combinant du contenu humain et généré par l’IA pour maximiser les avantages tout en minimisant les inconvénients.

OpenAI Orion en est encore à ses débuts, avec d’importants travaux de développement à venir. Le PDG Sam Altman a indiqué qu’il ne serait pas prêt à être déployé cette année ou l’année prochaine. Ce calendrier prolongé pourrait s’avérer avantageux, permettant aux chercheurs de remédier aux limites actuelles et de découvrir de nouvelles méthodes d’amélioration des modèles.

Face à des attentes accrues après un récent cycle de financement de 6,6 milliards de dollars, OpenAI vise à surmonter ces défis en innovant dans sa stratégie de développement. En s’attaquant de front au dilemme de la rareté des données, la société espère garantir qu’OpenAI Orion aura un impact substantiel lors de sa sortie éventuelle.

Crédit image en vedette : Jonathan Kemper/Unsplash