Dans l’apprentissage automatique, peu d’idées ont réussi à unifier la complexité comme le tableau périodique l’a fait autrefois pour la chimie. Maintenant, Des chercheurs du MIT, Microsoft et Google tentent de faire exactement cela avec I-CON ou l’apprentissage contrasté de l’information. L’idée est trompeusement simple: représente la plupart des algorithmes d’apprentissage automatique – classification, régression, regroupement et même de grands modèles de langage – comme des cas particuliers d’un principe général: apprendre les relations entre les points de données.

Tout comme les éléments chimiques tombent dans des groupes prévisibles, les chercheurs affirment que les algorithmes d’apprentissage automatique forment également un schéma. En cartographiant ces modèles, I-Con ne clarifie pas seulement les anciennes méthodes. Il en prédit de nouveaux. Une telle prédiction? Un algorithme de classification d’image de pointe nécessitant zéro étiquettes humaines.

Imaginez un dîner de salle de bal. Chaque invité (point de données) trouve un siège (cluster) idéalement près des amis (données similaires). Certains amis s’assoient ensemble, d’autres répartis sur les tables. Cette métaphore, appelée le gala de clustering, capture la façon dont I-CON traite le clustering: optimiser le groupe de points de données étroitement basé sur des relations inhérentes. Il ne s’agit pas seulement de savoir qui est à la suite de qui, mais quels types de liens comptent; que ce soit une similitude visuelle, des étiquettes de classe partagées ou des connexions de graphiques.

Cette analogie de la salle de bal s’étend à l’ensemble de l’apprentissage automatique. Le framework I-CON montre que les algorithmes diffèrent principalement par la façon dont ils définissent ces relations. Modifiez la liste des invités ou la logique des sièges, et vous obtenez une réduction de la dimensionnalité, un apprentissage auto-supervisé ou un clustering spectral. Tout se résume à la préservation de certaines relations tout en simplifiant d’autres.

L’architecture derrière I-Con

À la base, I-Con est construit sur une base théorique de l’information. L’objectif: minimiser la différence (divergence kl) entre une distribution cible, ce que l’algorithme pense que les relations devraient être et une distribution apprise, la sortie du modèle réel. Formellement, ceci est écrit comme:

L (θ, ϕ) = ∑ dKl(pθ (· | i) || qϕ (· | i))

Différentes techniques d’apprentissage découlent de la façon dont les deux distributions, Pθ et Qϕ, sont construites. Lorsque Pθ groupe les images par proximité visuelle et que Qϕ les groupte par la similitude de l’étiquette, le résultat est une classification supervisée. Lorsque Pθ s’appuie sur la structure du graphique et Qϕ se rapproche des clusters, nous obtenons un regroupement spectral. Même la modélisation du langage s’inscrit, en traitant la cooccurrence des jetons comme une relation à préserver.

La table qui organise tout

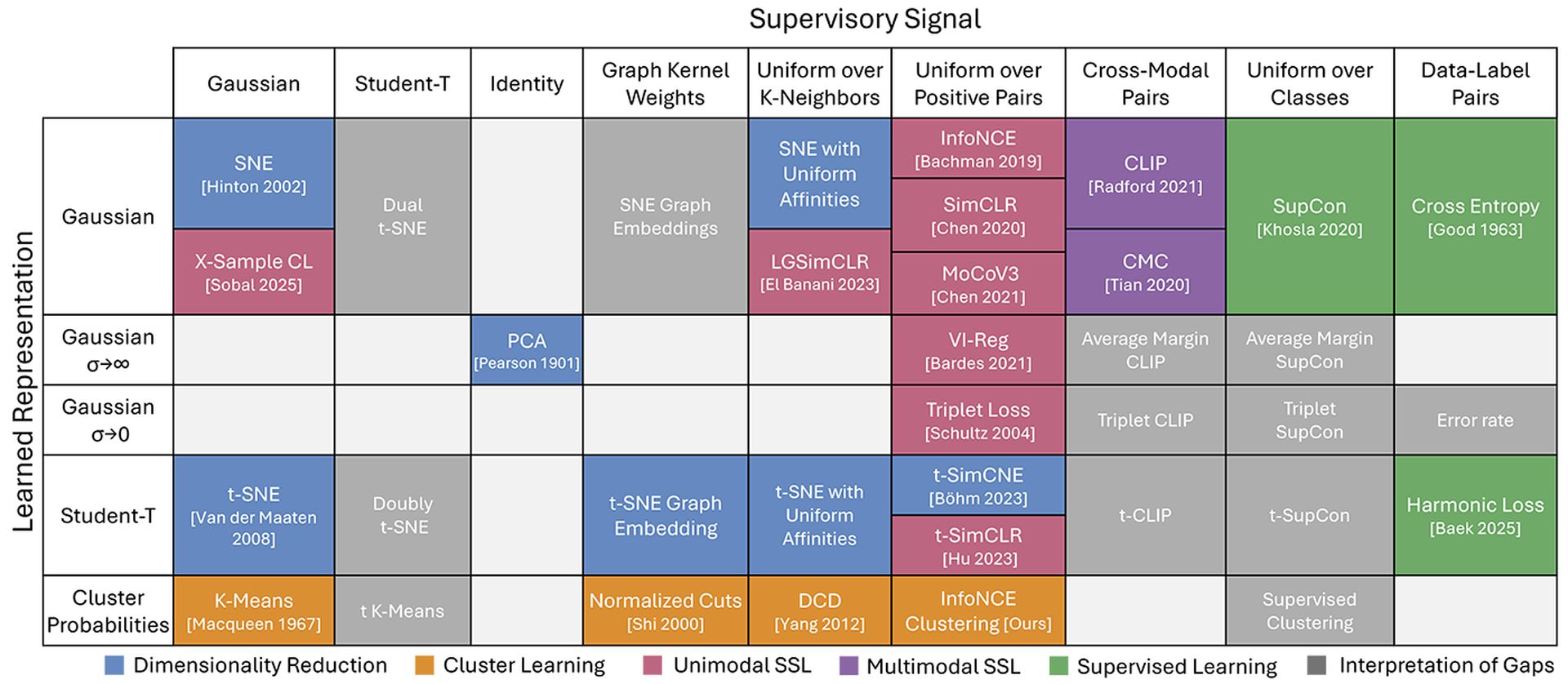

Inspirée par le tableau périodique de la chimie, l’équipe I-CON a construit une grille qui catégorise des algorithmes en fonction de leurs types de connexion. Chaque carré du tableau représente une manière unique de points de données liés dans l’espace d’entrée par rapport à l’espace de sortie. Une fois toutes les techniques connues placées, des lacunes surprenantes sont restées. Ces lacunes n’ont pas indiqué les données manquantes – elles ont fait allusion aux méthodes qui pouvaient exister mais qui n’avaient pas encore été découvertes.

Pour tester cela, les chercheurs ont comblé un de ces écarts en combinant le clustering avec l’apprentissage contrasté débiré. Le résultat: une nouvelle méthode qui a surperformé les classificateurs d’images non supervisés existants sur ImageNet de 8%. Il a fonctionné en injectant une petite quantité de bruit – «l’amitié universelle» entre les points de données – qui a rendu le processus de clustering plus stable et moins biaisé vers les affectations trop confiantes.

Debiasing joue un rôle central dans cette découverte. L’apprentissage contrasté traditionnel pénalise trop durement les échantillons différents, même lorsque ces échantillons peuvent ne pas être vraiment sans rapport. I-CON présente une meilleure approche: le mélange dans une distribution uniforme qui adoucit les hypothèses trop rigides sur les séparations des données. C’est un ajustement conceptuellement propre avec des gains mesurables en performance.

Une autre méthode consiste à étendre la définition du quartier lui-même. Au lieu de regarder uniquement les voisins les plus proches directs, I-CON se propage à travers le graphique du quartier – faisant des «promenades» pour capturer plus de structure mondiale. Ces promenades simulent comment l’information se propage sur les nœuds, améliorant le processus de clustering. Les tests sur les transformateurs de vision Dino confirment que la propagation à petite échelle (longueur de marche de 1 ou 2) donne le plus de gain sans écraser le modèle.

Recherche: L’IA de Google mange vos clics

Performance et gain

Le cadre I-CON n’est pas seulement la théorie. Sur ImageNet-1k, il a battu les modèles de clustering de pointe précédents comme Temi et Scan à l’aide de fonctions de perte auto-équilibrées plus simples. Contrairement à ses prédécesseurs, I-Con n’a pas besoin de pénalités ou de contraintes de taille réglées manuellement. Cela fonctionne simplement: les épine dino-vit-S Dino Vit-S, Vit-B et Vit-L.

Clustering d’infoncé Debiased (I-Con) Amélioration de la précision hongroise par:

- + 4,5% sur Vit-B / 14

- + 7,8% sur Vit-L / 14

Il a également surclassé les k-means, le clustering contrastif et la numérisation de manière cohérente. La clé réside dans son unification propre des méthodes et de l’adaptabilité – les probabilités de close, les graphiques voisins, les étiquettes de classe, tous relèvent d’un même parapluie.

I-Con n’est pas seulement un unifique; C’est un plan pour l’invention. En montrant que de nombreux algorithmes ne sont que différentes façons de choisir les distributions de quartier, il permet aux chercheurs d’inventer de nouvelles combinaisons. Échangez un type de connexion pour un autre. Mélangez le débias. Régler la profondeur du quartier. Chaque ajustement correspond à une nouvelle entrée dans le tableau – un nouvel algorithme prêt à être testé.

Comme l’a dit le Mit’s Shaden Alshammari, l’apprentissage automatique commence à se sentir moins comme un art des suppositions et plus un espace de conception structuré. I-Con transforme l’apprentissage en exploration – peu d’alchimie, plus d’ingénierie.

Ce que I-Con offre vraiment, c’est une philosophie plus profonde de l’apprentissage automatique. Il révèle que sous la grande diversité des modèles et des méthodes, une structure commune peut exister – celle non construite sur des formules rigides, mais sur la logique relationnelle. En ce sens, I-Con ne résout pas l’intelligence. Il le mappe. Et comme le premier tableau périodique, cela nous donne un aperçu de ce qui attend encore d’être découvert.