Avec sa nouvelle technologie LLM 1 bit, Microsoft vient peut-être de déchiffrer le code permettant de créer une puissante IA derrière des chatbots et des outils linguistiques qui peuvent tenir dans votre poche, fonctionner à la vitesse de l’éclair et contribuer à sauver la planète.

Ok, laissez tomber la partie planète mais c’est vraiment un gros problème !

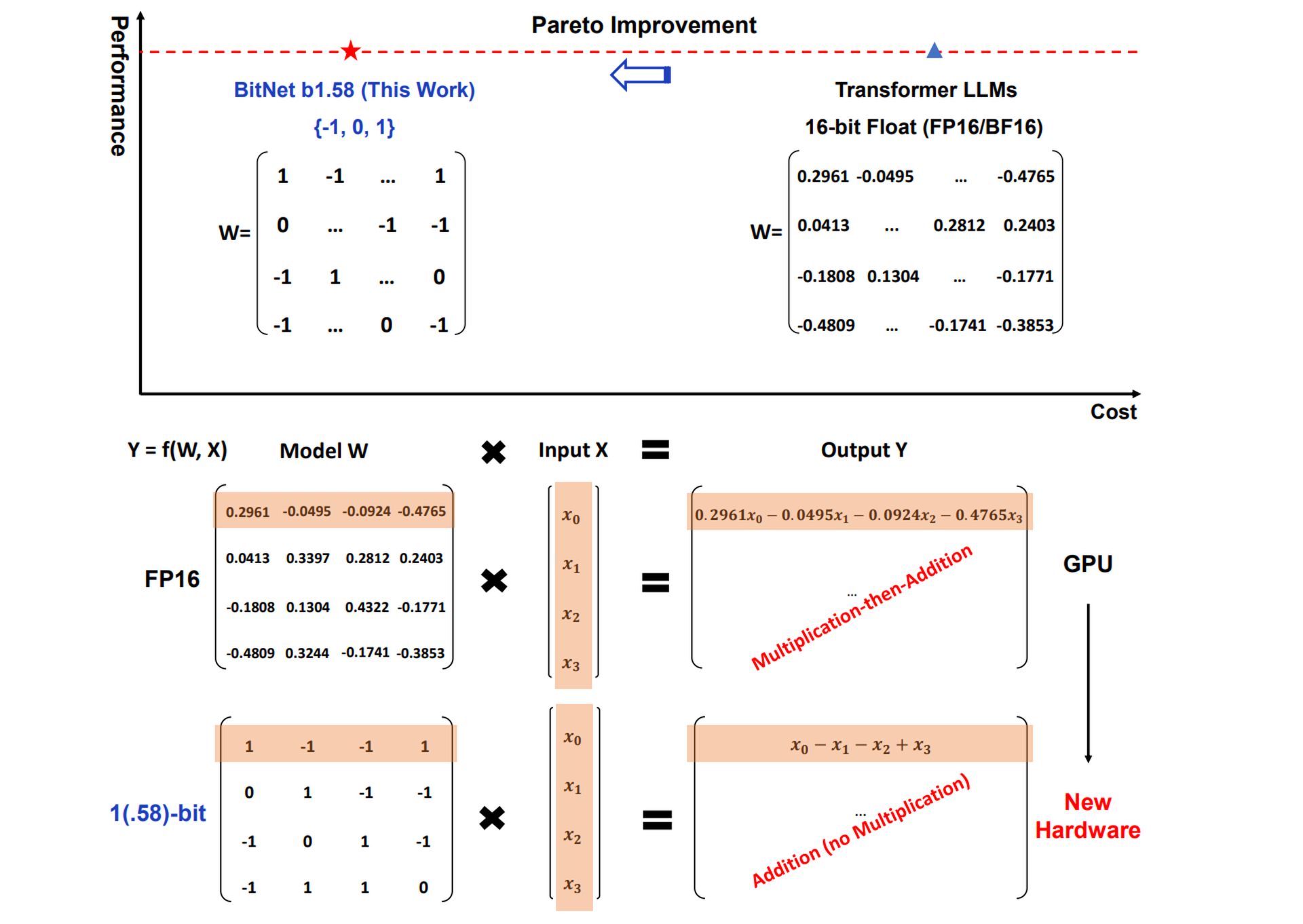

Les LLM traditionnels, les puissants modèles d’IA derrière des outils comme ChatGPT et Gémeauxutilise généralement Nombres à virgule flottante 16 bits ou même 32 bits pour représenter les paramètres ou les poids du modèle. Ces poids déterminent la manière dont le modèle traite les informations. Le LLM 1 bit de Microsoft adopte une approche radicalement différente en quantifiant (en réduisant la précision de) ces poids jusqu’à juste 1,58 bits.

Avec un LLM 1 bit, chaque poids ne peut prendre que l’une des trois valeurs suivantes : -1, 0 ou 1.

Ce peut sembler considérablement limitatifmais cela conduit à des avantages remarquables.

Quel est le problème avec les LLM 1-Bit ?

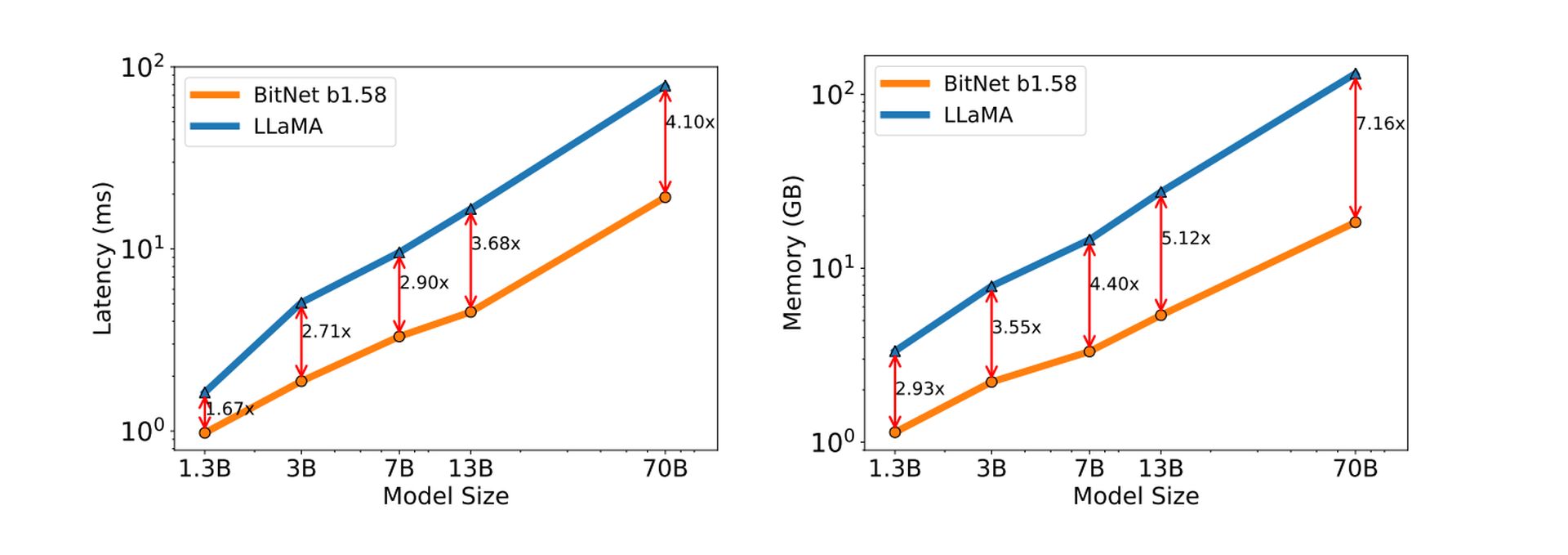

Les besoins réduits en ressources des LLM 1 bit pourraient permettre des applications d’IA sur une plus large gamme d’appareils, même ceux dotés d’une mémoire ou d’une puissance de calcul limitée. Cela pourrait conduire à une adoption plus large de l’IA dans divers secteurs.

Des cerveaux plus petits signifier L’IA peut fonctionner sur des appareils plus petits: Votre téléphone, votre montre intelligente, à vous de choisir.

La représentation simplifiée des poids dans un LLM 1 bit se traduit par des vitesses d’inférence plus rapides – le processus de génération de texte, de traduction de langues ou d’exécution d’autres tâches liées à la langue.

Des calculs plus simples signifient que L’IA pense et réagit beaucoup plus rapidement.

L’efficacité informatique des LLM 1 bit entraîne également une consommation d’énergie inférieure, ce qui les rend plus respectueux de l’environnement et plus rentables à exploiter.

Moins de puissance de calcul équivaut à moins d’énergie utilisée. Il s’agit d’une victoire majeure pour une technologie soucieuse de l’environnement, une étape ultime vers rendre l’IA verte.

En dehors de tout cela, les caractéristiques informatiques uniques des LLM 1 bit ouvrent des possibilités de conception de matériel spécialisé optimisé pour leurs opérations, conduisant potentiellement à des progrès encore plus importants en termes de performances et d’efficacité.

Découvrez le BitNet LLM de Microsoft

La mise en œuvre par Microsoft de cette technologie s’appelle BitNet b1.58. La valeur 0 supplémentaire (par rapport aux véritables implémentations 1 bit) est un élément crucial qui améliore les performances du modèle.

BitNet b1.58 démontre des résultats remarquables, approchant les performances des LLM traditionnels dans certains cas, même avec une quantification sévère.

Briser la barrière des 16 bits

Comme mentionné précédemment, les LLM traditionnels utilisent des valeurs à virgule flottante de 16 bits (FP16) pour représenter les pondérations au sein du modèle. Tout en offrant une grande précision, cette approche peut être gourmande en mémoire et coûteuse en calcul. BitNet b1.58 met un terme à ce paradigme en adoptant une représentation ternaire de 1,58 bits pour les poids.

Cela signifie que chaque poids ne peut prendre que trois valeurs distinctes :

- -1 : représente une influence négative sur la sortie du modèle

- 0 : ne représente aucune influence sur la sortie

- +1 : représente une influence positive sur le résultat

Cartographie efficace des poids

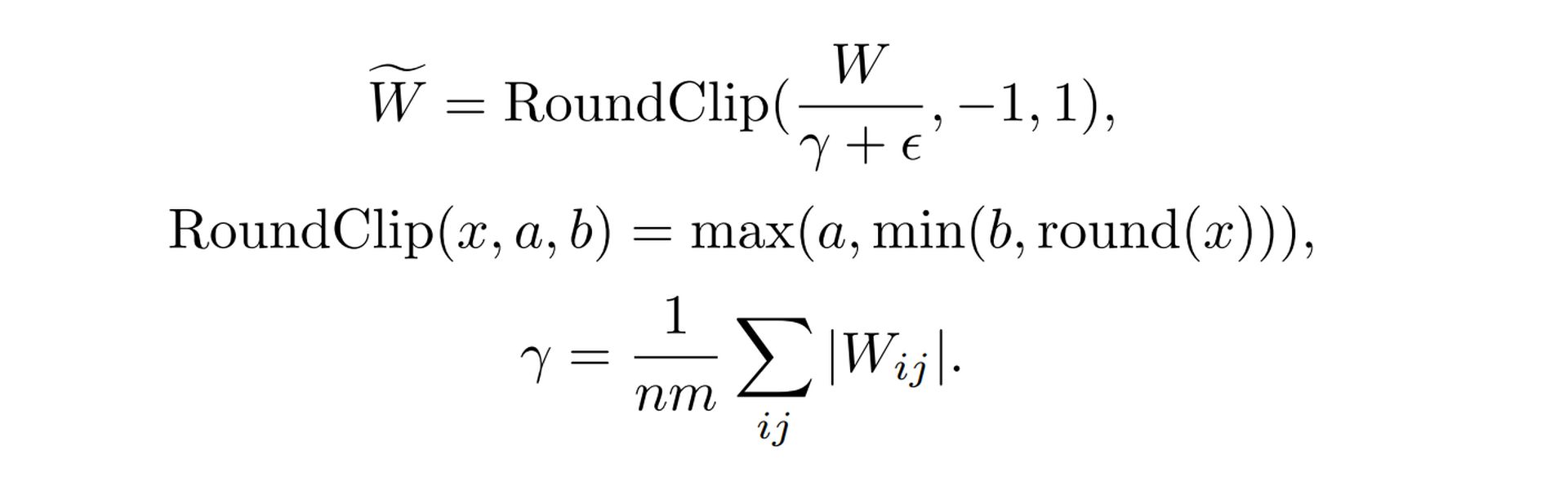

La transition d’un espace de poids continu (FP16) à un espace de poids discret (ternaire) nécessite un examen attentif. BitNet b1.58 utilise un fonction de quantification spéciale pour réaliser cette cartographie de manière efficace. Cette fonction prend les valeurs de poids originales du FP16 et applique un algorithme spécifique pour déterminer la valeur ternaire correspondante la plus proche (-1, 0 ou +1). La clé ici est de minimiser la dégradation des performances provoquée par cette conversion.

Voici une description simplifiée de la fonction

- Mise à l’échelle: La fonction met d’abord à l’échelle l’ensemble de la matrice de poids en fonction de sa valeur absolue moyenne. Cela garantit que les poids sont centrés autour de zéro

- Arrondi: Chaque valeur de poids est ensuite arrondie à la valeur entière la plus proche parmi -1, 0 et +1. Cela traduit les poids mis à l’échelle dans le système ternaire discret

Voir la formule détaillée sur Document de recherche 1-Bit LLM de Microsoft.

Mise à l’échelle des activations

Les activations, un autre composant crucial des LLM, subissent également un processus de mise à l’échelle dans BitNet b1.58. Pendant la formation et l’inférence, les activations sont adaptées à une plage spécifique (par exemple, -0,5 à +0,5).

Cette mise à l’échelle répond à deux objectifs :

- Performance Optimisation : la mise à l’échelle des activations permet de maintenir des performances optimales dans l’environnement de précision réduite de BitNet b1.58

- Simplification: La plage de mise à l’échelle choisie simplifie la mise en œuvre et l’optimisation au niveau du système sans introduire d’inconvénients significatifs en termes de performances.

Compatibilité open source

Le Recherche LLM la communauté prospère grâce à la collaboration open source. Pour faciliter l’intégration avec les frameworks existants, BitNet b1.58 adopte des composants similaires à ceux trouvés dans l’architecture de modèle populaire LLaMA. Cela inclut des éléments tels que :

- Norme RMS: Une technique de normalisation pour stabiliser le processus de formation

- SwiGLU: Une fonction d’activation offrant des avantages en termes d’efficacité

- Encastrements rotatifs: Une méthode pour représenter les mots et les positions dans le modèle

- Suppression des préjugés: Simplifier l’architecture du modèle

En intégrant ces Lama-comme les composants, BitNet b1.58 devient facilement intégrable aux bibliothèques de logiciels LLM open source populaires, minimisant ainsi les efforts requis pour son adoption par la communauté de recherche.

Crédit image en vedette: Freepik.